NLP

1.[NLP] RNN & LSTM

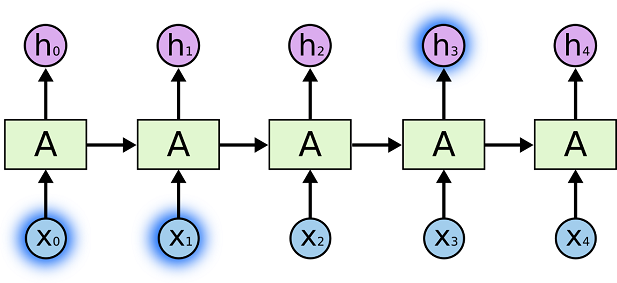

RNN(Recurrent Neural Network, 순환신경망)은 연속성이 있는 데이터를 처리하기 위해서 고안된 신경망이다. RNN은 기존 신경망들과는 달리 은닉층의 노드에서 활성화 함수를 통해 나온 결과값을 출력층 방향으로 보내는 동시에, 은닉층 노드의 다음 계산을

2.[NLP] Attention in Seq2Seq Learning

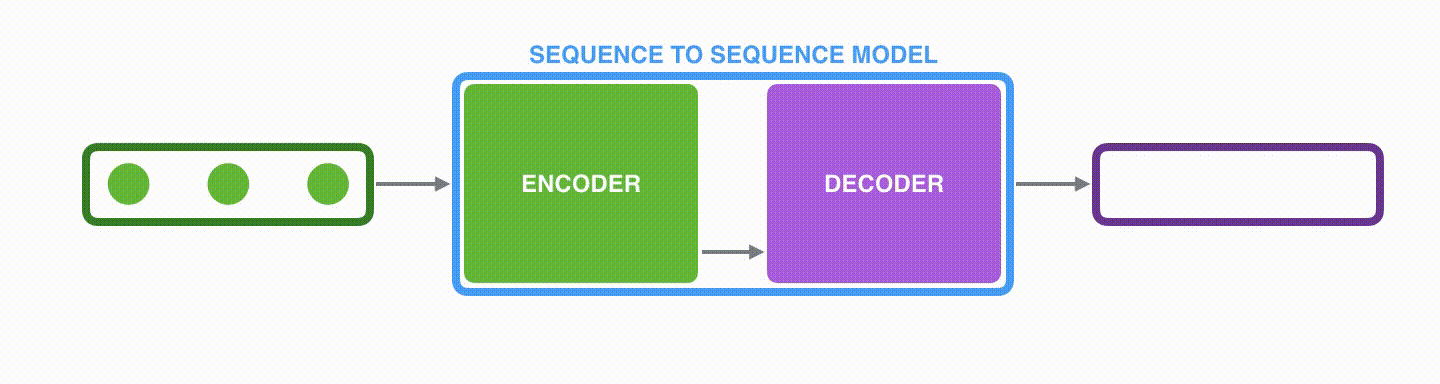

Seq2Seq(sequence to sequence)란 입력 시퀀스(input sequence)에 대해서 출력 시퀀스(output sequence)를 만들기 위한 모델로서, 주로 기계 번역(Machine Translation)이나 챗봇(Chatbot)뿐만 아니라 내용

3.[NLP] Transformer : Attention Is All You Need

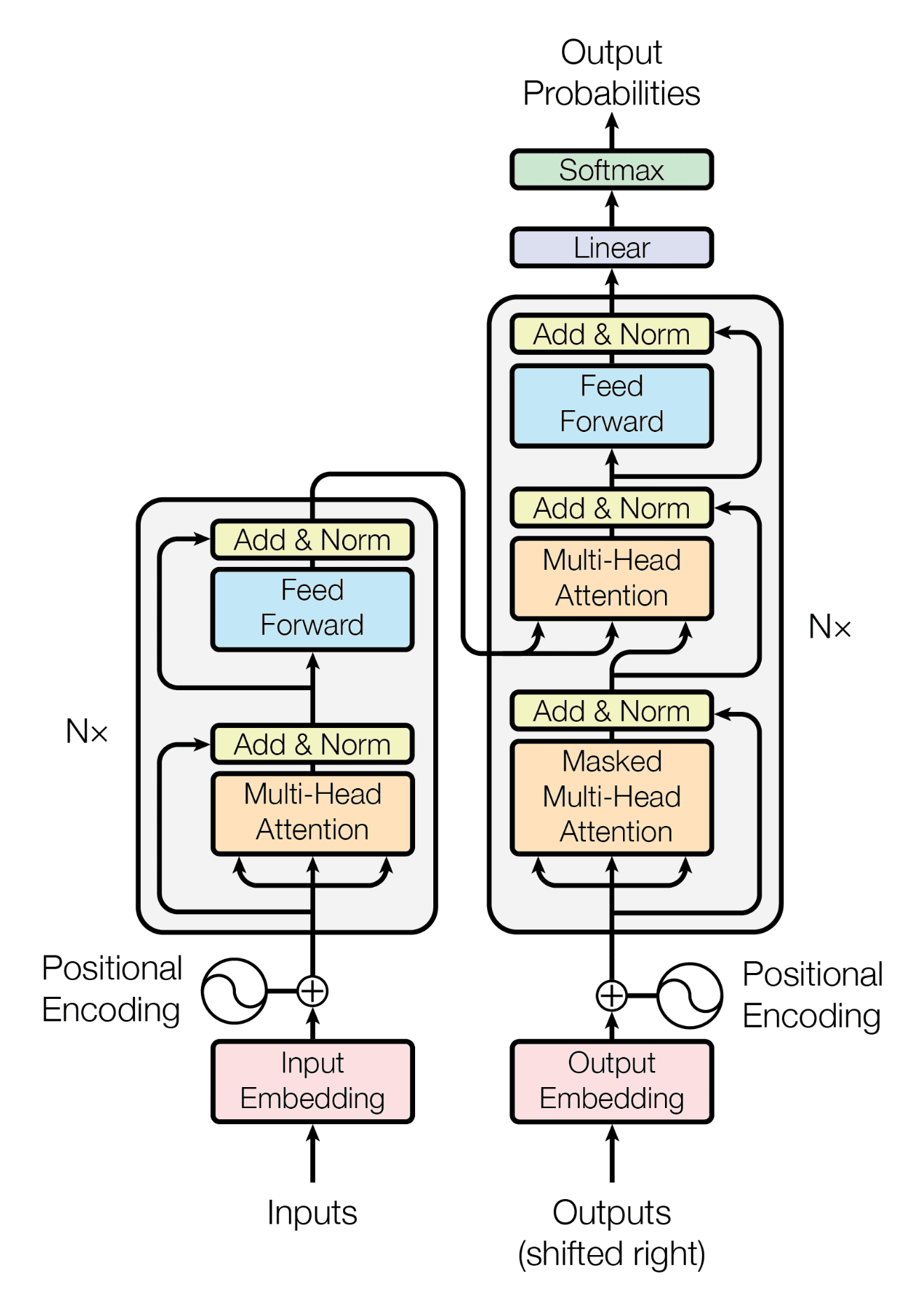

장기 의존성 문제(long-term dependacy) : RNN이 은닉 상태(hidden state)를 통해 과거의 정보를 저장할 때 문장의 길이가 길어지면 앞의 과거 정보가 마지막 시점까지 전달되지 못하는 현상트랜스포머(transformer)는 RNN에서 사용한 순

4.[NLP] BERT : Pre-training of Deep Bidirectional Transformers for Language Understanding

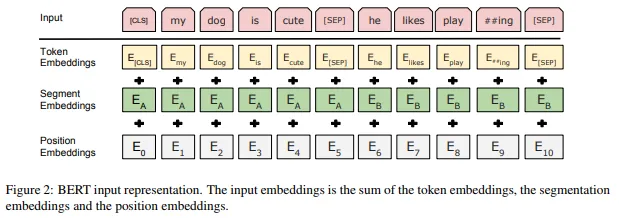

1. BERT의 기본 개념 BERT는 Word2Vec과 같은 context-free 임베딩 모델과는 달리 context-based 임베딩 모델이다. BERT는 모든 단어의 문맥상 의미를 이해하기 위해 문장의 각 단어를 문장의 다른 모든 단어와 연결시켜 이해한다. 2.

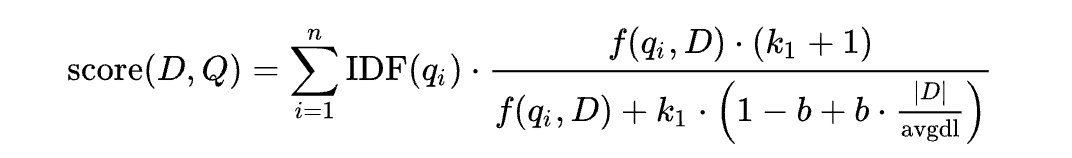

5.[NLP] TF-IDF & BM25

RAG와 관련된 공부를 하던 와중에 EnsembleRetriever에서 sparse retriever와 dense retriever를 결합하여 사용한다는 내용을 봤다. sparse retriever는 키워드를 기반으로 쿼리와 관련 문서를 찾는 데에 효과적이며, dens

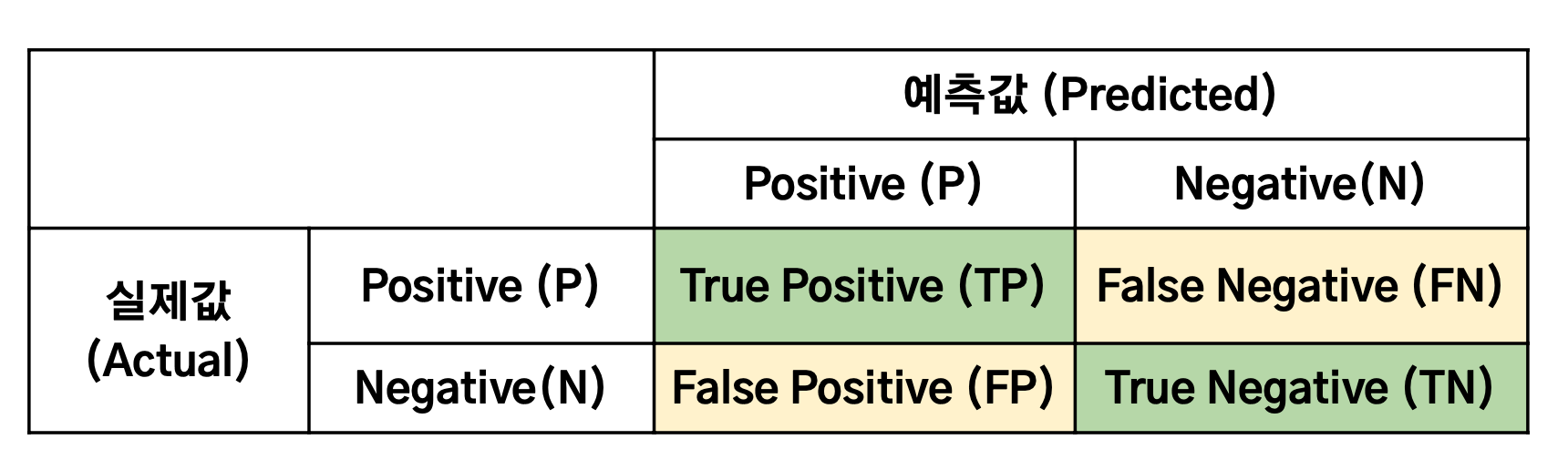

6.[NLP] Evaluation Metrics

자연어처리에 있어서 다른 평가 지표에 가장 기본이 되는 것은 다른 task와 마찬가지로 Precision, Recall, F1-score이다. 따라서 해당 평가 지표들이 자연어처리에서 어떤 의미를 가지는지 간단하게 살펴본 이후 Precision, Recall, F1-s