머신러닝과 데이터사이언스

1.1. Math for Machine Learning

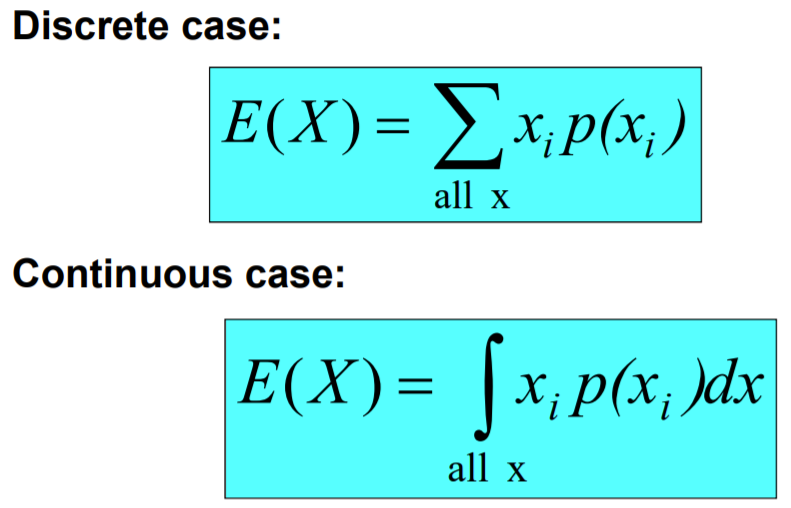

확률에 의해 정해지는 결괏값들ex) 주사위 던지기discrete : ex) 죽냐/사냐continuous : ex) 혈압평균으로부터 떨어진 거리2020-09-09-15-19-04= 정규분포 (종모양)ex) 동전 100번 던질 때 앞면 나오는 확률의 분포두 변수의 선형 관

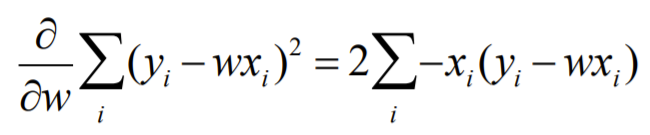

2.2. Linear Regression

Supervised Learning의 일종input(x)와 output(y) 사이의 관계를 직선으로 모델링ex) 11번가에서 9달러에 파는 물건이 쿠팡에서 얼마에 파는가?2020-09-14-15-19-32파라미터와 노이즈2020-09-14-15-20-32선이 예측 값,

3.3. Maximun Likelihood Estimation, Logistic Regression, Softmax Regression

1. Maximum Likelilhood Estimation (최대 가능도 추정)

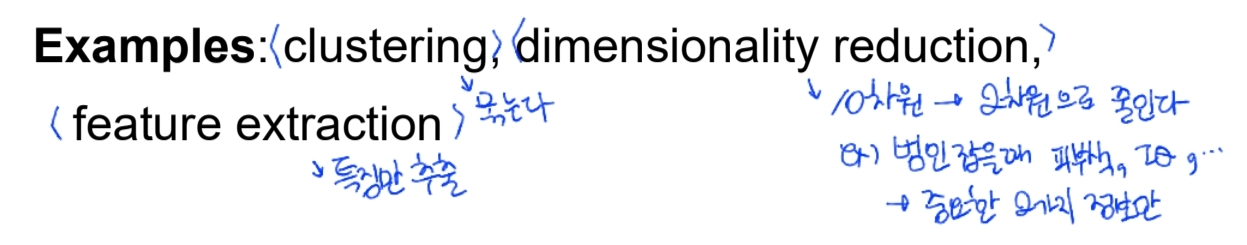

4.4. Clustering

Clustering_200928_164218_1Clustering_200928_164218_2Clustering_200928_164218_3Clustering_200928_164218_4Clustering_200928_164218_5Clustering_200928_16

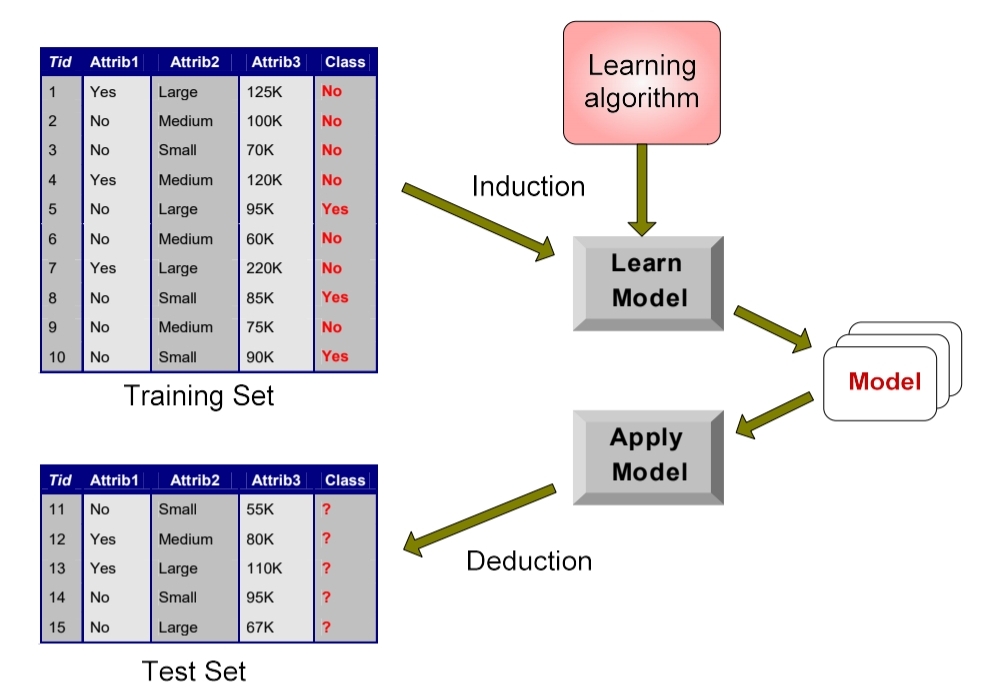

5.5. Decision Tree

Supervised Learning이미 x에 대해 f(x)라는 정답이 있는 경우이산 f(x) : 분류연속 f(x) : 회귀f(x)가 x의 확률일 때 : 확률 추정

6.jupyter notebook 기본 모듈 import

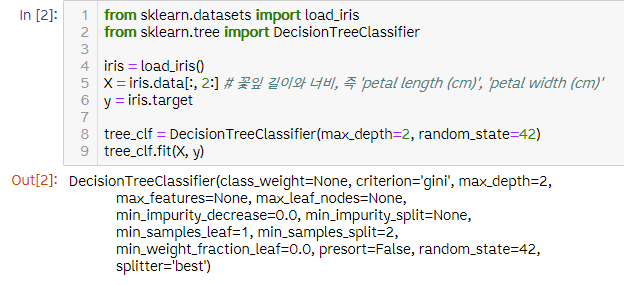

7.실습 5. Decision Tree

iris.data 결정나무\- 그림에서 노란색 체크된 노드 value 잘못 씀 (50, 0, 0node의 samples 속성100개의 sample은 petal length가 2.45보다 긺(오른쪽, False)그 중 54개는 petal width가 1.75보다 짧다 (

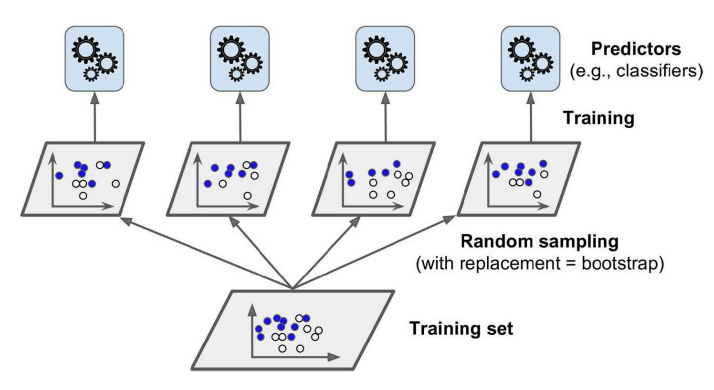

8.6. Ensemble Learning

Ensemble Learning 한 전문가의 의견보다 여러 사람의 종합된 의견이 더 나은 경우가 많다 = 하나의 좋은 예측기보다 보통 예측기 집단의 예측이 더 낫다 방법 👍 Bagging 👍 Boosting 👍 Stacking 앙상블을 통한 변

9.* 엔트로피와 크로스 엔트로피 차이

예를 들어, 가방에 0.8/0.1/0.1 의 비율로, 빨간/녹색/노랑 공이 들어가 있다고 하자, 하지만 직감에는 0.2/0.2/0.6의 비율로 들어가 있을 것 같다. 이 때, entropy 와 cross-entropy 는 아래와 같이 계산된다. H(q)=−0.8log(

10.공학용 계산기 fx-570 사용방법

ln(숫자) / ln(2) = log2(숫자)