논문리뷰

1.[TIL] Bag of Tricks for Image Classification with Convolutional Neural Networks

3. Efficient Training 3.1 Large-batch traninig 작은 batch size로 training 시키는 것과 비교하면, batch size가 클 경우 동일 epoch에서 validation accuracy가 낮게 나타나는 것을 확인할 수

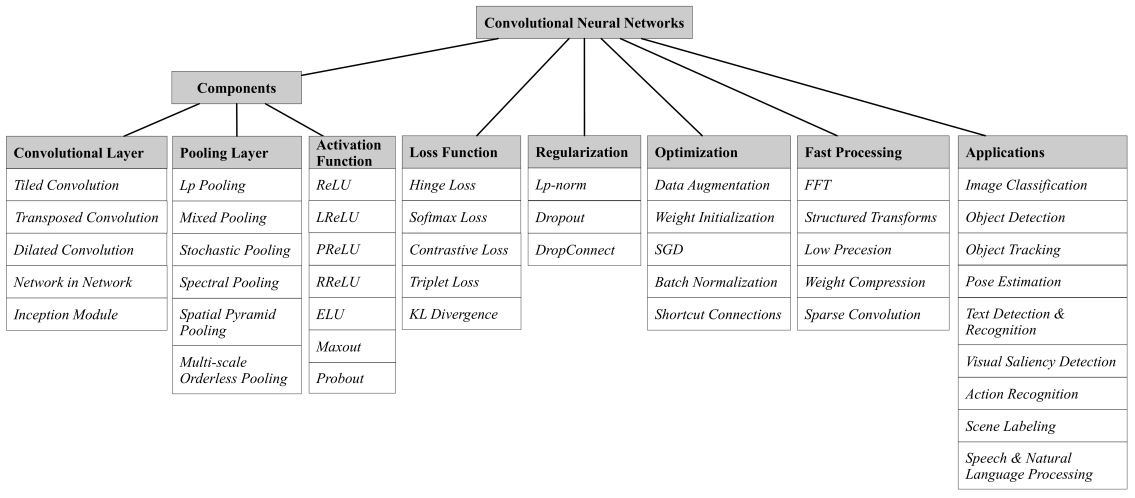

2.[TIL] Recent Advances in Convolutional Neural Networks

3.1. Convolution Layers3.1.1 Tiled ConvolutionTiled CNN은 인접한 단위로 pooling함으로써 complex invariances을 학습하여, 인접한 은hidden units가 동일한 weights를 공유할 필요가 없음. 또한

3.[TIL] LeNet-5, AlexNet

LeNet-5 현대 MNEST는 28x28을 받지만, LeNet-5는 32x32를 input 받을. 당시에 convolution은 아직 발전하지 않았기 때문에 전통적인 Fully Connected의 영향을 받음. 전통적인 Fully connected는 위치에 민감하기

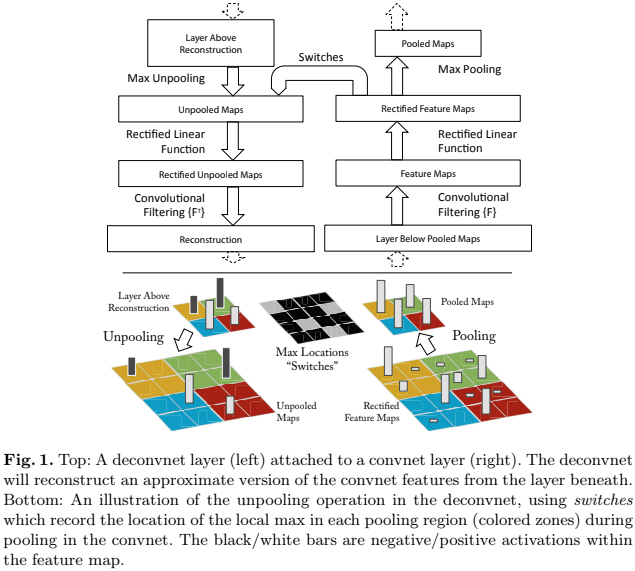

4.[TIL] ZFNet, NIN

ZFNet, NIN 논문 리뷰하기

5.[TIL] InceptionNetv1, VGGNet, ResNet

InceptionNet, VGGNet, ResNet의 특징을 요약

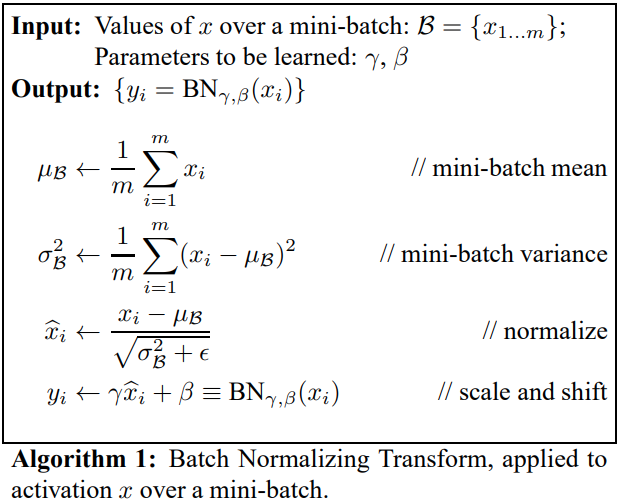

6.[TIL] Normalization, Batch Normalization

정규화'정규화'라고 번역이 되는데 Regularization, Standardzation과 차이가 무엇일까?Normalization : 값 범위를 왜곡시키지 않고 데이터셋을 공통 스케일로 변경하는 것.ex. KNN, K-means 등 distance based algo

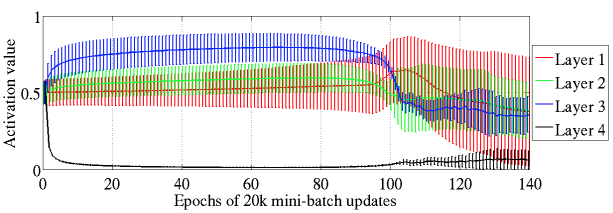

7.[TIL] Understanding the difficulty of training deep feed-forward neural networks

main idea:Deeper networks는 특별한 초기화(initialization methods)를 통해서 학습이 되는데, 이 논문에서는 activation function이 어떻게 training에 영향을 끼치는지에 대해 설명함Dataset : MNIST, C

8.How to Train 10,000-Layer Vanilla Convolutional Neural Networks

train architectures that are currently untrainbalbe?eliminate the need to search over hyperparameters?disentangle trainablilty, expressivity, and gern

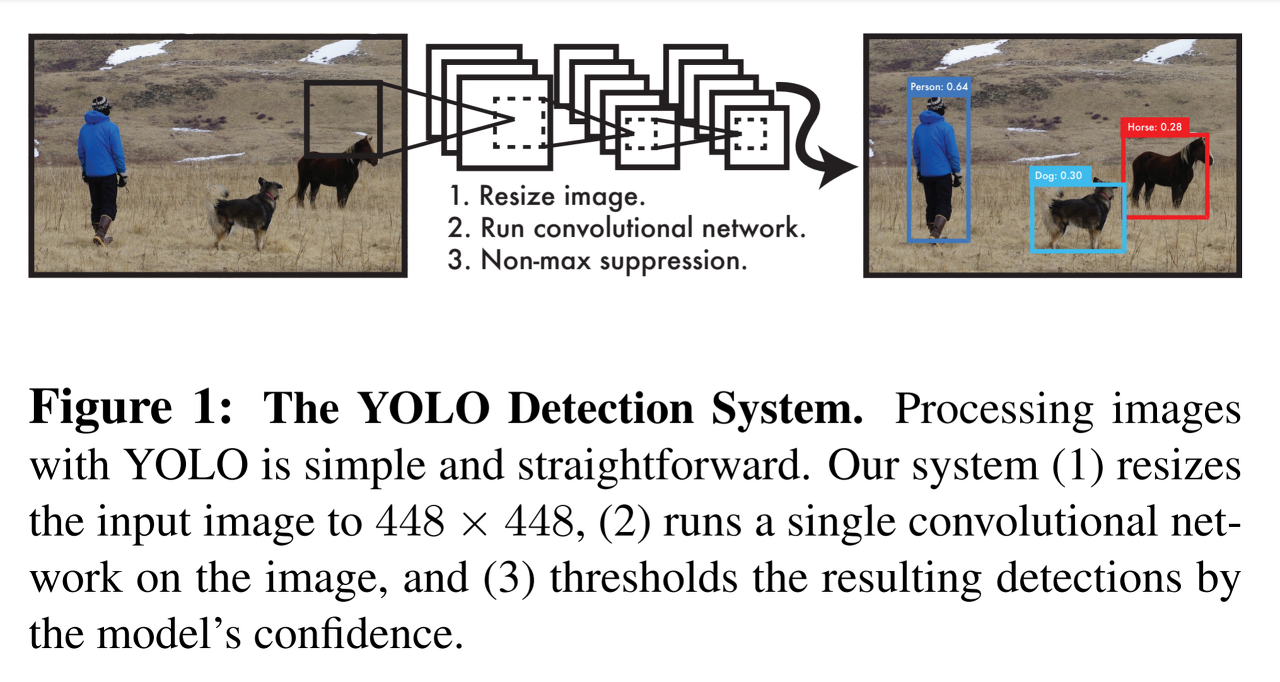

9.[TIL] You Only Look Once: Unified, Real-Time Object Detection

2 Stage Object Detection : 위치 → 분류1 Stage Object Detection : 위치 + 분류 → Confidence = acc. + IoU ⇒ confidence 50% 이상인 경우에만 물체가 있을 확률이 높다고 판단, 50% 이하의 경우