- 전체보기(95)

- question(5)

- AI(5)

- 이산수학(4)

- linux(3)

- paper-review(2)

- 모방학습(2)

- 시사(1)

- simulation(1)

- 독후감(1)

- 용어 정의(1)

- 3D Printing(1)

- chatGPT(1)

- English(1)

tmux 사용법

좋아. tmux + conda + 서버 접속 흐름을 “처음부터 끝까지” 한 번에 정리해줄게. (GPU 서버에서 학습 돌리는 상황 기준)tmux: SSH 끊겨도 작업(학습/스크립트) 계속 돌게 “터미널 세션”을 서버에 붙여두는 도구conda env: 파이썬/라이브러리 버

Transfomer 모델 구조

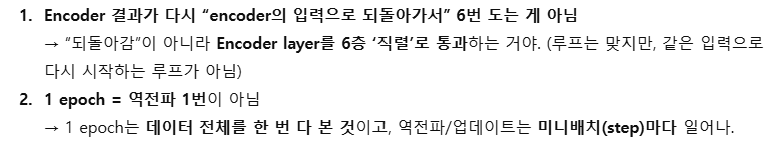

작성이유 : Transfomer 논문을 이해하는 과정에서 x N 이라고 있는데 이 부분에서 레이어가 인인코더와 디코더 레이어가 어떻게 훈련되어가는지 모르겠음https://github.com/hyunwoongko/transformer/tree/master

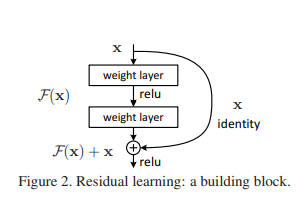

Residual Neural Network, ResNet

작성 이유 : transfomer 모델을 설명해주기 위해서 작성하는 과정에서 attention 부분이 3가지정도 있었는데 encoder - decoder attention / multi-head-self-attention /masked multi-head-attenti

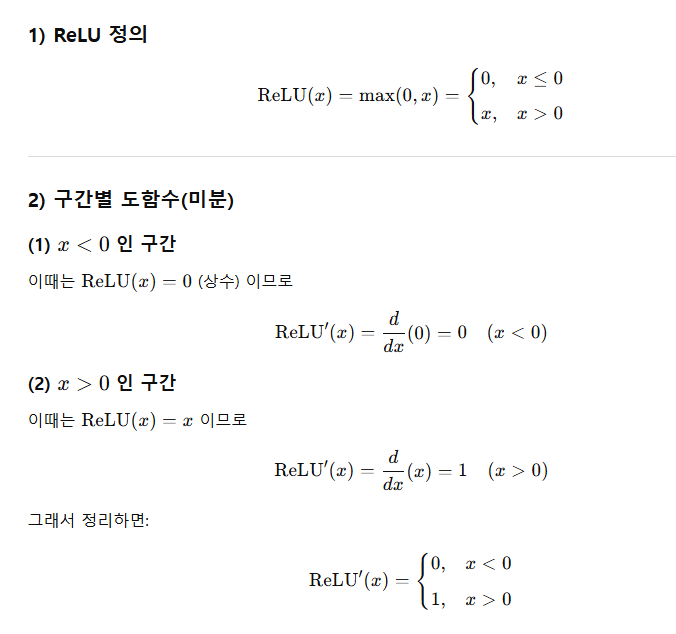

Activation function

작성한 이유 : 잔차 학습 방법을 공부하면서 그레디언트 소실 문제를 막는 효과가 있다고 하는데 그전에는 시그모이드 함수의 역시도 미분하면 최댓값이 0.25이고 0도 나와서 결국 Gradiant vinishing problem이 발생해서 그것을 보완하는 것이 RELU인데

Imitation Learning(1)

모방학습(Imitation Learning)은 전문가(사람/기존 정책)의 시연(demonstration) 데이터를 이용해, 에이전트가 전문가처럼 행동하는 정책(policy) 을 학습하는 강화학습/로봇학습 방법입니다.입력: 상태/관측 (s) (또는 이미지, 센서 등)정답

용어 정의

IMU 센서 : inertail Measurement Unit : 관성 측정 장치 --> 관성이란 : 외부의 힘이 작용하지 않을때 현재 운동상태를 유지하려는 성질 즉 가속도계와 자이로스코프(각속도계)를 기본으로, 때로는 자기장 센서(지자기 센서)를 추가하여 물체의 움

AI 학습 관련 질문 정리

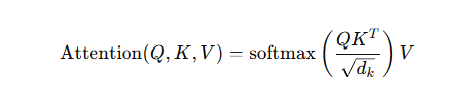

좋아. 지금 대화 흐름(소프트맥스 → 크로스엔트로피 → 로스 줄이기 → 그라디언트/방향 → 체인룰/역전파 → “가장 크게 줄어드는 방향” → 모든 가중치에 대해 하냐?)을 수식으로 한 번에 깔끔하게 정리해줄게.분류 모델의 마지막 선형층(가중치/편향)에서 로짓이 나와:로

AI Speak and write (7)

지금 질문은 핵심을 정확히 찔렀고,다만 개념 몇 개가 머릿속에서 겹쳐져 있어서 그걸 분리해서 정리해주면 완전히 정리돼.아래에서 네가 쓴 문장 흐름 그대로 하나씩 정확히 정리해줄게.👉 YES, 둘 다 맞다.다만 표현을 더 정확히 하면 이렇게 말하는 게 좋아.SSL은 V

AI Speak and write (6)

좋아. 이 두 질문은 실제로 SSL을 “쓰는 단계”로 넘어가는 핵심이야.그래서 ① 어떻게 가져다 쓰는지(실무 파이프라인) → ② 왜 ViT에 특히 중요한지(이유) 순서로 정리할게.핵심 한 줄:SSL 모델은 ‘사전학습된 백본(backbone)’으로 쓰고,다운스트림 태스크

AI Speak and write (5)

좋은 질문이야. 이 질문 하나로 자기지도학습(SSL)을 ‘이해한 단계’로 넘어간다고 봐도 돼.한 문장으로 먼저 말하면 👇라벨 없이, 데이터 자체에서 ‘가짜 정답(supervision)’을 만들어 학습하는 방법즉,사람이 정답 라벨을 안 줘도모델이 스스로 문제를 만들어서

AI Speak and write (4)

좋아. 이제 🔥 ViT + LoRA / Adapter 방식을왜 필요한지 → 개념 → LoRA vs Adapter 차이 → 코드 → 언제 무엇을 쓰는지 순서로 완전히 이해되게 설명할게.앞에서 우리가 본 문제를 다시 정리하면:ViT는전역 self-attention 구조l

AI Speak and write (3)

좋은 질문이야. ViT에서의 partial fine-tuning은 ResNet의 layer4 개념과 정확히 대응되는 구조가 있어.아래를 보면 “아, 그래서 이렇게 하는구나”가 바로 올 거야.ViT의 partial fine-tuning =패치 임베딩 + 앞쪽 Transf

paper review(1) : π ∗0.6 : a VLA That Learns From Experience

π ∗0.6 : a VLA That Learns From Experience

[3D printing] 부품 만들고 뽑기

Fusion 360 으로 진행or GPT기술자료실 - > 해당 설치 파일 설치 - > .gcode로 변경하기 위함해당 소스파일을 다운로드 후 진행 필요http://www.3dcubicon.com/bbs/board.php?bo_table=datalist