모두를 위한 딥러닝 시즌2 - PyTorch

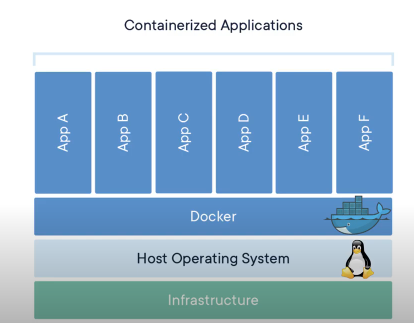

1.Docker Instruction

컨테이너 기반의 가상화 시스템이다. 실제로 있지 않은 것을 마치 있는 것처럼 보이게 해주는 것 내 컴퓨터에 실제로 디스크는 하나이지만, 파티션을 나눠서 여러개 있는 것처럼

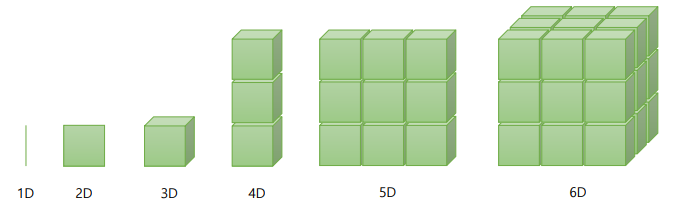

2.Tensor Manipulation

1D : Vector, 2D : Matrix, 3D : Tensor, nD는 Tensor를 확장2D Tensor : | t | = (batch size, dim)3D Tensor : | t | = (batch size, width or length, height or

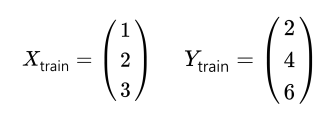

3.Linear regression

내가 4시간을 공부했을 때 어떤 점수가 나올 것인가?데이터는 torch.tensor 형태를 띈다.입력과 출력은 따로 둔다. (x_train, y_train)y = Wx + b 로 식을 정의한다.여기서 W는 weight, b는 Bias를 의미한다.W와 B를 0으로 초기화

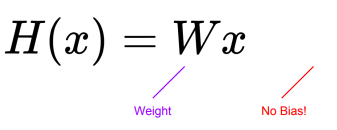

4.Deeper Look at GD

Bias가 없는 간단한 식으로 경사하강법을 이해해본다.H(x) = x가 정확한 모델이다. ( W = 1 이 가장 좋은 숫자이다.)W = 1 일 때 cost = 0이며, 1에서 멀어질수록 높아진다.Mean Squared Error(MSE)로 오차를 구한다.기울기가 양수면

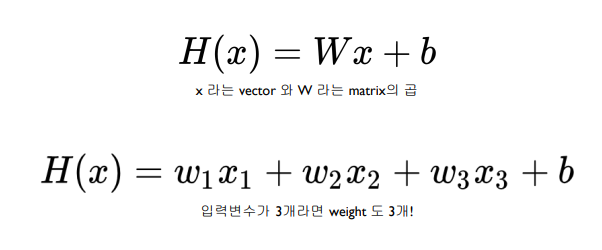

5.Multi-variable Linear regression

복수의 정보가 존재할 때 어떻게 하나의 추측값을 계산할 수 있을까?기존 Simple Linear Regression과 동일한 공식이다.역시 기존 선형 회귀와 동일하다.W를 쓰는 것은 모델이 커질수록 귀찮은 일이 된다.nn.Module을 모델 Class에 상속해서 쓰면

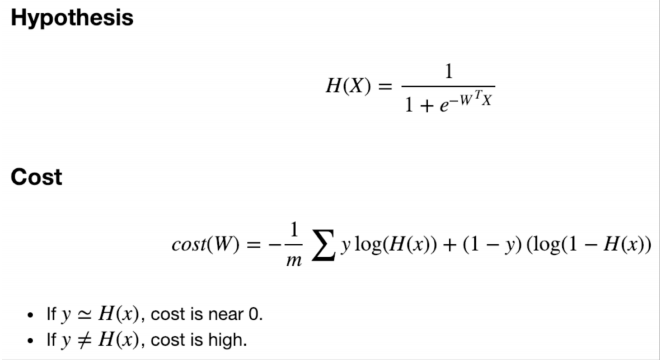

6.Logistic Regression

이거 먼저 읽기M개의 sample로 이루어져있고, D size의 vector의 을 갖는 데이터 X👉 M개의 0과 1로 이루어진 정답을 구할 수 있는 model을 구한다.W는 d개의 값을 갖는 벡터이다.Weight를 경사하강법으로 업데이트 하는 수식은 다음과 같다.역시

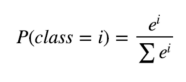

7.Softmax Classification

이거 먼저 읽기softmax는 하단 수식을 활용해서 모든 확률의 합을 1로 만들어준다.점점 Cost가 낮아지는 것을 확인할 수 있다.

8.MNIST

손으로 쓴 숫자의 dataset으로, 0 ~ 9 까지의 숫자이다. 링크에서 다운로드 가능하다. 28 x 28 해상도의 이미지이며, 1개의 채널을 갖는 gray image이다. torchvision 에서 다양하고 유명한 dataset들을 사용할 수 있다.

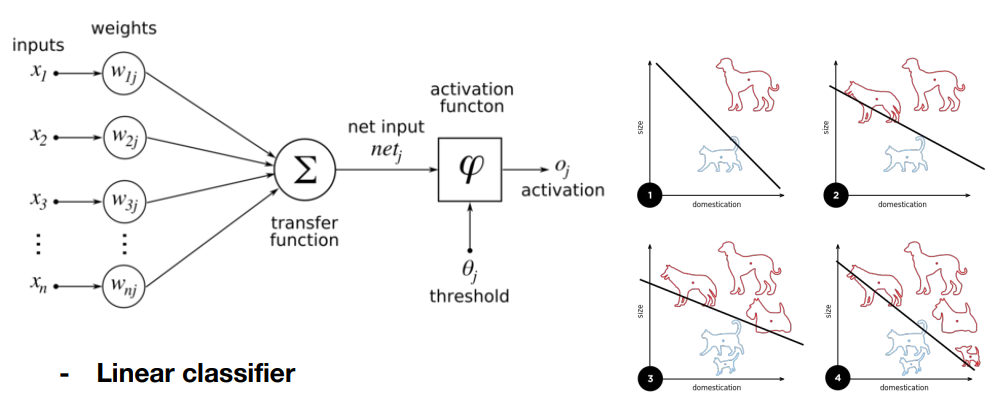

9.Percepptron

인공 신경망은 Neuron의 동작 방식을 본따서 만든 모델이다. 입력 신호가 들어왔을 때, 신호들의 총 합이 threshold를 넘으면 다음으로 전파되는 방식이다. 입력 x가 들어왔을 때 가중치를

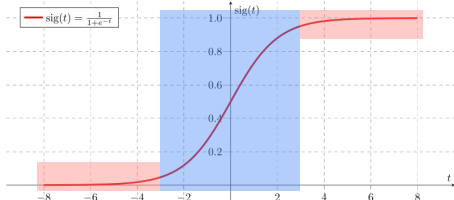

10.Activation function

Sigmoid는 양 끝 부분에서는 아주 작은 값이 나와 gradient가 소멸될 수 있다.👉 이는 Layer가 쌓였을 때 앞 부분에서 gradient를 전파받을 수 없는 상황을 만든다.f(x) = max(0, x) 의 간단한 점화식을 갖는다.음수일 때 gradient

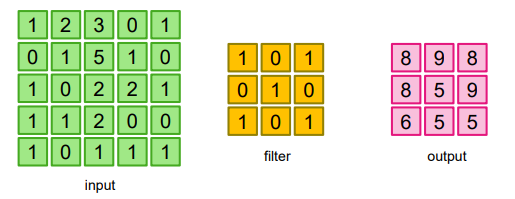

11.Convolution Neural Network

이미지 위에서 stride 값 만큼 filter를 이동👉 겹쳐지는 부분의 각 원소의 값을 곱해서 모두 더한 값을 출력으로 하는 연산각 인덱스에서 두 행렬을 mul 한 뒤, sum 연산을 취한다고 생각하면 될 듯 하다.stride : filter를 한번에 얼마나 이동할

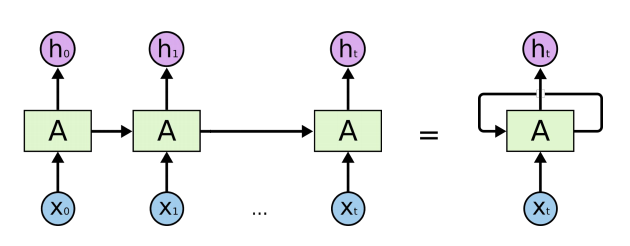

12.Recurrent Neural Network

순서도 데이터의 일부가 되는 sequential data를 위해 만들어졌다.이전 입력 값의 처리를 반영하여 모델이 데이터의 순서를 이해한다.긴 sequence가 들어와도 이를 처리할 A의 parameter만 알면 된다.