영상처리 기초 - 6. OCR 프로젝트-2(학습 및 평가)

부정확하거나 일관되지 않은 라벨:라벨의 오류는 모델의 성능을 저하시킬 수 있습니다. 모델이 잘못된 라벨을 학습하면, 정확성, 정밀도, 재현율과 같은 성능 지표가 모두 감소하게 됩니다.왜곡된 라벨링: 라벨이 실제 시나리오를 제대로 대표하지 못할 경우, 모델은 새로운 데

영상처리 기초 - 4. OCR 프로젝트-1(데이터분석)

전이학습(Transfer Learning)이란?전이학습은 기존에 학습된 모델의 가중치를 새로운 문제에 활용하는 방법입니다.대규모 데이터셋에서 사전 학습된 모델을 통해 기본적인 특성(feature)을 이해하게 하고, 이를 새로운 데이터셋에 적용하여 모델 학습 시간을 줄이

영상처리 기초 - 3. 컨볼루션 신경망

완전 연결 네트워크의 문제점으로부터 시작매개변수의 폭발적인 증가공간 추론의 부족: 픽셀 사이의 근접성 개념이 완전 연결 계층(Fully-Connected Layer)에서는 손실됨동물의 시각피질의 구조에서 영감을 받아 만들어진 딥러닝 신경망 모델시각 자극이 1차 시각피질

영상처리 기초 - 2. OPENCV 이미지처리

다양한 도형을 그릴 수 있음도형을 그리는 좌표가 해당 범위를 넘어가면 이미지에 표현되지 않음cv.line()Parametersimg : 그림을 그릴 이미지 파일start : 시작 좌표end : 종료 좌표color : BGR형태의 Color (ex; (255, 0, 0)

영상처리 기초 - 1.컴퓨터비전 기초

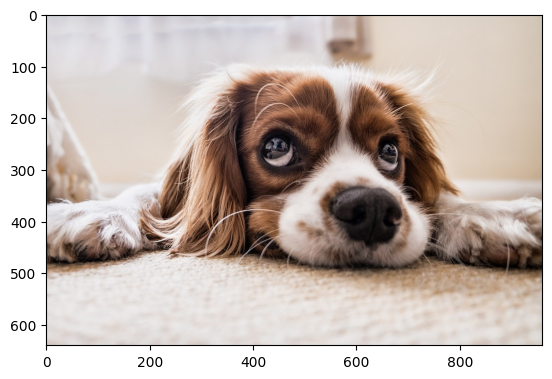

컴퓨터 비전은 컴퓨터가 디지털 이미지를 이해하고 분석하여 의미 있는 정보를 추출하도록 하는 학문 및 기술 분야입니다.인간의 시각 시스템처럼 이미지나 비디오를 처리하고 그 안의 객체, 패턴, 또는 행동을 이해하려는 목표를 가지고 있습니다.컴퓨터 비전은 인공지능(AI)의

강화학습 기초 6 - 최신 강화학습 사례

RLHF (Reinforcement Learning with Human Feedback):사용 사례:ChatGPT (OpenAI): 인간 피드백을 활용해 언어 모델의 응답 품질 향상.InstructGPT: 사용자의 지침에 맞는 응답 생성.작동 원리:인간 평가자가 제공하

강화학습 기초 5 - DQN

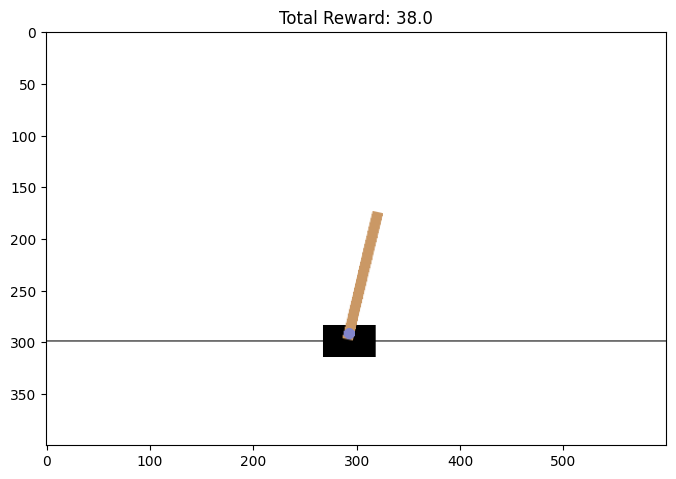

강화학습(RL): 에이전트가 환경과 상호작용하며 최적의 행동을 학습하는 과정.핵심 요소:상태(State): 현재 환경의 상태.행동(Action): 에이전트가 취할 수 있는 행동.보상(Reward): 행동의 결과로 환경이 에이전트에 제공하는 피드백.정책(Policy):

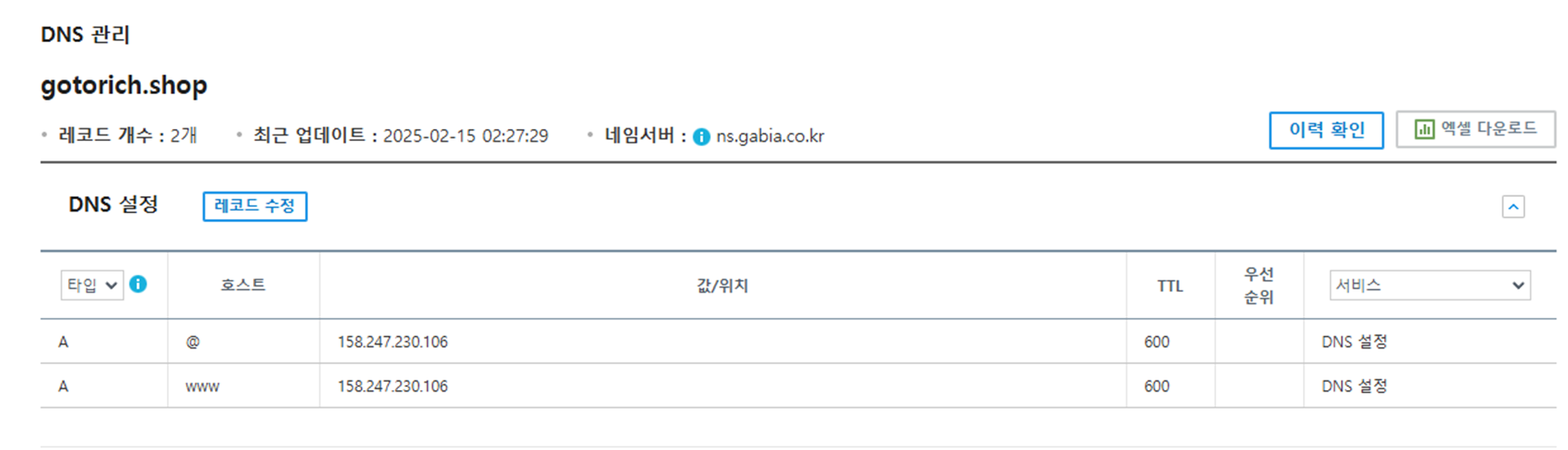

가비아 DNS 설정 및 Nginx를 활용한 FastAPI 배포

가비아에 로그인한 후, DNS 관리 페이지(예: 가비아 DNS 관리)로 이동합니다.여기서 도메인에 대해 다음과 같이 DNS 레코드를 설정합니다.링크 : https://dns.gabia.com/dns/internals/total_setDNS 레코드 예시타입: A

암호화폐 재정거래 프로젝트

암호화폐는 탈중앙화 화폐이기 때문에 거래소마다 가격의 차이가 있다. 따라서 거래소마다 가격이 다른 것을 이용해 가격이 싼 곳에서 구매한 뒤 비싼곳에서 사면 적은 리스크로 돈을 벌 수 있고 이것을 무위험 차익거래 혹은 재정거래라고 부른다. 돈을 입금하면 재정거래를 자동으

Tensorflow를 활용한 인공신경망 구현2

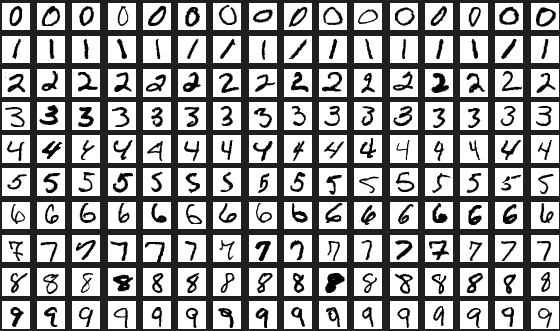

손으로 쓴 숫자들로 이루어진 이미지 데이터셋기계 학습 분야의 트레이닝 및 테스트에 널리 사용되는 데이터keras.datasets에 기본으로 포함되어 있는 데이터셋MNIST 데이터셋을 로드Train Data 중, 30%를 검증 데이터(validation data)로 사용

Tensorflow를 활용한 인공신경망 구현1

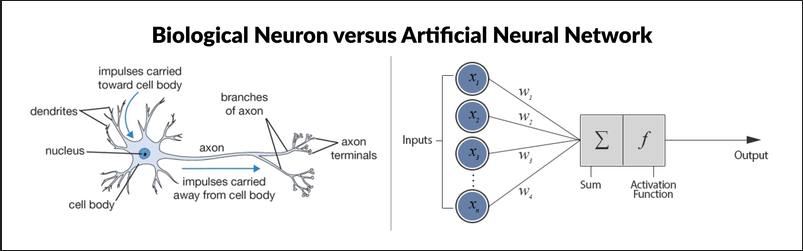

본 자료는 이수안 교수님(https://suanlab.com/)의 자료를 일부 수정 후 업데이트 한 자료입니다. ipynb 나 pdf 자료가 필요하신분은 연락주세요.인간 두뇌에 대한 계산적 모델을 통해 인공지능을 구현하려는 분야인간의 뇌 구조를 모방: 뉴런과

wireguard 설치 - 1

회사를 그만두고 프리랜서 개발자로 활동하며, 출장이 잦아 집이 아닌 장소에서 개발하는 일이 많아졌습니다.특히 GPU를 활용한 작업이 필요할 때가 있는데, GPU가 탑재된 노트북은 무겁고 휴대성이 떨어지기 때문에 집에 우분투(Ubuntu) 기반의 데스크톱을 구축하여 원격

강화학습 기초 4 - 큐러닝

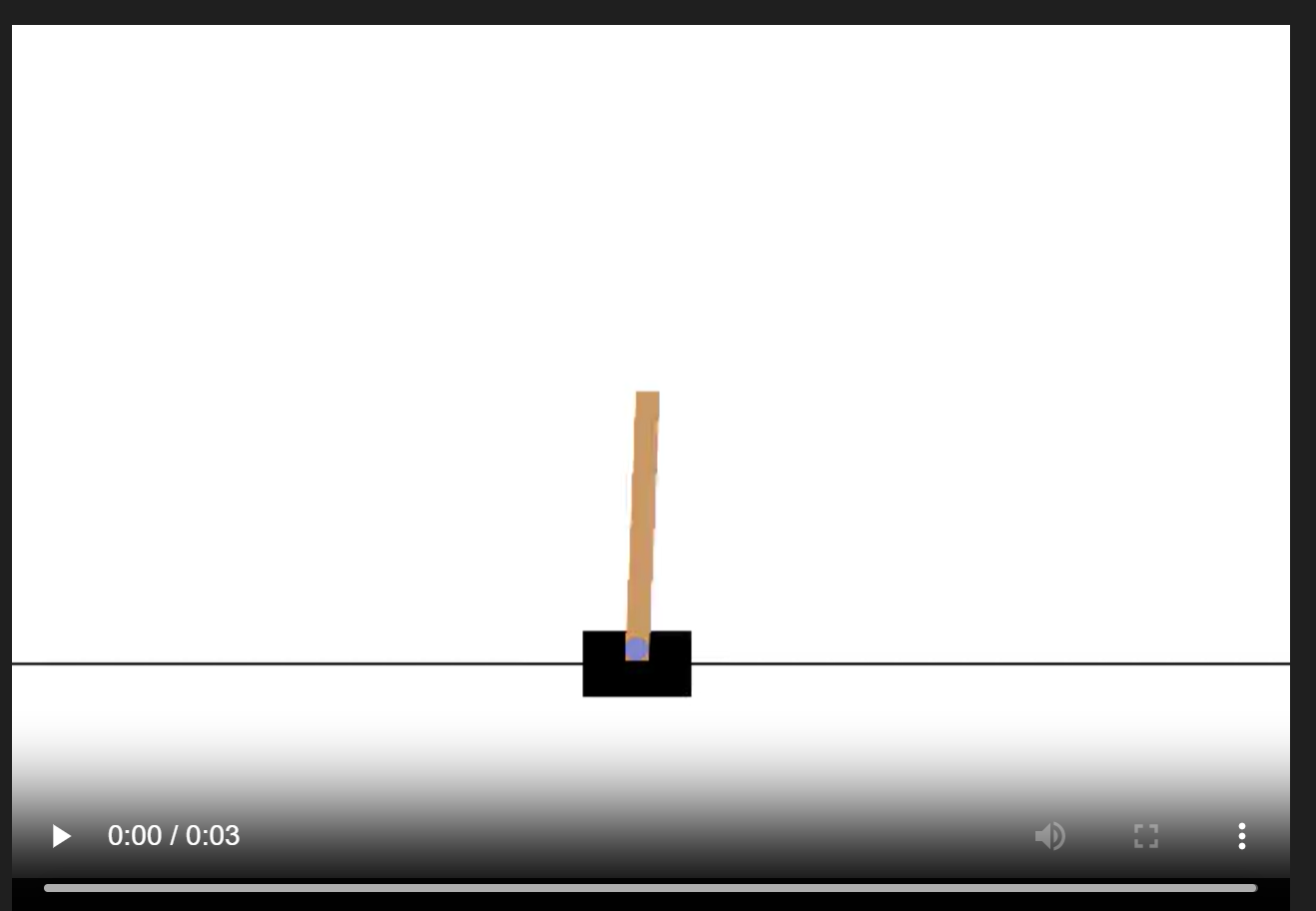

Q-Learning은 강화학습의 대표적인 알고리즘 중 하나로, 환경과의 상호작용을 통해 최적의 정책을 학습하는 방법입니다.이미지 출처 https://www.researchgate.net/figure/Q-Learning-vs-Deep-Q-Learning_fig1

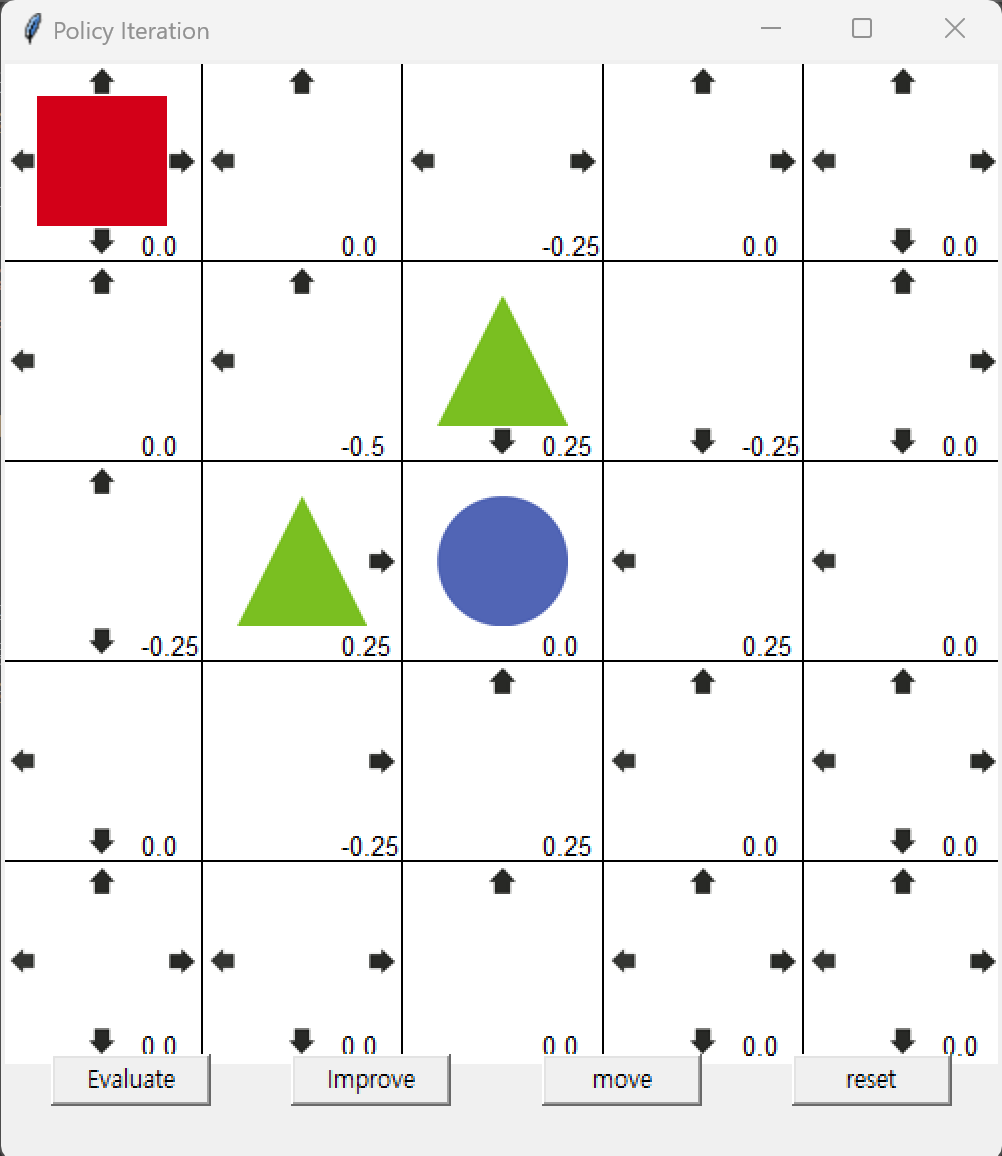

강화학습 기초 3

강화학습의 핵심 목표: 환경과의 상호작용을 통해 기대되는 누적 보상(expected cumulative reward)을 최대화하는 정책(Policy)을 학습하는 것.이는 에이전트가 어떤 상태에서 어떤 행동을 선택해야 할지를 학습하여 장기적으로 최적의 결과를 얻는 것을

Streamlit 기초 2

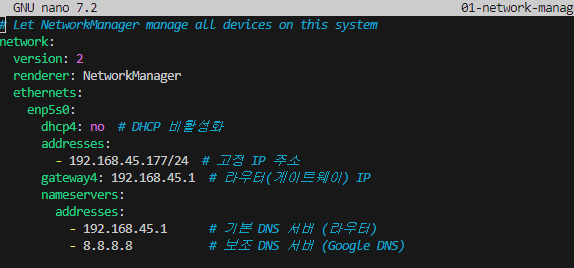

Streamlit으로 서버를 실행하면 211로 시작하는 IP가 출력되는데, 이를 다른 사람들이 접속할 수 있도록 공유해 보셨나요?대부분의 경우, 같은 와이파이에 연결된 사용자들만 접속이 가능했을 겁니다.왜 같은 와이파이 사용자만 접속할 수 있었는지 이유와 다른 와이파이

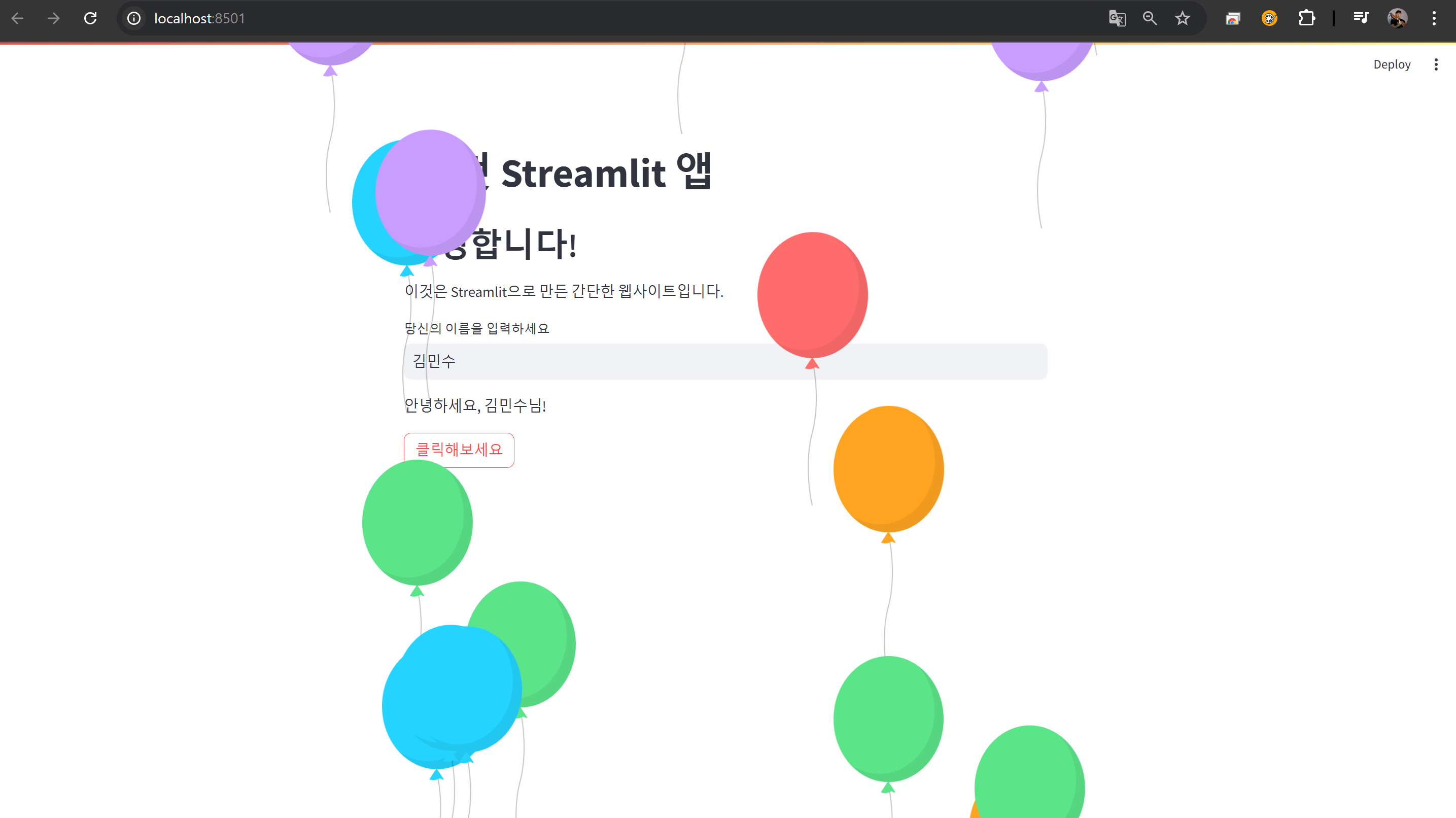

Streamlit 기초 1

Streamlit은 데이터 애플리케이션을 쉽게 만들 수 있도록 도와주는 파이썬 기반의 오픈 소스 프레임워크입니다.특히 데이터 분석, 모델 시각화, 인터랙티브 대시보드를 빠르고 쉽게 구축할 수 있도록 만들어졌습니다.Streamlit을 사용하면 복잡한 웹 개발 지식 없이도

강화학습 기초 3

가치 기반 학습 (Value-Based Learning)상태(state)의 가치를 학습하여 최적의 정책을 유도하는 방식입니다.대표적인 알고리즘: Q-Learning, SARSA.Q-값(Q-Value): 특정 상태 $s$에서 행동 $a$를 취했을 때 기대되는 총 보상 $

강화학습 기초 2

강화학습은 에이전트가 환경과 상호작용하며 최적의 행동을 학습하는 방식입니다. 이 과정에서 중요한 구성 요소들이 있습니다: 에이전트, 환경, 상태, 행동, 보상입니다.에이전트는 강화학습의 주체로, 환경과 상호작용하며 행동을 취하고 보상을 받습니다. 에이전트는 주어진 목표

강화학습 기초 1

강화학습(RL)은 에이전트(agent)가 환경과 상호작용을 통해 보상(reward)을 최대화하는 방법을 학습하는 알고리즘입니다. 에이전트는 여러 상태(state)에서 가능한 행동(action)을 선택하고, 그에 따라 결과와 보상을 받으며 학습합니다. 이 과정에서 에이전