Machine Learning

1.퍼셉트론

퍼셉트론을 설명하는 포스팅입니다.

2022년 8월 24일

2.로지스틱 회귀

로지스틱 회귀에 관한 포스팅입니다.

2022년 8월 25일

3.활성화 함수(Activation Function)- Sigmoid, Tanh, Softmax

활성화 함수가 사용되는 이유와 주요 활성화 함수들의 종류를 소개하는 포스팅입니다. 그리고 Sigmoid와 tanh 그리고 Softmax 함수의 특징들에 대해서 소개했습니다.

2022년 8월 26일

4.활성화함수(Activation Function)-ReLU

이 포스팅에선 Gradient Vanishing 문제를 해결하기 위해 기존에 주로 사용되었던 ReLU 등의 활성화 함수들을 소개했습니다.

2022년 8월 26일

5.손실 함수(Loss Function)-MSE, MAE, Cross Entropy

이번 포스팅에선 손실 함수의 정의 그리고 회귀에서 주로 사용되는 MSE, MAE와 분류에서 주로 사용되는 Cross Entropy Loss Function에 대해서 소개했습니다.

2022년 8월 28일

6.손실 함수(Loss Function)-Likelihood

이번 포스팅에선 우도 함수에 대해서 정리했습니다.

2022년 8월 29일

7.옵티마이저(Optimizer)

이번 포스팅에선 주요 옵티마이저에 대해서 알아보았다. Gradient Descent부터 Adam까지 각 옵티마이저들의 특징들 위주로 정리했습니다.

2022년 9월 1일

8.과적합(Overfitting)

머신러닝에서 주로 일어나는 과적합 문제에 대한 해결 방법에 대해서 포스팅 했습니다.

2022년 9월 1일

9.Gradient Vanishing / Exploding

Gradient Vanishing / Exploding 현상을 제어할 수 있는 몇가지 방법에 대해 포스팅 했습니다.

2022년 9월 2일

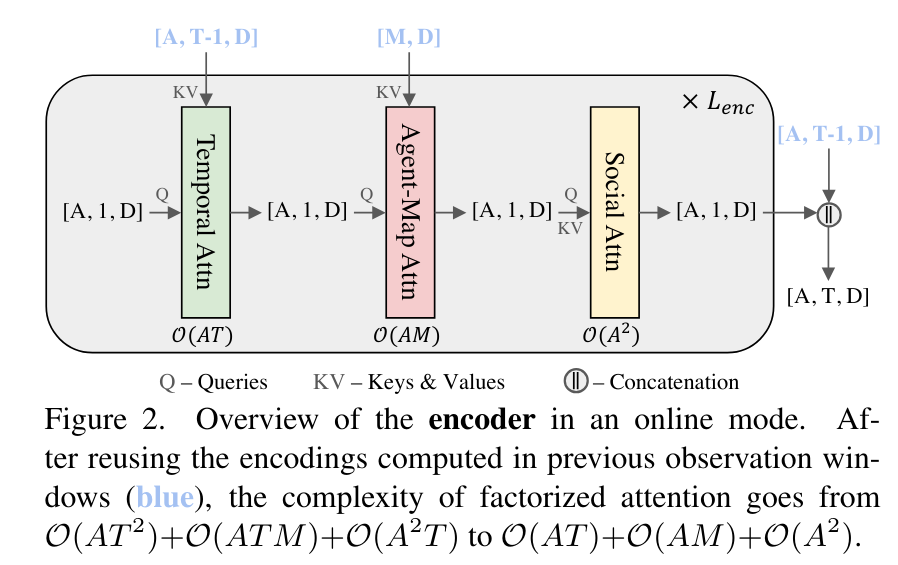

10.Query-Centric Trajectory Prediction

QCNet 논문 리뷰

2024년 4월 24일