PaperReview

1.[Paper Review] 논문 리뷰의 중요성

네이버 AI Tech 부스트캠프에서 멘토링을 매주 1회씩 받으면서, AI 엔지니어로서의 최근 논문과 AI 아키텍처에 대한 이해가 많이 부족하다는 점을 느끼고 있다. 그렇기에 이렇게 매주 2,3개씩 관심 있는 대학원 연구실의 논문 리뷰 영상들을 보고, 직접 논문도 읽고

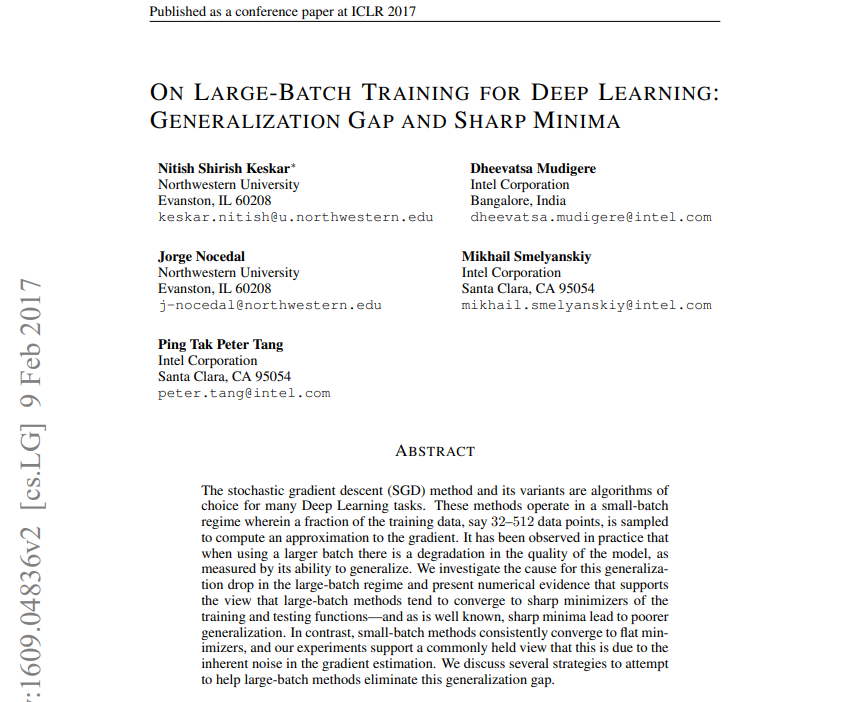

2.[📖논문 리뷰] ON LARGE-BATCH TRAINING FOR DEEP LEARNING : GENERALIZATION GAP AND SHARP MINIMA (2017)

ICLR 2017 conference paper로 2023년 11월 기준 3000회 넘는 인용 횟수를 가지고 있는 중요한 논문을 읽고 해석해보았다. 논문 리뷰를 어떻게 하면 잘 할 수 있는 건지 아직도 잘은 모르겠지만, 일단 읽으면서 생각을 정리해본다는 식으로 해보려고

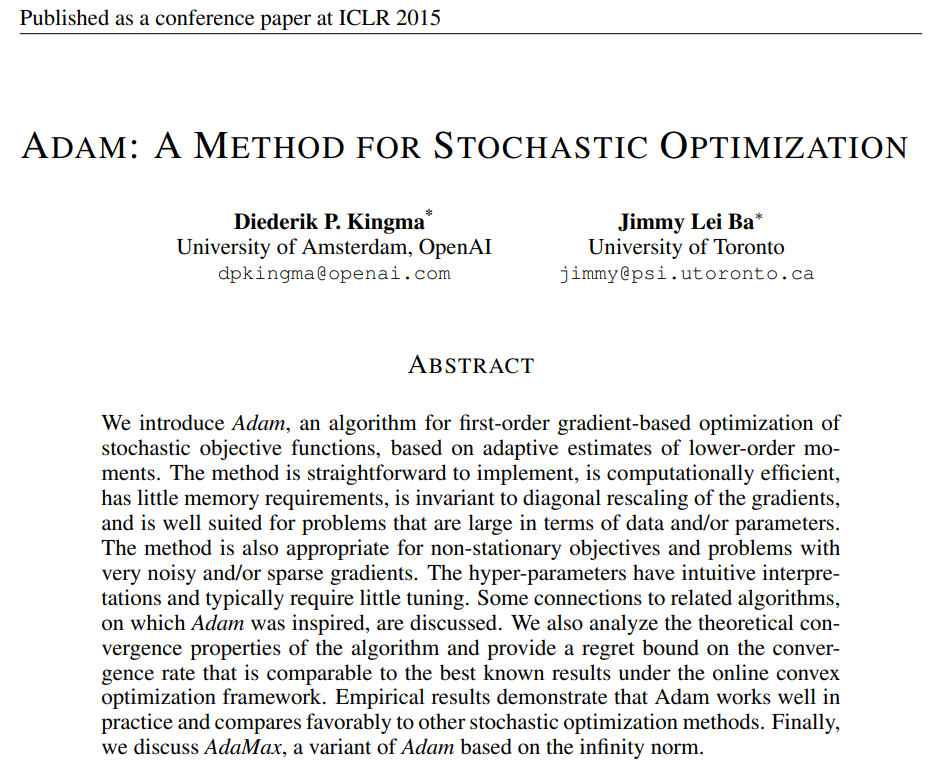

3.[📖논문 리뷰] ADAM: A METHOD FOR STOCHASTIC OPTIMIZATION (2015)

지금은 모두가 Adam optimizer을 당연하게 사용하고 있다. 왜 그런지 Adam의 원리를 보면, 그 이유를 알 수 있지 않을까 하여 이렇게 정리하게 되었다 리뷰하는 "ADAM: A METHOD FOR STOCHASTIC OPTIMIZATION (2015)" 논문

4.[📖논문 리뷰] Attention Is All You Need (2017)

NLP task, architecture의 역사는 Transformer 이전과 이후로 봐도 될 만큼, Transfomer, self-attention 에 대한 내용은 꼭 알아야 하는 내용이라고 생각한다. 오늘 이 포스팅을 하면서 Transformer에 대해서 다시 한

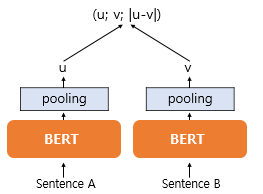

5.[📖논문 리뷰] Sentence-BERT: Sentence Embeddings using Siamese BERT-Networks (2019)

Sentence Bert에 대해서 공부해보았다. 여러 길이의 문장에 대해서 같은 768 차원의 임베딩을 해보며서 예전에 sBERT를 사용해보았다. 하지만, 그때는 transformer 기반이지 라는 생각으로 넘어갔는데, 이번에도 sBERT를 모델링 해보면서 하나하나 찾

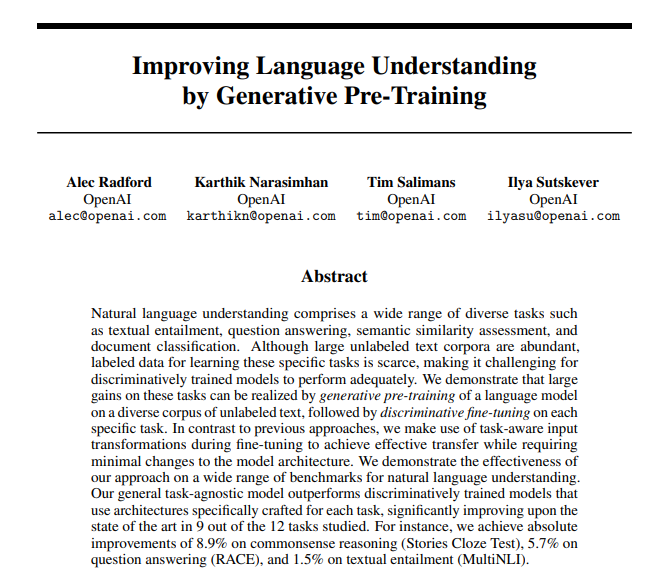

6.[📖논문 리뷰] GPT-1: Improving Language Understanding by Generative Pre-Training (2018)

최근에 Generative model에 대한 강의를 다시 들으면서 GPT 모델을 처음부터 다시 봤다. 그래서 GPT1, 2, 3까지 하나하나 다시 보았고 이렇게 GPT1모델 부터 정리하게 되었다. 간단하게 얘기하자면, GPT-1은 transformer에서 Encoder

7.[📖논문 리뷰] BERT: Pre-training of Deep Bidirectional Transformers forLanguage Understanding (2019)

sBERT 논문을 리뷰 하던 중 BERT에 대한 이해를 좀 더 해보고자 BERT 논문을 찾아보게되었다. BERT의 B, 즉 "Bidirectional"이라는 표현은 ELMo에서 많이 등장하였는데, ELMo가 순방향 언어 모델과 역방향 언어 모델을 모두 사용하기 때문에

8.[📖논문 리뷰] ELECTRA : PRE-TRAINING TEXT ENCODERS AS DISCRIMINATORS RATHER THAN GENERATORS (2020)

부캠에서 Korean Language STS 모델링을 하는 도중, 현재 가장 실험 결과로 가장 좋은 pearson correlation 값을 내고 있는 모델이 Hugging Face에 배포된 "snunlp/KR-ELECTRA-discriminator" 이어서 앙상블 하

9.[📖논문 리뷰] FinGPT: Open-Source Financial Large Language Models (2023)

Bloomberg GPT보다 더 나은 성능을 보여주는 모델이 최근 6월에 출시되었다는 소식을 Hugging Face에서 접하게 되었다. FinGPT 로 간략하게 미국주식 ticker와 날짜를 입력하면 그 때의 expert opinion, analysis, related

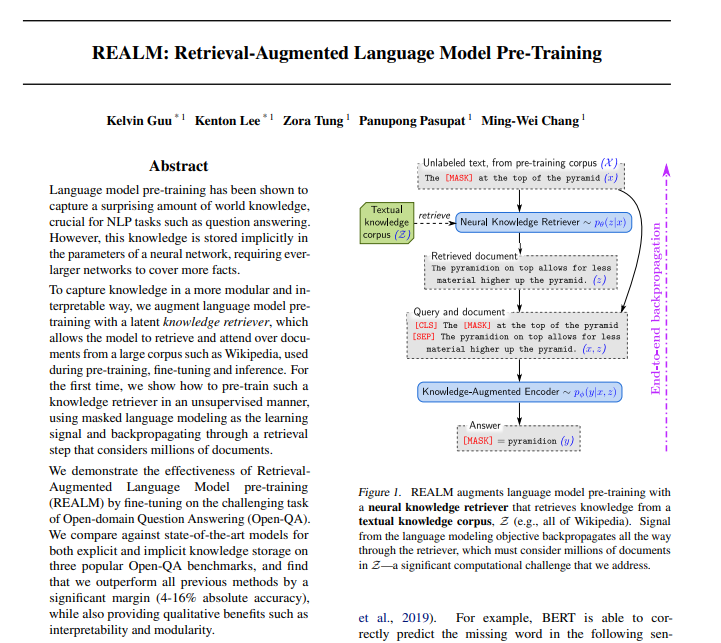

10.[📖논문 리뷰] REALM: Retrieval-Augmented Language Model Pre-Training (2020)

Open-Domain QA(ODQA) 분야에 한 획을 그었던 REALM 논문을 리뷰했다. RAG 모델링을 요즘에 찾아보면서 Financial AI 프로젝트를 진행하고 있다보니, REALM 논문을 자연스럽게 찾아보게 되었다.

11.[📖논문 리뷰] Large Language Models Are Zero-Shot Time Series Forecasters (2023)

LLM 모델을 사용해 Time Series Forecasting을 한 논문을 최근에 자주 보는 대학원 세미나 채널에서 발견하게 되어 이렇게 올리게 되었다.

12.[📖논문 리뷰] LoRA: Low-Rank Adaptation of Large Language Models (2021)

FinGPT 논문을 읽던 중, 매일매일 쏟아져나오는 금융 데이터를 가지고 Fine-tuning을 하는데 있어서 LoRA를 사용했다는 것을 보고 LoRA를 간단하게만 내가 알고 있다는 생각을 했다. 그래서 이렇게 LoRA 논문을 찾아보게되었다.

13.[📖논문 리뷰] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (RAG) (2020)

최종 프로젝트로 금융 도메인 Chat-Bot을 만들면서, 금융 데이터가 가지고 있는 적시성을 RAG로 해결해볼 수 있지 않을까라는 생각을 계속 하고 있다. 그래서 RAG를 계속해서 알아보던 중 이 논문을 리뷰하게 되었다.

14.[📖논문 리뷰] Deep Learning for Anomaly Detection: A Review (2020)

Anomaly Detection 분야는 뭔가 기계학습에서 스테디 셀러라고 느껴진다. Anomaly Detection 대회를 예전에 한 번 진행했었고, 생각보다 결과가 잘 안 나왔던 기억이 있다. 레퍼런스를 찾아보면서 이 분야의 역사가 꽤 오래되었다는 생각도 들었는데,

15.[📖논문 리뷰] Are Transformers Effective for Time Series Forecasting? (2022)

Anomaly Dectection을 요즘에 좀 알아보면서, Time Series Forecasting 분야를 계속 접할 수 밖에 없었고, Transformer의 sequence 적인 특징을 TSF에 사용한 예시가 없을까 하여서 이렇게 찾아보던 중 좋은 논문을 찾게 되었

16.[📖논문 리뷰] A TIME SERIES IS WORTH 64 WORDS: LONG-TERM FORECASTING WITH TRANSFORMERS (2023)

앞서 리뷰했던 논문 "Are Transformers Effective for Time Series Forecasting? (2022)"에서 Transformer가 Times Series Forecasting 에 도움이 안된다는 내용을 얘기했었는데,,,, 본 논문에서는

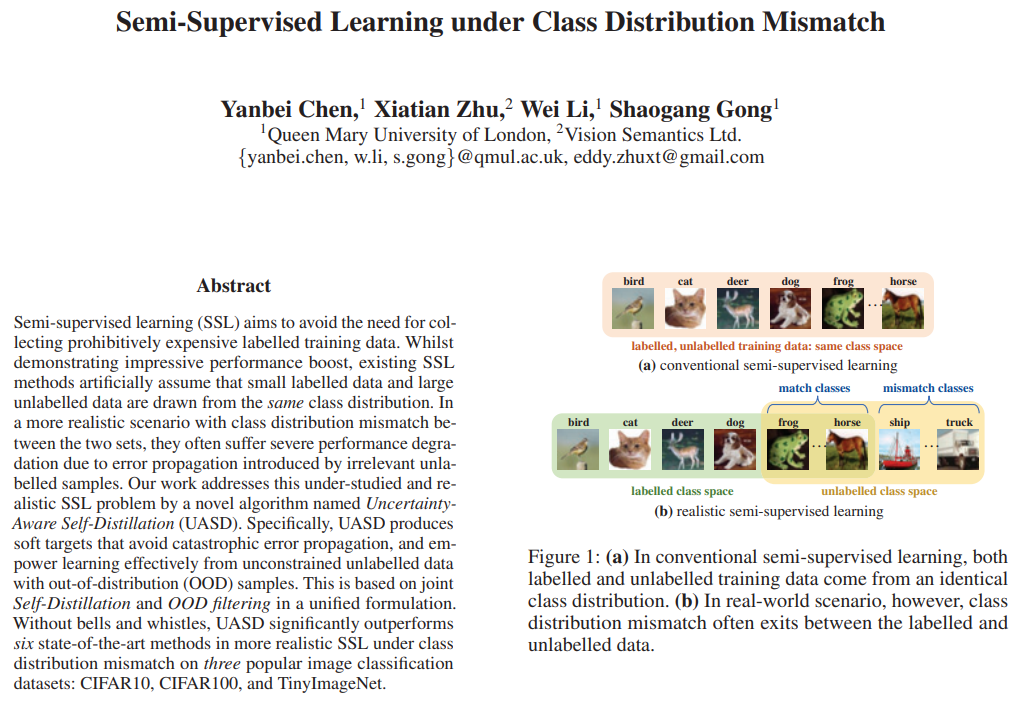

17.[📖논문 리뷰] Semi-Supervised Learning under Class Distribution Mismatch (2020)

최근에 부스트캠프에서 Data-Centric task를 수행하면서 불균형 데이터와 데이터 품질에 대해서 어떻게 관리하는게 좋을지에 대해 큰 궁금증이 생겼다. 그래서 찾아보던 중 유튜브 세미나 영상이 있어서 보게 되었고 이렇게 정리하게 되었다.

18.[📖논문 리뷰] Generative Adversarial Nets (2014)

오늘은 GAN을 하나하나 제대로 파악하고자 한다.

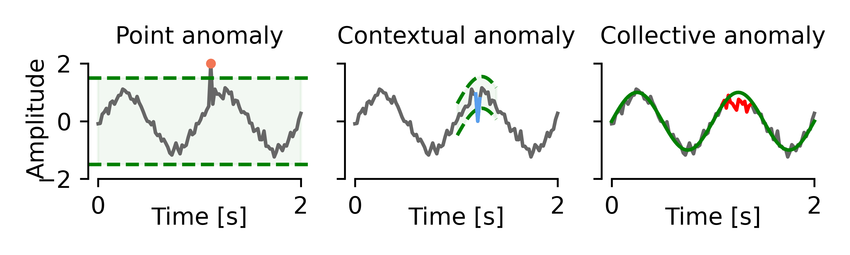

19.[📖논문 리뷰] Deep Learning for Anomaly Detection: A Review (2020)

산업공학원 대학원의 꽃은 이상 탐지 아닐까 싶다. 기존에 공부하던 것들을 기반으로 이상탐지라(Anomaly Detection)이라는 새로운 분야를 공부하고 있다. 전반적인 기반을 다지고자 이 유튜브 영상와 영상에서 소개한 논문을 가져와서 하나하나 보려고 한다. Abs

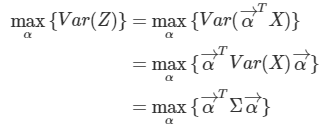

20.[📖논문 리뷰] Kernel Principal Component Analysis (1997)

기본적인 PCA 공부를 다시 해봣다... 앞서 정리하고 있던 이상탐지 리뷰 논문에서 이상탐지 방법론 중에 하나로 PCA를 통한 차원축소 후, 이 차원 축소 PC 값을 이상탐지에 사용하는 걸 얘기하고 있었다. 오랜만에 기억도 되살릴 겸 정리해보고 있다.애정하는 rastg

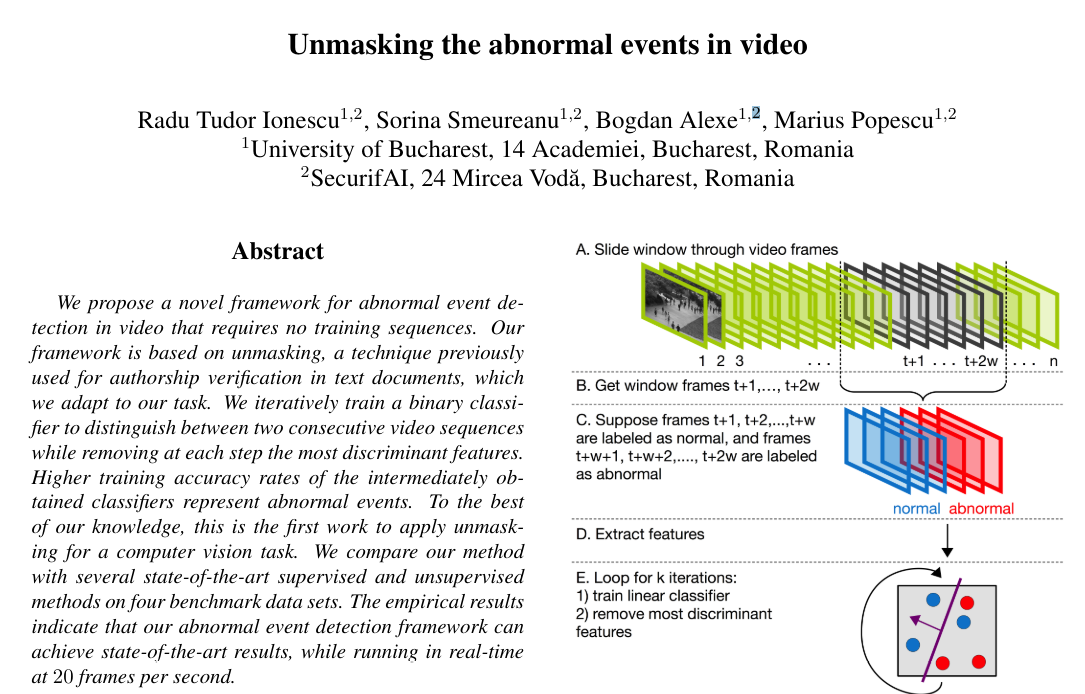

21.[📖논문 리뷰] Unmasking the abnormal events in video (2017)

비디오의 각 장면(Scene)이 비정상적인지 여부를 판단하는 알고리즘텍스트 저자 검증에 사용된 언마스킹(Unmasking, Koppel et al.) 기법을 비디오 프레임에 적용언마스킹(Unmasking)은 두 데이터 간의 유사도를 측정하기 위해 가장 구별력 있는 특징

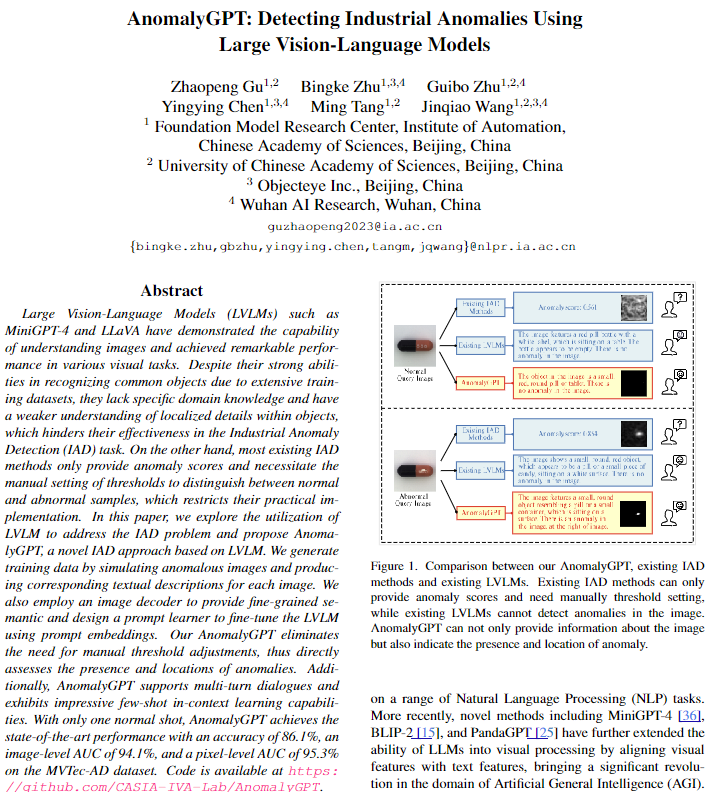

22.[📖논문 리뷰] AnomalyGPT: Detecting Industrial Anomalies Using Large Vision-Language Models (2023, AAAI 2024)

기말 프로젝트를 모빌리티 분야의 파손 진단 AI 분야를 하려고 한다. promptAD 같은 논문이랑 어떻게 보면 비슷한 분야의 논문인데 한 번 읽어보려고 한다. 실제로 AnomalyGPT에 가면 해볼 수 있는데 이상탐지라는 도메인에 특화된 ChatBot라고 보면 좋을

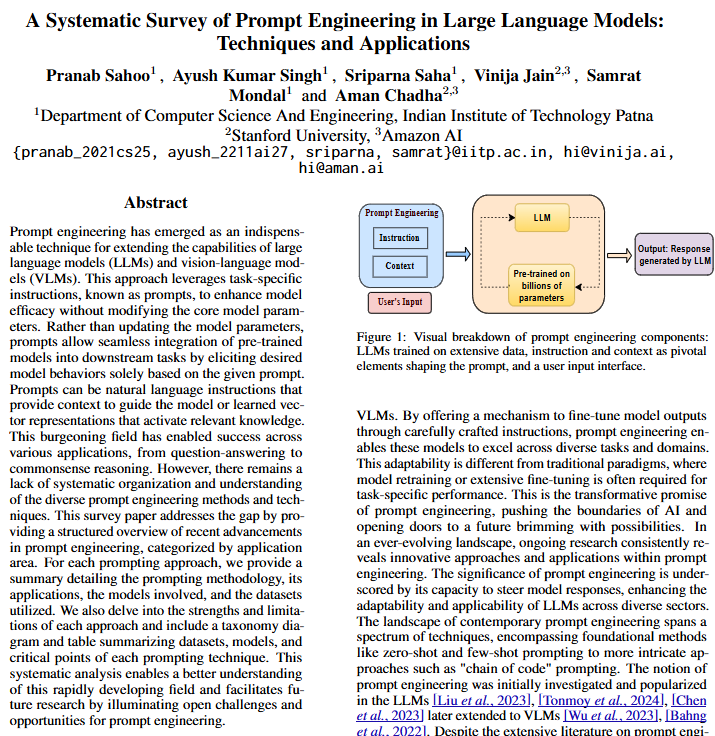

23.[📖논문 리뷰] A Systematic Survey of Prompt Engineering in Large Language Models: Techniques and Applications (2024)

Prompt Engineering 리뷰를 보면서 CoT(Chain-of-Thought)의 기반을 다지려고 본 리뷰 페이퍼입니다. 다른 블로그에 굉장히 잘 정리되어 있으니 참고하길 바랍니다.저는 이 논문에 정리된 여러 굵직한 논문들만 따로 각각 정리할 것이기에 여기선 간

24.[📖논문 리뷰] Chain-of-Thought Prompting Elicits Reasoning in Large Language Models (2022)

최근에 Prompting, Chain-of-Thought를 활용한 Few-shot reasoning을 통한 논문을 내려고 작업하고 있다. 그러면서 제대로 꼼꼼히 읽으려고 보고 있고, 정리해 보았다.본 논문은 NeurIPS 2022 Main Conference Track

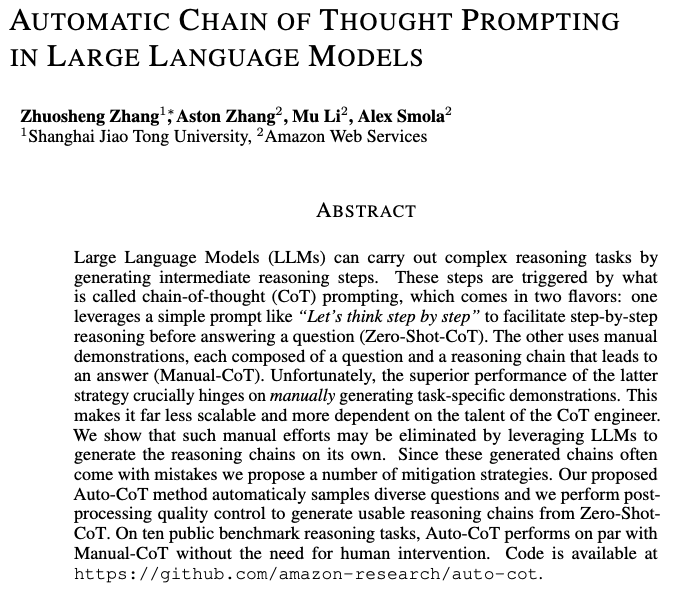

25.[📖논문 리뷰] Automatic Chain of Thought Prompting in Large Language Models (2024)

본 논문은 ICLR 2023 poster에 publish 된 논문으로 아마 많은 분들이 최근에 봤을 논문이다.✒️ Automatic Chain of Thought Prompting in Large Language Models(⭐ICLR-2023-Poster)아마 zer

26.[📖논문 리뷰] Zero-shot-CoT: Large Language Models are Zero-Shot Reasoners (2022)

본 논문은 NeurIPS 2022 Main Conference Track에 publish 된 논문으로 아마 많은 분들이 "Zero-Shot CoT"라고 알고 있는 논문이다.✒️ Large Language Models are Zero-Shot Reasoners(⭐Neur

27.[2025 ACL in Vienna 준비] 논문 읽기1

ACL Industry Track에 냈던 논문이 정말 운 좋게 되었다. Main Track은 아니지만, 내가 1저자로 작성한 첫 논문이 accept 되어서 매우 좋다. Logical Anomaly를 VLM을 통해서 탐지하고, 그 이상의 이유를 자연어로 설명할 수 있는