cs231n

1.cs231n 2강

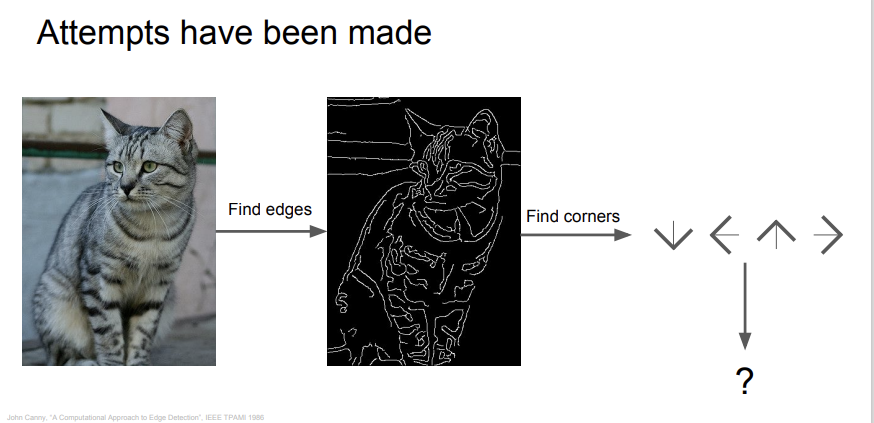

1. Computer Vision의 목표   Computer Vision의 기본적인 목표는 Image Classification이다. 이미지에 라벨을 각각 달아놓고, 어떻게 하면 알고리즘이 이 라벨에 맞게 이미지를 분류할지 고민하는 것이다. 우리는 눈으로

2.cs231n 3강

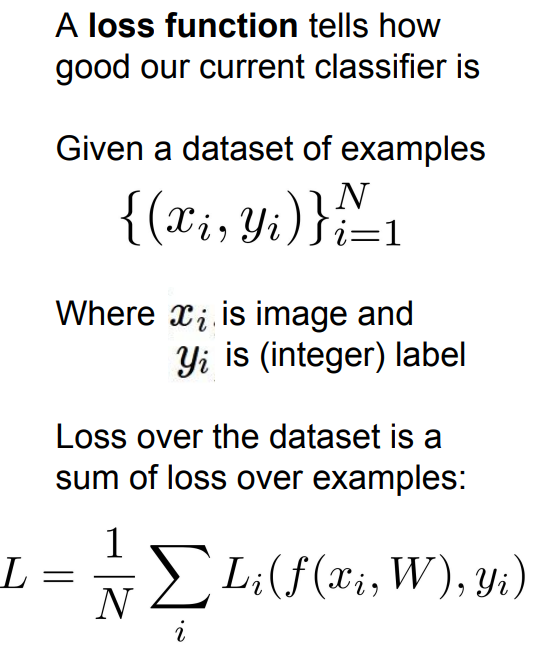

간단히 2강에서 다룬 내용을 복습하고 넘어가자. 주요한 주제들은 KNN, Linear classifier 가 있었다. 그 중에서 KNN은 영상처리에는 적합하지 않았고, Linear classifier는 Neural Network를 이루는 것이라고 하니, 잘 알아둘

3.cs231n 4강

지난 번 강의에서는 Softmax function과 SVM을 배웠고, Regularization을 배웠다. 그리고 테스트 데이터를 가장 잘 설명하기 위한 gradient를 찾기 위한 방법으로 gradient descent를 배웠다. 데이터의 크기가 너무 크다면 St

4.cs231n 5강

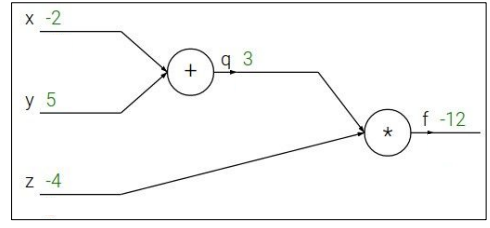

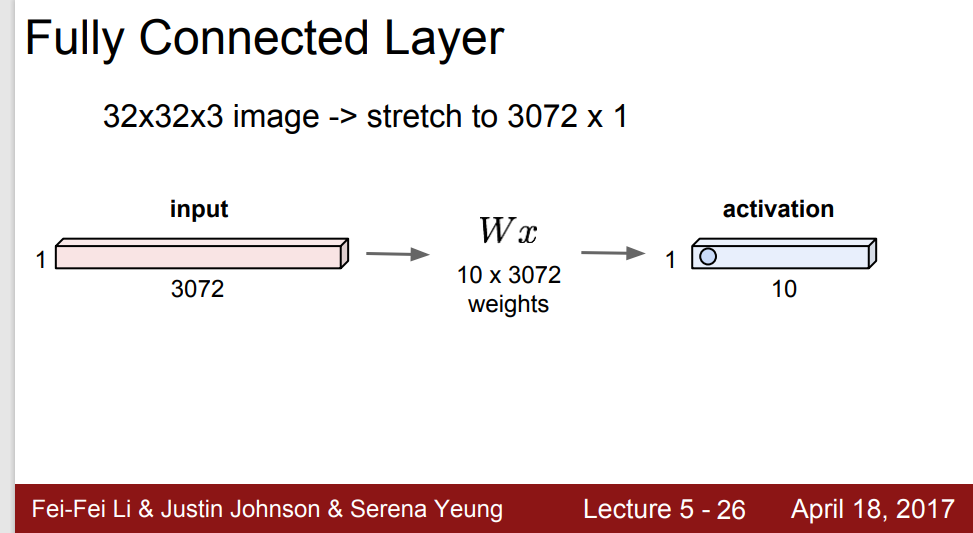

4강은 양이 꽤 많았다. 주요한 주제들만 짚고 넘어가자. 먼저 back propagation을 이용해 computational graph를 다루는 것에 대해 배웠다. 이는 임의의 식에 대해 일관된 방법으로 계산이 가능하다는 점에서 의미가 있었다. 그리고 back p

5.cs231n 6강

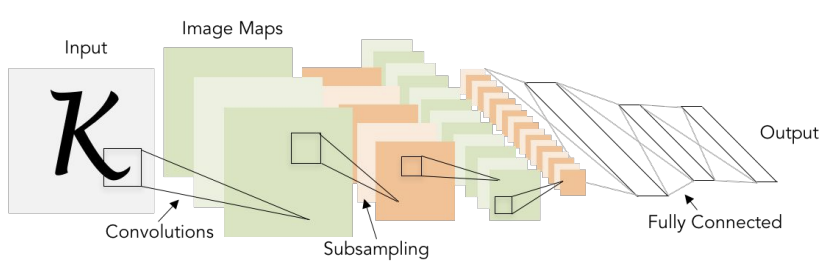

1. 5강 복습   지난 강의들에서 배운걸 총 복습해보자. 이제까지 식을 분리해서 computational graph를 그리는 법, 그리고 거기서의 back propagation에 대해 배웠다. 그 이후 Neural Network와 CNN에 대해서도 배웠

6.cs231n 7강

1.6강 복습   6강에서는 다양한 activation function, weight initialization, data preprocessing, batch normalization, hyperparameter search등을 배웠다. 여러가지 논의를

7.cs231n 9강

8강은 Deep Learning Software에 관한 내용이라 정리를 생략한다. 7강에서는 SGD의 문제점과, 각종 최적화 방법들에 대해서 배웠다. 그 중 가장 많이 사용하는 것은 Adam optimizer였다. 또, model ensemble을 이용해 train

8.cs231n 10강

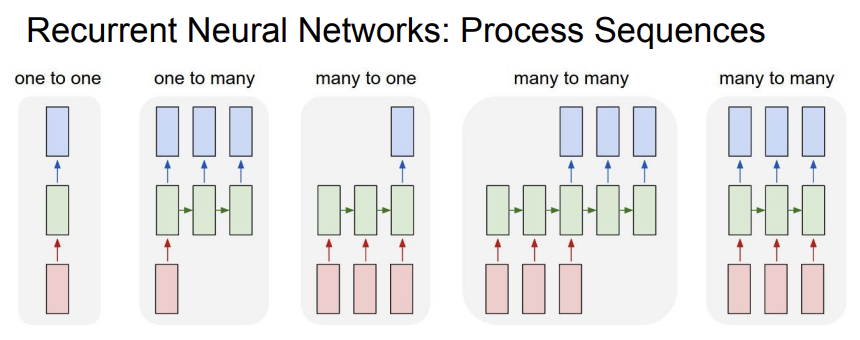

9강에서는 다양한 CNN Architecture들을 배웠다. 이번 강의에서 배울 RNN과 비슷한 효과를 가지는 ResNet도 배웠는데, ResNet은 skip connection이라는 것을 통해 gradient flow control을 가능하게 했다. 결과 값으로

9.cs231n 11강

저번 강의에서는 정해지지 않은 input, output에 쓰이는 RNN에 대해 배웠다. input과 output의 사이즈가 정해져 있는 케이스를 다루는 CNN보다 더 자유롭게 사용할 수 있다는 이점이 있었다. 물론 fixed size 케이스에 대해서도 CNN보다 더

10.cs231n 12강

지난 강의에서는 Computer Vision에서 다루는 다양한 주제들에 대해 알아봤다. object가 아니라 pixel 단위로 classification을 진행하는 Semantic Segmentation과 하나의 object를 찾고, 그 주변에 박스를 치는 clas

11.cs231n 13강

12강에서는 Visualization을 다루며 다양한 layer의 filter들을 시각화했었다. 첫 번째 layer의 filter들에서는 대체적으로 oriented edge를 찾는 경향을 보였고, intermediate layer들의 filter들에서는 의미 있는

12.cs231n 14강

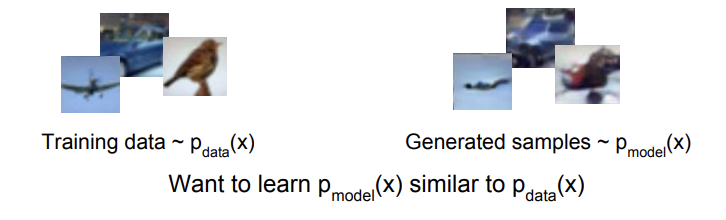

13강에서는 다양한 unsupervised learning 방법들인 PixelRNN/CNN, VAE, GAN에 대해서 알아봤다. Fully Visible Belief Network의 일종인 PixelCNN/RNN은 tractable한 density function을