- 전체보기(24)

- SKNetworks(7)

- 부트캠프(5)

- AI(4)

- Family AI camp(4)

- 코딩테스트(4)

- 머신러닝(3)

- SKN(3)

- 파이썬(3)

- CS(2)

- pinecone(2)

- Family AI(2)

- rag(2)

- chroma(2)

- 프로세스(2)

- 운영체제(2)

- 전진혁(2)

- 자료구조(2)

- 프로그래머스(2)

- tlb(2)

- 알고리즘 고득점 Kit(2)

- 코테(2)

- H Index(1)

- K번째수(1)

- 가장 큰 수(1)

- JJACKLETTE(1)

- prompt(1)

- Second Chance(1)

- CountVectorizer(1)

- PCB(1)

- Context Switching(1)

- sLLM(1)

- mmap(1)

- OrderedDict(1)

- 해시(1)

- Prompt Template(1)

- 선점형(1)

- django(1)

- 플레이데이터(1)

- agent(1)

- WSClock(1)

- iterable(1)

- BPE(1)

- views(1)

- page fault(1)

- 비선점형(1)

- 딥러닝(1)

- output parser(1)

- collections(1)

- AMAT(1)

- 스케줄링(1)

- SK네트웍스(1)

- AI캠프(1)

- langgraph(1)

- LRU(1)

- 디스크 컨트롤러(1)

- 더 맵게(1)

- 이중우선순위큐(1)

- MLFQ(1)

- python(1)

- counter(1)

- family(1)

- PTE(1)

- 드라이버(1)

- JavaScript(1)

- 쉘(1)

- 인코딩(1)

- Deque(1)

- LCEL(1)

- huggingface(1)

- 모델링(1)

- 스래싱(1)

- LFU(1)

- DTM(1)

- 폰켓몬(1)

- 지역성(1)

- bootstrap(1)

- SRTF(1)

- Lora(1)

- 레지스터(1)

- Bag of Words(1)

- Latency Cliff(1)

- vectorstore(1)

- Gantt 차트(1)

- MMU(1)

- 일급시민(1)

- langChain(1)

- transformers(1)

- 날씨(1)

- RR(1)

- 데이터 전처리(1)

- CSS(1)

- html(1)

- PEFT(1)

- 같은 숫자는 싫어(1)

- FIFO(1)

- 올바른 괄호(1)

- retriever(1)

- 세그먼테이션(1)

- 정렬(1)

- 페이지 테이블(1)

- 서브워드(1)

- 가상 주소(1)

- 디스패처(1)

- 스택(1)

- 프로젝트(1)

- mpd(1)

- VectorDB(1)

- 해저드(1)

- VISION(1)

- 파인튜닝(1)

- NLTK(1)

- 스케줄러(1)

- 주식가격(1)

- 기능개발(1)

- 커널(1)

- PFF(1)

- CRUD(1)

- 시스템콜(1)

- 큐(1)

- Prefetcher(1)

- computer science(1)

- hash(1)

- 힙(1)

- SK(1)

- 의상(1)

- defaultdict(1)

- COW(1)

- OS(1)

- 스레드(1)

- 다리를 지나는 트럭(1)

- 페이징(1)

- 정규표현식(1)

- 완주하지 못한 선수(1)

- 베스트 앨범(1)

- 전화번호 목록(1)

- Match Class(1)

- 디스코드(1)

CS Week 3 - 운영체제(3)

이전 WEEK 2 - 운영체제 (1)에서 프로세스와 CPU의 할당을 주된 내용으로 학습하였다면 이번 WEEK 3 - 운영체제 (2)에서는 실제 메모리와 관련된 여러 메커니즘들을 위주로 공부할 차례이다.메모리가 실제로 어떻게 점유되고 어떻게 사용되는지를 알기 위해서는 먼

알고리즘 - 정렬

해시, 큐/스택, 힙 자료구조에 이어 이번에는 알고리즘에 대해 처음으로 접해볼 시간이다. 그 중 이번에 살펴볼 것은 정렬 알고리즘이다. 정렬을 하는 알고리즘이 굉장히 많은 것으로 알고있지만 이 시리즈의 경우 코딩테스트를 위한 정리본이므로 여러 정렬 알고리즘에 대해 다루

자료구조 - 힙

지난 스택/큐 구조에 이어 이제는 힙 구조에 대해 알아볼 차례이다 !힙은 특정한 규칙(최대 or 최소)을 가지는 완전이진트리로 "전체 정렬된 트리"가 아니라 "부분 정렬된 트리의 집합" 구조를 말한다.트리 전체가 아닌, 부모와 자식간의 관계에 대해서만 특정한 규칙을 확

CS Week 2 - 운영체제(1)

지난 주차 컴퓨터를 이루는 CPU와 메모리, 캐시 메모리 등 여러 하드웨어적인 요소들에 이어 이번 주차는 컴퓨터의 두뇌, 운영체제와 관련된 내용을 공부하였다.그 중에서도 운영체제와 프로세스, 스레드에 대해 알아보고 운영체제가 이들을 어떻게 관리하고 이들이 어떻게 실행되

자료구조 - 큐/스택

지난 해시 구조에 이어 가장 기본적인 자료 구조 중 큐/스택 구조에 대해 알아볼 차례이다.큐(Queue) 구조란 FIFO(First In First Out)이 구현된 구조이며,스택(Stack) 구조란 LIFO(Last In First Out)이 구현된 구조이다.이 두

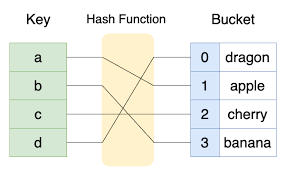

자료구조 - 해시

코딩 테스트와 기초적인 파이썬 실력을 위해 공부중이던 자료구조와 알고리즘 관련 내용을 포스트하기로 결정하였다. 아무래도 남기는게 좋은 것.... 공부 방식의 경우 프로그래머스 - 알고리즘 고득점 Kit의 내용을 기반으로 하였으며 **1) 자료구조 / 알고리즘에 대한

SKNetworsks Family AI 캠프 13기 16주차 회고

지난 주 얕게나마 프론트를 구성하는 세 가지 언어에 대해 알아보았다. HTML, CSS, JavaScript 가 그들이다. 이들을 통해 각각의 페이지가 어떻게 구성될 지, 각 페이지에서 사용자의 이벤트를 캐치하여 어떤 행동을 할지에 대해 정할 수 있었다. 이제 이들을

CS Week 1 - 컴퓨터 구조 기초

카카오 그룹의 CS(Computer Science) 테스트를 처음 접하고 비전공자의 무지함을 직접 실감하니 따로 공부하지 않고는 버틸 수가 없었다...그렇게 시작된 비전공자의 8주 짜리 CS 기초 다지기 !차근차근 달려가다보면 언젠가 끝에 닿으리라 믿으며 첫 주차를 시

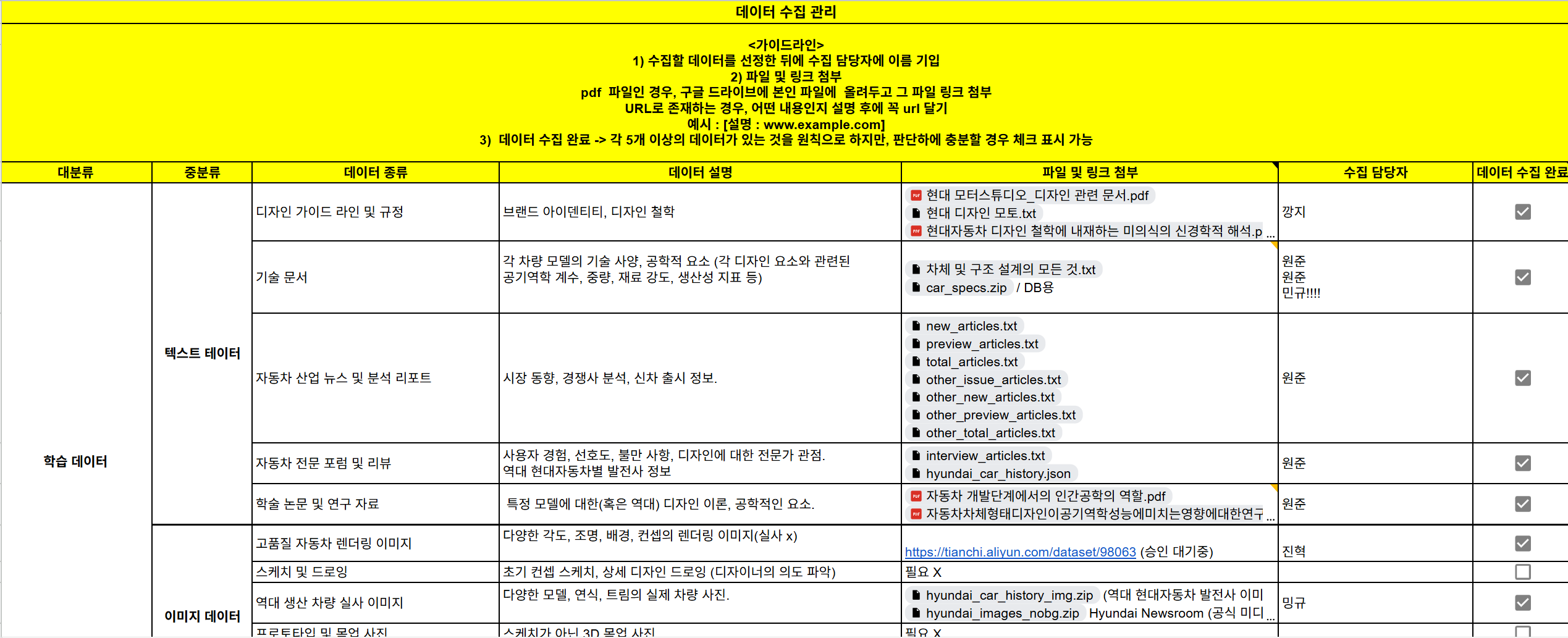

SKNetworks Family AI 캠프 13기: 최장 프로젝트의 AI 부트캠프

2025.03.24 (월) 을 시작으로 교육 및 단기 프로젝트로 이루어진 4개월과 최종 프로젝트 2개월, 총 6개월 간의 긴 여정이 2025.09.15 (월) 을 기점으로 끝이 났다. 이번 블로그에서는 최종 프로젝트를 진행하면서 배운 점과 느낀 점을 마지막으로 돌이켜보

SKNetworsks Family AI 캠프 13기 15주차 회고

지난 14주 동안 파이썬부터 시작해 여러 라이브러리를 거쳐 최종 LLM 모델 구성에 도달하기까지 많은 길을 걸어왔다. 이제 모델링에서 빠져나와 시야를 확장시켜 볼 단계이다. 프론트엔드 기초를 배우고, Django를 통해 웹 애플리케이션을 구성해 볼 것이며 AWS를

SKNetworsks Family AI 캠프 13기 14주차 회고

지난 주차까지 LLM API 를 이용하여 여러 체인을 구성해 원하고자 하는 task 를 해결해보는 과정을 배웠다.이렇게 발전된 거대 LLM 모델은 터무니없는 데이터 양을 학습하였기에 분명 막강한 성능을 지녔지만, 여러 방면에 있어 명백한 한계점을 지닌다.1) 특정 작업

SKNetworsks Family AI 캠프 13기 13주차 회고

이전 시간까지 하여 LangChain 을 이용하여 LLM 모델을 사용하는 전반적인 방법에 대해 알아보았다. 이제는 그 LLM 모델을 더 효율적으로 사용할 방법에 대해 배울 차례이다. LLM 모델은 태초부터 챗봇을 위해 나온 모델이 아니라 랜덤한 자연어를 최대한 말이

SKNetworks Family AI 캠프 13기 12주차 회고

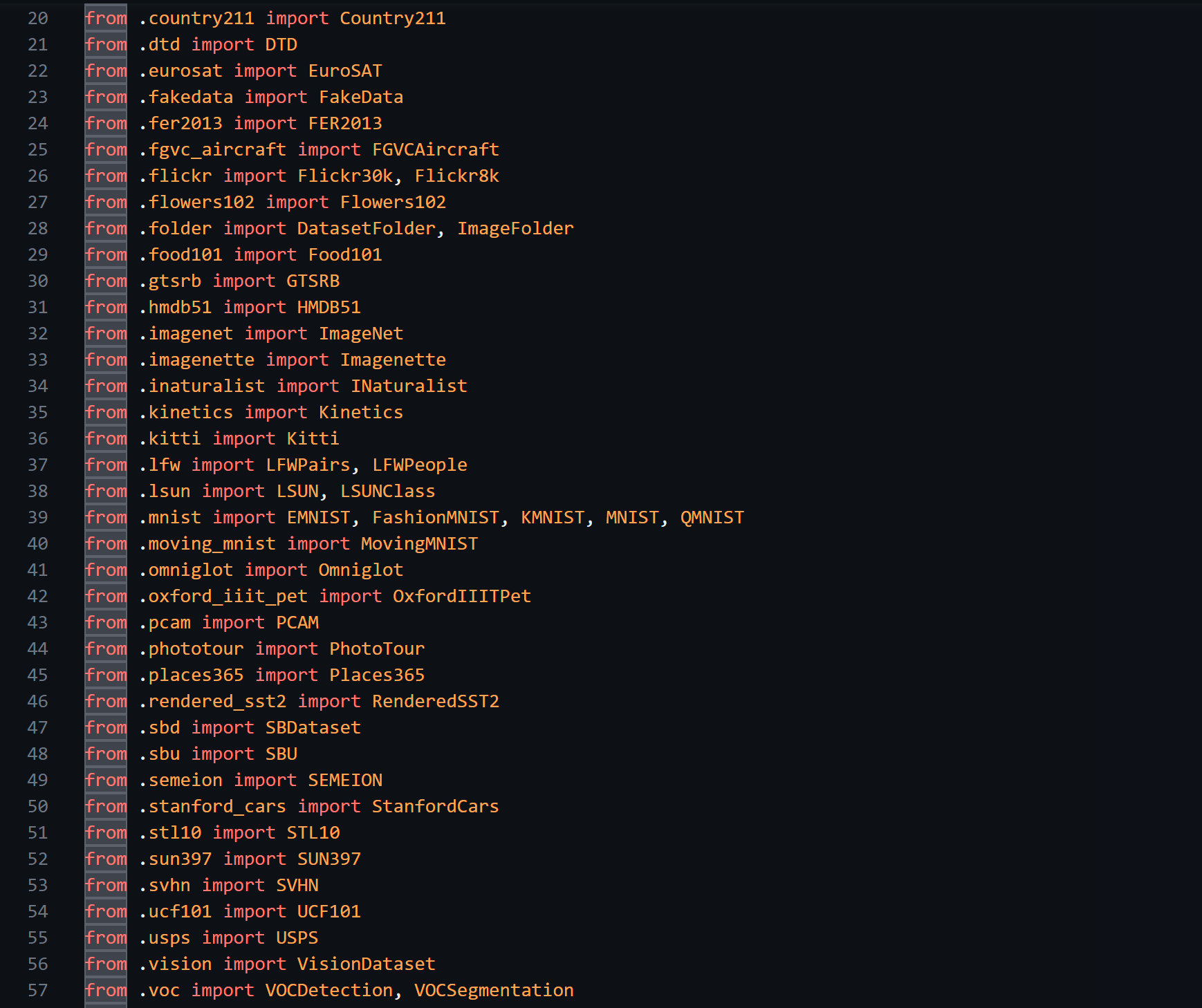

앞서 Hugging Face의 transformer 기반 모델을 활용하여 여러 task를 해결할 수 있음을 알았다. 그럼 끝인가? 초기 학습과 지속적인 추가 학습, 출력 저장용 데이터베이스가 추가로 필요하며 연결되어야 할 것이며 이 모델을 상용화하기 위한 여러 프레

SKNetworks Family AI 캠프 13기 11주차 회고

자연어에서 문맥의 정보를 처리하기위해 도입한 RNN은 그 구조 자체가 하나의 Layer를 계속해서 순환하여 사용하는 구조적인 문제로 데이터의 병렬 처리가 불가능하며 시간에 따른 장기 기억 손실 문제를 해결할 수 없었다. LSTM이나 그 구조를 개선한 GRU의 경우에도

SKNetworks Family AI 캠프 13기 10주차 회고

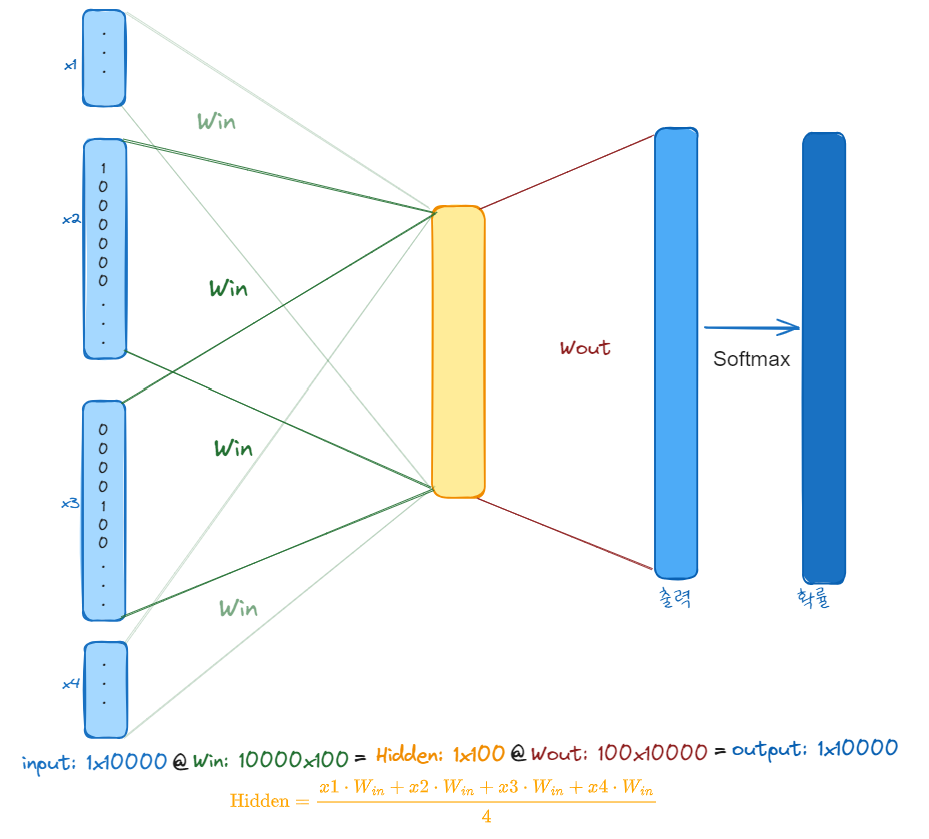

지난 한 주를 통해 자연어 텍스트를 쪼개 토큰으로 분류하고, 이 토큰들을 통해 커다란 단어 사전을 만드는 법에 대해 배웠다. 이제 우리는 자연어 텍스트를 입력으로 받으면 이를 숫자 배열로 바꿀 수 있게 되었다. 이번 한 주는 이렇게 쪼갠 단어들을 하나의 벡터로 바

SKNetworks Family AI 캠프 13기 9주차 회고

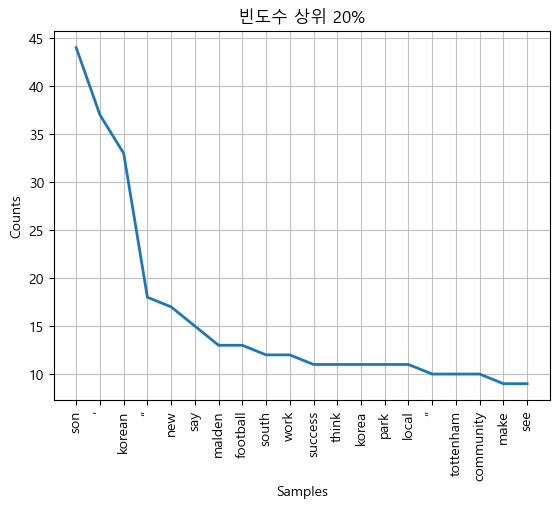

자연어 처리에 대해 배우기 시작하는 첫 주 !머신러닝과 딥러닝을 배울때와 마찬가지로 해당하는 개념을 먼저 배우고 그 개념을 짜놓은 라이브러리를 숙달하는 방식으로 수업이 진행되었다.정형화된 데이터를 사용하던 머신러닝에서 비정형 값을 데이터로 사용하던 딥러닝에 이어 이제는

SKNetworks Family AI 캠프 13기 8주차 회고

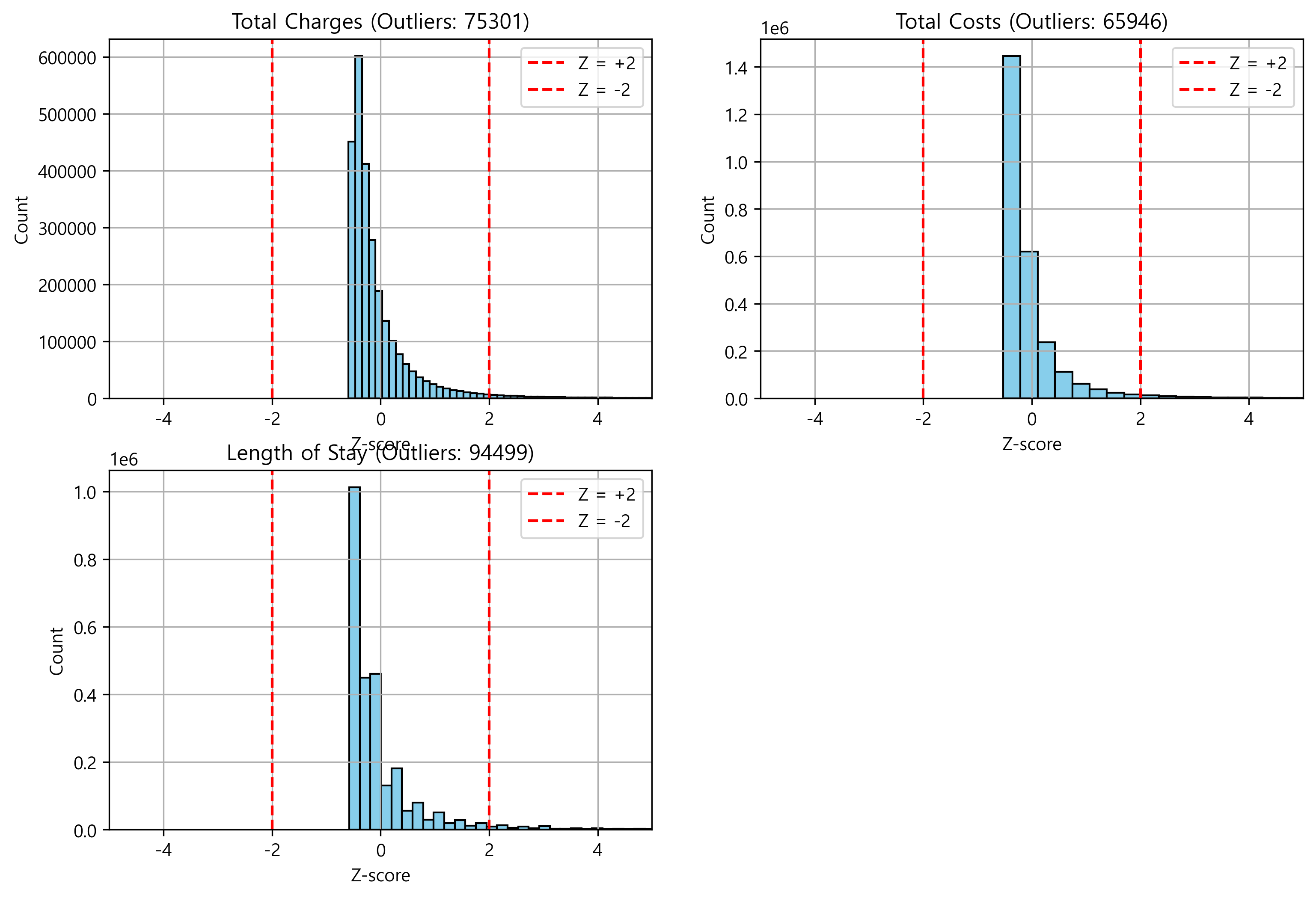

딥러닝을 마무리하고 여태까지 배운 내용을 꽃 피우는 프로젝트 주간이 지나갔다. > https://github.com/SKNETWORKS-FAMILY-AICAMP/SKN13-2nd-7Team.git 데이터를 분석해서 이탈 유저를 분석하라는 대주제에 우리 팀은 이탈 대

SKNetworks Family AI 캠프 13기 7주차 회고

드디어 고대하던 딥러닝을 배우는 한 주가 시작되었다. 이곳 저곳 흩어진 비정형 데이터를 모아 의미있는 값을 추출해낸다는 딥러닝의 아이디어가 너무도 매력적으로 느껴져 열심히 배워보고 싶었지만,,,, 연휴를 지나며 두통을 동반한 감기에 걸리는 바람에 수업을 제대로 따라가

SKNetworks Family AI 캠프 13기 6주차 회고

4/28 (월) ~ 5/2 (금) 까지 진행된 6주차에서는 머신러닝의 개별 모델들에 대해 더욱 상세하게 배우는 동시에 다음 챕터인 딥러닝에 대해 맛보는 시간을 가졌다.5/1 목요일부터 그 다음주 5/6 화요일까지 이어지는 연휴에 많은 머신러닝 내용을 다시 정리해 블로그

SKNetworks Family AI 캠프 13기 5주차 회고

지난 주에 분명 코딩 테스트를 위한 알고리즘에 대해 공부하겠다고 다짐했건만.... 5주차에 들어와 본격적으로 배워본 머신러닝은 감히 한 눈을 팔 대상이 아니었다.불과 제작년과 작년에 걸쳐 머신러닝에 대해 배울 기회가 있었고, 열심히도 공부했었지만 개념을 공부하는 것과