핸즈온 머신러닝

1.핸즈온 머신러닝 - Part1. 머신러닝 ch2. 머신러닝 프로젝트 처음부터 끝 까지

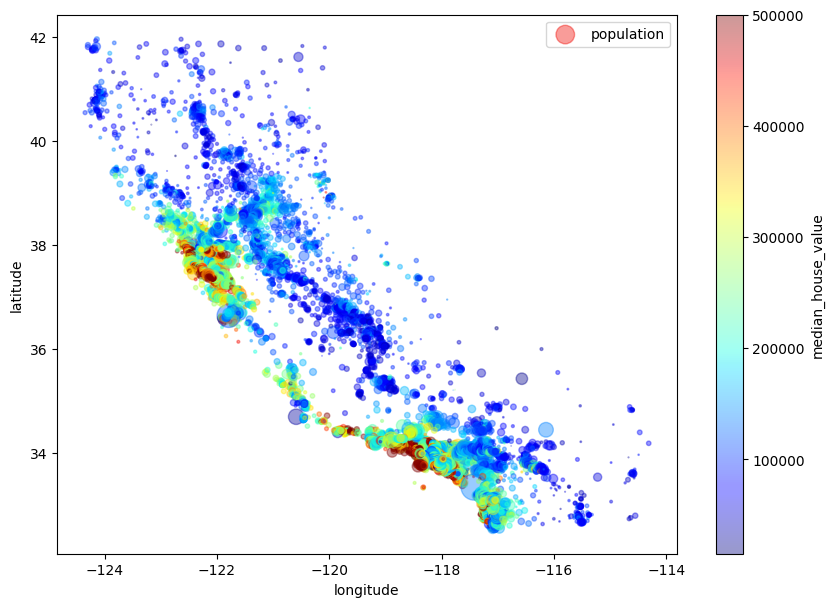

경도 위도를 기준으로 집값을 시각화여기에서 원의 크기는 인구수실제 캘리포니아 지도를 넣어 시각화사이킷런의 SimpleImputer 로 Null값 중간값으로 대체하기

2.핸즈온 머신러닝 - Part1. 머신러닝 ch3. 분류

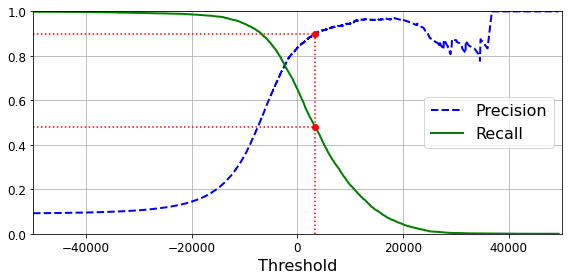

cross_val_score:cross_val_score 함수는 간단한 교차 검증을 수행하기 위해 사용됩니다. 주어진 모델과 데이터에 대해 K-폴드 교차 검증을 수행하고, 각 폴드에서 모델의 성능을 평가하여 평균 성능을 반환합니다. 이 함수를 사용하면 간단하게 교차 검

3.핸즈온 머신러닝 - Part1. 머신러닝 ch4. 모델 훈련

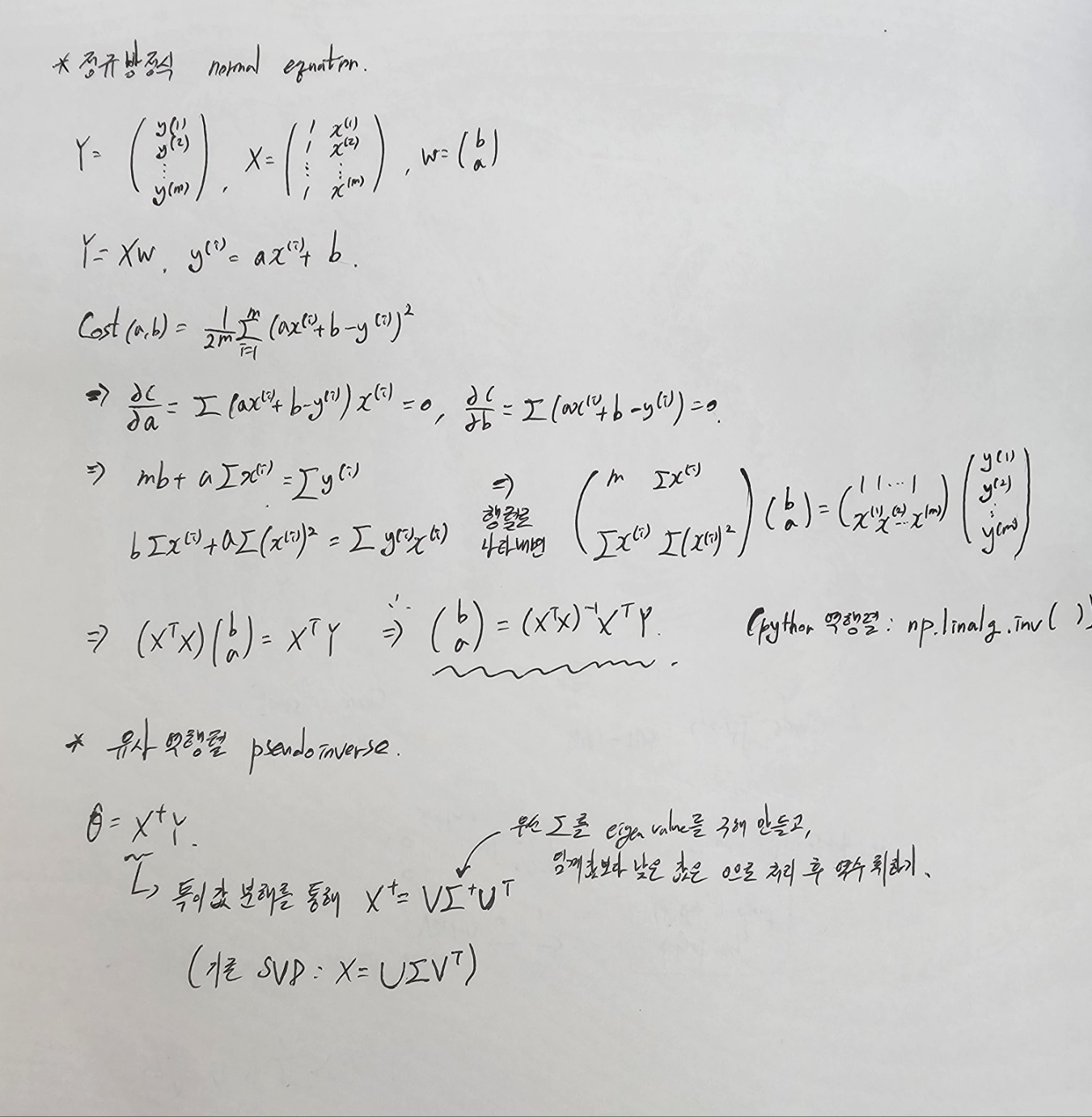

선형회귀경사하강법규제가 있는 선형 모델선형 회귀의 cost ft이 MSE라고 할 때, 이 cost ft을 최소화 시키는 값은 무엇일까?1) 미분을 통해 나온 정규방정식(normal equation) 풀기2) 역행렬이 불가할 때, 유사역행렬(pseudoinverse) 찾

4.핸즈온 머신러닝 - Part1. 머신러닝 ch5. 서포트 벡터 머신

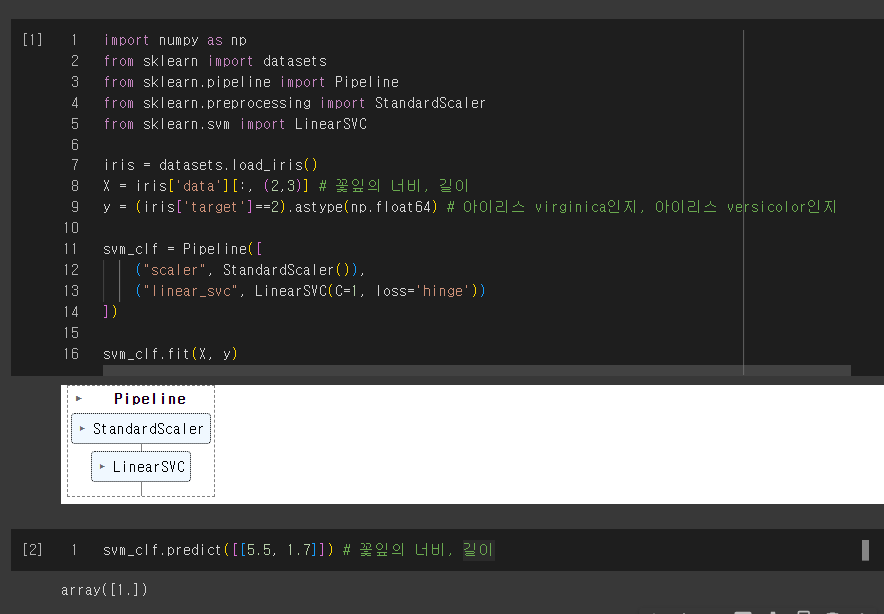

선형 SVM 분류비선형 SNM 분류SVM 회귀SVM 이론SVM은 선형, 비선형 분류, 회귀, 이상치 탐지에 사용할 수 있는 다목적 머신러닝 모델입니다.복잡한 분류 문제에 잘 들어 맞으며, 작거나 중간 사이즈의 dataset에 적합합니다.SVM의 support vecto

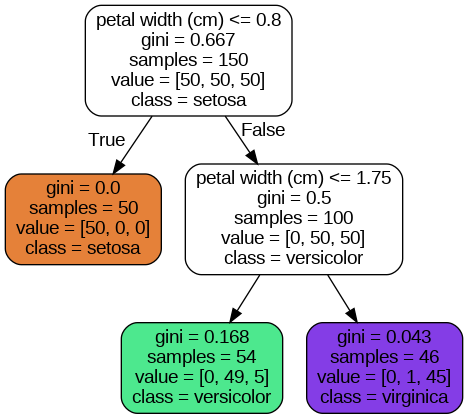

5.핸즈온 머신러닝 - Part1. 머신러닝 ch6. 결정 트리

아래는 깊이 2에 대한 불순도 측정입니다.Q. 둘 중 어떤 것을 사용해야 할까요?사실 실제로는 큰 차이는 없습니다. 지니 불순도가 좀 더 빠르긴 하기에 default로 사용하지만, 지니 불순도는 다른 트리가 만들어 지는 경우 가장 빈도가 높은 클래스를 한쪽 가지로 고립

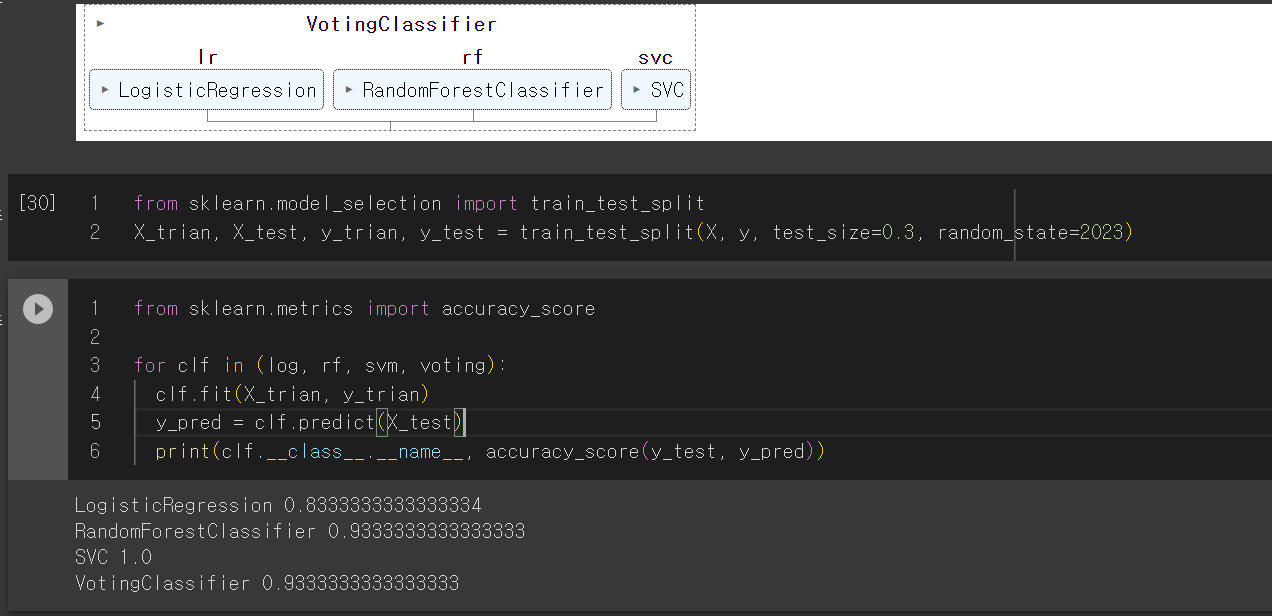

6.핸즈온 머신러닝 - Part1. 머신러닝 ch7. 앙상블 학습과 랜덤포레스트

Votinghard, softBagging Random ForestBoosting AdaBoost, Gradient Boost, XGBoost(eXtra Gradient Boost), LightGBM(Light Gradient Boost)Stacking보팅은 hard,

7.핸즈온 머신러닝 - Part1. 머신러닝 ch7. 앙상블 학습과 랜덤포레스트

Votinghard, softBagging Random ForestBoosting AdaBoost, Gradient Boost, XGBoost(eXtra Gradient Boost), LightGBM(Light Gradient Boost)Stacking보팅은 hard,

8.핸즈온 머신러닝 - Part1. 머신러닝 ch7. 앙상블 학습과 랜덤포레스트

Votinghard, softBagging Random ForestBoosting AdaBoost, Gradient Boost, XGBoost(eXtra Gradient Boost), LightGBM(Light Gradient Boost)Stacking보팅은 hard,

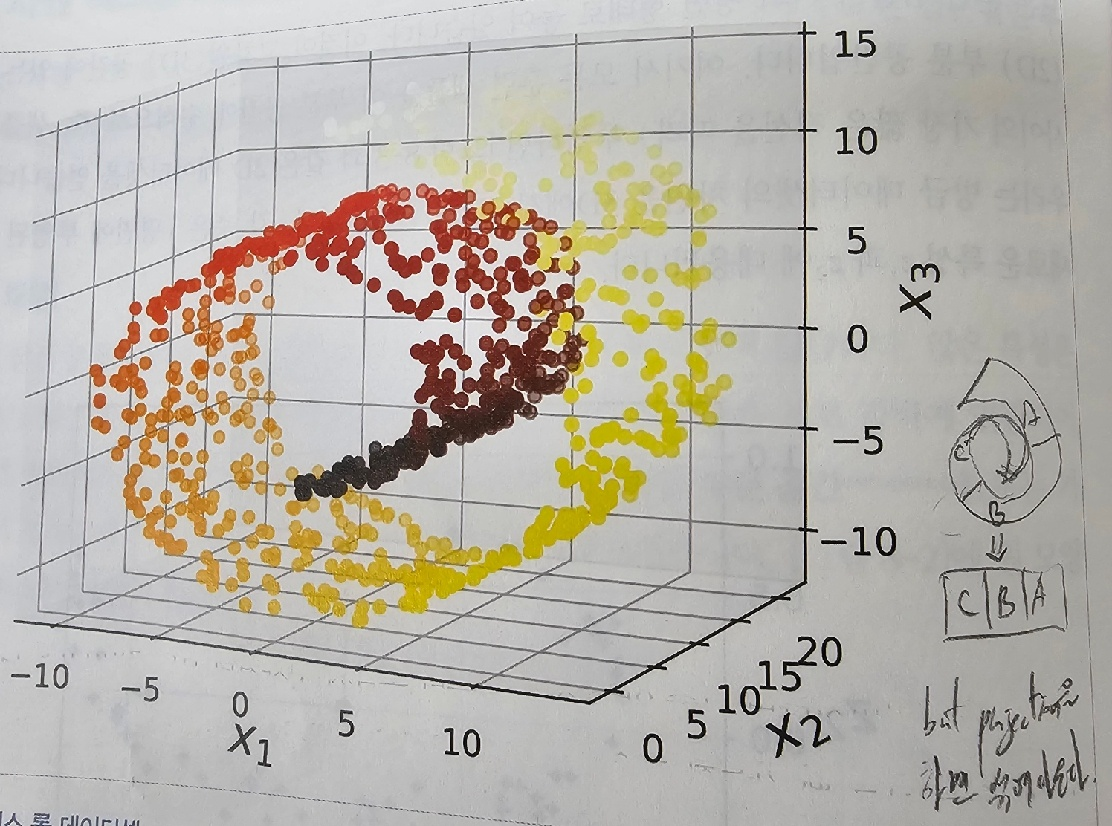

9.핸즈온 머신러닝 - Part1. 머신러닝 ch8. 차원 축소

데이터 양에 비해 특성이 너무 많다면 훈련을 느리게 할 뿐 아니라, 좋은 솔루션을 찾기 어려워 집니다. 이러한 문제를 차원의 저주 : Curse of Dimensionality라고 합니다.차원이 늘어남에 따라 데이터들의 거리들이 늘어납니다. 이는 새롭게 들어오는 샘플

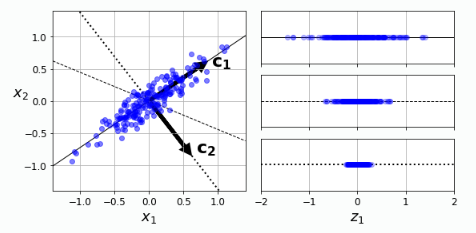

10.핸즈온 머신러닝 - Part1. 머신러닝 ch8. 차원 축소 (2) PCA LLE

PCA는 주성분 분석이라고 부르며, 분산이 가장 큰 component를 찾고, 그 principal component를 기반으로 orthogonal한 축 중 다시 한 번 분산을 최대로 보존하는 것을 찾아 나가는 것 입니다.이를 통해 데이터의 분산을 최대한으로 보존하며

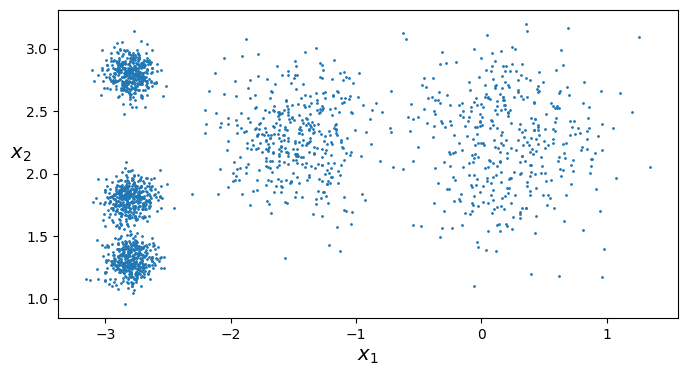

11.핸즈온 머신러닝 - Part1. 머신러닝 ch9-1. 비지도 학습 - 군집

8장에서는 가장 널리 사용되는 비지도 학습 방법인 차원 축소를 알아보았습니다.이번 장에서는 추가적인 비지도 학습과 알고리즘을 알아보겠습니다.군집비슷한 샘플을 클러스로 모읍니다.이상치 탐지정상 데이터가 어떻게 보이는지를 학습하고, 그 다음 비정상 샘플을 감지하는 데 사용

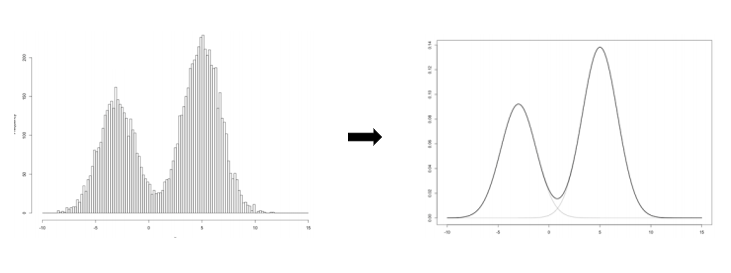

12.핸즈온 머신러닝 - Part1. 머신러닝 ch9-2. 비지도 학습 - 가우시안 혼합

GMM은 전체 데이터를 몇 개의 가우시안 분포로 표현할 수 있다고 가정하여 각 분포에 속할 확률이 높은 데이터로 군집을 형성하는 기법입니다.GMM은 기존 K-means, DBSCAN과 다르게 확률을 통해 군집을 형성합니다. GMM의 파라미터 : 평균, 분산, 각 분포가

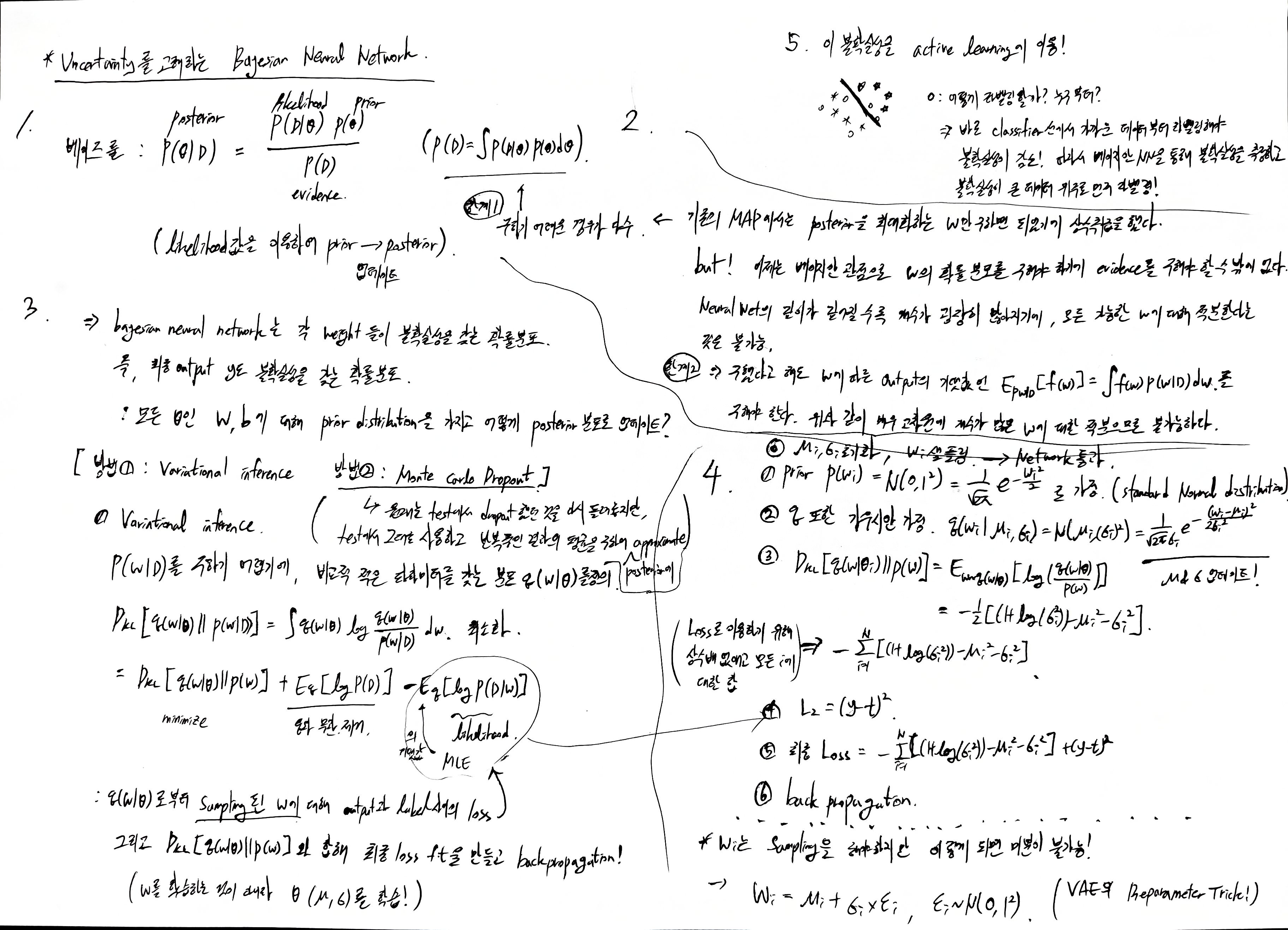

13.Uncertainty를 고려하는 Bayesian Neural Network

Uncertainty를 고려하는 Bayesian Neural Network

14.핸즈온 머신러닝 - Part2. 신경망과 딥러닝 ch16. RNN과 어텐션을 사용한 자연어 처리

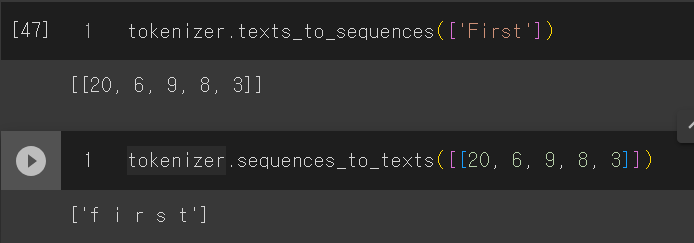

시계열을 다룰 때, 주로 시간의 순서에 따라 나누는 것이 안전하다.암묵적으로는 RNN이 과거에서 학습하는 패턴이 미래에도 등장한다고 가정한다. 즉, 변하지 않는다는 statioinary를 가정한다.하지만 금융시장같이 굉장히 불안정한 경우는 패턴을 발견한 뒤 적용하면 바

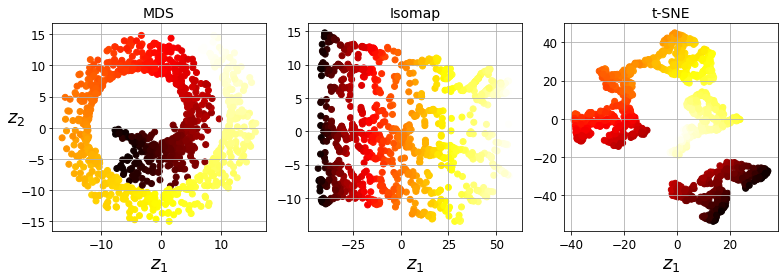

15.핸즈온 머신러닝 - Part1. 머신러닝 ch8. 차원 축소(3) 다른 차원 축소 기법

앞에서 설명드린 차원 축소 기법 이외에도 다양한 기법들이 존재합니다.1) MDS : Multi-Dimensional Scaling샘플 데이터들 간의 거리를 보존하면서 차원을 축소하는 기법입니다. 2) Isomap각 데이터 포인트를 가장 가까운 이웃과 연결하는 식의 그래