Computer Vision

1.GTSRB(교통표지판 분류 문제)에 대한 Classifier model 비교

목적 : 교통 표지판 이미지 데이터를 이용하여 여러 분류 모델을 구현하고 분류기별 성능 비교과정 : 대량의 이미지 데이터를 전처리 - support vector machine, random forest, cnn 세 모델의 성능 차이 확인 \- 캐글에서 제공하는 교통표지

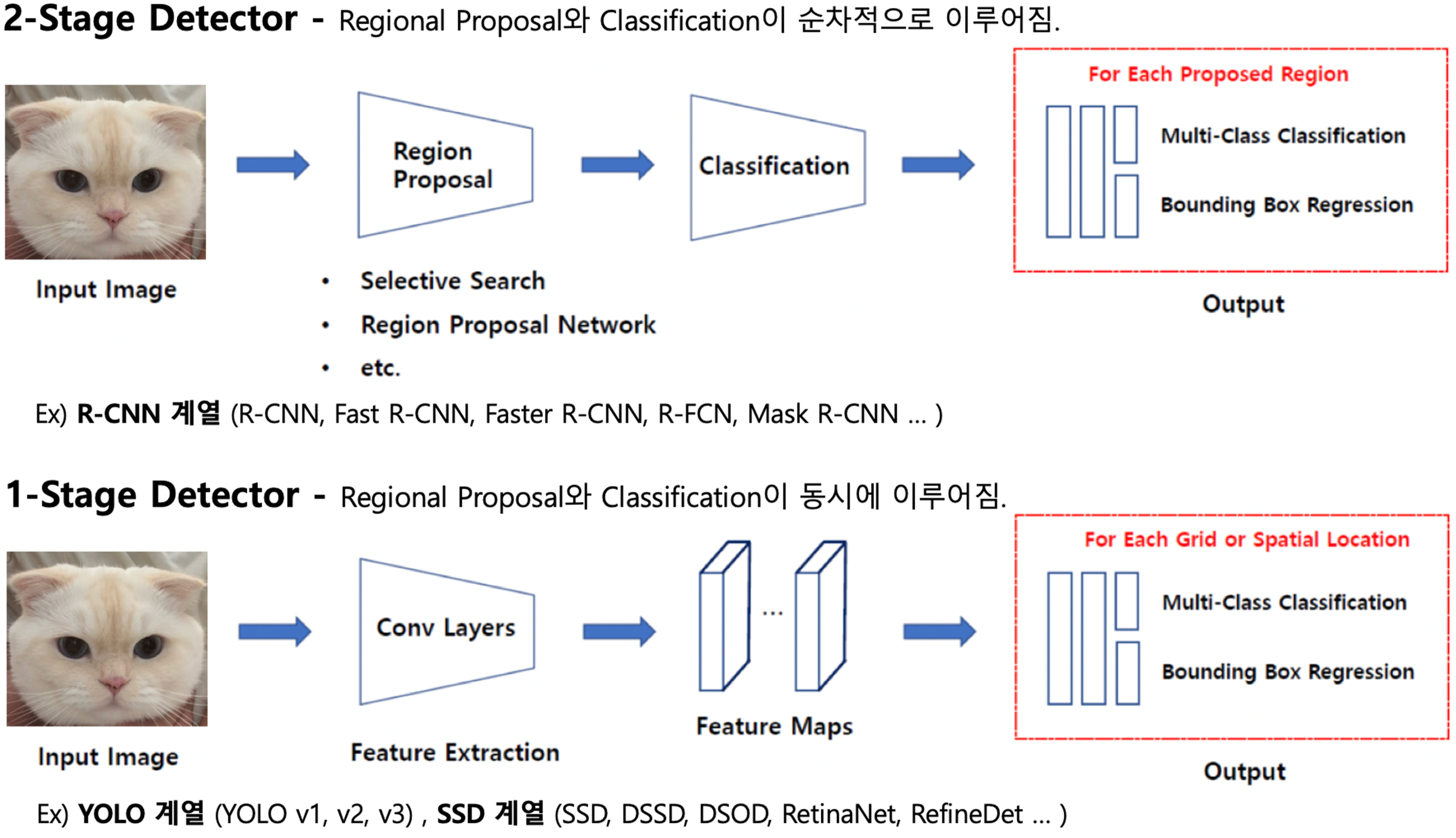

2.[Object Detection] Architecture - 1 or 2 stage detector 차이

Object detection 아키텍처에는 1-stage detector과 2-stage detector가 있습니다. 본 글에서는 두 아키텍처 모델의 차이점에 대해 알아보려고 합니다.

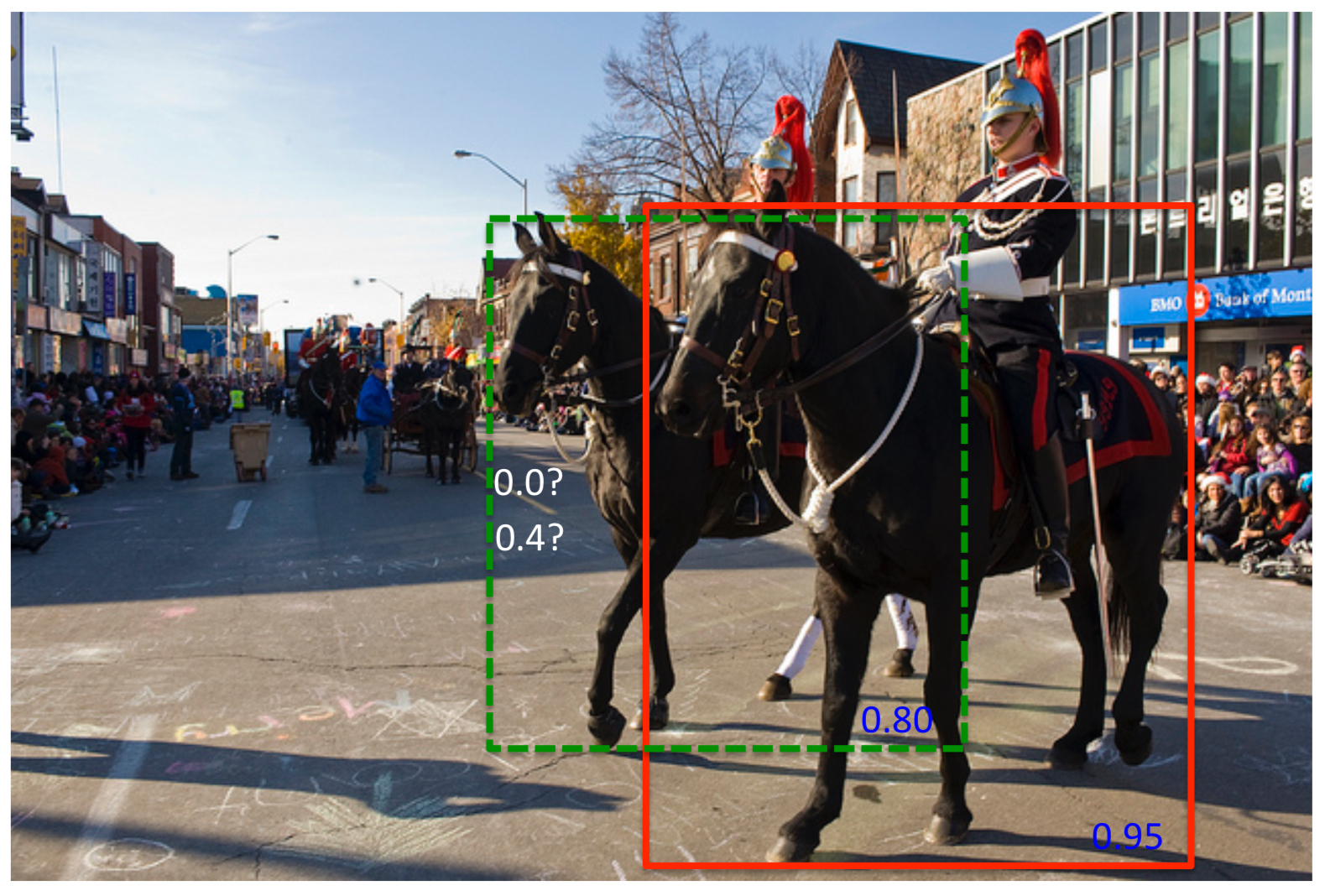

3.[Object Detection] NMS(Non Maximum Suppression), Soft NMS

본 글에서는 Object detection의 Overlap problem의 해결방안인 NMS(Non Maximum Suppression), 그리고 NMS의 같은 객체를 가리키는 IoU 문제를 해결하기 위한 Soft NMS에 대해서 다루어보겠습니다. Overlap pr

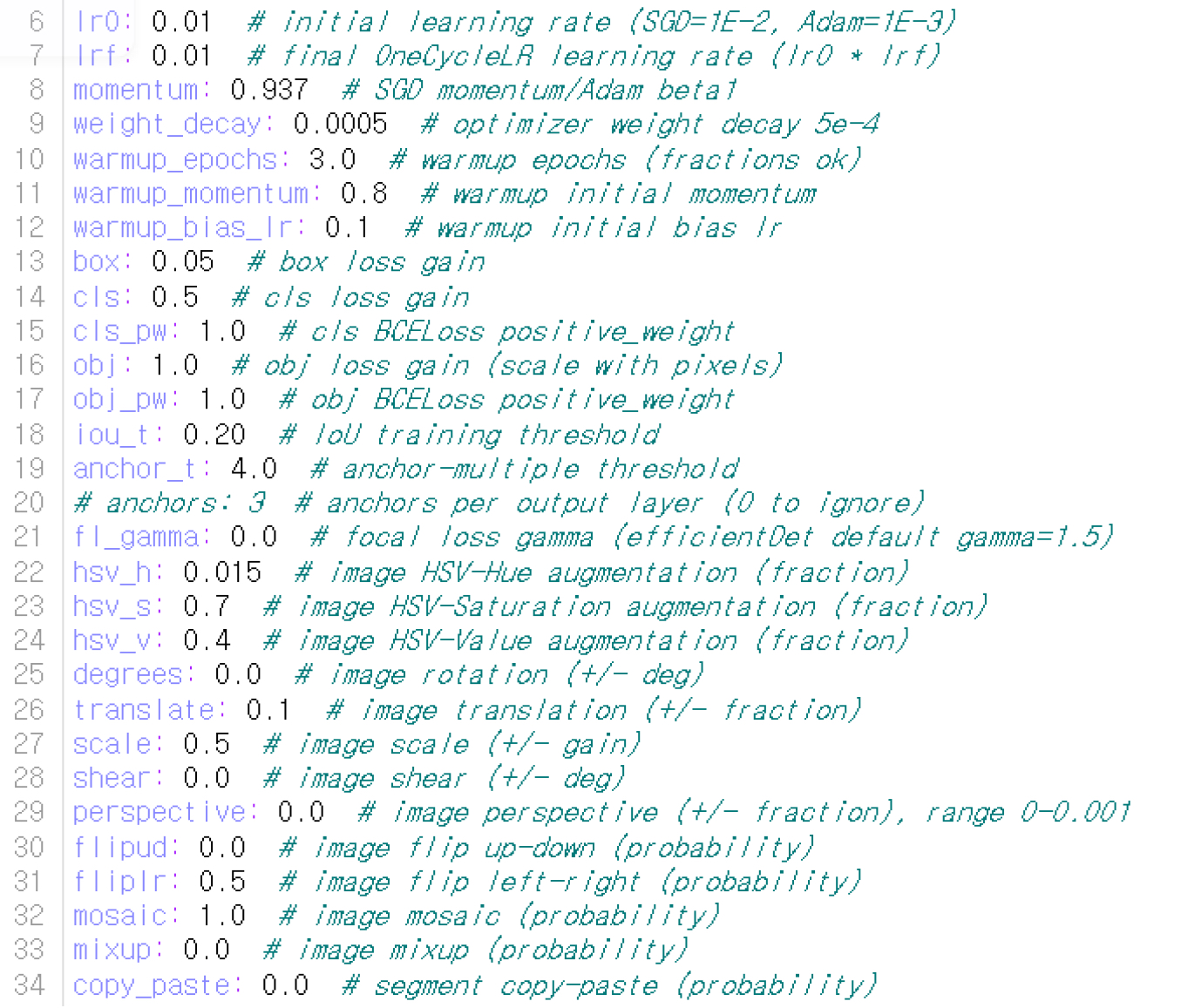

4.[ YOLO ] yaml 파일 hyper parameter 정리

본 글에서는 YOLO 모델 사용시 하이퍼파라미터를 조정하기 위해 yaml 파일에 있는 파라미터에 대한 설명을 정리하였습니다.lr0 : 시작 learning ratelrf : 종료시점의 learning ratemomentum : gradient descent를 통해 gl

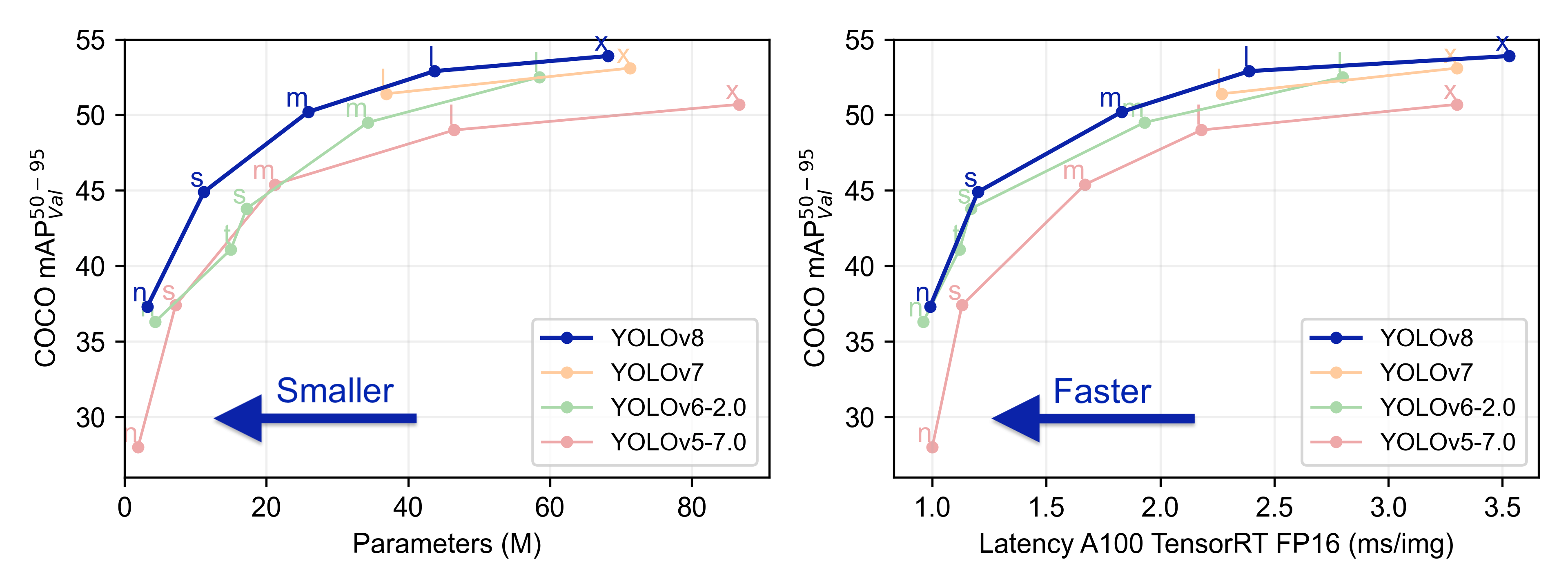

5.[YOLO] YOLO 버전 - Yolo v1부터 Yolo v8까지 (23.03.기준)

이번 글에서는 YOLO 시리즈별 구조 및 특징에 대해 정리해보겠습니다. 23년 3월 기준 YOLO는 버전 8까지 나와있습니다. < YOLO 버전별 출시 시점 > - YOLOv1 : 2016년에 발표된 최초 버전으로, 실시간 객체 검출을 위한 딥러닝 기반의 네트워크

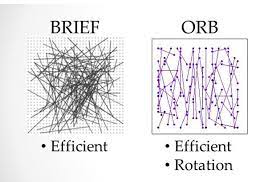

6.ORB(Oriented FAST and Rotated BRIEF)

OpenCV의 ORB (Oriented FAST and Rotated BRIEF) > 특징점 검출 및 기술자(descriptor) 생성을 위한 알고리즘으로, 이미지에서 고유한 특징점을 찾고 이러한 특징점들을 설명하는 특징 기술자를 생성하는데 활용 ORB는 FAST

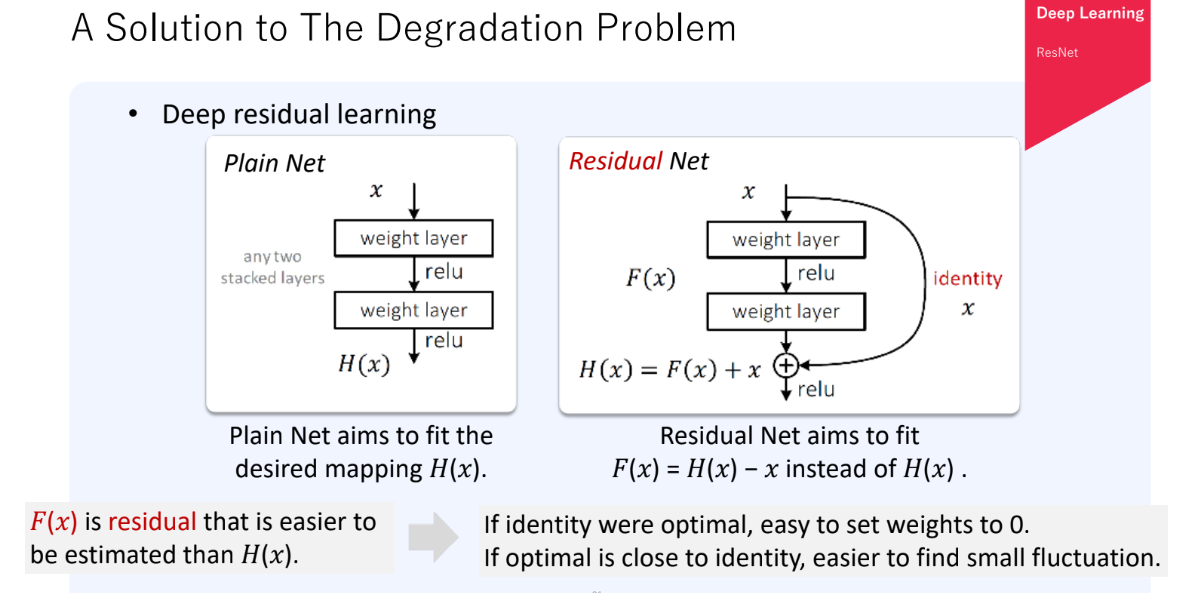

7.ResNet(Residual Network)

ResNet(Residual Network)은 딥 러닝 아키텍처의 한 종류로, 이미지 분류 및 다양한 컴퓨터 비전 태스크에서 매우 성공적으로 사용되는 모델Residual block이라고 불리는 구조를 사용하여 깊은 신경망을 학습레이어를 하나씩 쌓는 대신, 기존의 레이어

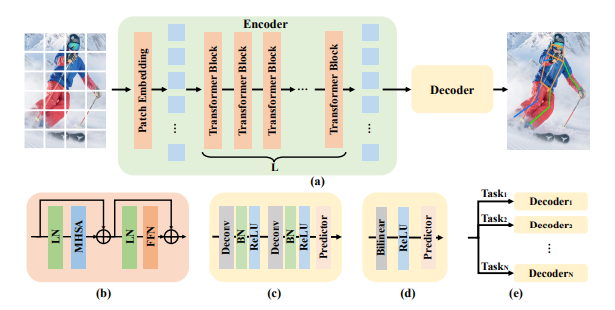

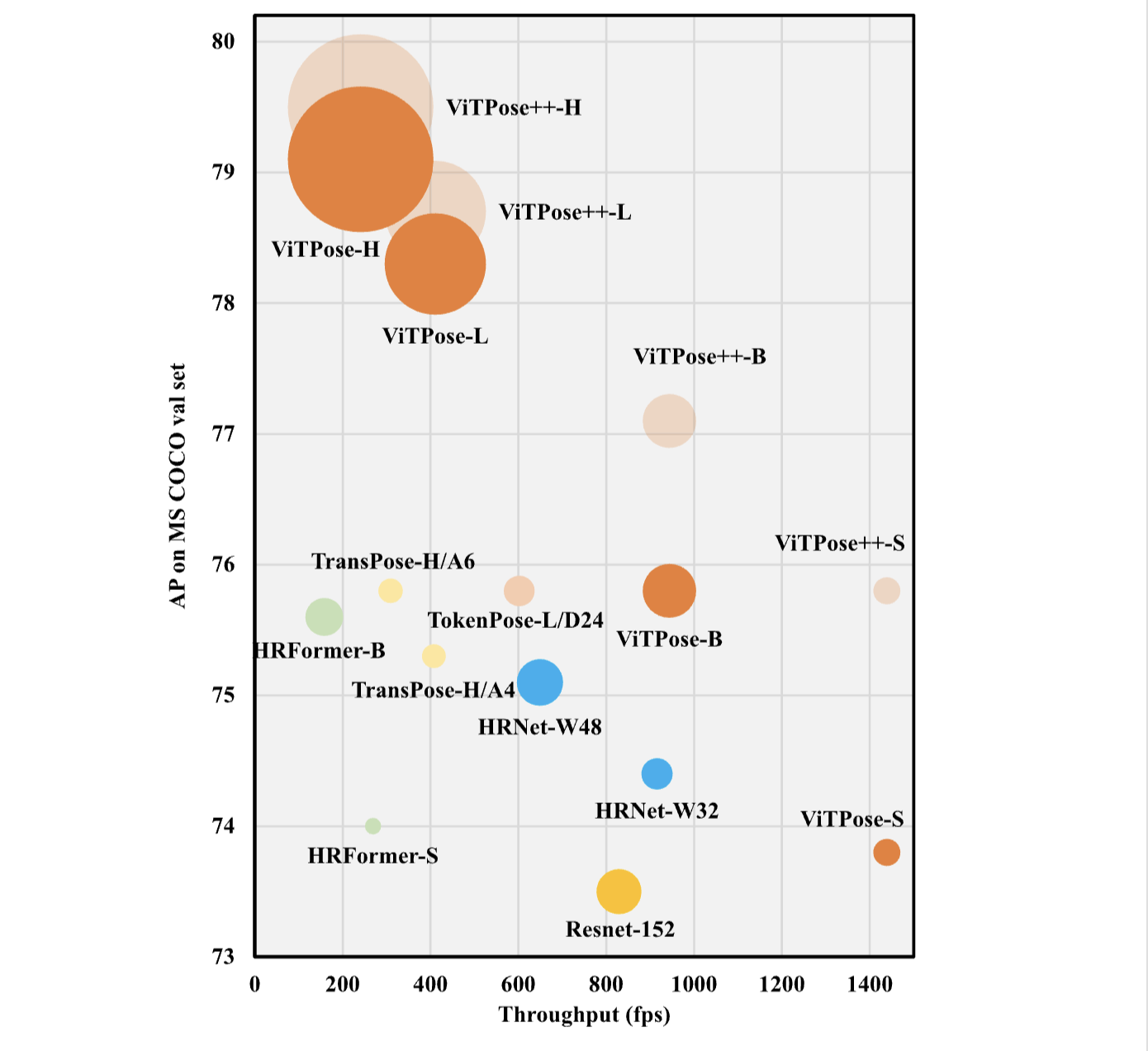

8.ViTPose: Simple Vision Transformer Baselines for Human Pose Estimation

이 논문에서는 ViTPose라는 간단한 베이스라인 모델을 통해서 다양한 측면(모델 구조의 단순함, 모델 크기의 확장성, 훈련 패러다임의 유연성, 모델 간 지식 전달 가능성)에서 자세 추정을

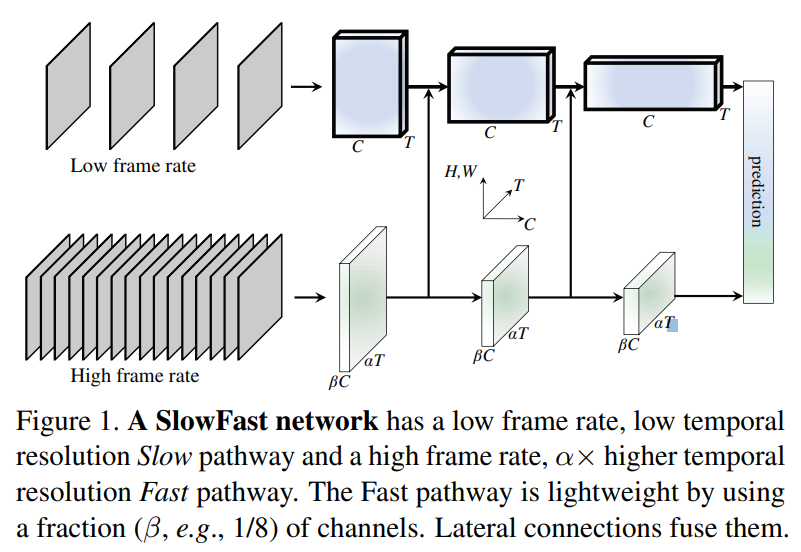

9.[paper] SlowFast Networks for Video Recognition

SlowFast Networks for Video Recognition 논문 리뷰

10.Linux server에서 Stable diffusion web-ui 설치하기

깃헙 설치 매뉴얼처럼 sudo 접근이 불가한 server에서 stable diffusion 설치하기

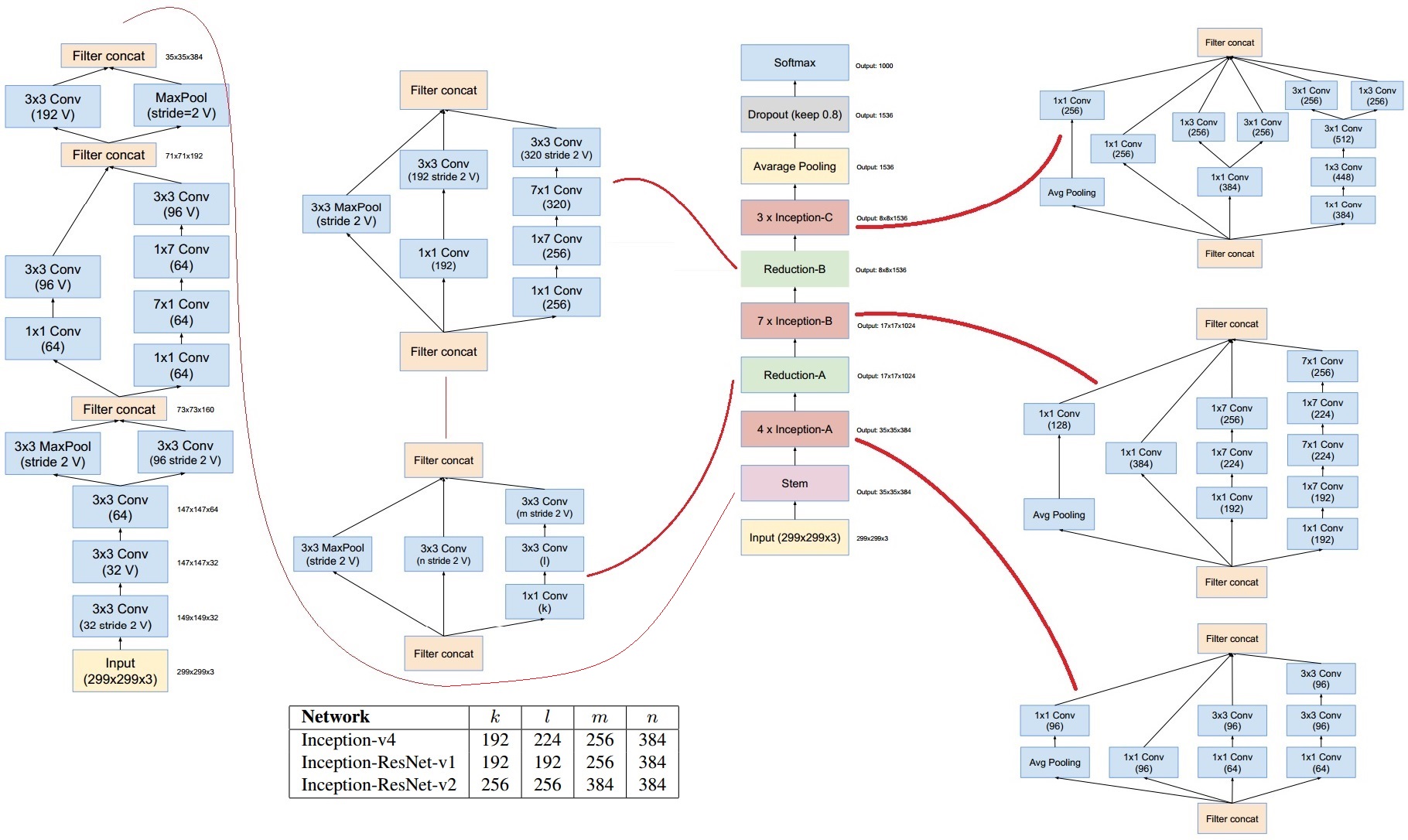

11.[paper] Inception v4 (2016)

Inception 아키텍처는 초기에 GoogLeNet으로 알려져 있었으며, 이후 Inception v2, Inception v3 등 다양한 버전이 발표되었습니다. Inception v4는 2016년에 소개되었으며, 그 이후로도 다양한 개선이 이루어진 것으로 알려져 있습

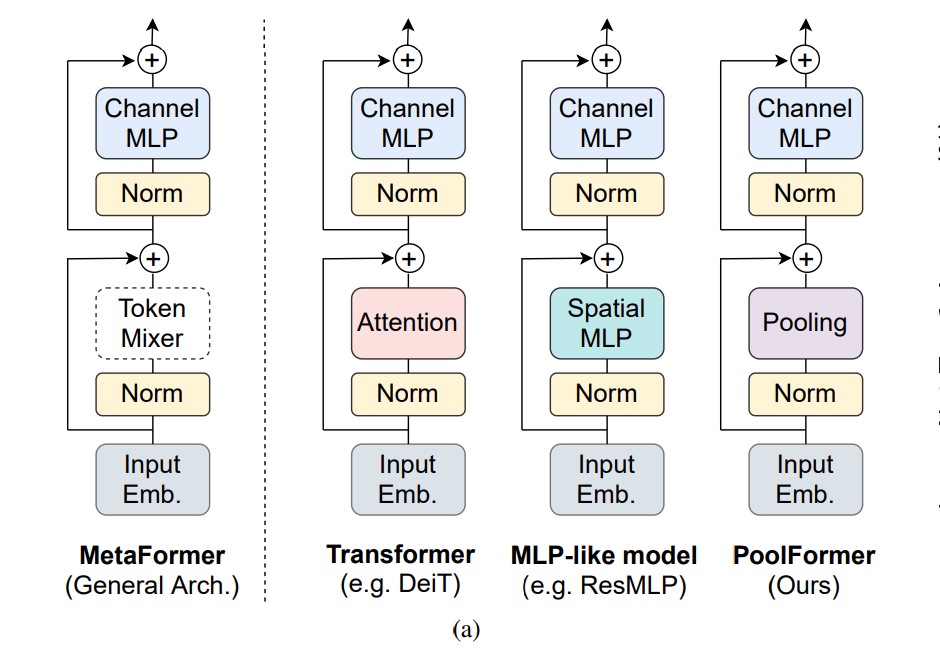

12.[paper] MetaFormer Is Actually What You Need for Vision

본 글에서는 CVPR에서 22년도에 발표된 MetaFormer is Actually What You Need for Vision, Yu et al.에 대해 간단하게 정리하겠습니다.논문에서는 일반화된 트랜스포머 아키텍처를 제안합니다.여기서 기존 트랜스포머 구조에서 Sel

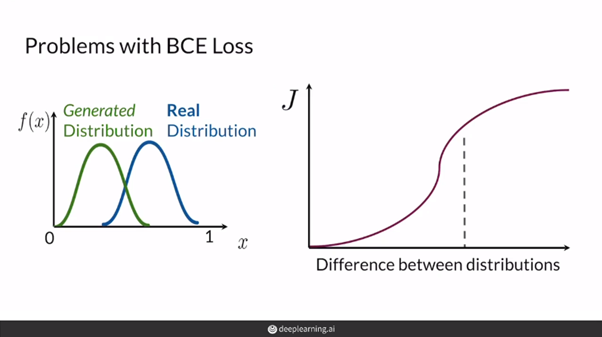

13.GAN Mode collapse, Wasserstein Loss, Weight Clipping, Gradient Penalty

generator가 discriminator가 못 맞추는 클래스를 파악해서 그 클래스만 계속 생성해서 discriminator가 전부 오분류하도록 하는것 즉 generator가 local minima에 갇힌 것이다. Problem with BCE lossGAN에서 bi

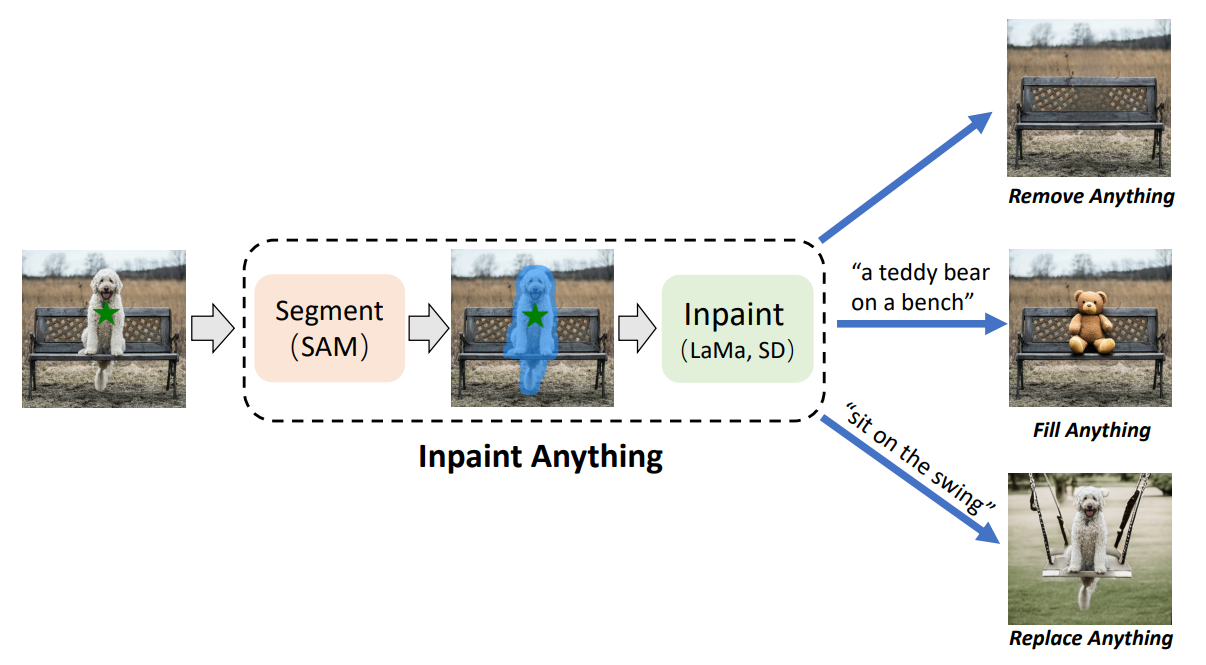

14.[paper] Inpaint Anything

Inpaint Anything 논문은 23년 4월에 발표되었습니다. 이 논문은 Segment Anything Model(SAM)을 기반으로 한 이미지 인페인팅 시스템을 소개합니다. 이 프레임워크는 다음과 같은 주요 기능을 제공합니다.Remove Anything: 사용자

15.ViTPose++: Vision Transformer for Generic Body Pose Estimation

Vision Transformer는 컴퓨터 비전 작업에서 큰 잠재력을 보여주었으며, human body pose estimation에 적용되어 우수한 성능을 얻었습니다. 기존의 ViTPose에서는 vision transformer를 pose estimation tas

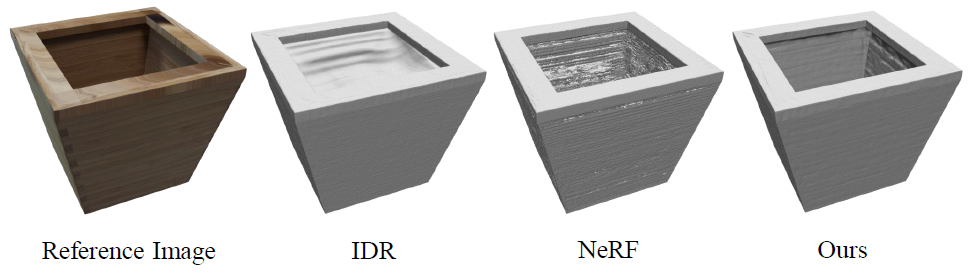

16.3D Object Generation 기술 동향, 모델 비교- Zero123, MVDream, SyncDreamer

연구원에서 세미나 열리는거 메일받고 듣고싶어서 실장님께 말씀드리고 다른 연구실 세미나 참석하기 KAIST 박병준 연구원님이 오셔서 3D 콘텐츠 생성 기술동향과 CVPR 2024에서 발표하신 논문을 소개해주셨다. 최근 multi view의 synthetic data 만

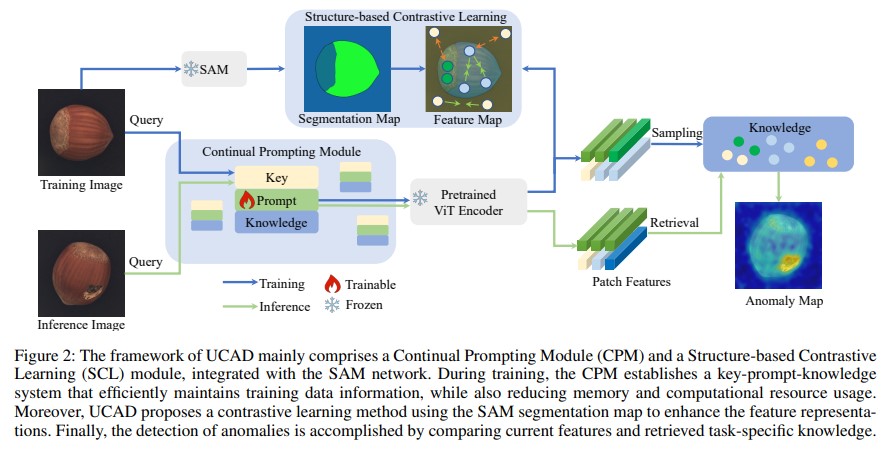

17.[paper] Unsupervised Continual Anomaly Detection with Contrastively-learned Prompt

catastrophic forgetting없이 하나의 모델에서 multi-object를 지속적으로 학습하고, task 간 transfer가 자유로운 anomaly detection 모델\*여기서 말하는 task는 다른 object category, anomaly det

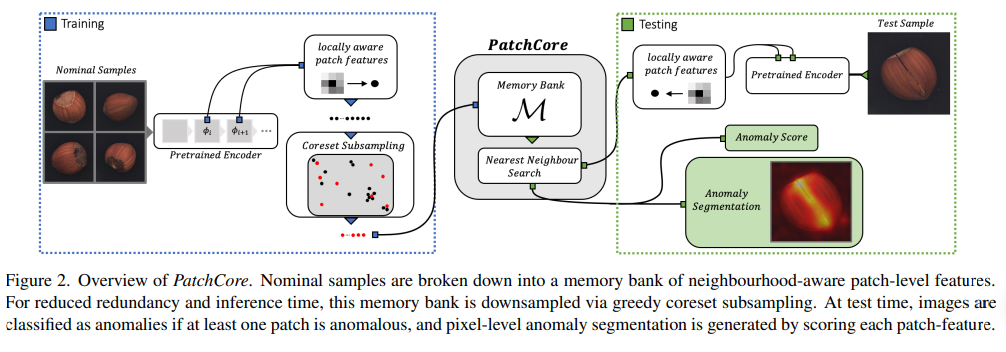

18.[paper] PatchCore: Towards Total Recall in Industrial Anomaly Detection

Towards Total Recall in Industrial Anomaly Detection (CVPR, 2022) locally-aware patch 비교 및 coreset subsampling을 통한 idustrial anomaly detection

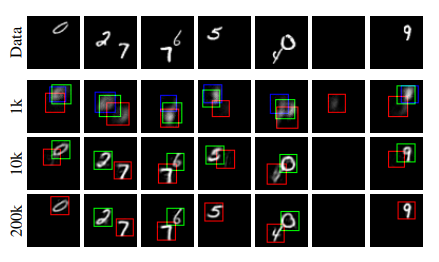

19.[paper] Attend, Infer, Repeat: Fast Scene Understanding with Generative Models

이번 논문은 2016년 발표된 논문으로 VAE에 RNN구조를 추가하여 구조화된 이미지 해석이 가능한 프레임워크를 제안하였습니다. 객체에 대해 명시적으로 추론하는 구조화된 이미지 모델에서 효율적인 추론을 위한 프레임워크 제시한다.한 scene의 요소들에 주목하고 장면을

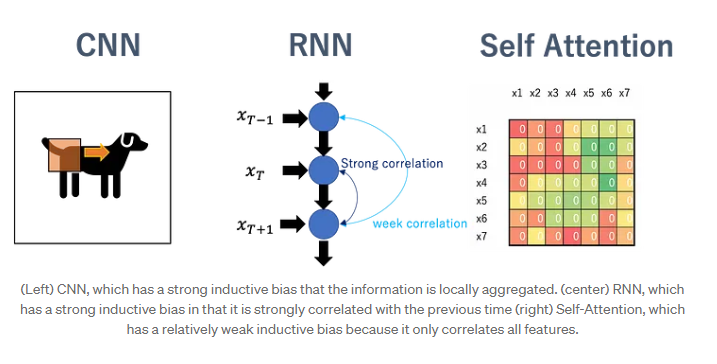

20.ViT의 Inductive Bias가 도대체 어떻다는 거야

ViTPose 정리하다가 ViTPose 살펴보고, 이미지 태스크에서 CNN 기반 모델과 ViT가 어떤 구조적 차이점이 있을까 살펴보다가 거슬러 여기까지 온 이야기 거슬러 온 순서 ··· 1) ViTPose: Simple Vision Transformer Baselin

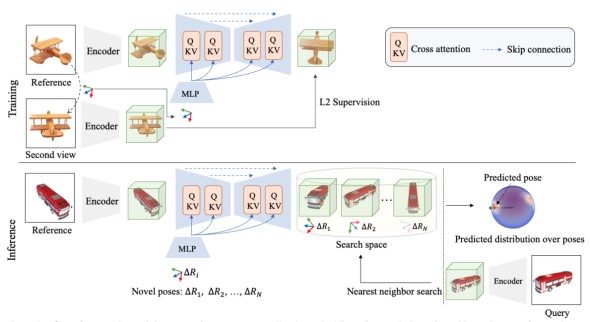

21.[paper] NOPE: Novel Object Pose Estimation from a Single Image

NOPE: Novel Object Pose Estimation from a Single Image은 arxiv 기준 23년 3월에 게재된 페이퍼입니다. 페이퍼 내용에 앞서 6D pose estimation task를 살펴보겠습니다. 먼저 최근 6D Pose esti

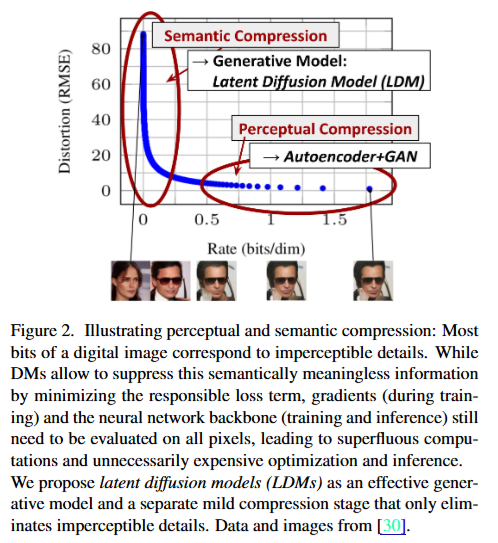

22.[paper] Stable diffusion

Stable Diffusion은 2022년 8월 Stability AI에서 발표한 text-to-image 생성 모델로, 오픈소스로 공개되어 인공지능 이미지 생성 분야에서 큰 주목을 받았는데요, 24년 12월 기준 1만 2천회가 넘는 인용수를 가지는 논문입니다. 최근

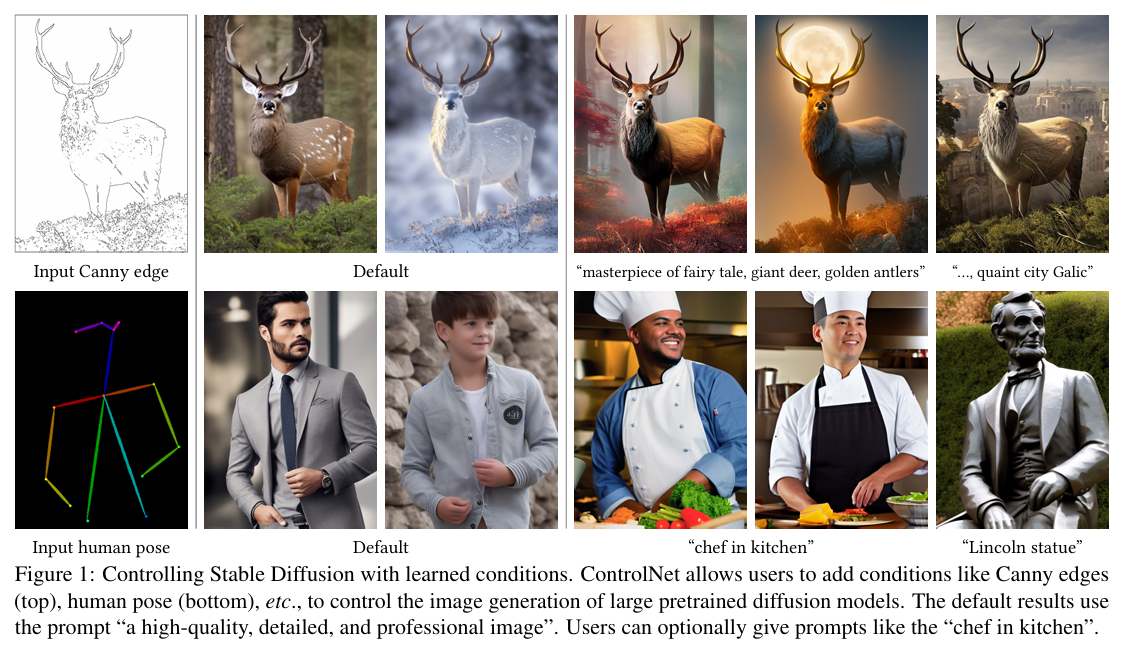

23.[paper] ControlNet, Adding Conditional Control to Text-to-Image Diffusion Models

ControlNet은 Stable Diffusion 모델에 조건을 추가하여 더 정밀한 이미지 생성을 가능하게 하는 신경망 아키텍처입니다. Stable Diffusion은 원래 텍스트 입력을 바탕으로 이미지를 생성하는 모델로, 입력된 텍스트에 따라 이미지를 생성할 수 있

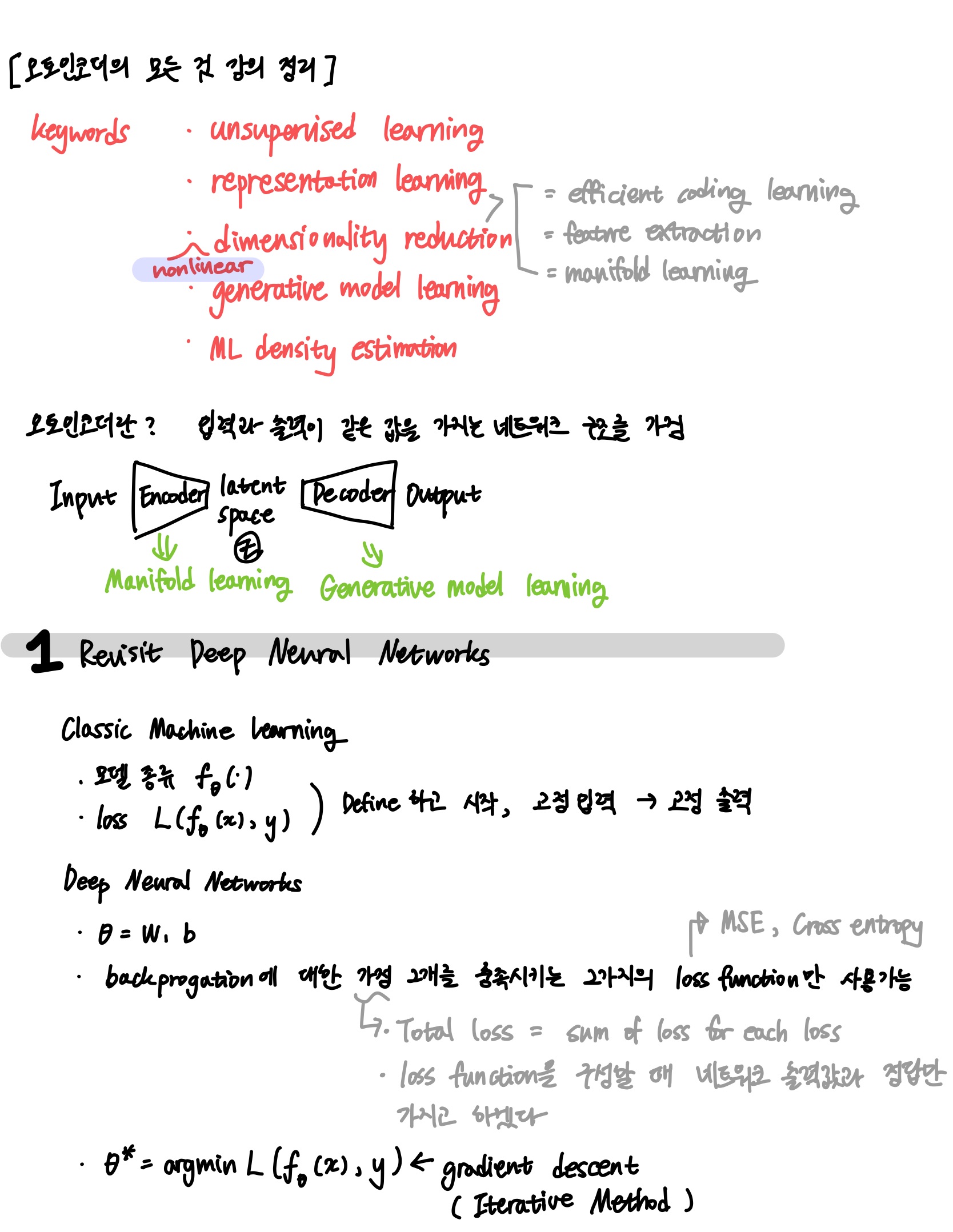

24.오토인코더의 모든 것 강의 정리

이활석 님의 '오토인코더의 모든 것' 유튜브 강의를 듣고 정리한 노트입니다.

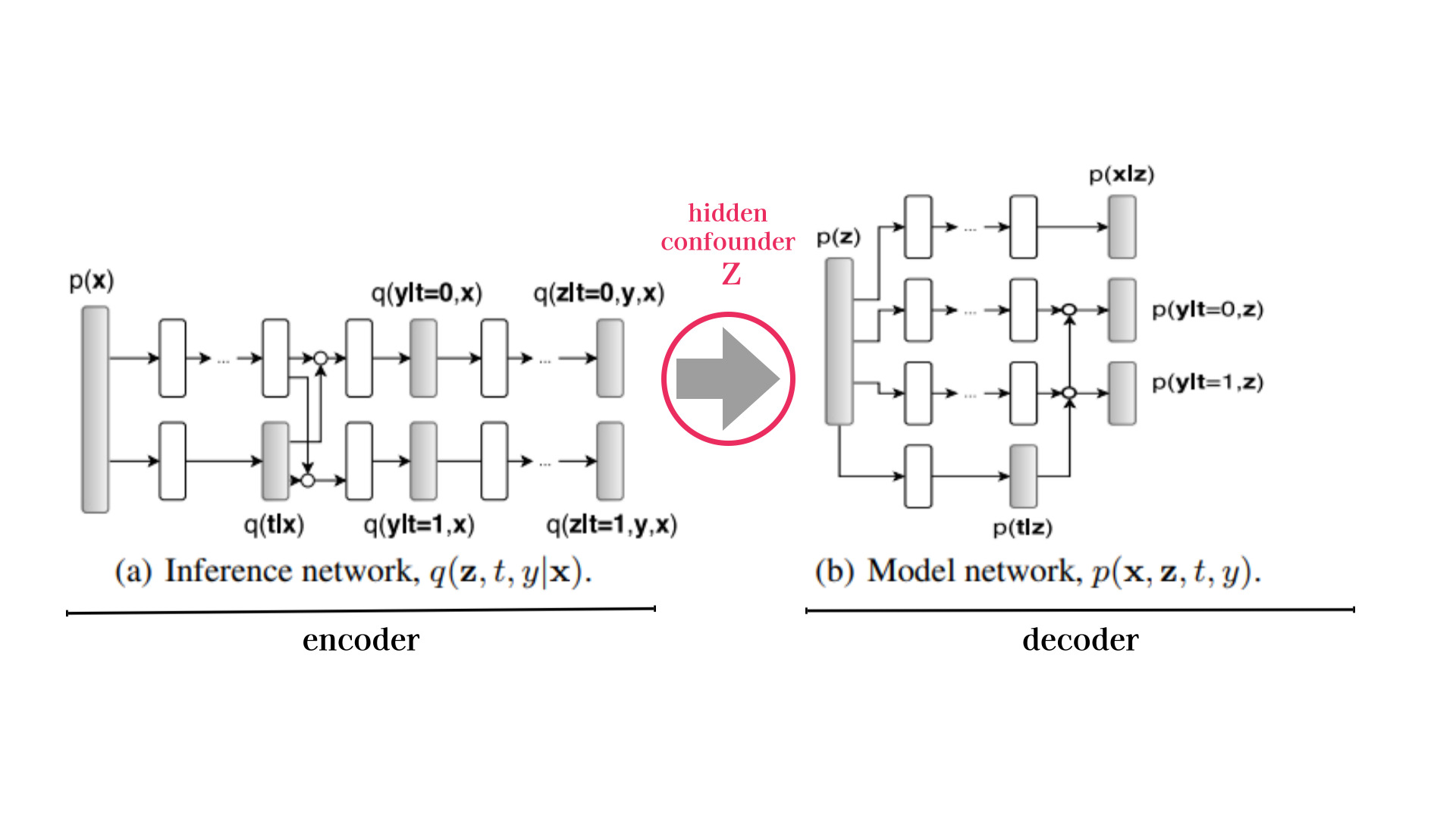

25.CEVAE / Causal Effect Inference with Deep Latent-Variable Models

"Causal Effect Inference with Deep Latent-Variable Models"은 2017년 NIPS (Neural Information Processing Systems) 컨퍼런스에서 발표된 논문입니다. 이 논문은 딥러닝과 잠재 변수 모델을