- 전체보기(32)

- ros2(4)

- ros1(1)

- RealSense(1)

- urdf(1)

- GAZEBO(1)

- mpu6050(1)

- sdf(1)

- turtlebot3(1)

- Jetson Nano(1)

- conda(1)

- ROS(1)

- d435i(1)

- ubuntu 20.04(1)

- md750t(1)

- ydlidar x4(1)

- intel realsense d435i(1)

NVIDIA Omniverse Basic Environment setup

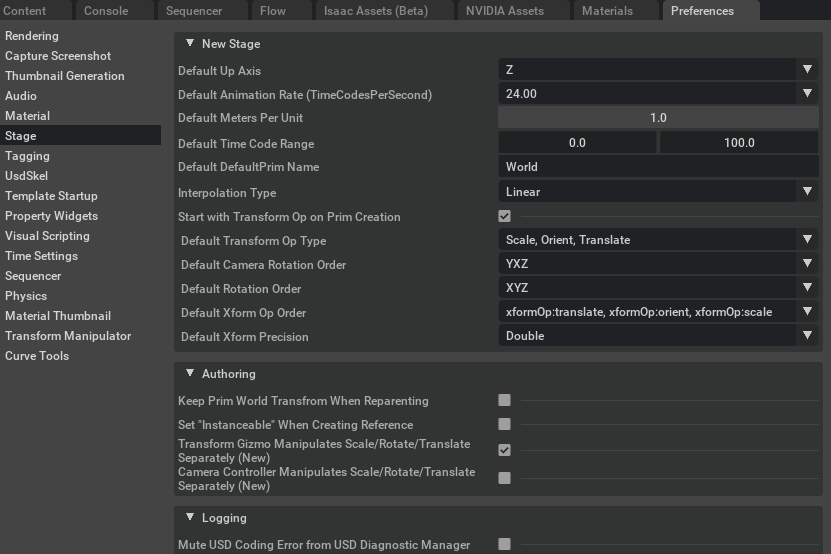

Setup global stage propertiesSetup global physics propertiesAdd ground planeAdd lightingEdit > Preference 에서 창을 키면 되겠다. 키면 다음과 같은 것들을 볼 수 있다. 기본적인 단위계

NVIDIA Omniverse basic interfaces

NVIDIA Omniverse를 다룰 때 다른 시뮬레이터와 다른 키를 사용하여 조종한다. 기본 마우스 조작 을 다음과 같이 알아보자.left clickright clickwheelwheel + movealt + left clickalt + right clickobjec

Install NVIDIA SDK Manager in Ubuntu 20.04

작년까지의 기억으로는 Ubuntu 20.04에는 SDK Manager를 설치 못하는 불편함이 있었던 걸로 기억하는데, 이제는 아닌 듯 하다. 하지만 참고를 위해서 다음과 같은 링크를 정리해두었다.https://gist.github.com/Lauszus/28f5

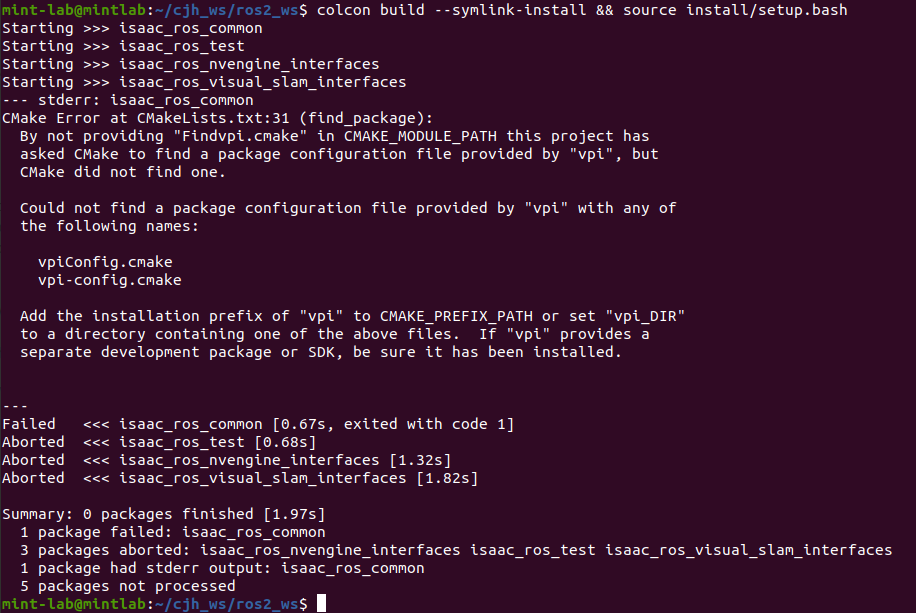

Install NVIDIA VPI for Elbrus SLAM

VPI란 NVIDIA에서 제공하는 라이브러리로 Vision Programming Interface를 의미한다. 마치 OpenCV를 대체하기 위해 만든 라이브러리 처럼 느껴진다... 특정 기능들은 nvidia jetson 시리즈에서만 사용이 가능하다. 1 PVA, VI

Nvidia Omniverse (Isaac SIM)

시뮬레이션이니까 world 위의 모든 object의 위치를 파악할 수 있다.말 그대로 일을 주는 것이다. 로봇팔이라면 pick&place가 될 것이고, 주행로봇이면 A2B의 일을 하는 것이다. 이러한 명령들이 모여모여 하나의 시스템이 될 터이니, 가장 간단한 Task를

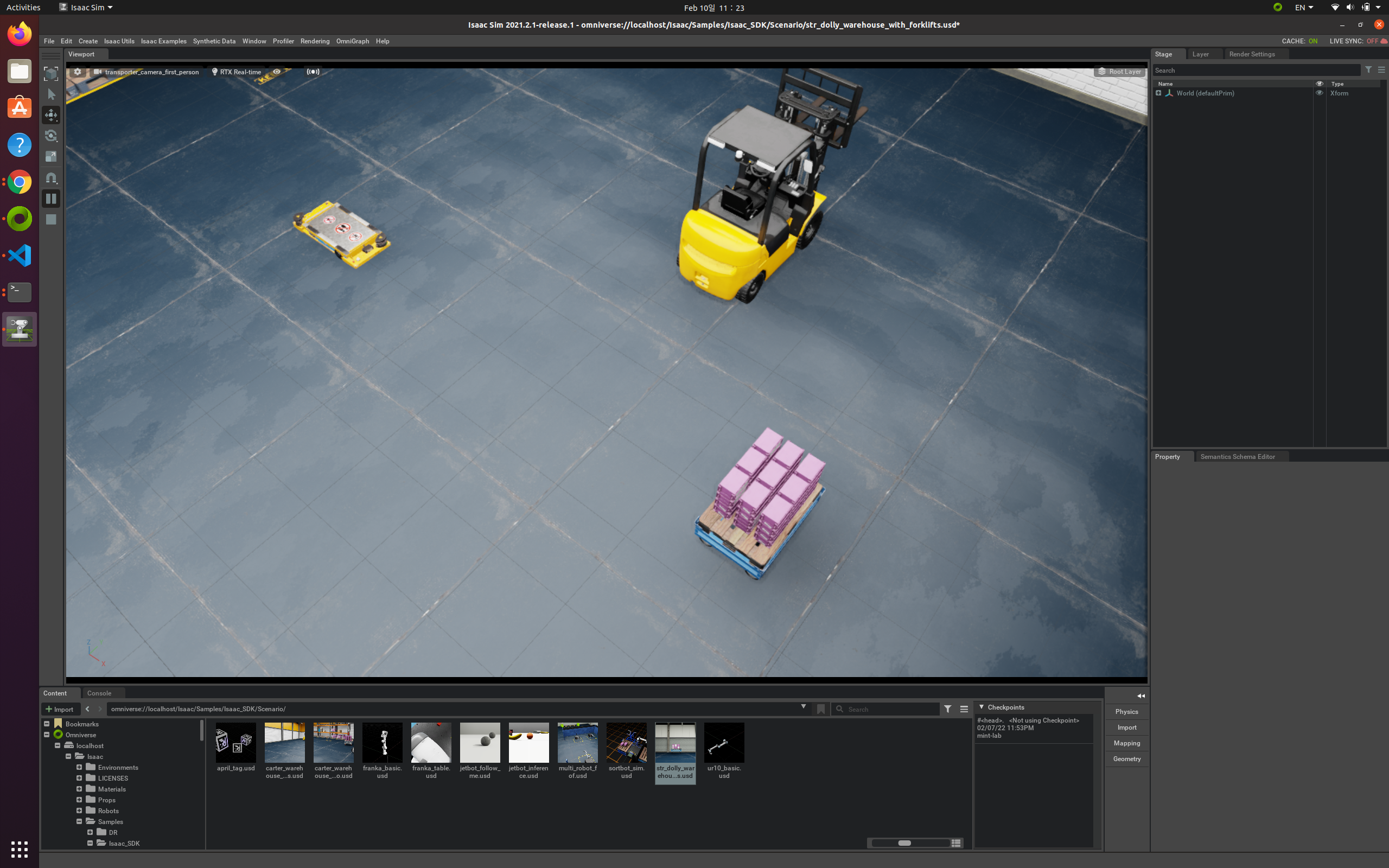

Nvidia Omniverse (Isaac SDK + SIM)

omniverse isaac sim과 isaac sdk를 연결해서 진행해보려고 한다.튜토리얼을 살펴보자.도커에서 다음과 같이 치자또한 omniverse에서 omni:/Isaac/Samples/Isaac_SDK/Scenario/str_dolly_warehouse_with

Nvidia Omniverse (Isaac SDK)

Prerequisites (os 버전 제외하고는 완전 필수는 아닌듯)RecommendationMinesdk downloadhttps://developer.nvidia.com/isaac-sdkDesktopRobotdependencies를 재밌게도 host pc에

SLAM and DL Paper Lists

Cartographer - Real-time SLAM in 2D and 3D across multiple platforms and sensor configurations \[github cartographer]FAST-LIO - efficient and robust

NVIDIA Omniverse 시작 - 00

최근 sim2real 기법으로 딥러닝의 부족한 데이터를 채우는 모습을 확인할 수 있다. 나 또한 이러한 기법에 깊게 감명받아 3d design과 simulation을 공부하려고 한다. 먼저 3d design 툴은 어떤 것들이 있을까? Autodesk 사의 제품들이 우

ROS1, ROS2, Conda 같이 쓰기

http://wiki.ros.org/noetic/Installation/Ubuntuhttps://docs.ros.org/en/foxy/Installation.htmlhttps://www.anaconda.com/products/individua

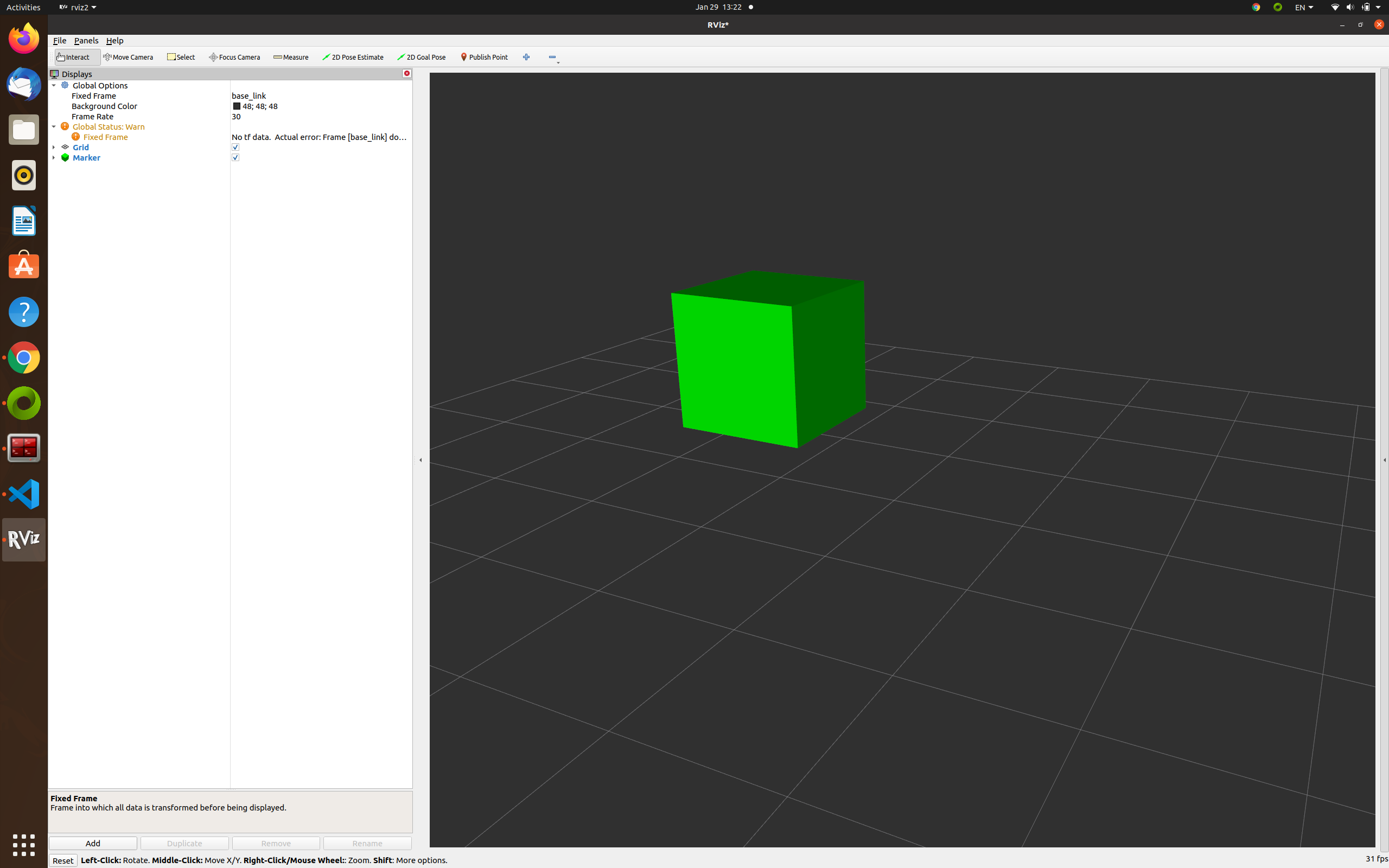

ROS2 RVIZ Marker

rviz2에서 마커를 본 경우가 많을 것이다. 나중에 사람이나 다른 객체의 이동 데이터를 얻으면 마커를 옮기는 방식으로 표현하고 싶어서 마커를 표시하는 방법을 찾아봤다. 메시지는 다음과 같다.위 메시지를 이용해서 데이터를 pub 하면 된다. ros wiki에서 위 메시

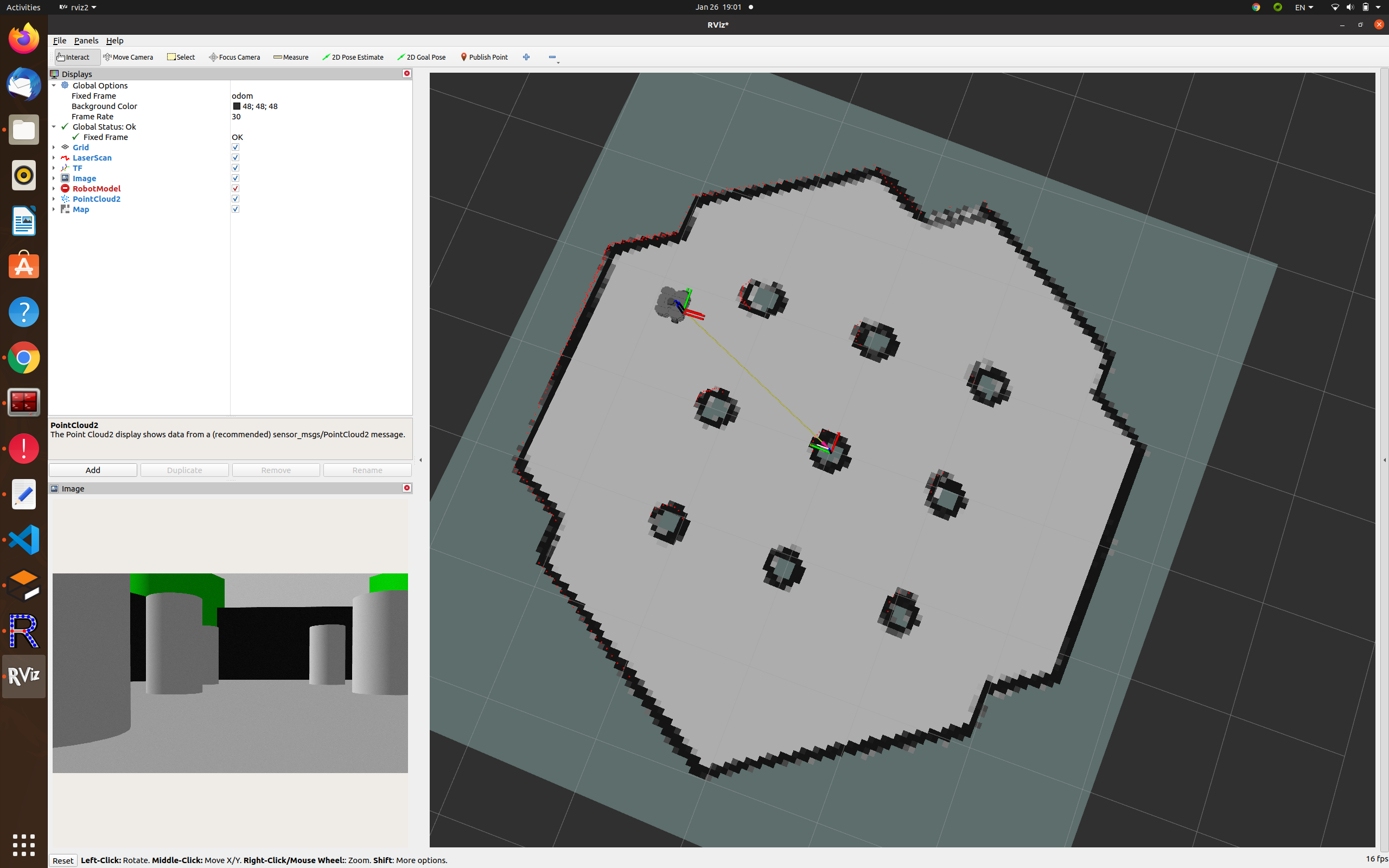

ROS2 Gazebo

목차 1. WareHouse 제작 2. Turtlebot3 불러오기 3. RVIZ에서 내용 보기. 4. Intel Realsense Gazebo Plugin 사용 5. Lidar SLAM 해보기 1. WareHouse 제작 (1) 링크의

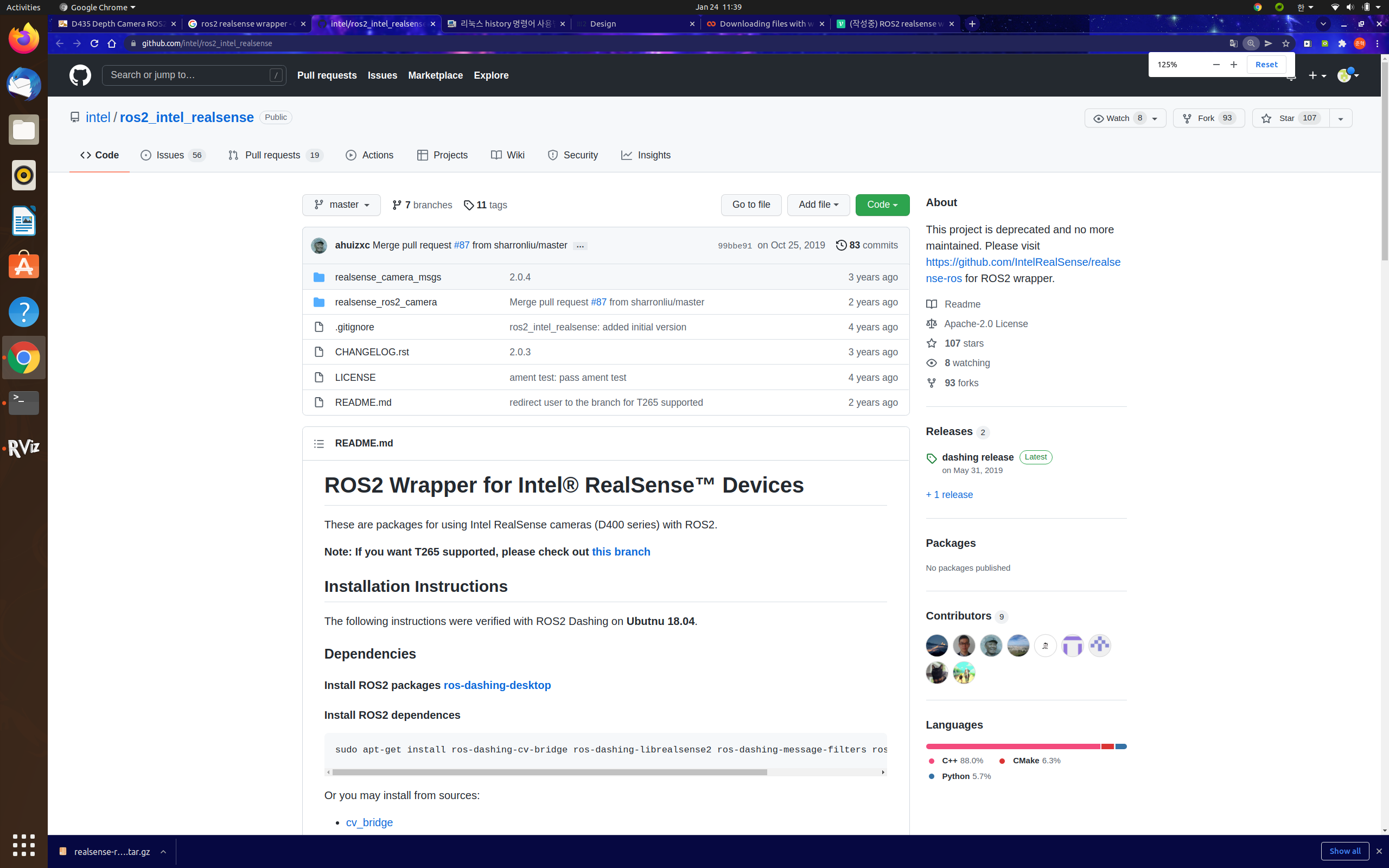

ROS2 realsense

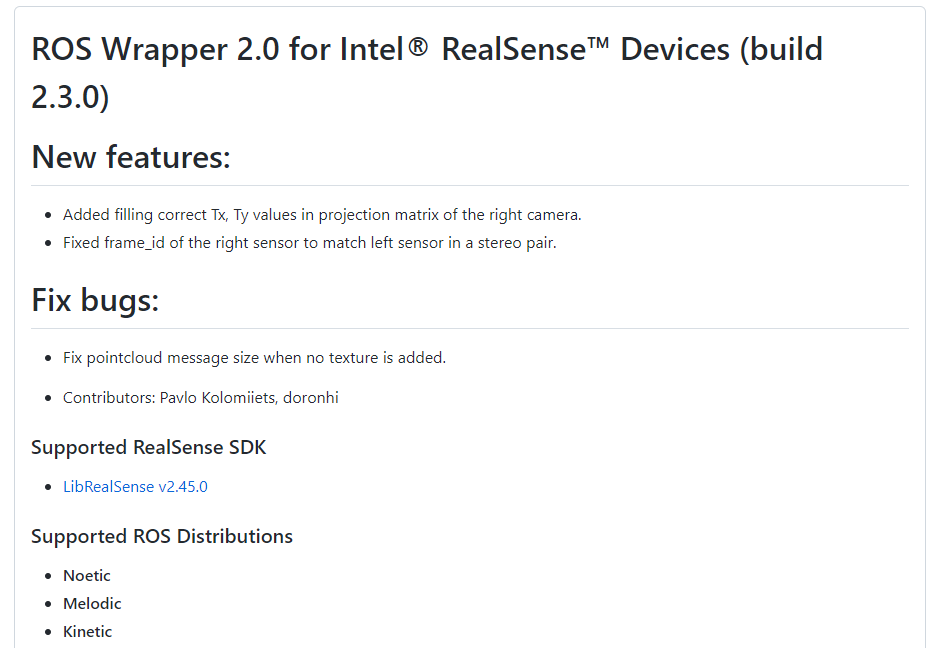

ros2의 realsense wrapper를 다운로드 받아야 한다. 먼저 본인이 현재 쓰고 있는 realsense sdk의 버전을 모른다면 필히 알아보도록 하자. 모른다면 realsense-viewer를 키면 되겠다.검색을 해보니 다음과 같은 링크가 나온다.https&

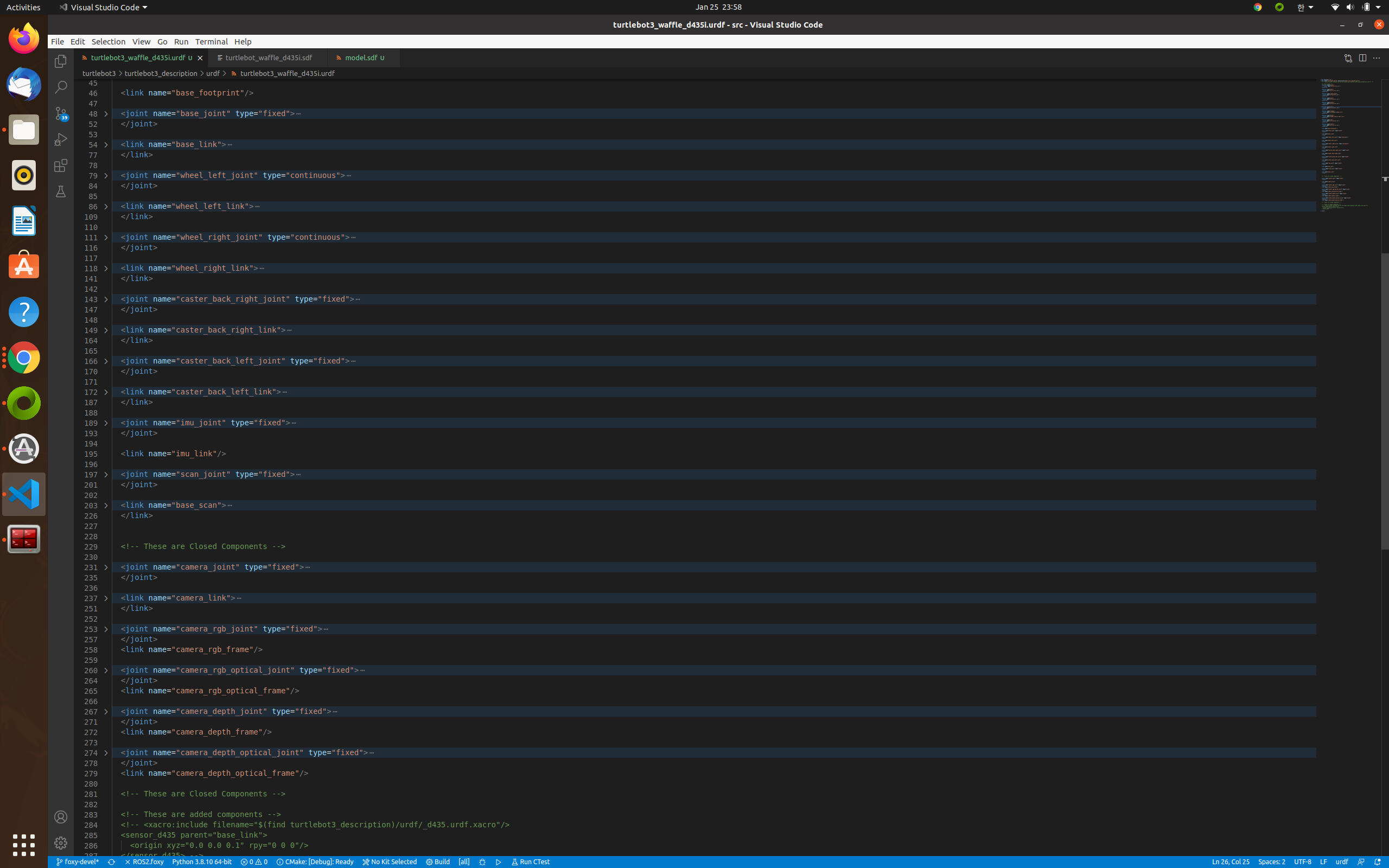

ROS URDF to SDF

Unified Robot Description Format으로 ROS1에서 자주 사용하던 형식이다.Simulation Description Format으로 urdf와 조금 다른 형식을 취한다.xml urdf to pure urdfpure urdf to sdfrefhtt

3. Hanwhabot 만들기

한화봇은 다음과 같이 구성되어 있다. sensor - Intel realsense d435i, YDlidar X4, mpu6050actuator - MD750TMCU - arduino megaboard - Jetson nano내부 코드는 철저히 터틀봇을 모방했다. 아무

2. VSLAM 테스트

VSLAM 테스트는 총 세가지 ORB_SLAM2, OpenVSLAM, RTABMAP을 진행하였다. 관련 영상 링크는 아래에 있다.https://youtu.be/WZDmh8JAfcU위 같은 내용을 진행하기 위해 필요한 세팅에 대해 알아보자.original ORB

1. 저가 카메라에서 고가카메라 기능 구현

WaveShare사의 저가 카메라 IMX219-83 stereo 카메라 모듈을 이용하여 고가 카메라의 기능 중 depth estimation 기능을 구현하려 했다. 비록 성공적이진 못했지만, 이곳에서 제공하는 코드를 분석해보고, 차후에 더 개발해보자. 1. stere

md

ROS cpp class example

class_example_v1.hclass_example_v1.cppcpp_class_v2.cpprefhttps://github.com/wsnewman/ros_class/tree/master/example_ros_class/srchttp://wiki.