- 전체보기(11)

- DeepLearning(4)

- 알고리즘(4)

- transformer(3)

- Object Detection(3)

- ps(2)

- PyTorch(2)

- 백준(2)

- R-CNN(1)

- neural(1)

- 벨만포드(1)

- CNN(1)

- NeRF(1)

- torch(1)

- 시점 합성(1)

- CartPole(1)

- tensorflow(1)

- dqn(1)

- YOLO(1)

- VISION(1)

- mlp(1)

- boj(1)

- you look only once(1)

- 강화학습(1)

- 컴퓨터비전(1)

- Deep Learning(1)

- Computer Vision(1)

[Paper] DETR : End-to-End Object Detection with Transformers

Object Detection 문제를 Direct Set Prediction Problem으로 접근 → detection pipeline을 이전보다 간소화세부적으로는 NMS (Non-Maximum Suppression)이나 Anchor Generation과 같은 han

[백준] 1865 웜홀 : 문제의 논란 정리

주의 : 해당 문제 질문 게시판의 풀이 및 논란 완전 정리합니다. 라는 글에 대한 보충 설명을 스스로 이해할 수 있도록 정리한 글입니다.이 문제에서 핵심 의문은 다음 2가지였다.시작 정점이 어디인가?연결 그래프 여부가 왜 표시되어 있지 않은가?결론적으로 말하면 다음과

[알고리즘] 트리의 지름 증명

링크의 글을 보충 설명한 글입니다.트리에서 지름이란, 가장 먼 두 정점 사이의 거리 혹은 가장 먼 두 정점을 연결하는 경로를 의미한다. 선형 시간안에 트리에서 지름을 구하는 방법은 다음과 같다:트리에서 임의의 정점 x를 잡는다.정점 x에서 가장 먼 정점 y를 찾는다.정

[백준] 2206 : 벽 부수고 이동하기

벽을 한번 뚫고 온 상태를 depth 1, 벽을 뚫고 오지 않은 상태를 depth 0라고 정의합니다.(0,0) → (N-1, M-1) 경로라고 생각합니다.같은 정점을 서로 다른 depth로 방문할 수 있다. 그러므로 방문 체크가 '독립적으로' 진행되어야 한다다음과 같은

코딩 테스트 대비 정리

vector : 배열(array)와 비슷하게 사용가능map파이썬의 Dictionary와 비슷함unordered_mapmap에서 정렬이 되어 있지 않은 버전 -> 더 빠르다setunique한 원소들을 정렬된 상태로 보관DFS, BFSDFS : stack or 반복문BFS

[번역]NeRF : Representing Scenes as Neural Radiance Fields for View Synthesis

NeRF 논문을 (제맘대로) 한국어 번역한 글입니다. 직역 수준이라 가독성이 별로 좋지 않습니다.

[PyTorch] Transformer 구현

작년부터 Transformer가 성능이 그렇게 좋다더라... 이제 RNN이고 LSTM이고 다 필요없고 이미 NLP는 저걸로 천하통일이라더라... 하는 소식을 듣고 있었다. 중간에 강화학습 공부 좀 찍먹해보다가 다시 캐글에서 PetFinder 이미지 비전 태스크 공부로

Transformer를 구현하며 배운 것들

named_parameters() 함수는 (param_name, param_weight) 형태의 튜플을 반환한다.Xavier Uniform Initilization을 이용하고자 한다면 다음과 같이 조건식을 추가하여 초기화하면 된다. (bias와 nn.layerNorm(

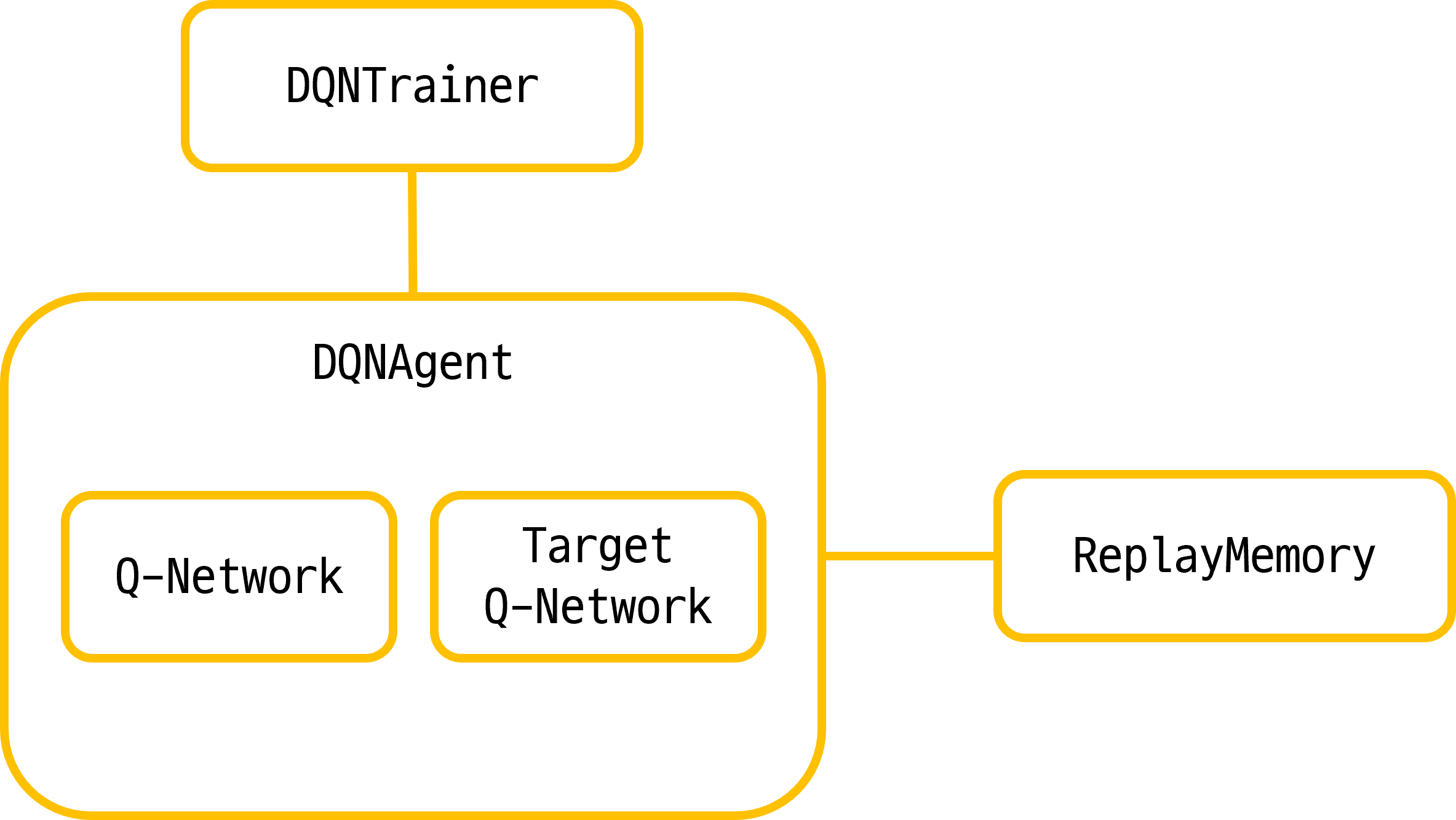

[강화학습] Tensorflow를 이용한 DQN 구현 (cartpole_v0)

Kaggle에서 도대체 내가 참여할만한 competition이 무엇이 있을까 하고 찾아보던 중 Lux AI Challenge라는 competition을 발견하게 되었었다. 강화학습과 주어진 파이썬 API를 이용해 참여해야 했는데, 이 당시(8월 말)의 나는 강화학습에