Deep learning Specialization 복습

1.MSE, MLE관점

우리는 종종 Loss함수를 minimize하는 과정이 MLE(Maximum likelihood estimation)와 연관있다는 이야기를 듣곤한다.이것 역시 시간이 지나면 많이 까먹게 되는 개념인 것 같아 오늘은 MSE와 Cross entropy loss가 어떻게 ML

2.Activation function

Coursera의 앤드류 응의 교수님의 말씀을 토대로한 포스트입니다.앤드류 교수님은 먼저 자신은 binary classification 문제의 output layer를 제외하고서는 sigmoid를 절대로 쓰지 않는다고 하셨다.아마 tanh함수가 gradient vani

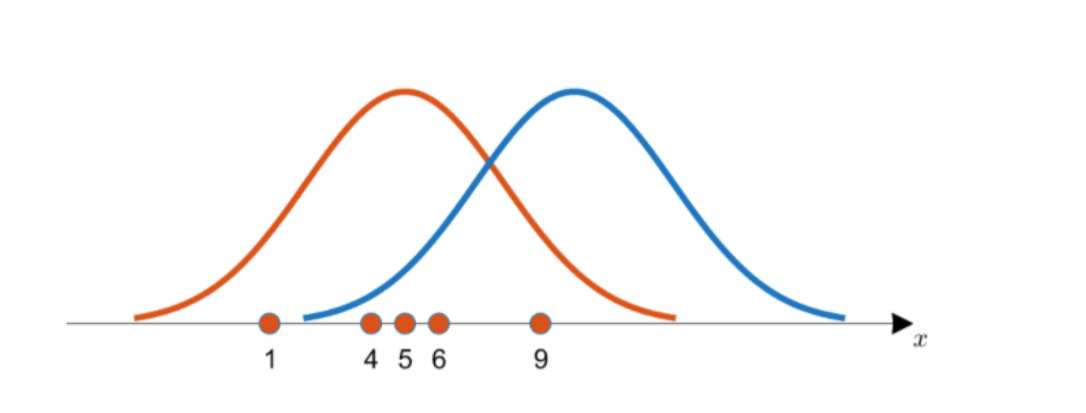

3.Bias and Variance

안녕하세요 오늘은 머신러닝에서의 bias와 variance에 대해서 포스트 해보도록 하겠습니다.먼저 Supervised learning의 개념에 대해서 이야기해보죠. 지도학습은 모델에게 정답을 알려주고 이를 잘 맞출 수 있도록 모델을 training 시키는 것이 목표입

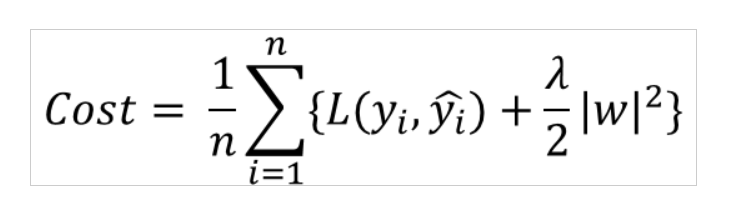

4.Regularization

오늘은 Overfitting을 방지하는 여러 regularization 기법들을에 대해 포스팅하려 합니다.먼저 cost function뒤에 l2 norm을 더해주는 방법이 있습니다.위의 그림과 같이 기존의 Loss function에 lambda/2\*(모든 가중치들의

5.Optimization (1)

Weight를 학습하는 과정에서 우리는 종종 어떠한 경사하강법을 이용해야 할지 결정해야 할 순간들이 온다. 실제 모델을 구현할땐 그냥 adam(W)을 쓰긴하지만...강의를 듣다 개념들이 조금은 헷갈려서 정리해 보려고 한다.대표적인 경사하강법 두개에 대해서 짚고 넘어가

6.Optimization(2)

안녕하세요, Optimization 두번째 파트입니다.😊1편에 다뤘던 것들과 다른 여러가지 최적화 방법에 대해서 알아보기전에 알고 가셔야할 개념이 있습니다.바로 지수 가중 평균이라는 개념인데요.산식은 아래와 같습니다.Vt는 현재 추정치 Vt-1는 이전시점에서의 추정치

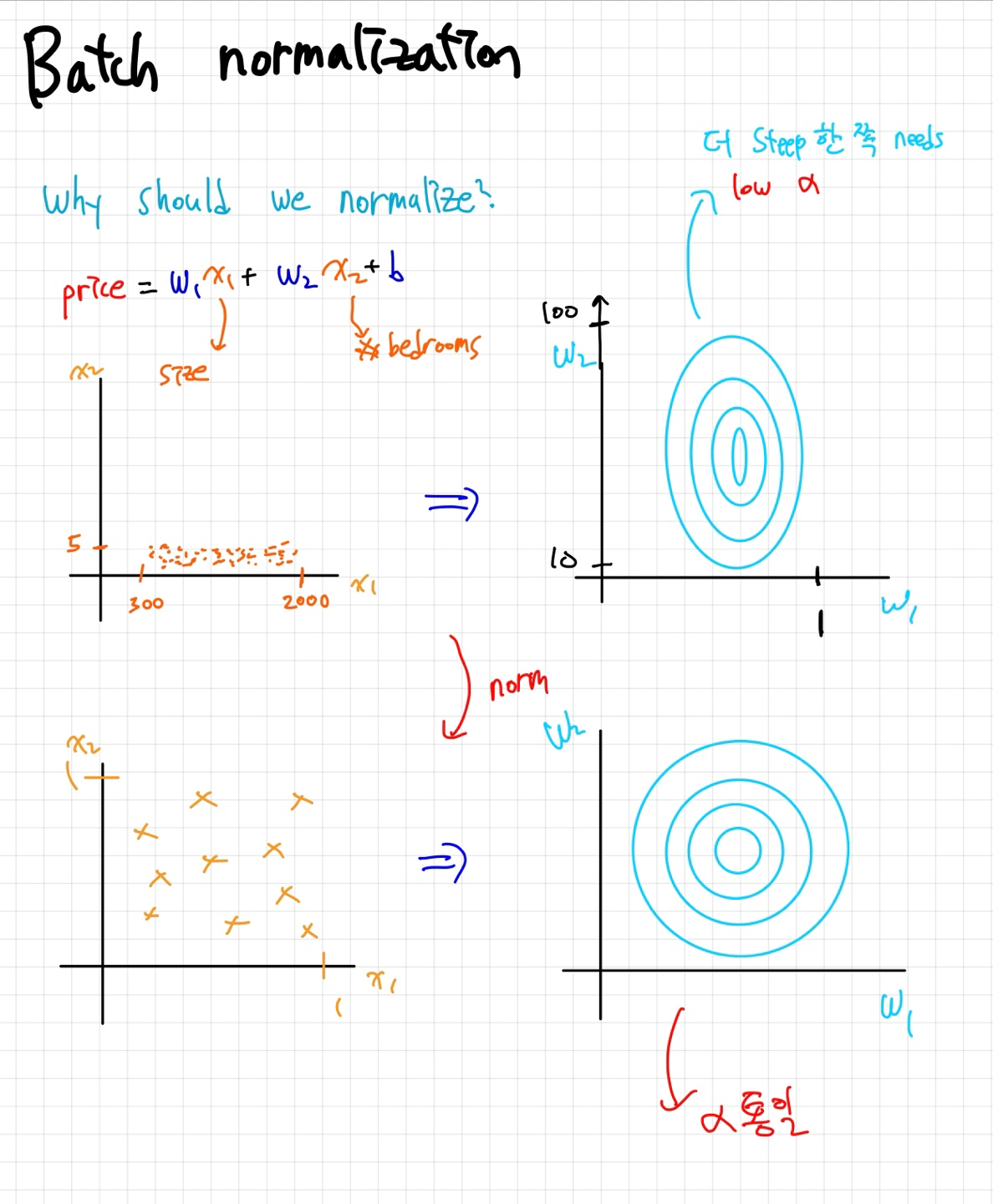

7.Hyperparameter / Batch Normalization

이번 포스트에서는 저희의 인공신경망을 더 강건하게 만들어주는 여러가지 방법들을 알아보겠습니다. Hyperparameter tuning 하이퍼 파라미터는 모델의 학습에 있어서 아주 중요한 역할들을 합니다. 앤드류 교수님께서는 빨강-파랑-보라-초록색순으로 중요하다고 말씀

8.ML Strategy

우리가 모델을 구현하고 학습하는 과정에서 다양한 문제에 직면합니다. 모델의 성능을 끌어올리기 위해 우리는 다양한 adjustment들을 고려해볼 수 있는데요. 위의 그림은 각 단계에서 성능이 안나올때 적용 할 수 있는 방법들을 적어둔 것 입니다. 밑줄 친 cost

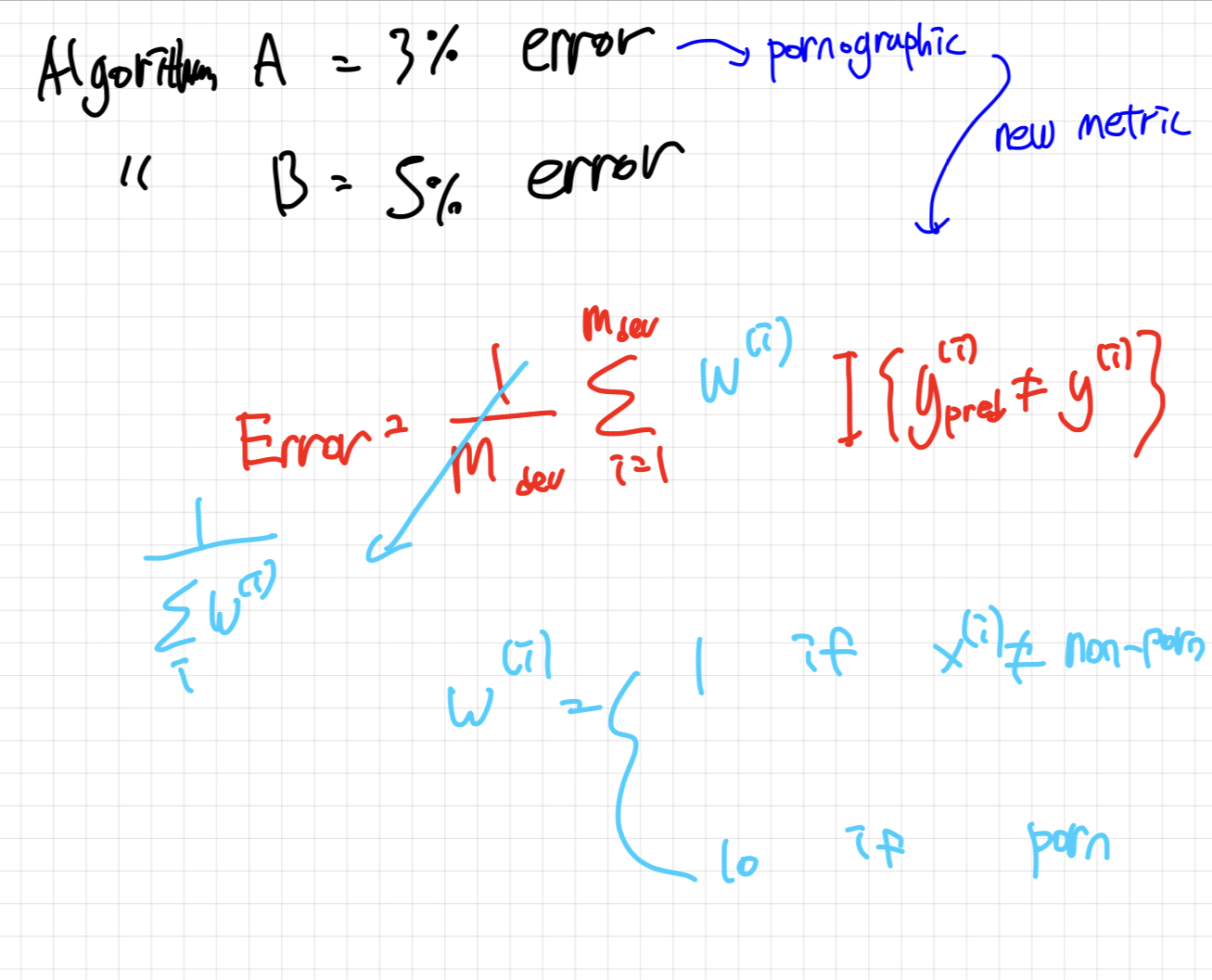

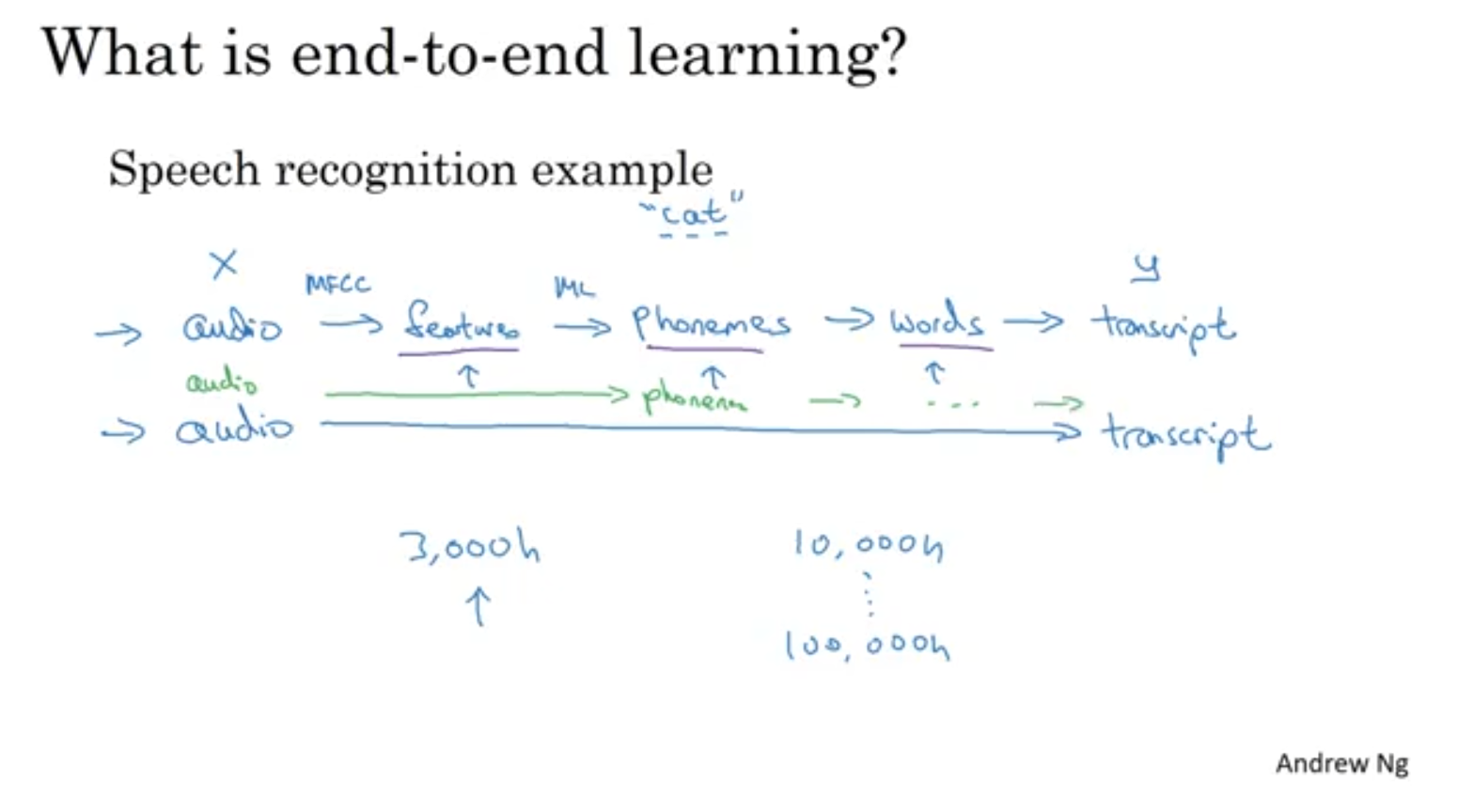

9.ML Strategy (2)

만약 저희의 모델이 Human-performance를 이뤄내지 못할 땐 어떻게 해야할까요? Error anaylsis Cat detection을 위한 classifier 모델을 학습시켰는데 10%의 확률로 에러가 나는 상황을 생각해봅시다. 개를 보고 고양이라 하는 것

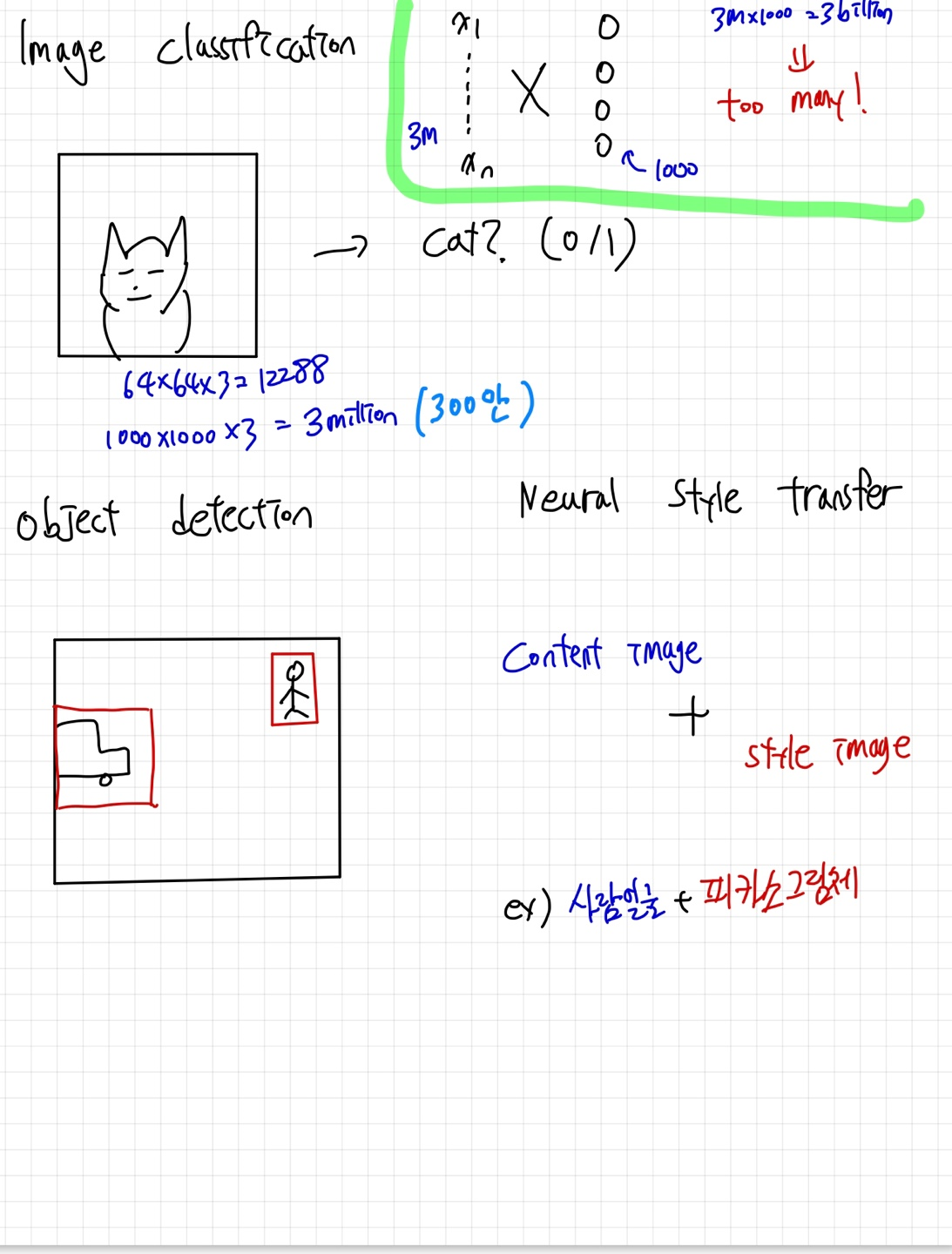

10.CNN-(1)

현재 Computer Vision분야에서 딥러닝을 활발히 활용하고 있습니다.image 데이터를 다룰때의 가장 큰 문제점은 학습 파라미터가 너무 많아진다는 점인데요. 이를 해결하기 위해 Convolutional Neural Network라는 개념이 도입 되었습니다.위의

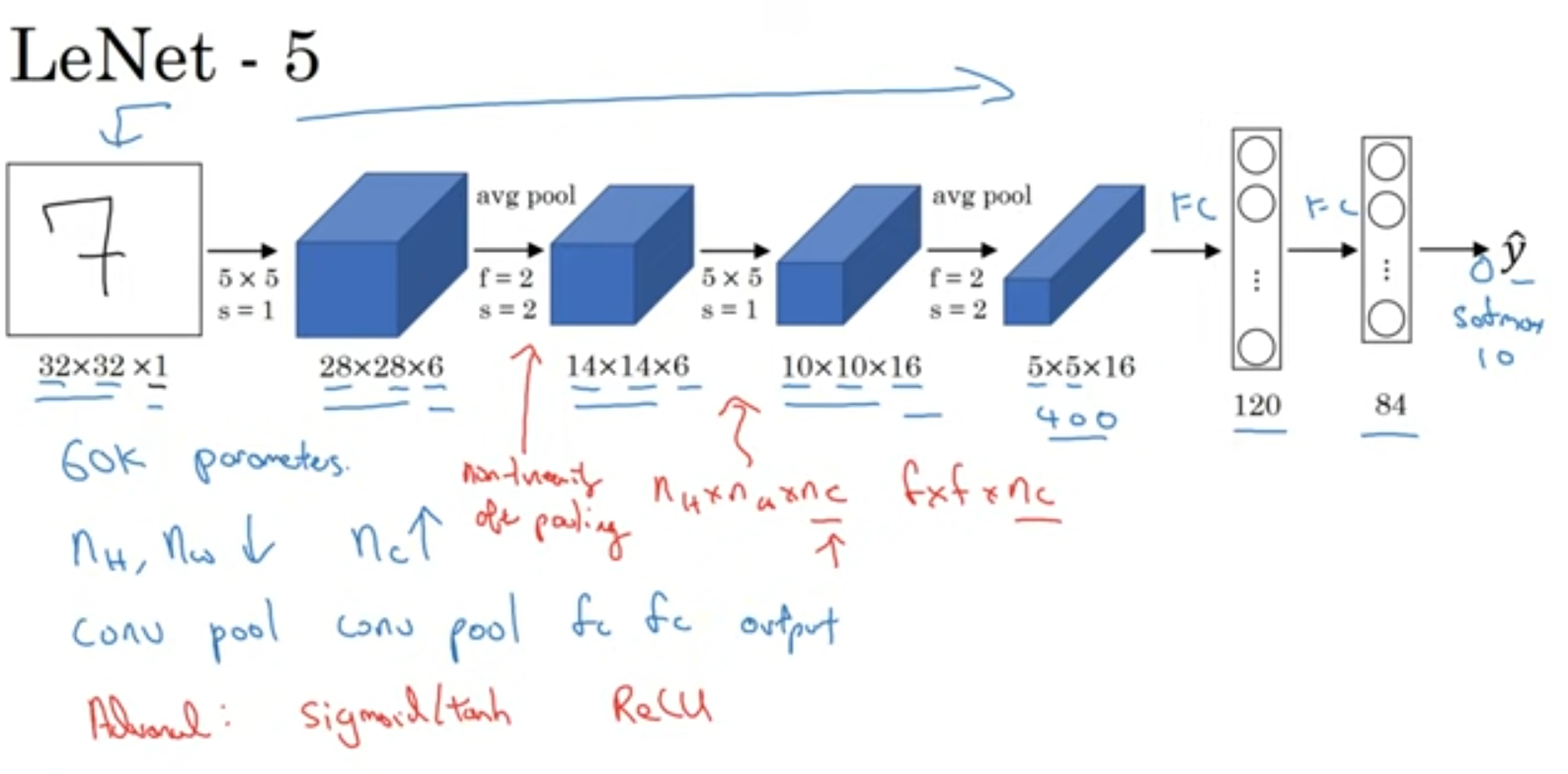

11.CNN -(2)

여러 Imagnet task에서 우수한 성적을 보인 모델들에 대해서 간략하게 짚고 넘어가봅시다!이 당시에는 ReLu가 없어서 sigmoid와 tanh를 이용해서 비선형성을 추가했습니다.Lenet보다 규모가 커졌지만 구조는 비슷합니다.ReLu함수가 등장했죠.당시에는 GP

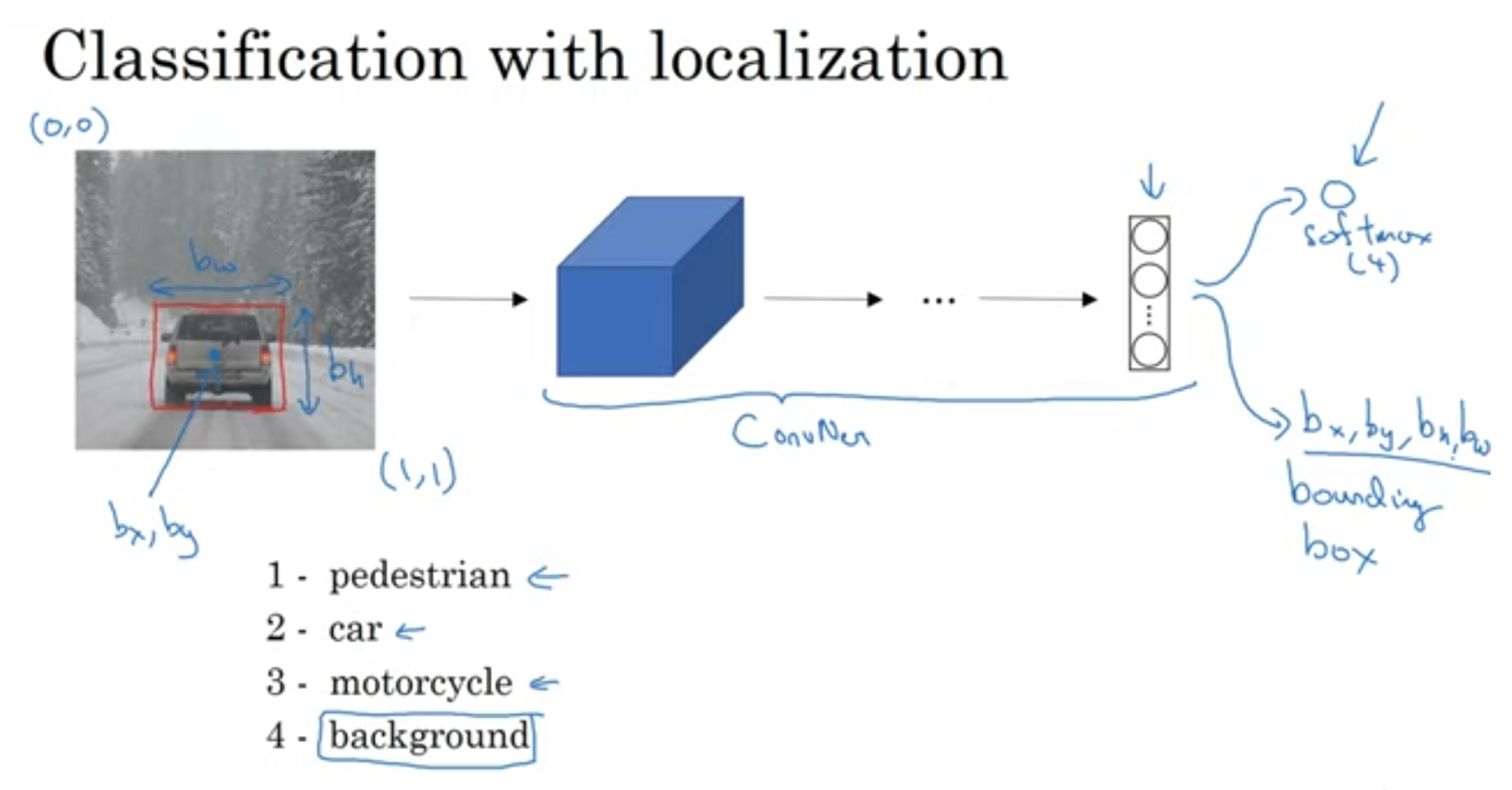

12.Object Detection

bounding box도 출력해주는 것을 볼 수 있습니다. 총 8개의 output이겠네요."랜드마크(landmark)"란 이미지 내에 존재하는 중요한 특징적인 지점들을 의미합니다. 랜드마크를 label로 주어서 학습시킬 수도 있겠죠.슬라이딩 윈도우 기법에 대해서 알아봅

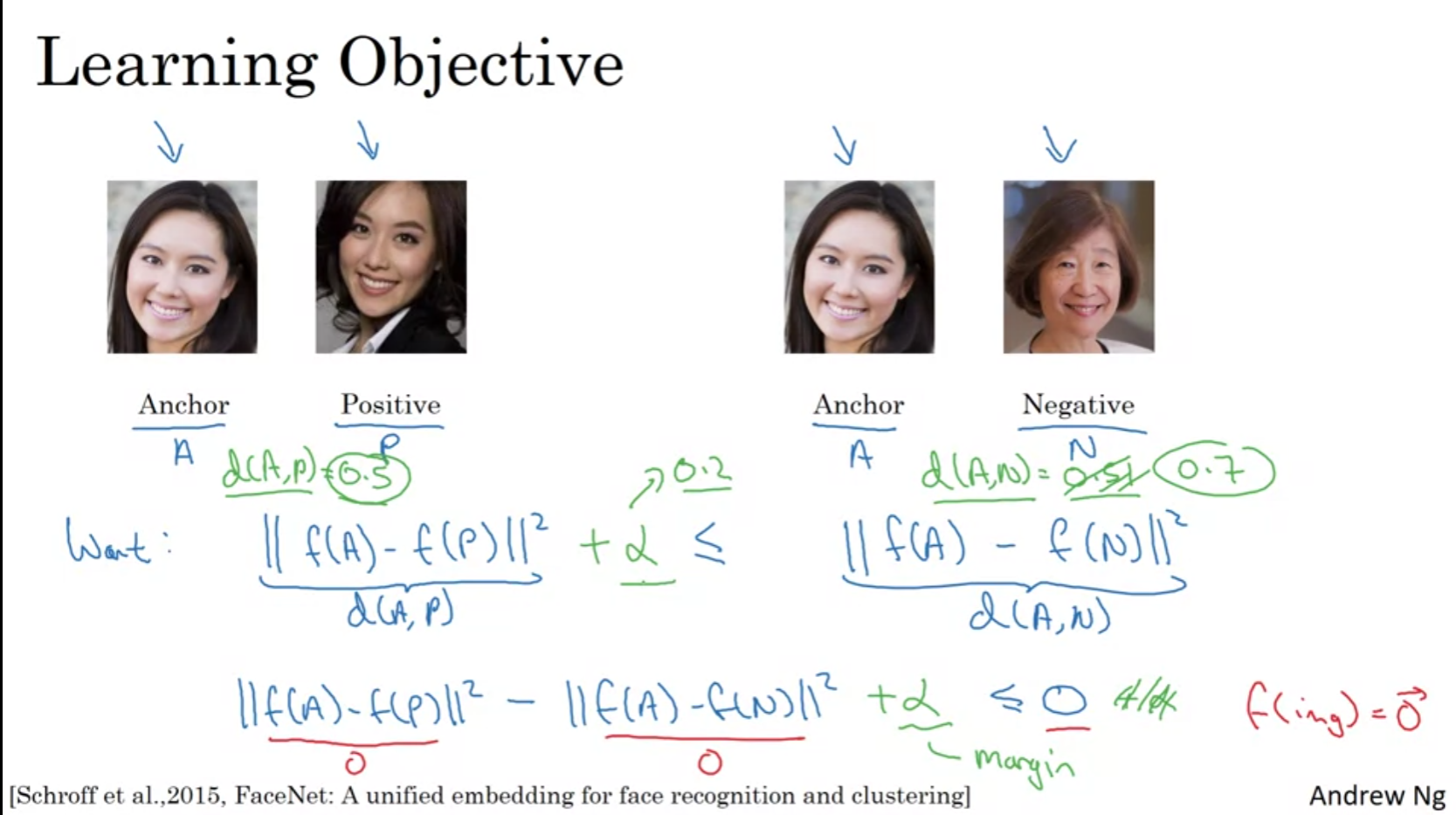

13.Face recognition

Face Verification vs Face recognition Face Verification은 input으로 이미지, name/ID 입력하면 이미지가 실제로 그 사람의 것인지를 확인하는 과정을 거친다. 반면에, face recognition은 더 복잡한 문제

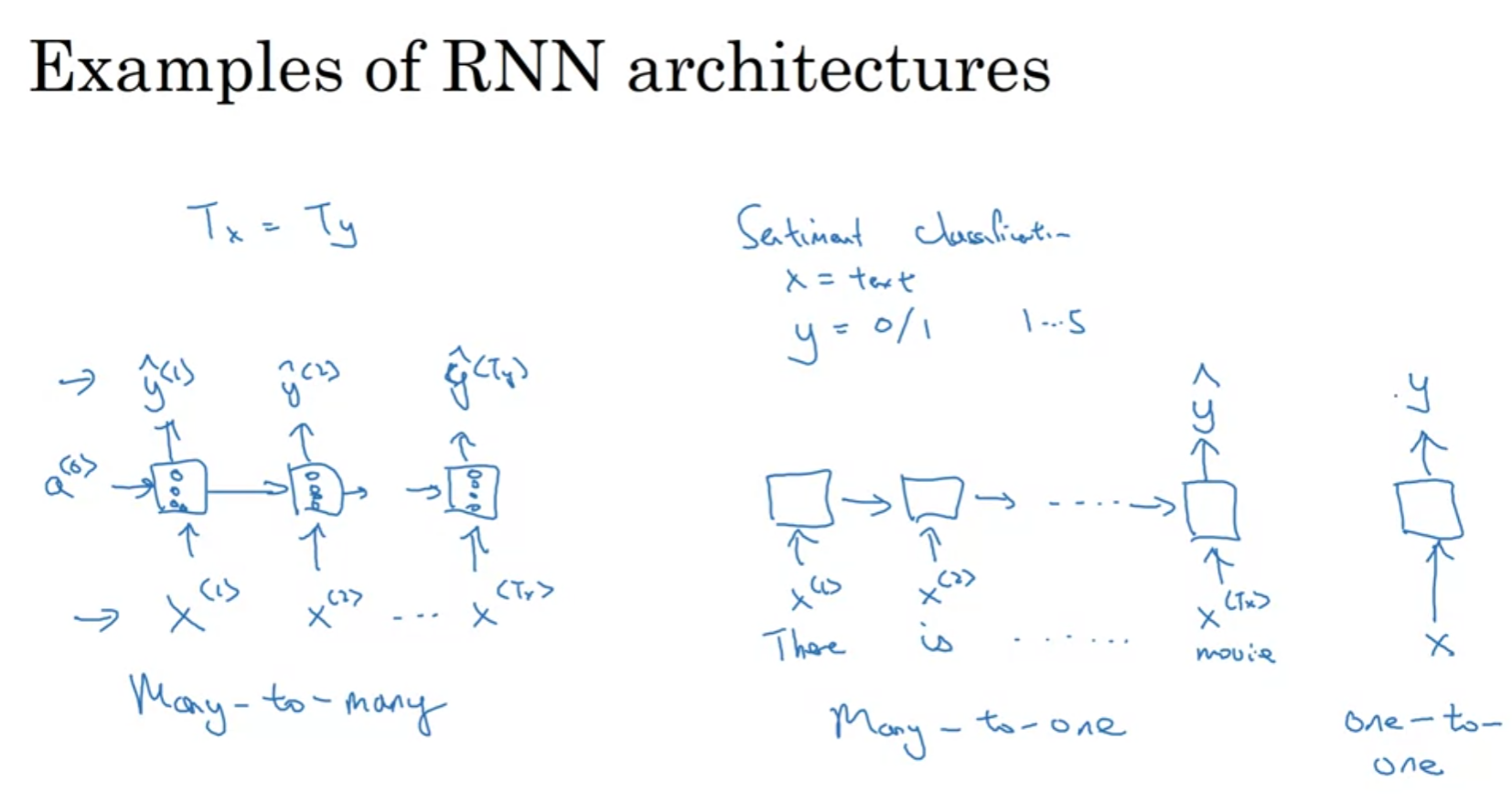

14.RNN

드디어 NLP/sequential data 처리입니다!! 종합설계 할 때 정말 빡세게 공부했었는데 정리안해놓은 걸 조금 후회하고 있어요. 제가 좋아하는 part이므로 자세하게! 정리해보도록 하겠습니다. 🔄️Recurren Neural Networks What i

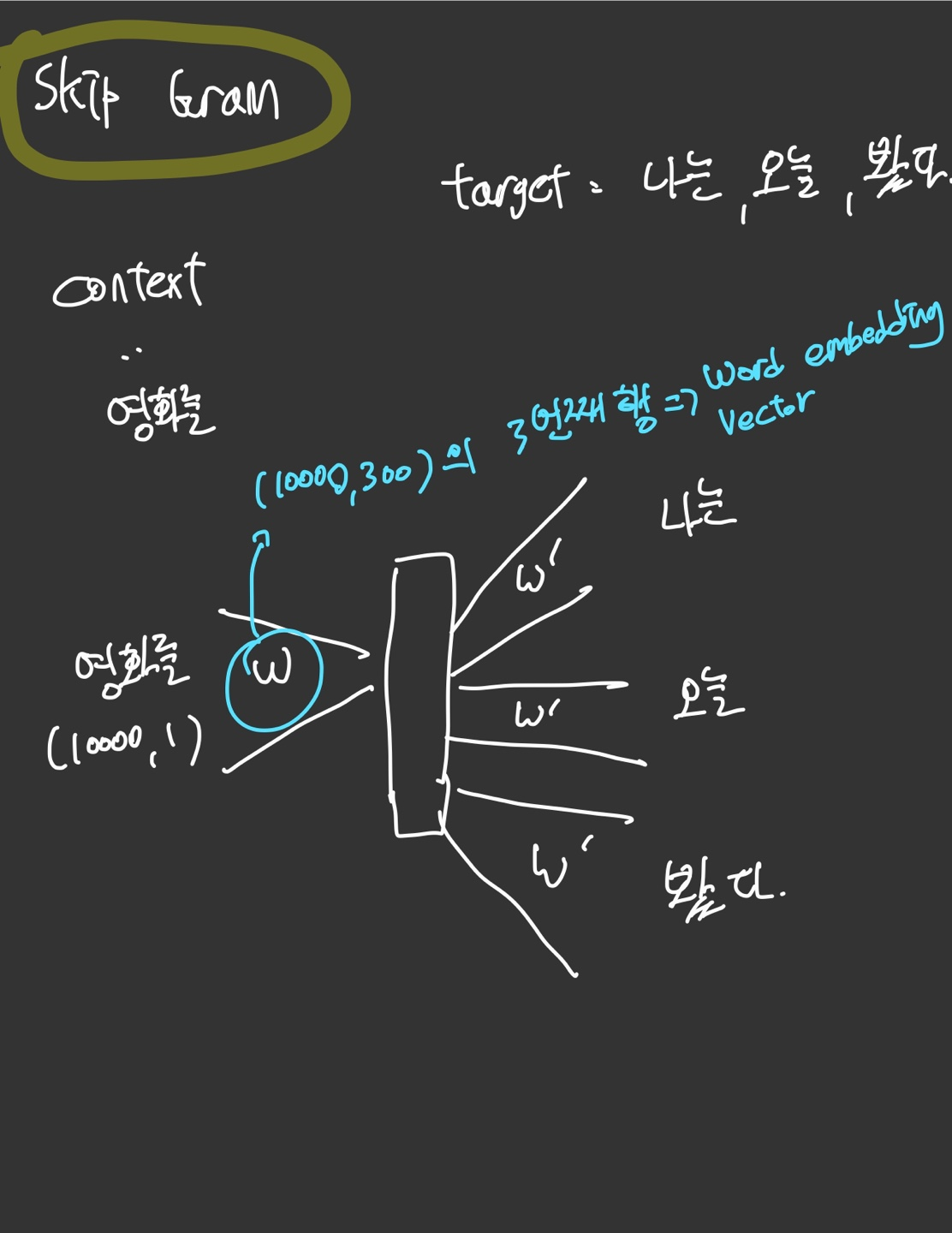

15.Word Embedding

What is word Embeddings Word Representation 기존의 one-hot encoding 방식으로는 단어 그 자체의 의미를 머신이 파악하기엔 한계가 있었다. 예를들면 King 과 Queen과의 관계나 King과 Orange과의 관계나