- 전체보기(36)

- 선형대수학(11)

- linearalgebra(10)

- cpp(7)

- 프로그래밍언어(5)

- 고전역학(3)

- 물리학(3)

- notion(2)

- API(2)

- MC(2)

- 객체지향프로그래밍(2)

- nullspace(2)

- 가우스소거법(1)

- Linear Independence(1)

- columnspace(1)

- MDP(1)

- 선형독립(1)

- basis(1)

- REINFORCEMENT(1)

- orthogonality(1)

- 다중상속(1)

- bellman optimality equation(1)

- model free(1)

- subspace(1)

- server(1)

- td(1)

- mutable(1)

- CS개념(1)

- 동역학(1)

- RANK(1)

- 객체포인터(1)

- 다형성(1)

- dimension(1)

- inverse matrix(1)

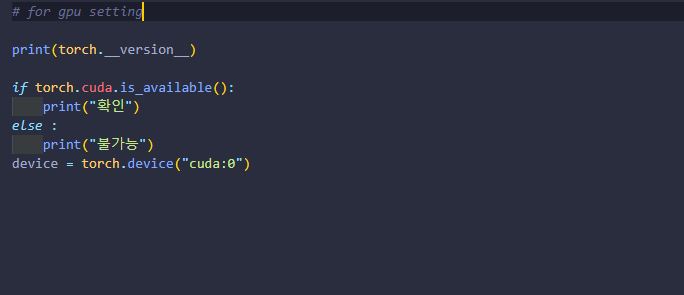

- python(1)

- Value Iteration(1)

- special solution(1)

- linearArgebra(1)

- PPO(1)

- bellman expectation equation(1)

- 시작(1)

- Q learning(1)

- GLIE(1)

- planning(1)

- const(1)

- model based(1)

- friend(1)

- Cloudflare(1)

- 추상클래스(1)

- explicit(1)

- 영공간(1)

- protected(1)

- Gauss-Jordan Elimination(1)

- latex(1)

- policy evaluation(1)

- 행공간(1)

- complete solution(1)

- rowspace(1)

- pycharm(1)

- G-J Elimination(1)

- dqn(1)

- C(1)

- RL(1)

- 가상함수(1)

- 부분공간(1)

- symmetric matrix(1)

- 상속(1)

- policy iteration(1)

- linearAgebra(1)

- Haar Wavelet Transform(1)

- reinforcement learning(1)

- 열공간(1)

- Fundamental Subspace(1)

- DWT(1)

- Importance Sampling(1)

- Gaussian Elimination(1)

- vscode(1)

- 기저변환(1)

- static(1)

- 대칭행렬(1)

[강화학습] Model Free Control

Environment의 MDP(=model)을 알지 못할 때, value function을 어떻게 최적의 policy를 찾을 것인지에 대한 방법론들

[강화학습] Model Free Prediction

Environment의 MDP(=model)을 알지 못할 때, value function을 어떻게 계산하는지; 주어진 policy를 어떻게 평가하는지에 대한 방법론들

[강화학습] Planning by Dynamic Programming

model을 알고 있을 때(=MDP를 알 떄), Reinforcement Learning에서 Prediction 문제와 Control 문제를 해결하는 방법을 배우는 챕터 (with. DP)

[강화학습] Markov Decision Process

강화학습의 문제를 표현하는 방법인 MDP의 개념과 value-function을 계산하기 위해 기초가 되는 Bellman Equation에 대해 이해하는 챕터

파워포인트에서 LaTex 문법 사용하여 수식넣기 : IguanaTex

LaTex로 표현하는 수식을 사용한지도 몇년이 지나 현재 나는 수식을 입력할 때 LaTex 문법이 매우 익숙해진 상태이다.

[강화학습] Deep Reinforcement Learning

기본적인 강화학습은 Agent가 반복해서 시뮬레이션하면서 겪는 경험들을 이용하여 action을 선택할 때 참조하는 일종의 look-up table을 갱신하는 방법이었다.

[강화학습] Introduction to Reinforcement Learning

강화학습이 무엇인지에 대해 그 정의를 살펴보고 어디서 유래했는지 알아보는 챕터

[선형대수학] Change of Basis

Basis는 하나의 동일한 subspace에 대하여 여러개 존재할 수 있다. 이때, subspace안의 벡터를 표현할 때 어떤 basis를 사용하여 표현하는지에 따라서 필요한 정보의 양이 달라질 수 있다.

[선형대수학] Orthogonality

Two vectors v and w are said to be orthogonal if their inner product is zero.

[선형대수학] Four Fundamental Subspace (feat.dimension)

행렬의 4개의 부분공간의 표현과 dimension. (+Elimination 전 후 row space가 변하지 않는 이유!)

[선형대수학] Basis and Dimension of Subspace

벡터들의 모든 linear combination을 모아둔 space가 다른 space와 정확히 같을 때, 해당 벡터들의 집합이 해당 space를 span한다고 한다.

[선형대수학] Linear Independence (feat. Rank)

행렬의 Rank는 행렬에서 독립적으로 뽑아낼 수 있는 column의 최대갯수이다.

[선형대수학] Inverse Matrix & Gauss-Jordan Elimination

행렬의 앞/뒤 어디에 곱하든 그 결과가 항등행렬이 되는 행렬.