- 전체보기(18)

- 논문리뷰(15)

- NLP(9)

- LLM(8)

- agent(5)

- mas(3)

- transformer(3)

- AI(3)

- Multi-Agent(3)

- rag(2)

- evaluation(2)

- serving(1)

- DEEPSEEK(1)

- BLEU(1)

- sbert(1)

- DiffTransformer(1)

- python(1)

- study(1)

- streamlit(1)

- BART(1)

- Offline RL(1)

- Reflexion(1)

- Microsoft(1)

- RL(1)

- 강화학습(1)

- ROUGE(1)

- PEGASUS(1)

- GPT(1)

- summarization(1)

[논문 리뷰] Exploring Expert Failures Improves LLM Agent Tuning (2025)

기존 LLM Agent Fine-Tuning 방법인 RFT는 간단한 작업만 잘한다. 어려운 작업을 해결하는 Agent Tuning 방법은 뭐가 있을까? EEF는 실패 경로에서 ‘유용한 행동’을 식별해 학습에 활용한다.

[논문 리뷰] DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning (2025)

DeepSeek-R1은 80억원, 280만 H800 GPU 시간만으로 o1급 성능의 모델을 제작했다. 그리고 지도학습 없이 순수 강화학습만으로 LLM에게서 추론 능력을 발전시켰다. 이게 다 가능하다고?

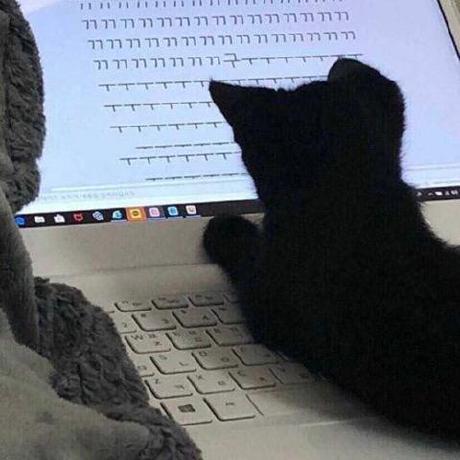

[논문 리뷰] Agent-R: Training Language Model Agents to Reflect via Iterative Self-Training (2025)

Agent-R은 interactive 환경에서 실시간 수정이 가능한 기법을 제안한다. 이는 expert data만을 의존하던 기존 방식과 다르게 self-generated revision trajectory를 통해 성능과 self-reflection 모두를 향상한다.

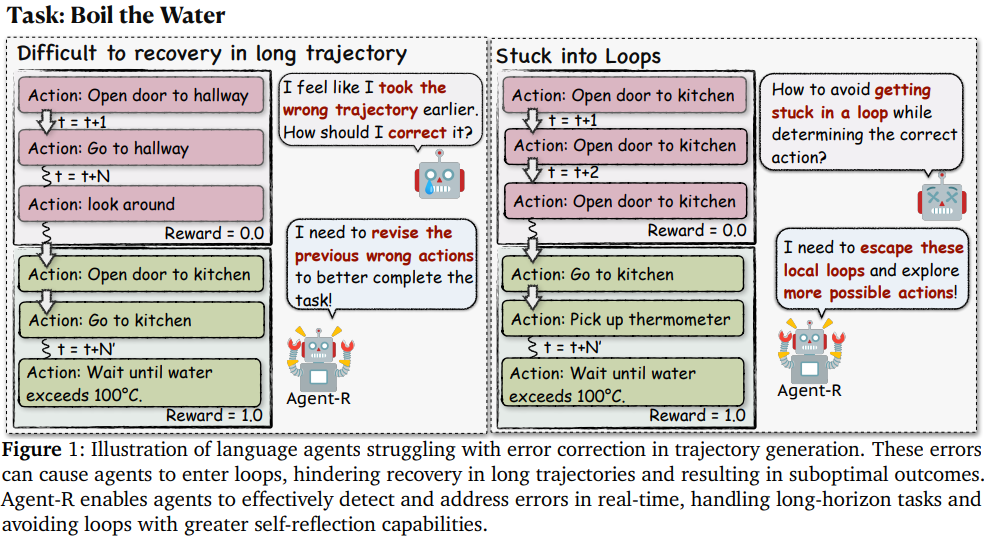

[논문 리뷰] Decision Transformer: Reinforcement Learning via Sequence Modeling (2021)

(NeurIPS 2021) Decision Transformer는 강화학습 문제를 Sequence modeling 문제로 추상화하여 transformer 아키텍처의 단순성과 확장성을 활용했다. 이를 통해 Offline RL에서 기존 알고리즘보다 우수한 성능을 보인다.

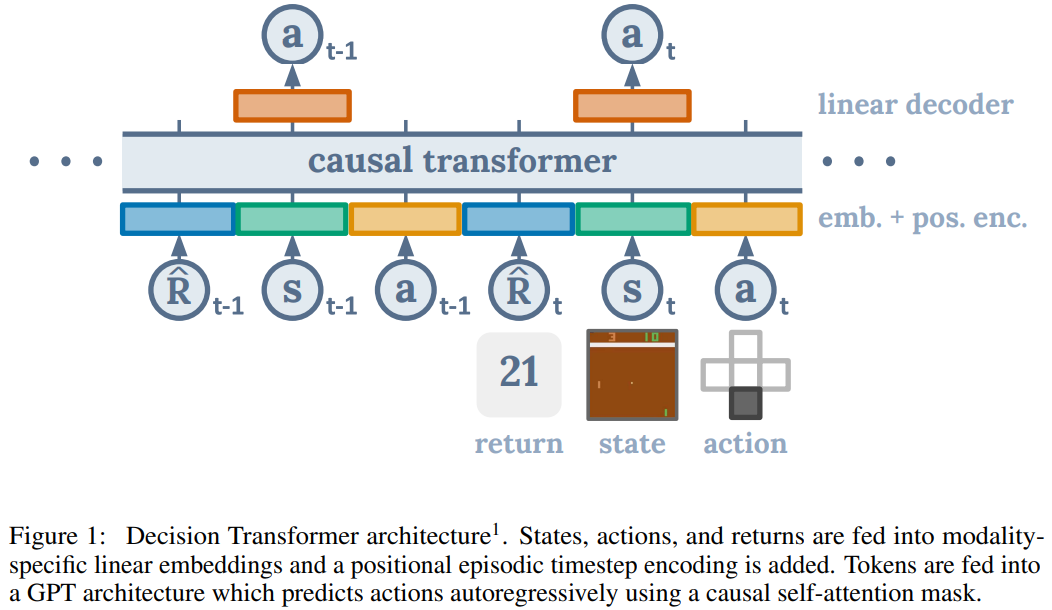

[논문 리뷰] Multi-LLM Debate: Framework, Principals, and Interventions (2024)

(NeurIPS 2024) Multi-Agent debate를 분석한 framework를 제공하며, debate 성능을 향상시키기 위한 3가지 interventions을 제안한다.

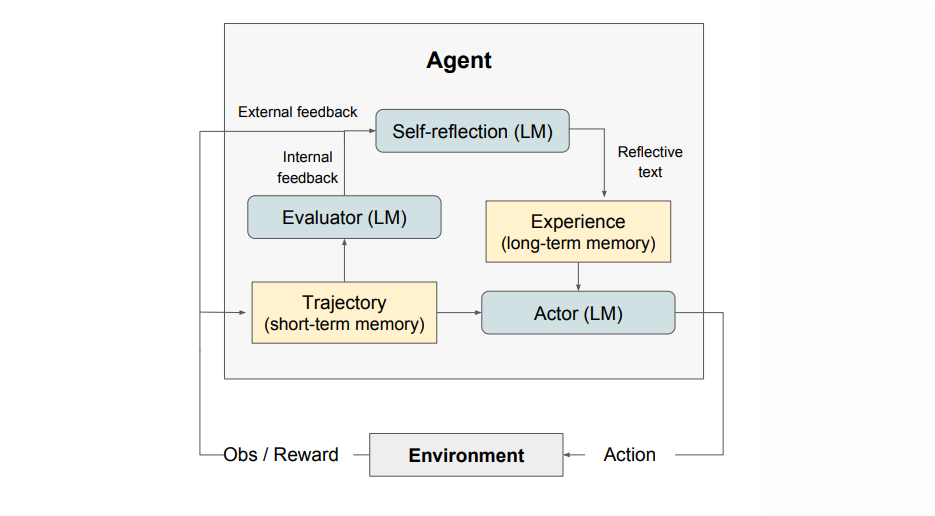

[논문 리뷰] Reflexion: Language Agents with Verbal Reinforcement Learning (2023)

Reflexion 프레임워크는 AI 에이전트가 자신의 행동과 결과를 평가하고, 실수를 바탕으로 학습과 수정 과정을 반복하여 행동 능력을 지속적으로 향상시키는 자기 반성(Self-Reflection) 기반 강화 학습 시스템이다. From NeurIPS 2023

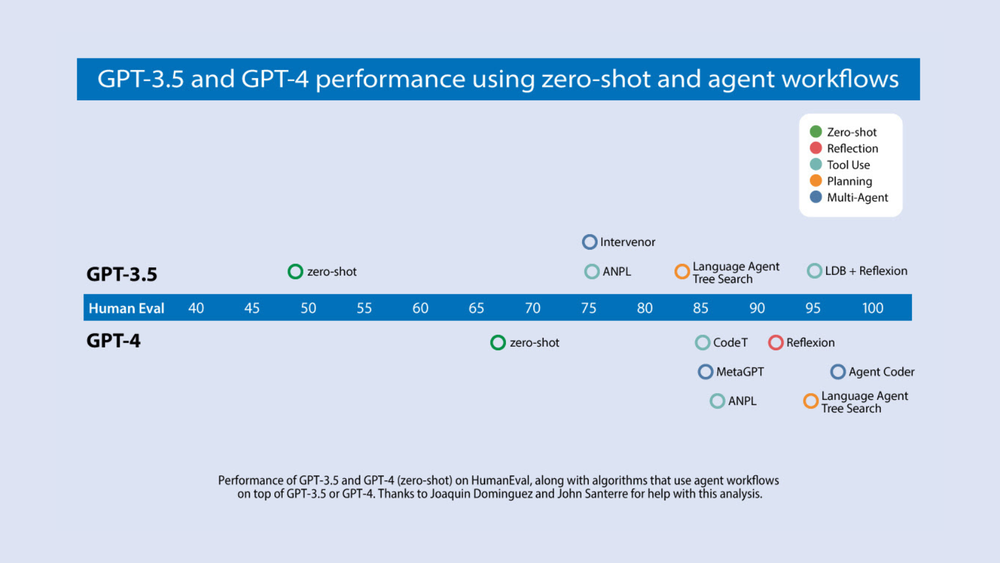

[Survey] Deep dive into AI Agent & Multi-Agent System (MAS)

AI Agent는 LLM의 출력 퀄리티를 높이기 위해 최종 출력물을 내기 전 내부적으로 작업을 여러번하도록 할 수 있다.

[논문 리뷰] Differential Transformer (Diff Transformer) (2024)

DIFF Transformer는 관련 context에 대한 attention을 amplify하고 noise를 줄이는 differential attention mechanism을 통해 Transformer보다 뛰어난 성능을 보인다

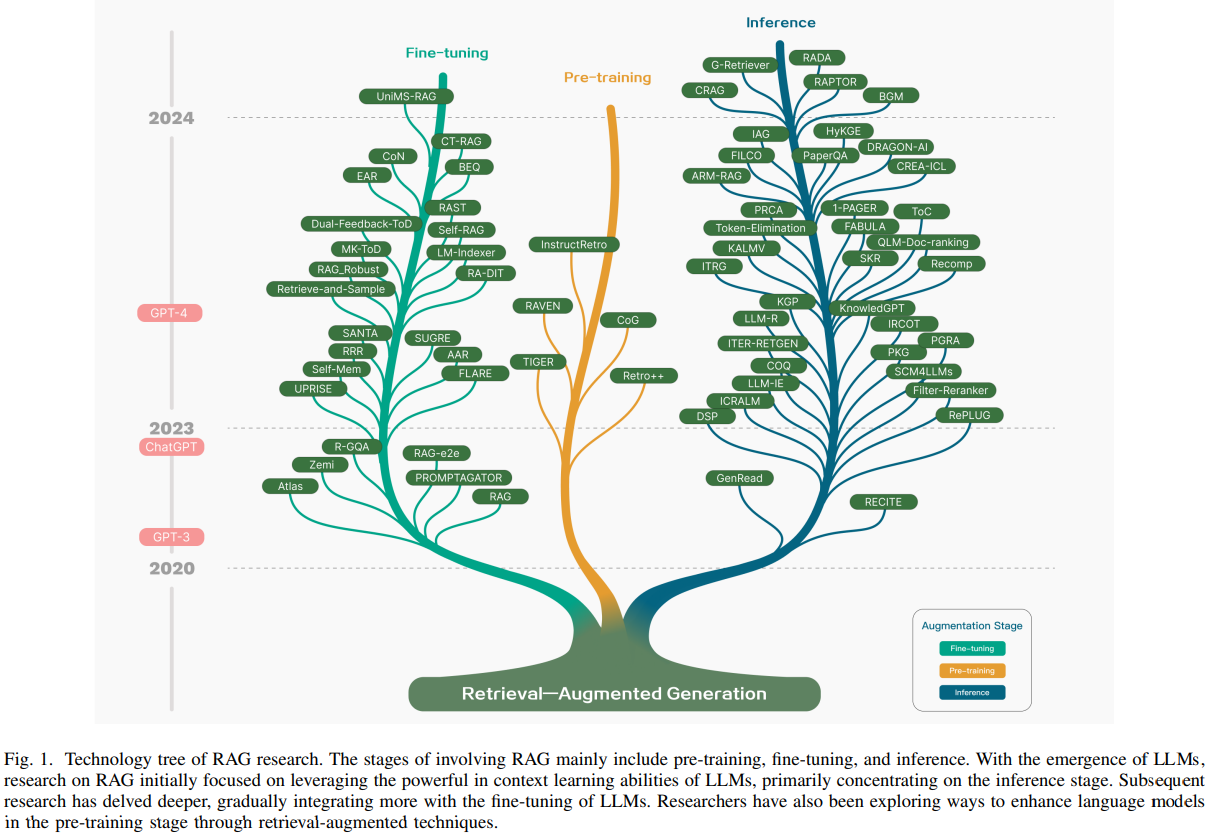

[논문 리뷰] Retrieval-Augmented Generation for Large Language Models: A Survey (2024)

Retrieval-Augmented Generation for Large Language Models: A Survey 논문을 통해 RAG의 역사, 발전 과정, 패러다임, 앞으로의 연구 방향에 대해 알아본다.

[Survey] RAG(Retrieval Augmented Generation) 핵심 개념

RAG(Retrieval Augmented Generation)는 정보 검색(IR)과 텍스트 생성(Generation)의 두 단계를 결합한 시스템으로, QA 시스템이나 대화형 챗봇에서 강력하고 유연한 답변을 제공할 수 있는 기술이다.

[Python] Streamlit 기본 문법 (text, data, cache, session)

AI 딥러닝 모델을 복잡한 프론트엔드 코딩없이 서빙할 수 있게 해주는 Streamlit의 기초 문법에 대해 알아보자

[논문 리뷰] PEGASUS: Pre-training with Extracted Gap-sentences for Abstractive Summarization (2020)

ICML 2020에서 제안된 PEGASUS는 Gap-Sentences Generation(GSG)를 통해 pretrain되어 생성 요약문을 생성하는데 특화되어 있다는 특징이 있다.

[논문 리뷰] ROUGE: A Package for Automatic Evaluation of Summaries (2004)

ROUGE는 후보 요약과 참조 요약을 비교하는 자동화된 방법을 제안하며, 요약의 자동 평가에 효과적으로 사용될 수 있음을 보여준다.

[논문 리뷰] Improving Language Understanding by Generative Pre-Training (GPT-1) (2018)

우리는 Generative한 Pre-training과, Discriminative한 Fine-tuning을 통한 Single model을 통해 자연어 이해 작업에서 강력한 성능을 달성하는 GPT를 제안한다.

[논문 리뷰] BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension (2020)

BART: Seq-to-Seq 모델을 Pre-Train하기 위한 Denoising Autoencoder인 BART를 제안한다

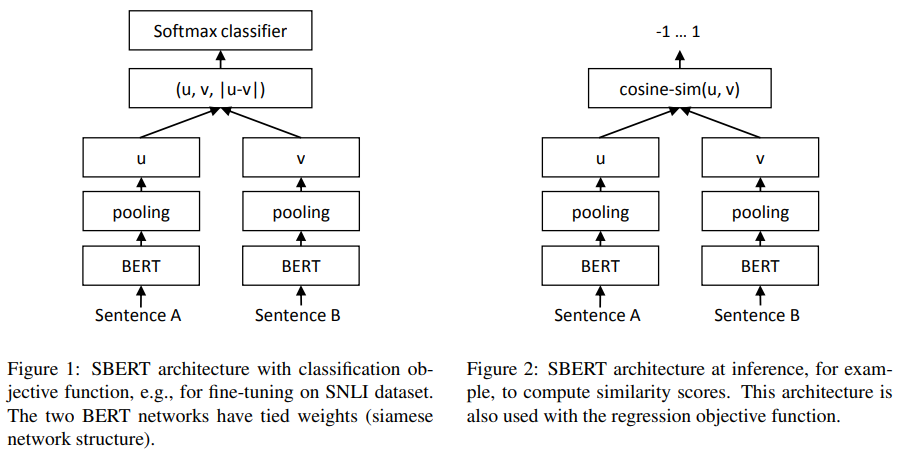

[논문 리뷰] Sentence-BERT: Sentence Embeddings using Siamese BERT-Networks (SBERT)(2019)

Sentence-BERT: Sentence Embeddings using Siamese BERT-Networks (SBERT)(2019) 본 연구에서는 샴 네트워크과 트리플렛 네트워크를 사용하는 BERT의 수정 버전인 Sentence-BERT(SBERT)를 제안한다.

[논문 리뷰] Attention Is All You Need | Transformer (2017)

Attention Is All You Need | Transformer (2017) 우리는 순환(Recurrent) 구조와 합성곱(Convolution) 구조를 완전히 없애고 Attention으로만 구성된 새로운 모델을 제안한다 : Transformer

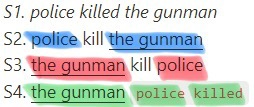

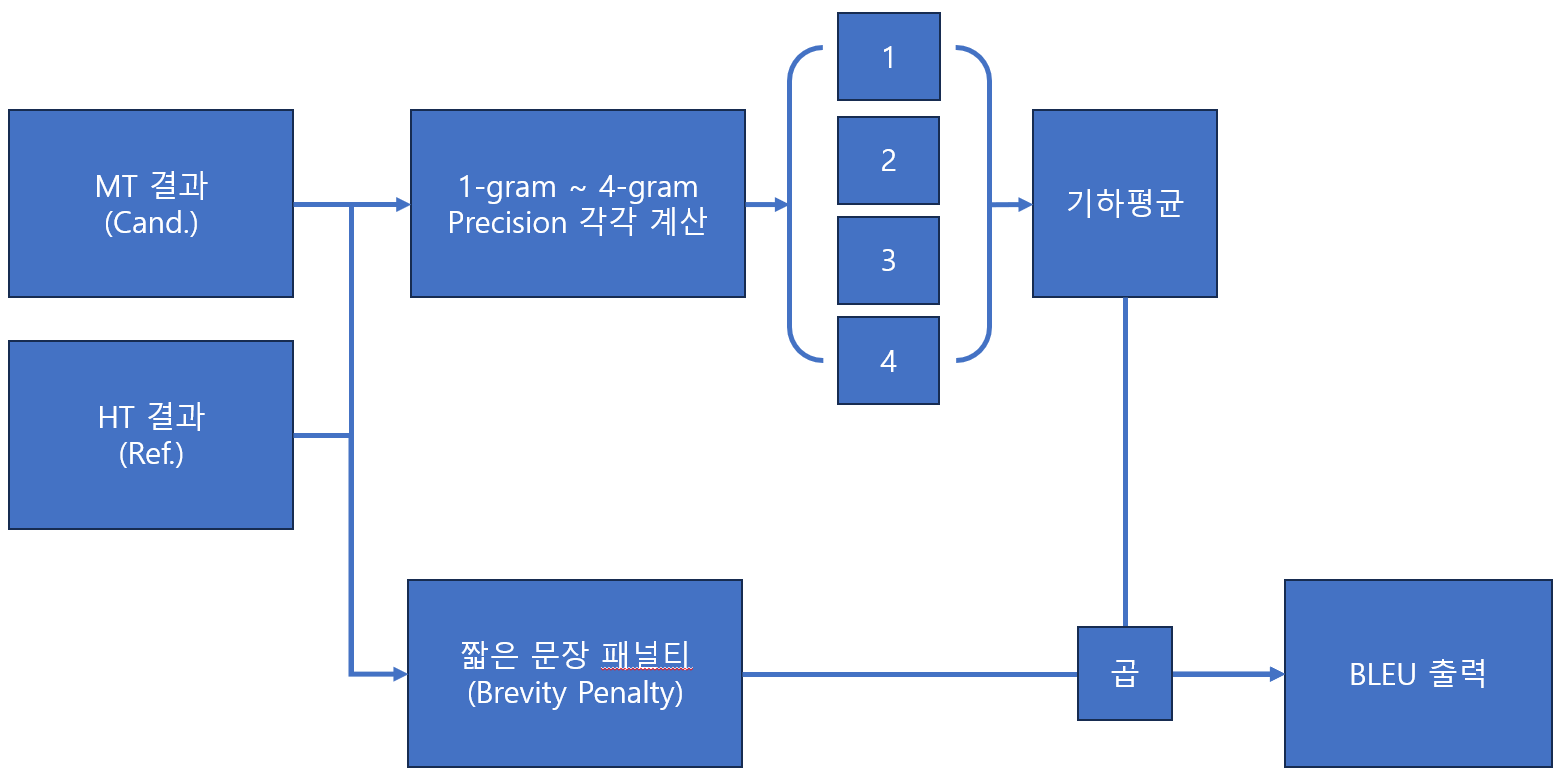

[논문 리뷰] BLEU: a Method for Automatic Evaluation of Machine Translation (2002)

BLEU: a Method for Automatic Evaluation of Machine Translation BiLingual Evaluation Understudy → BLEU