XAI / Object Detection

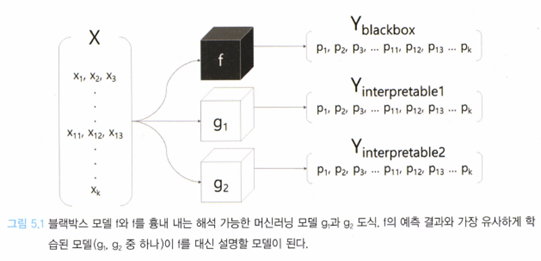

1.대리 분석과 Local Interpretable Model-Agnostic Explanation (LIME)

대리 분석은 이름에서 예상할 수 있듯이 본래 기능을 흉내내는 대체재를 만들어 프로토타입이 동작하는지 판단하는 분석 방법이다.

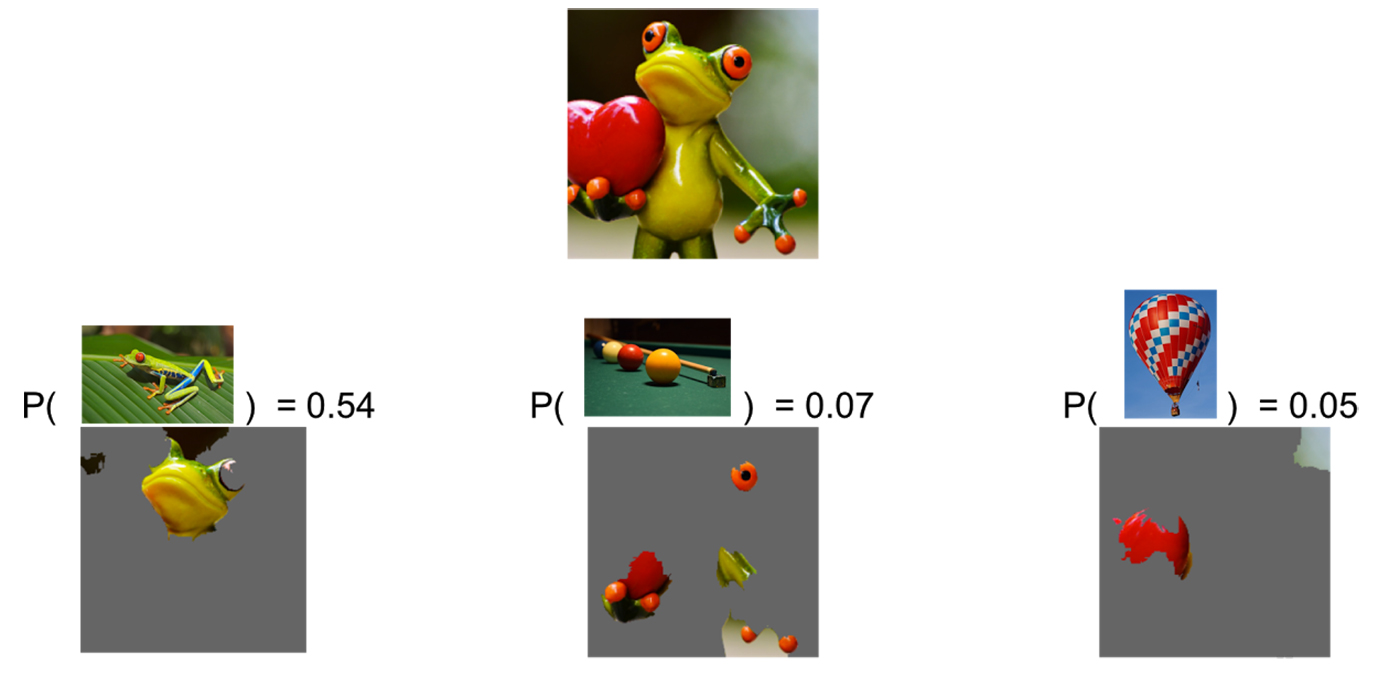

2.[논문 리뷰] LIME : “Why Should I Trust You? Explaining the Predictions of Any Classifier"

본 글은 XAI 기법 중 LIME에 관한 논문("Why Should I Trust You?": Explaining the Predictions of Any Classifier)을 참고하여 작성하였습니다.

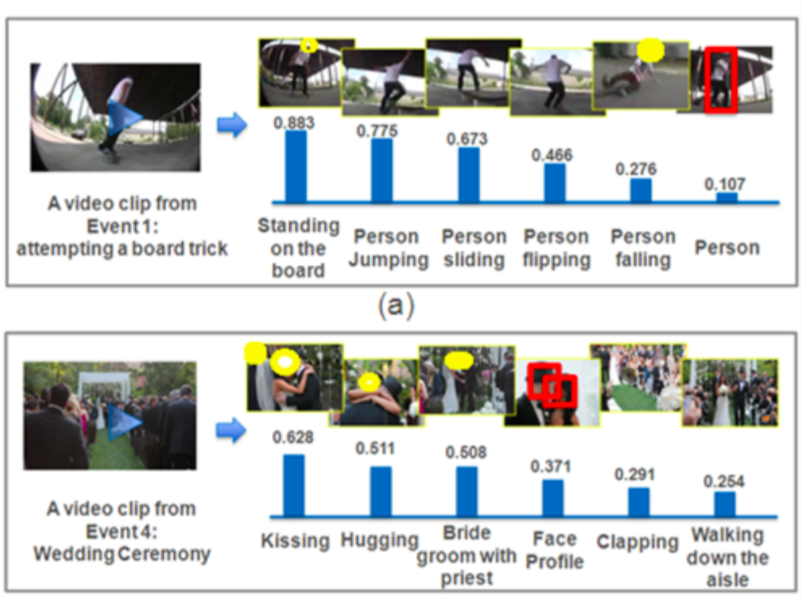

3.[연구개요]Semantic Associations

Semantic Association에 관한 짤막한 메모.

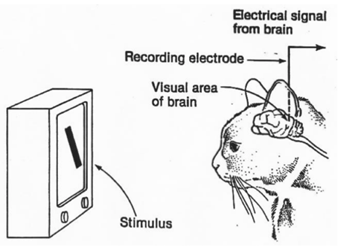

4.[개념정리] Filter Visualization(필터 시각화)

CNN 모델에 적용할 수 있는 XAI기법 중 하나인 시각화 기법에 대해 알아보자.

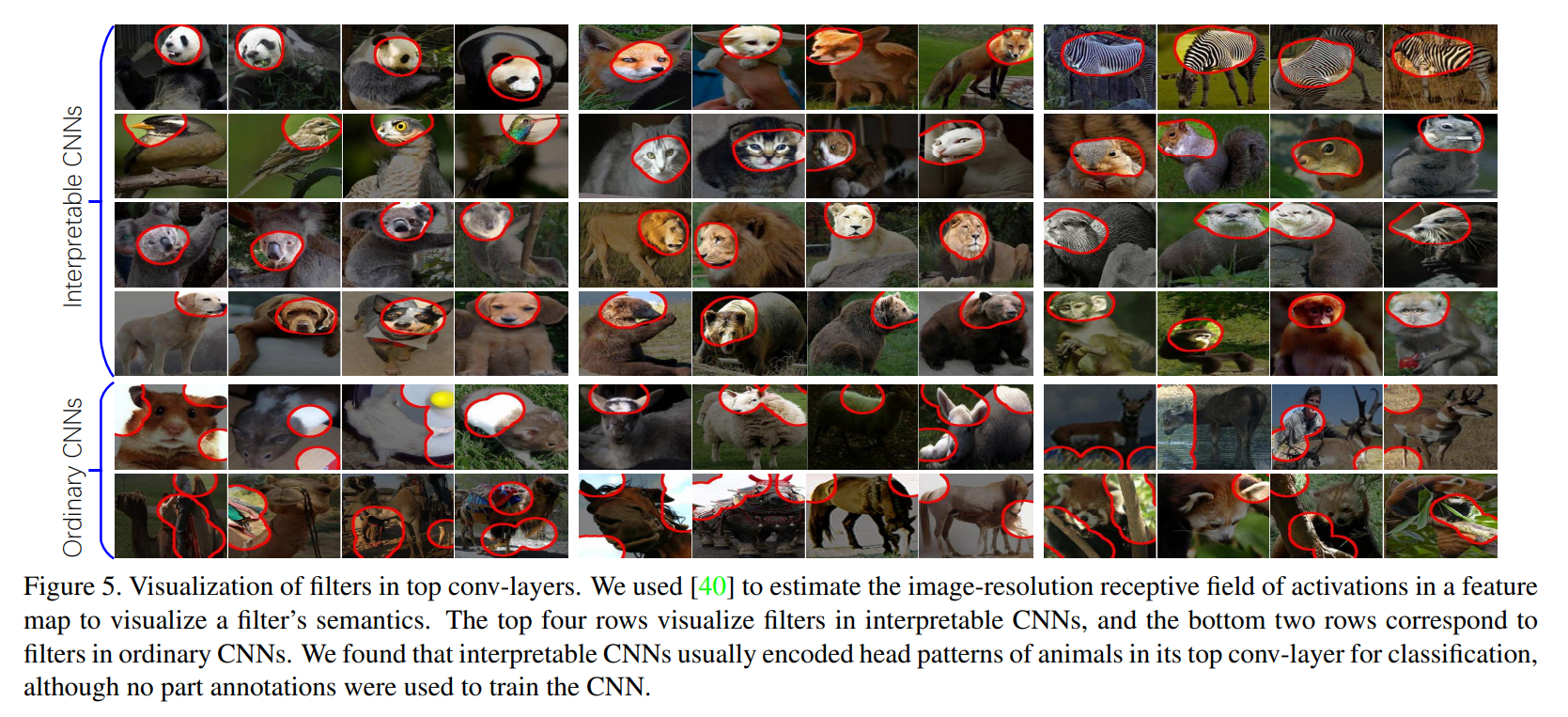

5.[논문리뷰] Interpretable Convolutional Neural Networks

"Interpretable Convolutional Neural Networks"에 대한 논문 리뷰입니다.

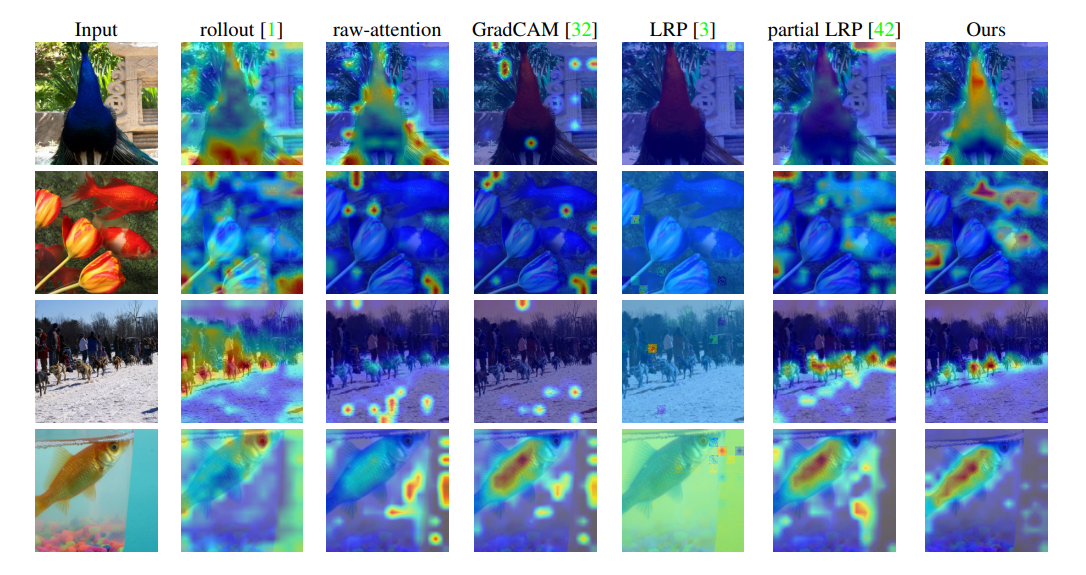

6.[논문리뷰]Transformer Interpretability Beyond Attention Visualization

Paper: Transformer Interpretability Beyond Attention Visualization

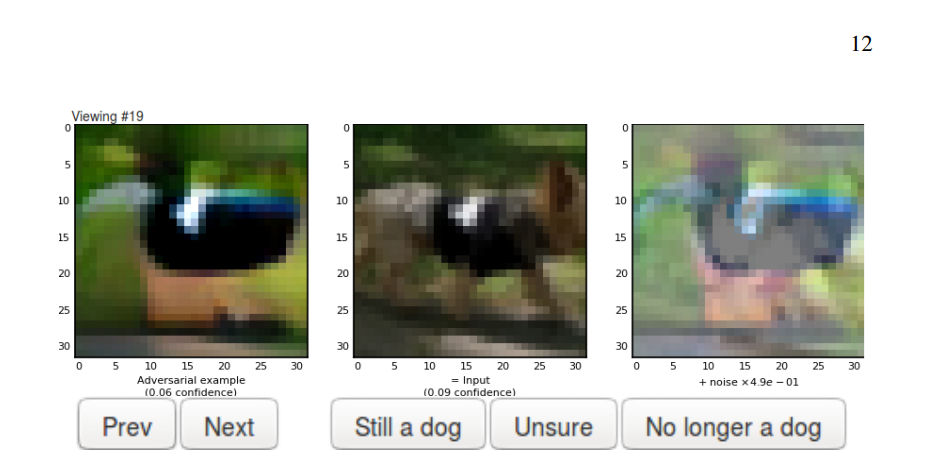

7.[논문리뷰] Adversarial explanations for understanding image classification decisions and improved neural network robustness

"Adversarial Explanations for Understanding Image Classification Decisions and Improved Neural Network Robustness"에 관해 정리한 글입니다.

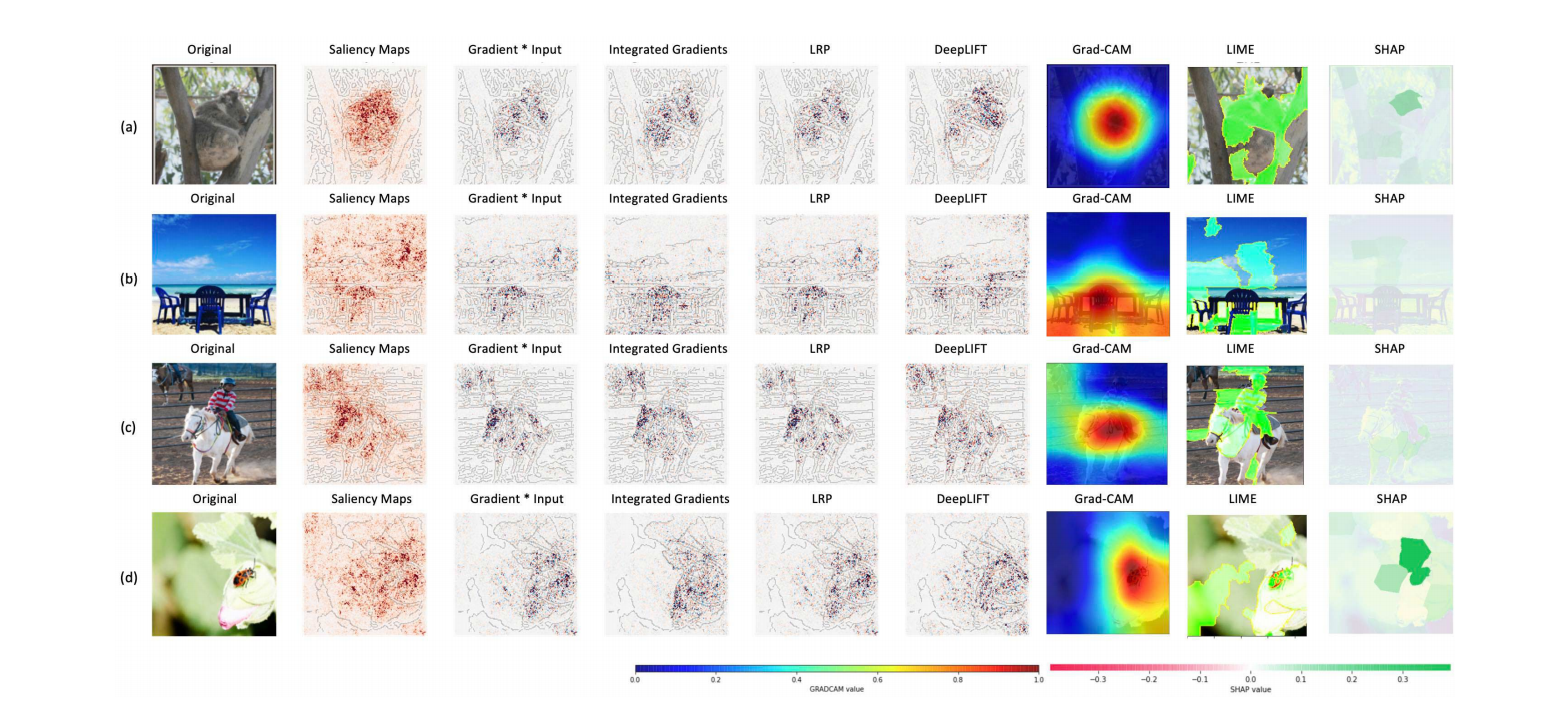

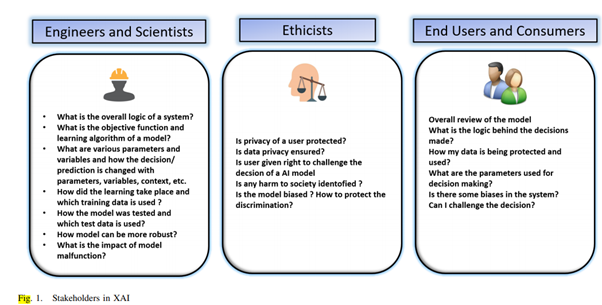

8.[논문리뷰] Opportunities and Challenges in Explainable Artificial Intelligence (XAI): A Survey

"Opportunities and Challenges in Explainable Artificial Intelligence (XAI): A Survey" 논문에 대한 논문 리뷰입니다.

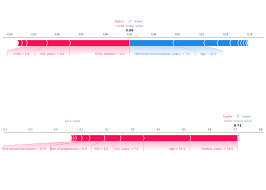

9.[개념정리]SHAP(Shapley Additive exPlanations)

SHAP에 대해 간략하게 정리한 글입니다.

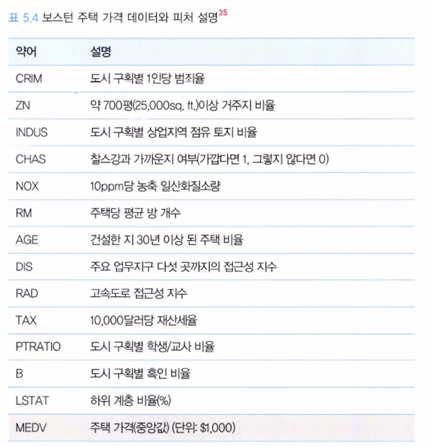

10.[코드리뷰] SHAP - for boston dataset

SHAP 실습 – 보스턴 주택 가격에 대한 설명

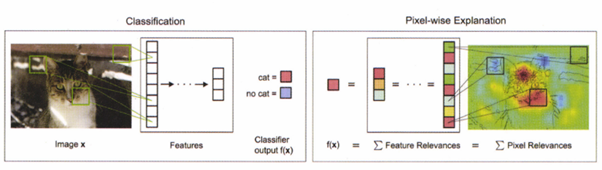

11.[개념정리] LRP(Layer-wise Relevance Propagation)

LRP에 대해 간략히 정리한 글입니다.

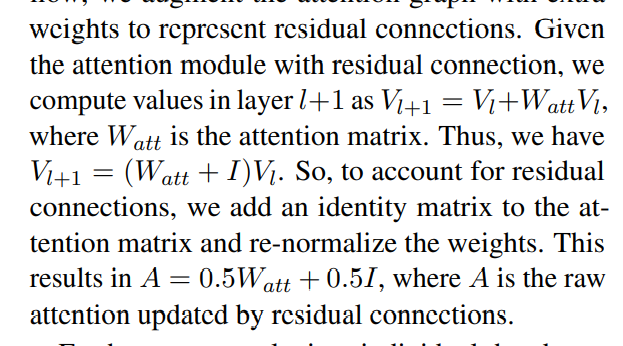

12.[논문리뷰]Rollout : Quantifying Attention Flow in Transformers

Some Notes on Rollout

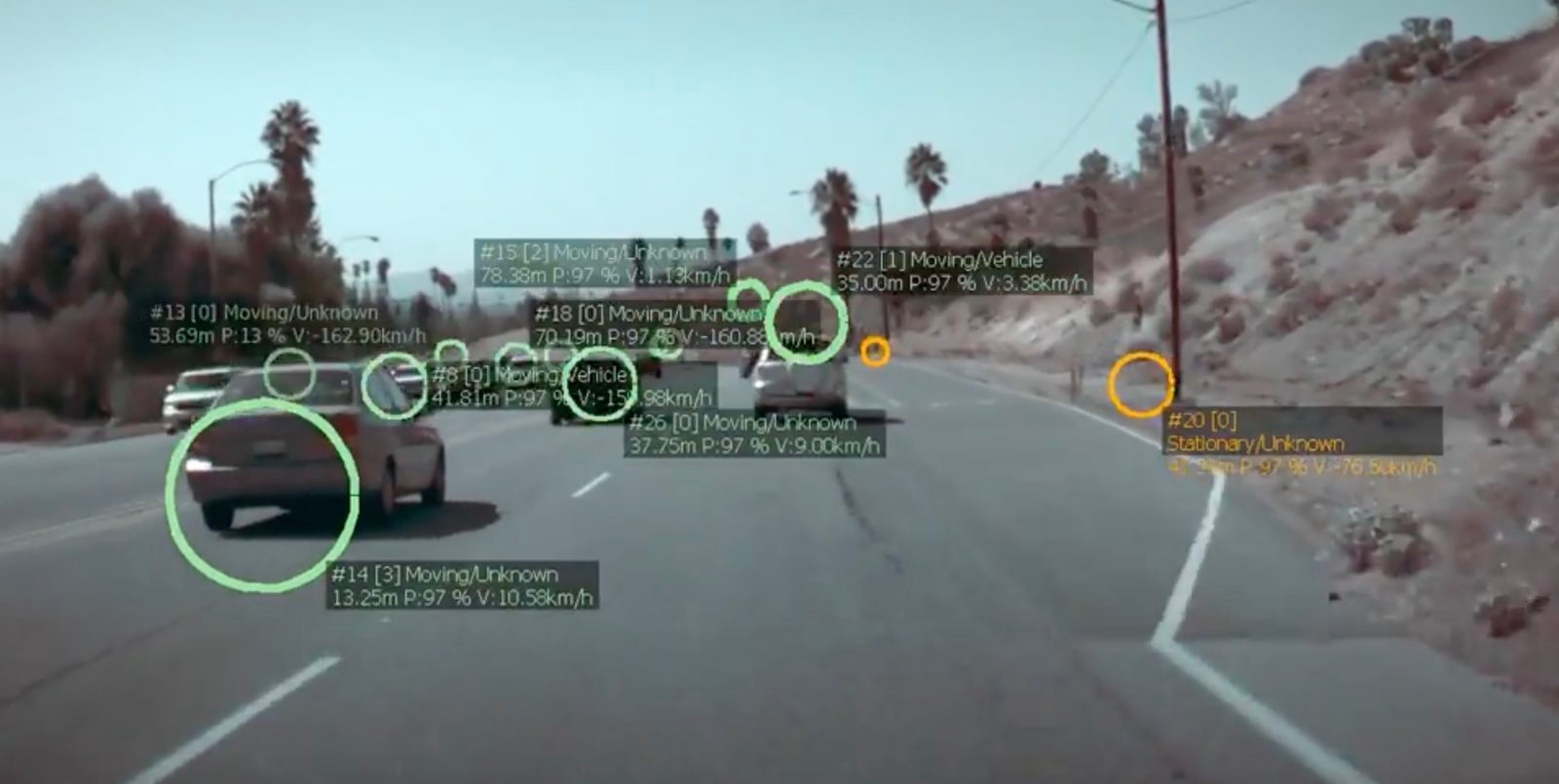

13.[칼럼리뷰] Explaining Why Explainable AI is Needed For Autonomous Vehicles And especially Self-driving Cars

본 글은 해외의 칼럼 중 XAI가 Autonomous vehicle에 적용되어야 하는 이유에 대해서 주장한 칼럼을 다룬다. 실 생활에서 현 AVs가 어떤 상태인지 알고 싶어서 봤으나, 크게 도움되는 내용은 없었던 것 같다.

14.[논문리뷰] Explainable Artificial Intelligence (XAI): An Engineering Perspective

여전히, DL(Deep Learning) 분야에서 설명력과 투명성을 제공하는 것은 법률 규제자, 소비자, 서비스 제공자 등에게 중요한 상황이다. 본 논문에서는, XAI의 개념을 다루기 위해 '엔지니어링적 관점'을 취한다.

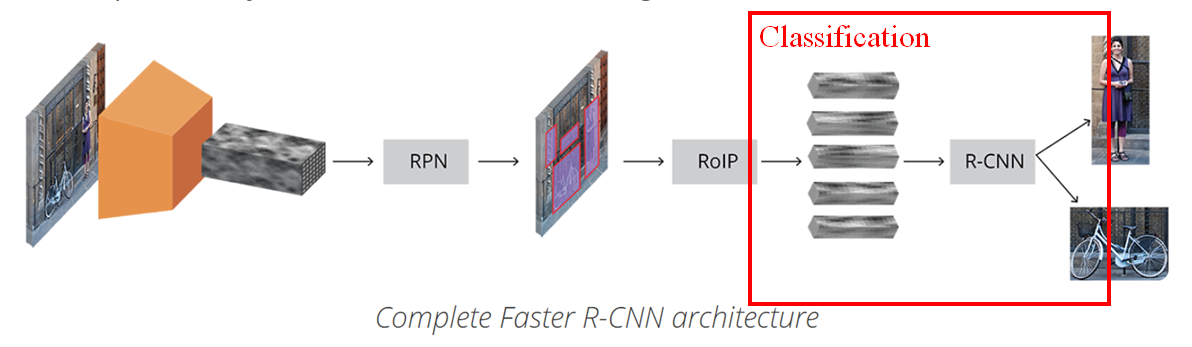

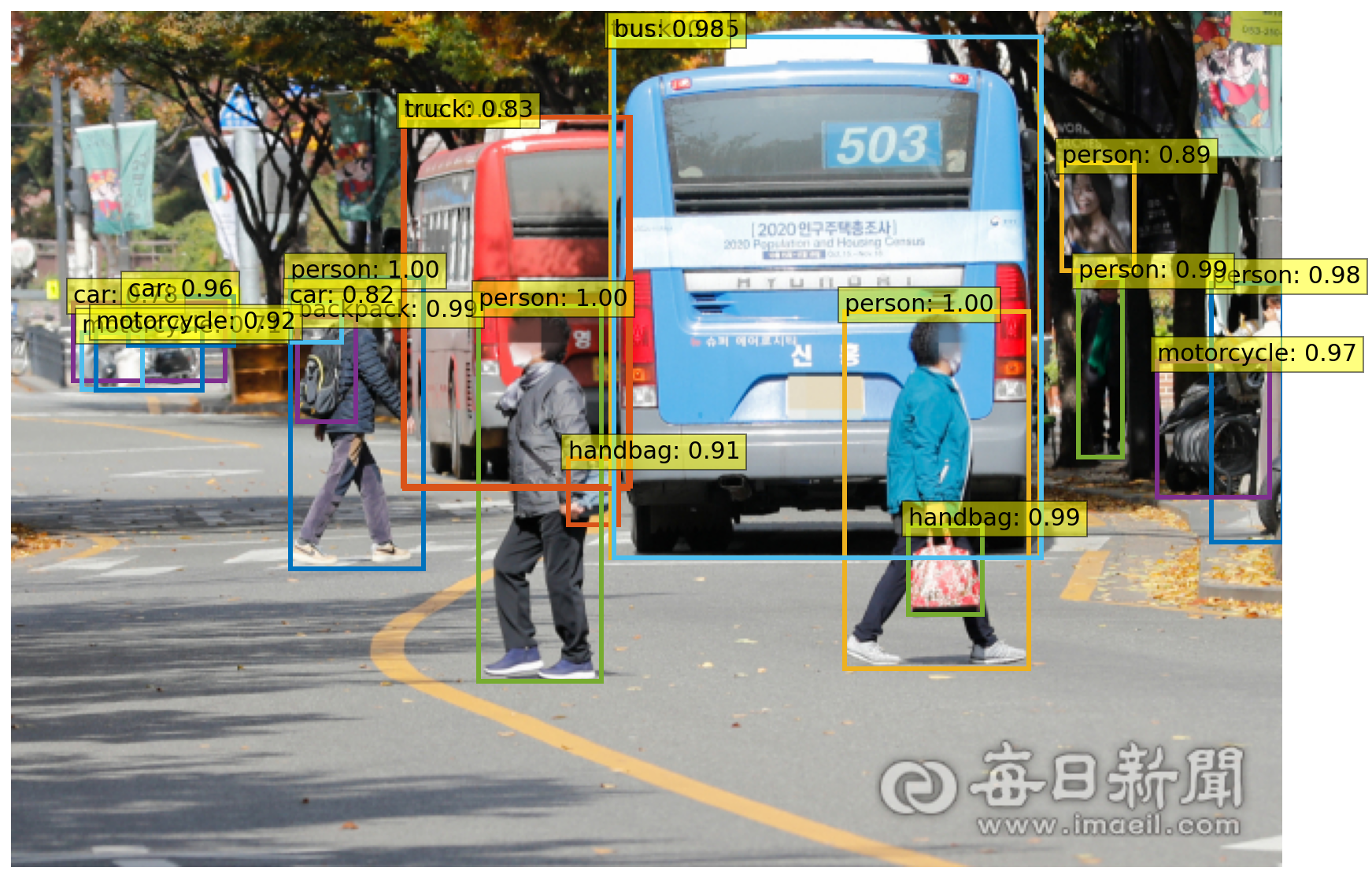

15.[모델리뷰] eXplainable Object Detection

SHAPley Values를 이용해 설명가능한 객체 감지 모델을 구축하는 방법에 대해 기술한 글입니다.

16.[논문&아이디어정리] XAI for object detection

XAI & Object Detection 관련해 참고할 만한 아이디어와 논문을 정리한 글입니다.

17.[관련연구정리] 읽어 볼 논문들 - Keyword: XAI, Object detection, Transformer, Attention, Vision Transformer

XAI, Object Detection, Vision Transformer 등과 관련된 논문을 정리한 글입니다.

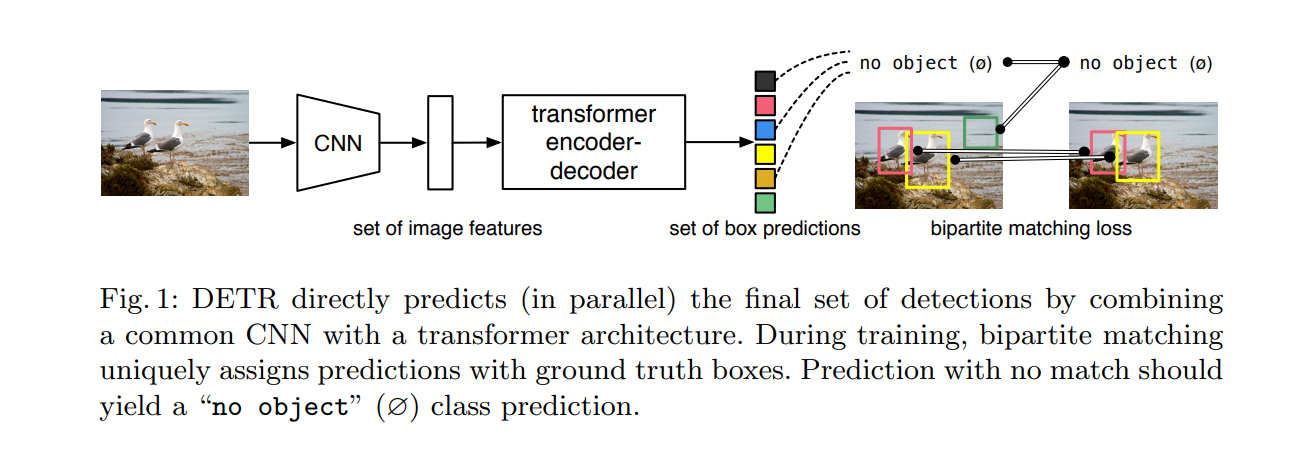

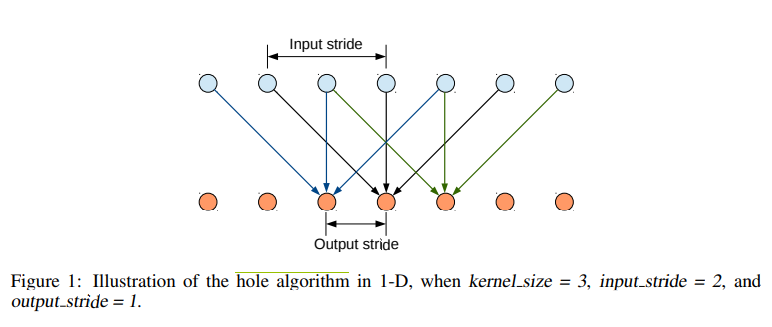

18.[논문리뷰] DETR: End-to-End Object Detection with Transformers

Paper: End-to-End Object Detection with Transformers

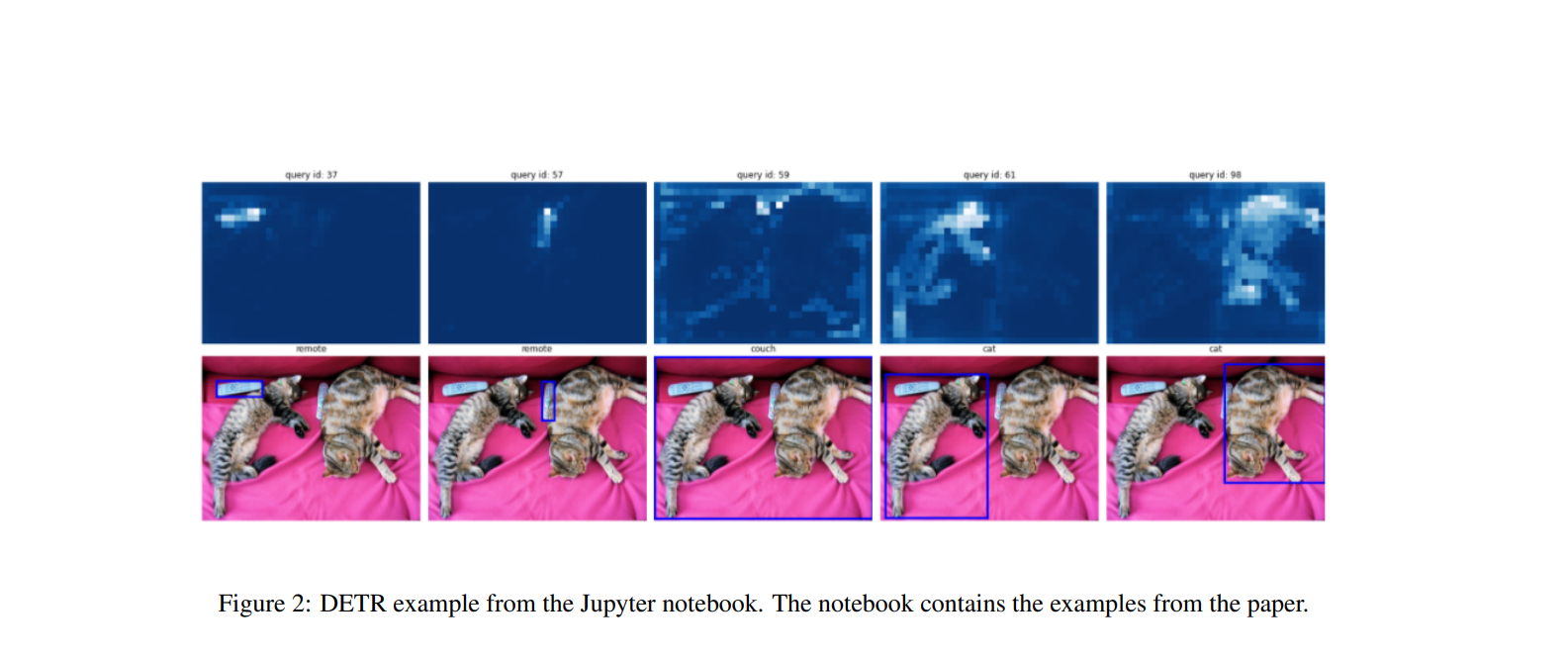

19.[코드리뷰] DETR : End-to-End Object Detection with Transformers

논문 "End-to-end object detection for transformer"의 Implementation code입니다.

20.[논문리뷰] Generic Attention-model Explainability for Interpreting Bi-Modal and Encoder-Decoder Transformers(1)

Paper : Generic Attention-model Explainability for Interpreting Bi-Modal and Encoder-Decoder Transformers. > DETR을 중심으로.

21.[논문리뷰] Generic Attention-model Explainability for Interpreting Bi-Modal and Encoder-Decoder Transformers(2)

Baselines, Experiments, and Conclusion in "Generic Attention-model Explainability for Interpreting Bi-Modal and Encoder-Decoder Transformers" -

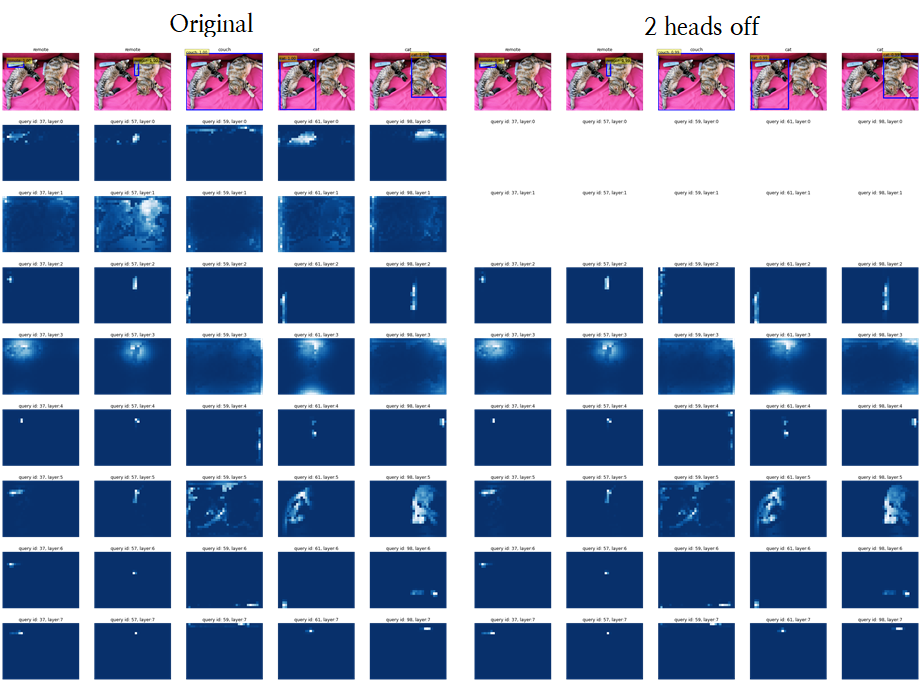

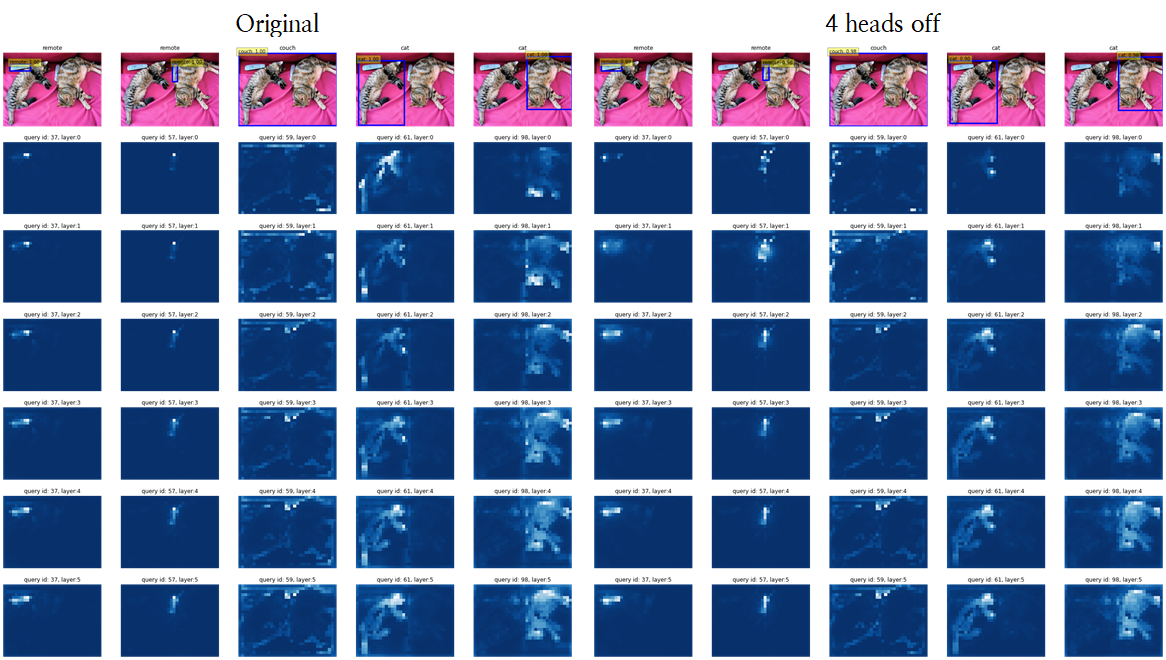

22.Turning off each head's attention maps of Decoder in DETR : Focusing on raw attention map

Turning off each head's attention maps of Decoder in DETR : Focusing on raw attention map

23.Turning off each head's attention maps of Decoder in DETR : Focusing on generic attention model explainability

Turning off each head's attention maps of Decoder in DETR : Focusing on generic attention-model explainability

24.Role of CNN-Based backbone in DETR

End-to-End Object Detection 모델(DETR) 내에서 Feature maps을 생성하는 CNN 기반 Backbone 모델이 최종 성능에 어떻게 기여하는 지에 대해 정리할 글입니다.