딥러닝

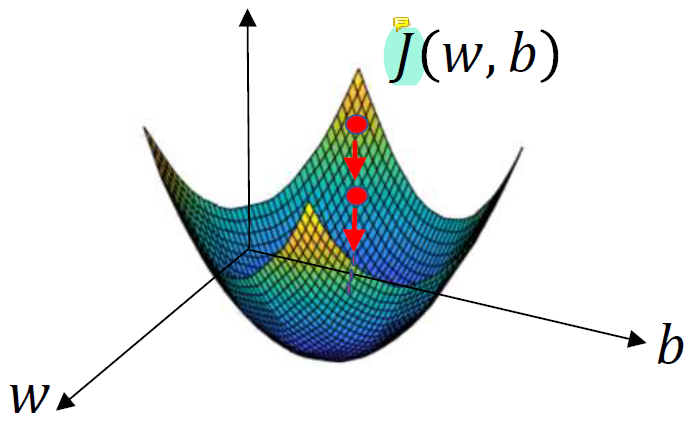

1.Logistic Regression (Notation, Cost Function, Gradient Descent)

Binary Classification classification의 결과가 0 또는 1인 것을 의미한다. 예를 들면 사진 하나를 보여주고 이 사진이 고양이이면 1, 고양이가 아니면 0을 뱉는 classification model은 binary classificatio

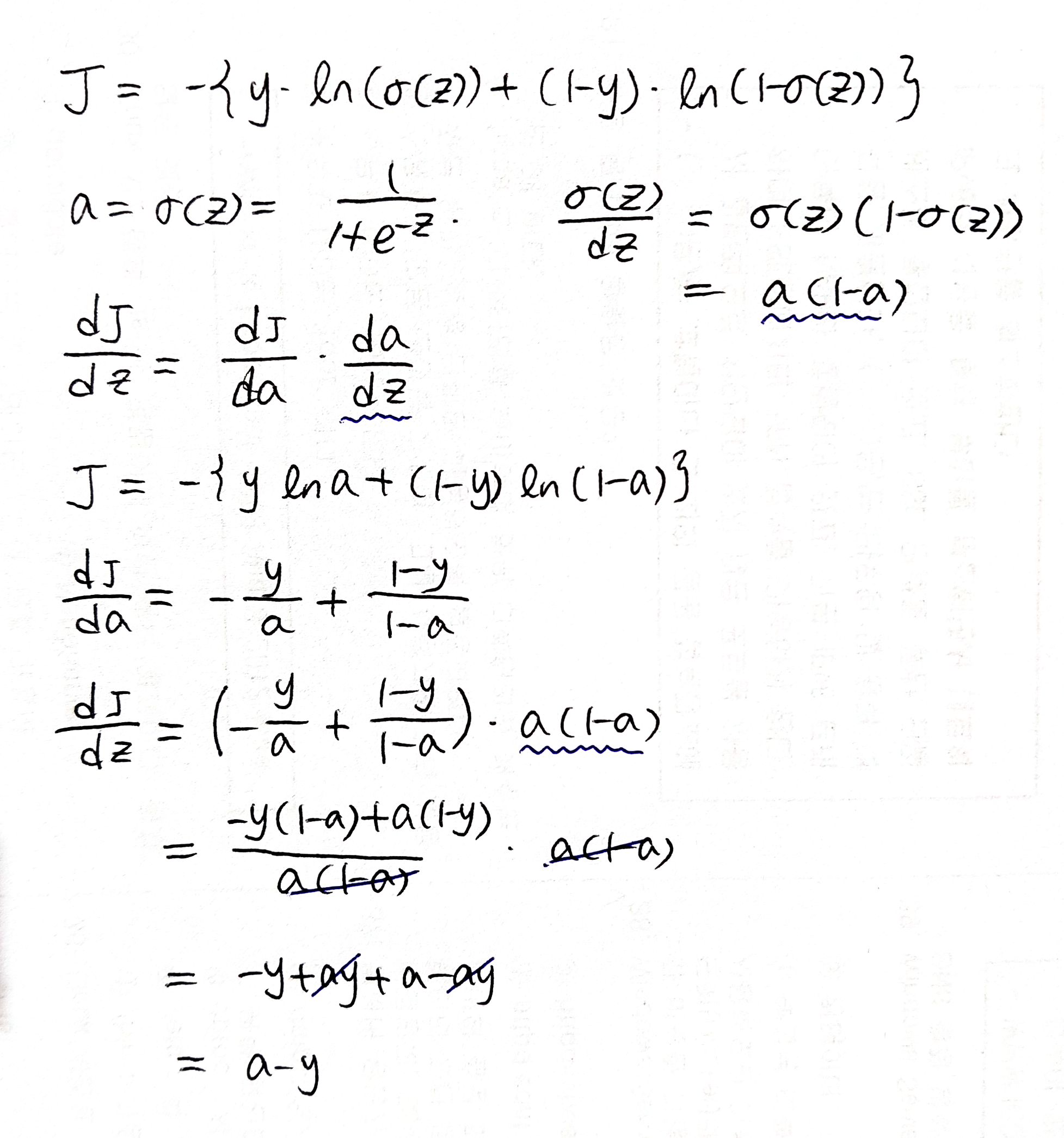

2.Logistic Regression (Computation Graph)

Computation Graph model을 perceptron이라고 하는데 logistic regression에서는 loss function의 gradient를 통해 w와 b를 찾아야 한다. 코드로 gradient method를 구현할 때에는 최대한 효율적으로 계산

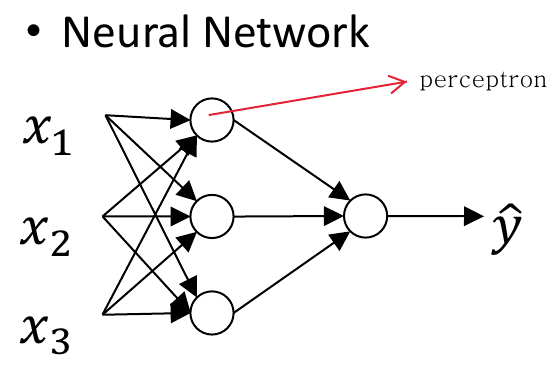

3.Neural Network

이 그림과 같이 사람의 neuron을 본뜬 perceptron이 엮여있는 것을 neural network라고 한다.저 그림에서 동그라미 하나가 perceptron에 해당한다.인공지능에서는 스스로 생각할 줄 아는 컴퓨터를 만들기 위해 인간의 뇌를 구성하는 신경세포(뉴런)

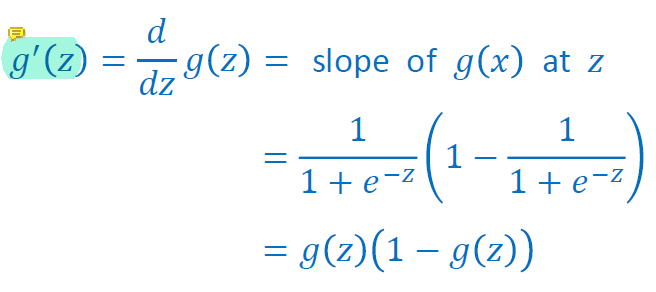

4.Activation Functions

Activation Functions logistic regression에서 linear transformation 결과에 적용한 non-linear transformation인 sigmoid함수가 activation function에 해당된다. activation f

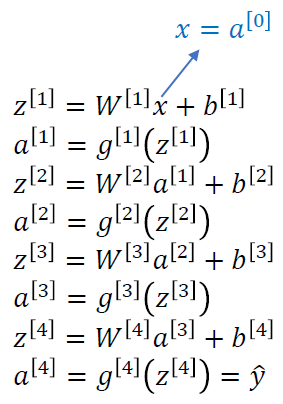

5.Deep Neural Network

Deep Neural Network 일반적으로 hidden layer의 개수가 2개인 network부터 deep neural network라고 한다. layer의 개수가 많아질수록 만들 수 있는 network의 경우의 수가 많아진다. 각 층에 퍼셉트론을 몇 개 쓸 것인

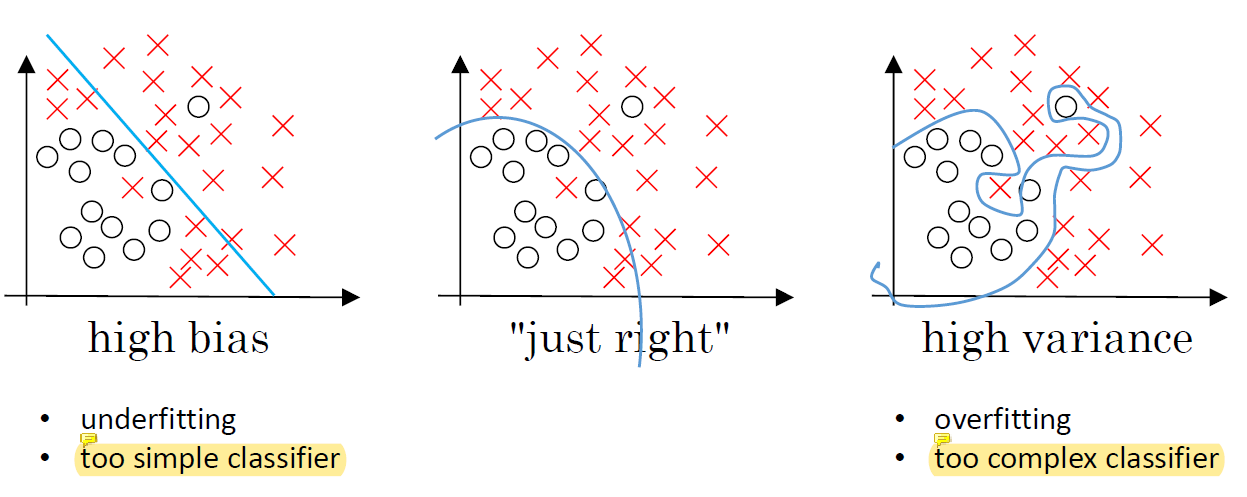

6.Problem Setting and Regularization

training을 하기 위해서 결정해야 할 것들이 정말 많지만 각 hyperparameter 사이에 dependency가 있기 때문에 guess가 매우 어렵다. 그렇기 때문에 실제로 machine learning은 굉장히 반복적인 작업이다. Dataset 좋은 cho

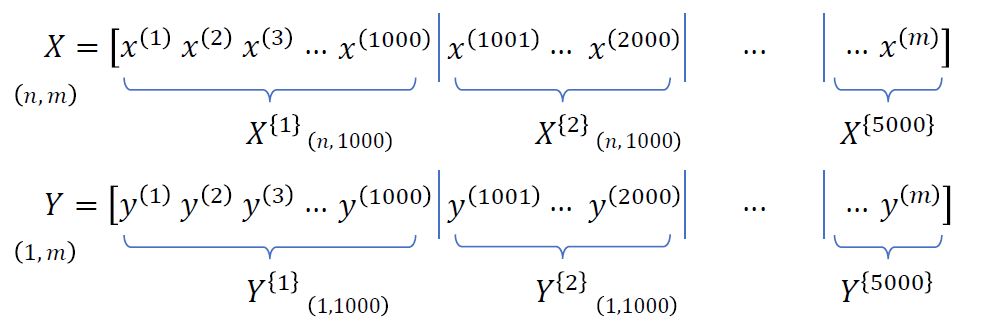

7.Batch Normalization

batch normalization은 hyperparameter를 찾는 문제를 더 쉽게 만들어주고 nerual network가 hyperparameter를 선택할 때에 더욱 robust할 수 있게 해준다. Batch / Mini-Batch 전체 train exampl

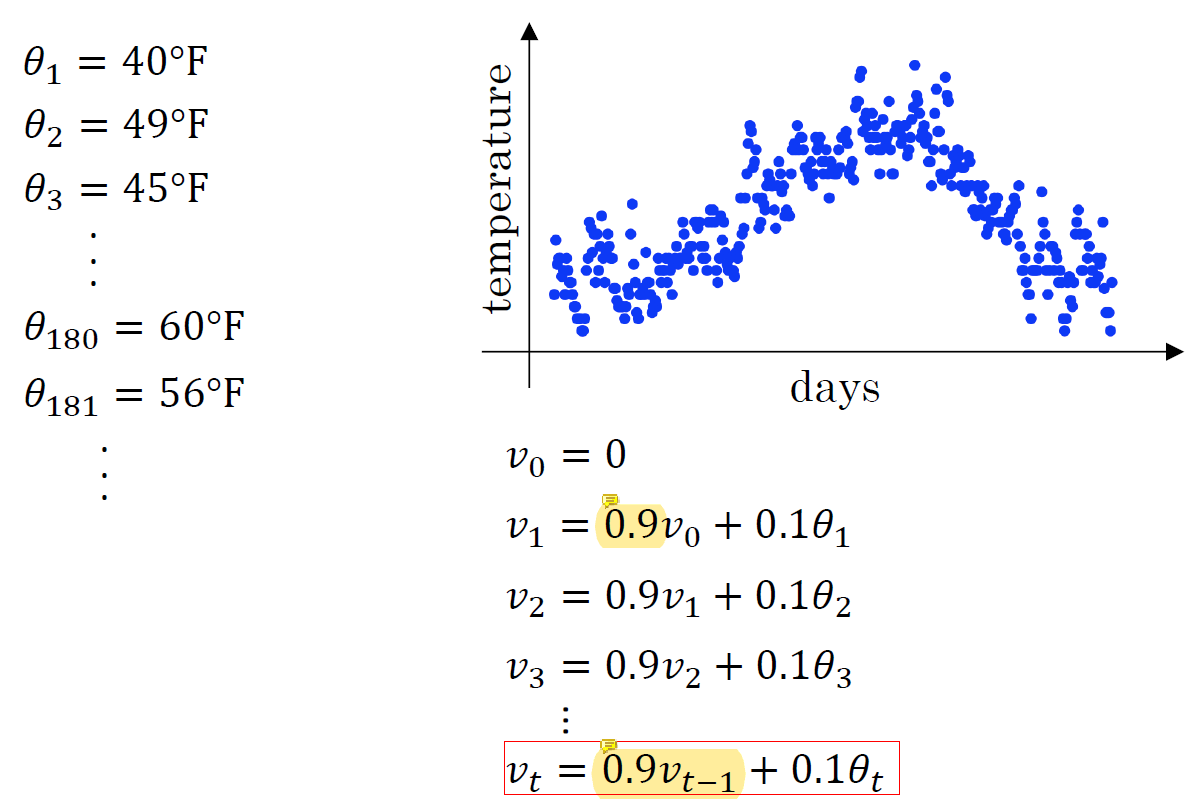

8.Optimization Algorithms

temperature의 값을 나타냈을 때 값들에 noise가 섞여있다. noise를 없애는 가장 쉬운 방법은 average를 사용하는 것이다.식에 곱해진 0.9는 smoothness의 강도를 결정한다. 이전 단계에서 smooth된 data에 smoothness를 적용하

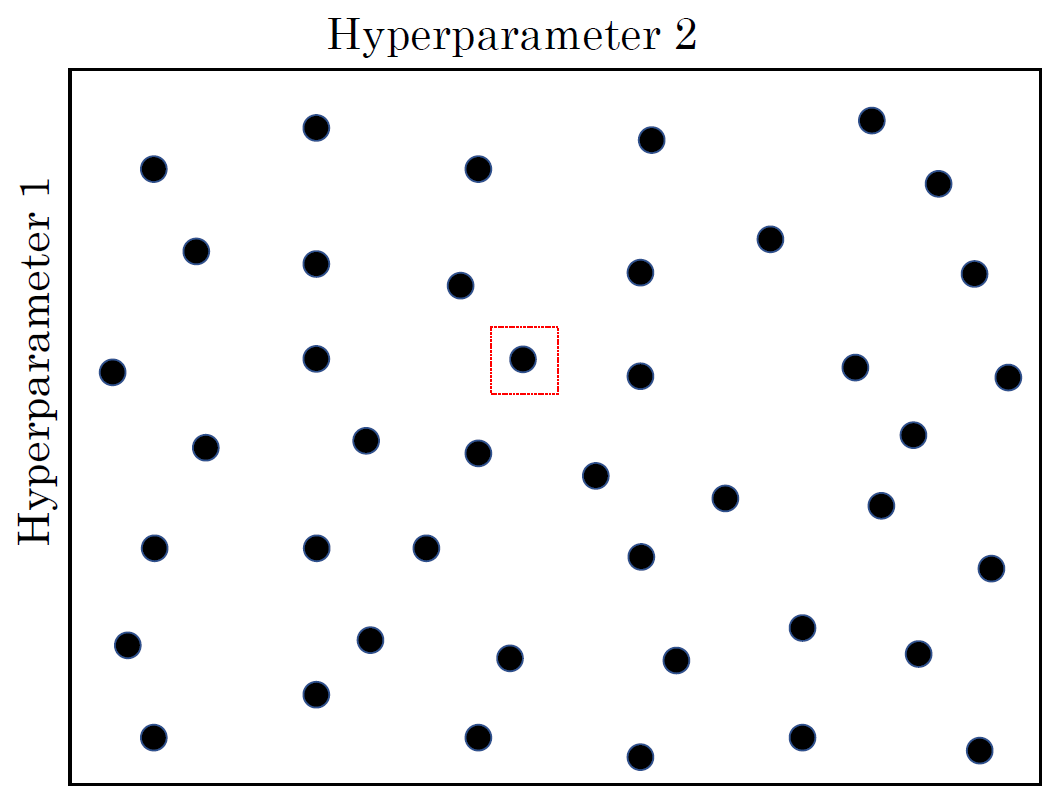

9.Hyperparameter Tuning

uniform하게 hyperparameter를 선택해서 그 중 좋은 것을 쓸 수 있지만 α입장에서는 그 α에 대해 다른 값을 5개밖에 보여주지 않은 것이 된다. 5개만 동일한 α에 대해 검사했기 때문에 보여주지 않은 값 중 더 좋은 것이 있었을 수도 있음.. 랜덤하게

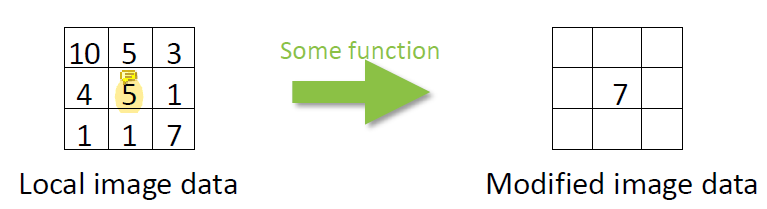

10.Convolution

output image와 input image는 같은 크기이다 (image 크기가 변하지는 않음).image filtering에는 linear filtering과 non-linear filtering이 있다.linear filtering은 단순히 입력 data를 주변

11.✨Convolutional Neural Network

Convolutional Neural Networks (CNN)

12.✨Case Studies, Practical Advices for Using ConvNets

LeNet-5, AlexNet, ZFNet, VGG-16, GoogLeNet, ResNet

13.✨Recurrent Neural Network

RNN, LSTM, GRU

14.✨Image Captioning & Attention

Image Captioning, Attention

15.✨Visualizing & Understanding

Visualizing

16.✨GAN (1)

Supervised Learning, Unsupervised Learning, Generative Model

17.✨GAN (2)

Generative Adversarial Networks

18.✨GAN (3)

Applications of GANs