8-7 survey

DUS(Depth-Up-Scaling) Mistral 7B 모델을 베이스로 해서 복사해서 2개의 모델 만듬 각 위 8개, 아래 8개 layer 제거하고 합쳐서 48 layer 만듬 그러면 10.7B지만 성능이 떨어져서 다시 pretraing -> instruction

[논문리뷰] Mistral 7B

Mistral 7B은 Llama2(13B)보다 모든 평가 벤치마크에서 능가했고 Llama1(34B)보다 reasoning, mathmatics, code generation 부분에서 능가더 빠른 추론을 위해 grouped-guery attention(GQA)릃 활용하고

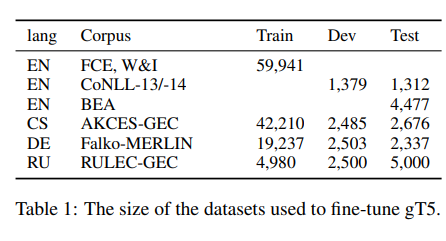

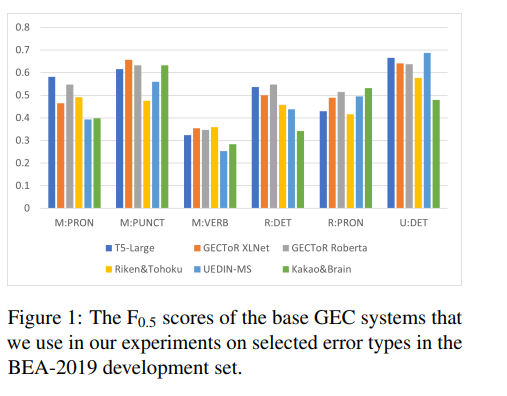

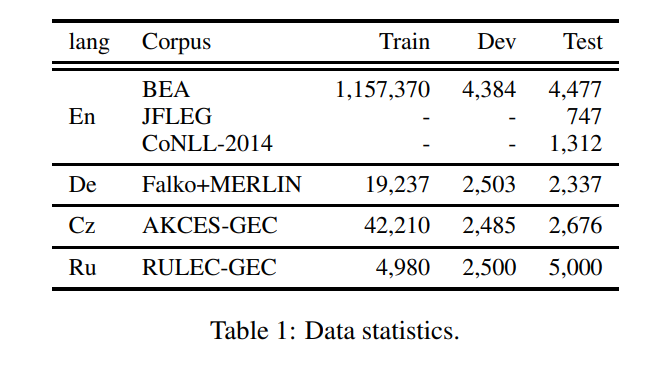

[논문 제목] Frustratingly Easy System Combination for Grammatical Error Correction

문법 오류 수정(GEC)를 위한 시스템 조합을 간단한 이진 분류로 공식화간단한 로지스틱 회귀 알고리즘이 GEC 모델을 결합하는 데 매우 효과적CoNLL-2014 tast에서 가장 높은 기본 GEC 시스템의 F0.5 점수를 4.2점 BEA-2019 test에서 7.2점

The Past Mistake is the Future Wisdom: Error-driven Contrastive Probability Optimization for Chinese Spell Checking

Abstract PLM에 대한 학습된 지식과 CSC 작업의 목표 사이에는 격차가 있음 PLM은 텍스트의 의미론에 초점을 맞추고 잘못된 문자르 의미론적으로 적절하거나 일반적으로 사용되는 문자로 수정하는 경향이 있지만, 이는 실제 수정이 아님 이 문제를 해결하기 위해 C

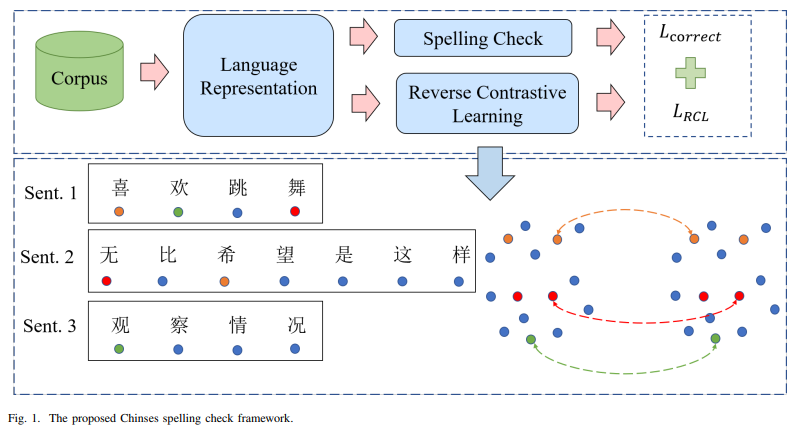

[논문 리뷰] A Chinese Spelling Check Framework Based on Reverse Contrastive Learning

기존 연구는 text representation을 향상시키고 multi-source 정보를 사용하여 모델의 detection과 correction의 성능을 향상시키는 것을 목표로 하지만 혼동하기 쉬운 단어를 구별하는 능력을 향상시키는 데 크게 attention X유사한

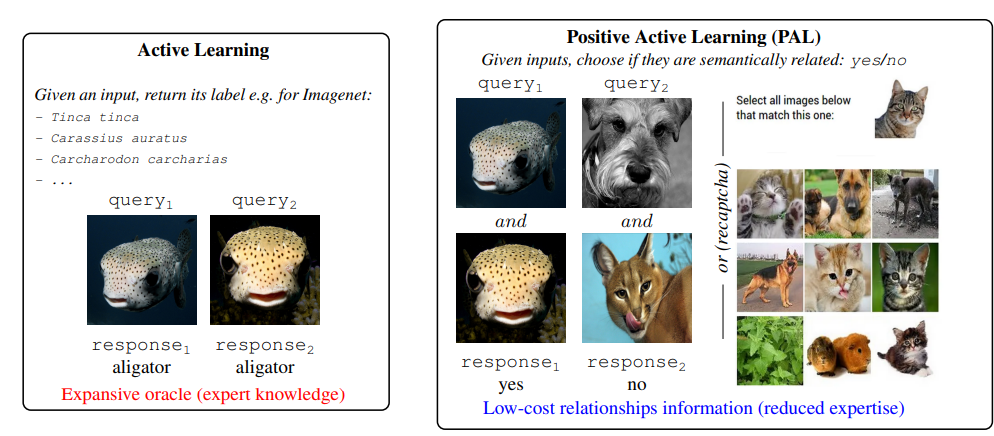

[논문리뷰] Active Self-Supervised Learning: A Few Low-Cost Relationships Are All You Need

Self-Supervised Learning(SSL)은 레이블이 없는 데이터에서 transfer 가능한 representation을 학습하기 위한 선택 솔루션으로 떠오름하지만 SSL은 의미론적으로 유사한 샘플(positive views)을 구축해야 함이러한 지식이 필

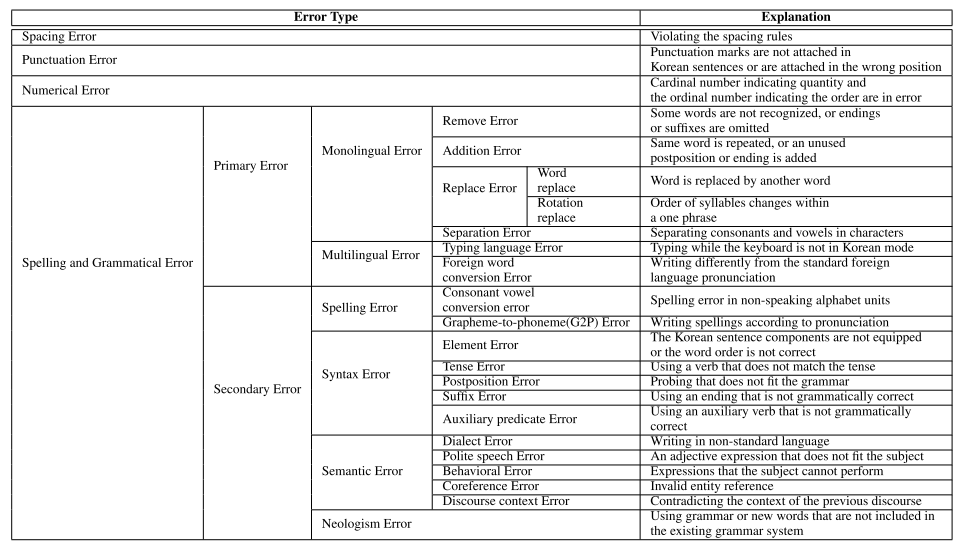

[논문 리뷰]K-NCT: Korean Neural Grammatical Error Correction Gold-Standard Test Set Using Novel Error Type Classification Criteria

맞춤법 데이터셋

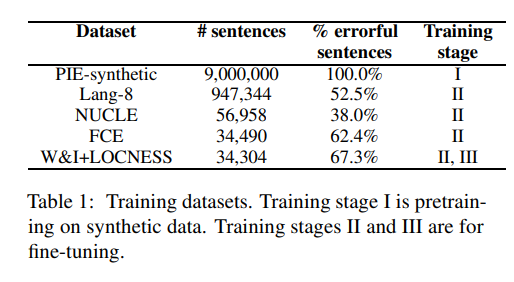

[논문 리뷰] Stronger Baselines for Grammatical Error Correction Using a Pretrained Encoder-Decoder Model

BART 파인 튜닝한 논문

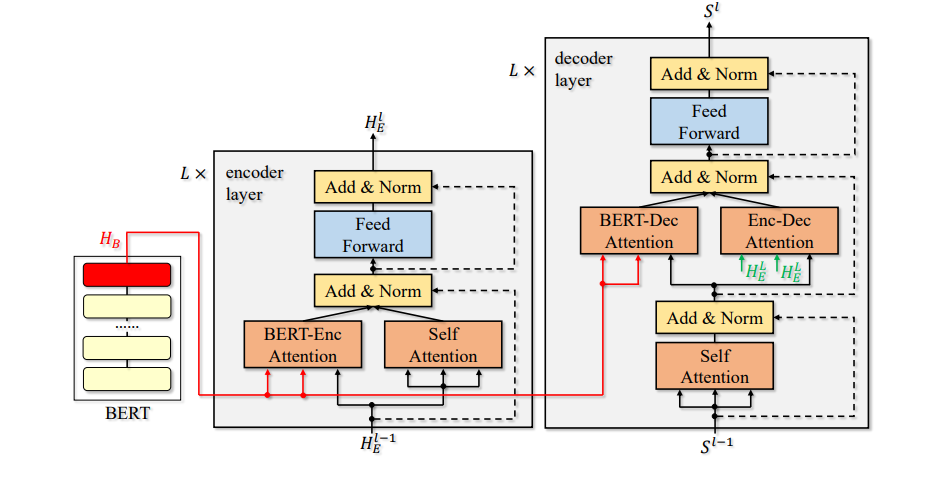

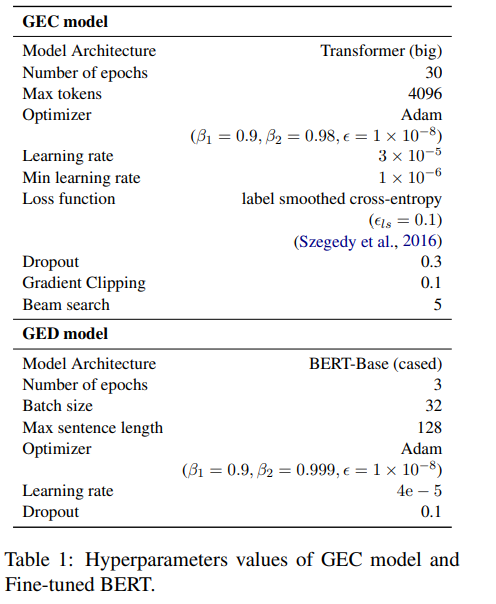

[논문 리뷰]Encoder-Decoder Models Can Benefit from Pre-trained Masked Language Models in Grammatical Error Correction

BERT-fuse mask, GED

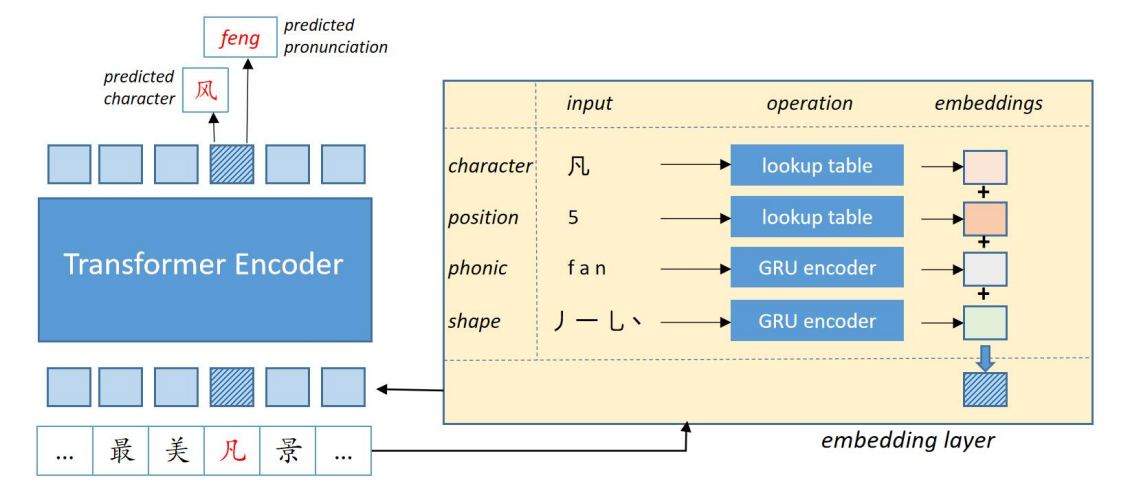

[논문리뷰] Correcting Chinese Spelling Errors with Phonetic Pre-training

음성 정보 이용한 BERT

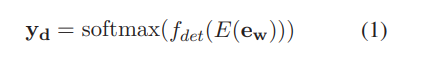

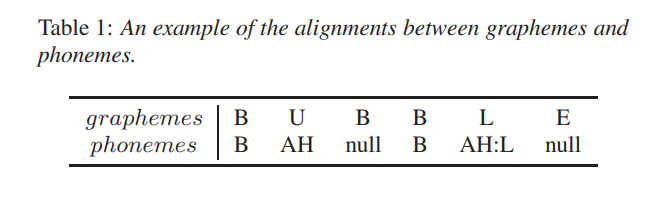

[논문리뷰]Token-Level Ensemble Distillation for Grapheme-to-Phoneme Conversion

MS token-level ensembel distillation

[논문리뷰] Results of the Second SIGMORPHON Shared Task on Multilingual Grapheme-to-Phoneme Conversion

SIGMORPHON 2021 G2P

[논문 리뷰] Neural Grapheme-to-Phoneme Conversion with Pre-trained Grapheme Models

BERT를 이용한 G2P

[논문리뷰]Ensemble Self-Training for Low-Resource Languages: Grapheme-to-Phoneme Conversion and Morphological Inflection

우리는 최적의 앙상블을 학습하고 검색하는 반복적인 데이터 증강 프레임워크를 제시하고, 동시에 self-training 스타일로 새로운 학습 데이터에 주석을 달았음이 프레임워크를 두 개의 SIGMORPON 2020 shared task에 족용: G2P변환과 morphol

[논문리뷰]DeepSPIN at SIGMORPHON 2020: One-Size-Fits-All Multilingual Models

SIGMORPHON2020의 한국어 성능이 제일 좋은 DeepSPIN 리뷰