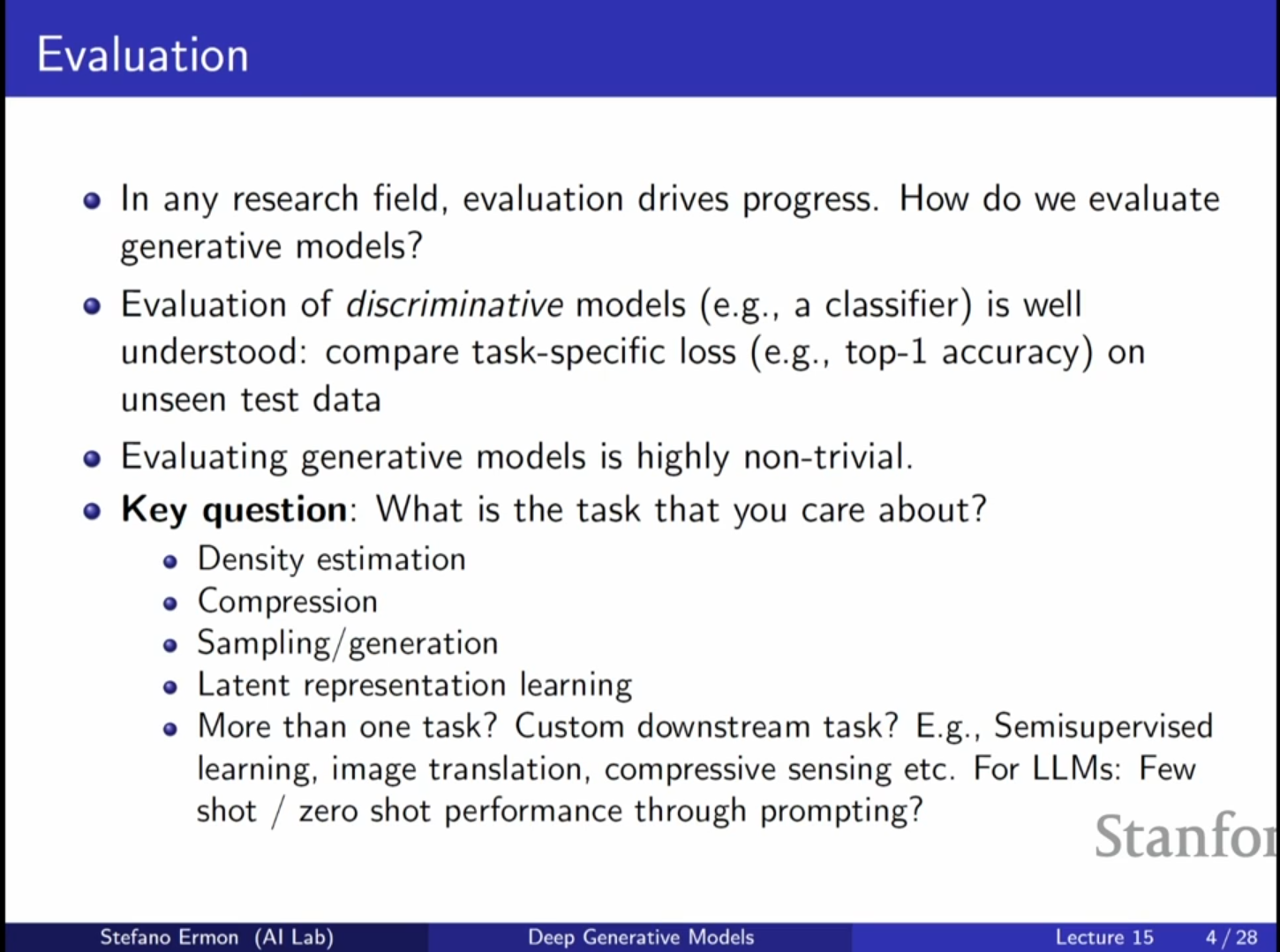

[CV] CS236 15강 정리 [Evaluation of Generative Models]

생성 모델(Generative Models)의 평가는 매우 까다로운 주제이며, 현재까지 완벽한 합의(Consensus)가 이루어지지 않은 분야입니다. 모델링 방법론(Autoregressive, Flow, VAE, GAN, Score-based 등)과 훈련 목적함수(KL

[CV] CS236 14강 정리 [Energy Based Models]

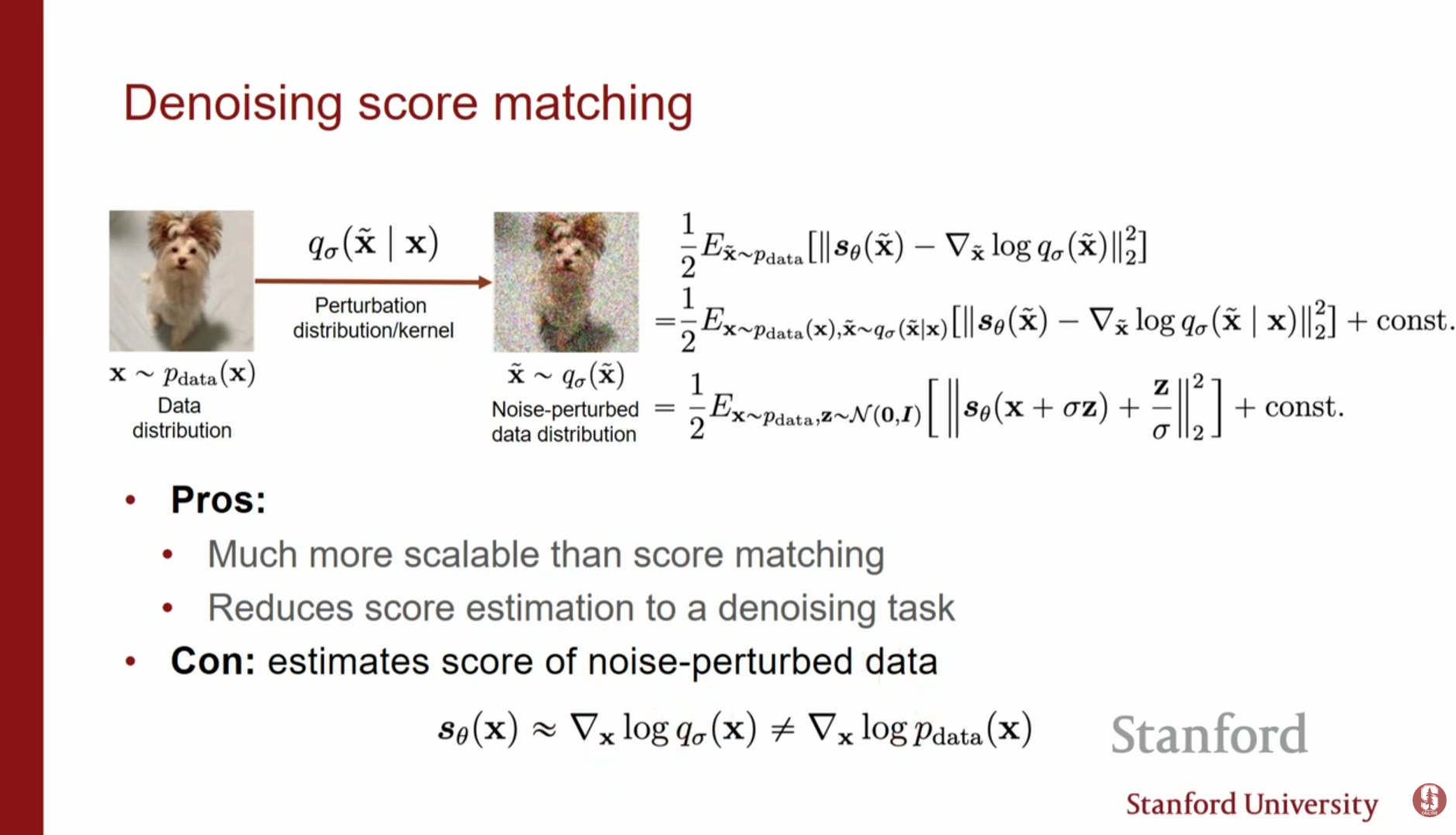

지난 강의에 이어 스코어 기반 모델(Score-based Models)에 대한 논의를 심화합니다. 스코어 모델은 신경망을 통해 데이터 분포의 로그 우도 그라디언트(Vector Field, $\\nabla_x \\log p(x)$)를 학습하는 것을 목표로 합니다. 그러나

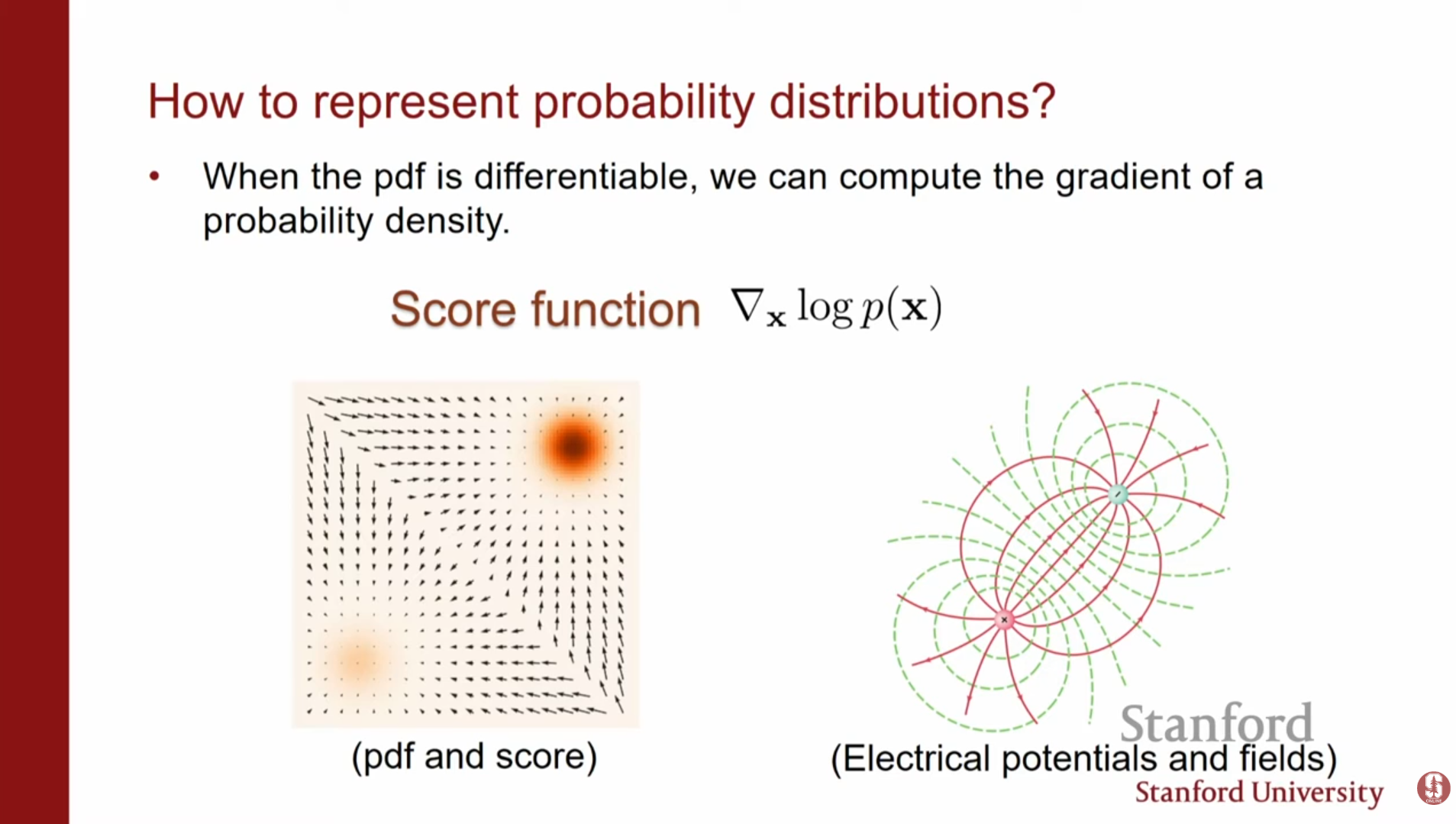

[CV] CS236 13강 정리 [Score Based Models]

강의 초반부에서는 지금까지 다룬 생성 모델들의 장단점을 복습하며 스코어 기반 모델의 필요성을 설명합니다.우도 기반 모델(Likelihood-based models): Autoregressive 모델이나 Flow 모델 등은 확률 밀도 함수(PDF)를 직접 모델링합니다.

[AI] EM 알고리즘 & 최대우도추정 & 베이즈 추정 개념 정리

머신러닝/딥러닝 논문을 읽다 보면EM 알고리즘, 최대우도추정(MLE), 베이즈 추정이 자주 같이 나온다.겉보기엔 서로 다른 개념처럼 보이지만, 실제로는MLE는 “학습 목표”EM은 “그 목표를 풀기 위한 방법”베이즈는 “학습을 바라보는 더 큰 관점(불확실성 포함)”으로

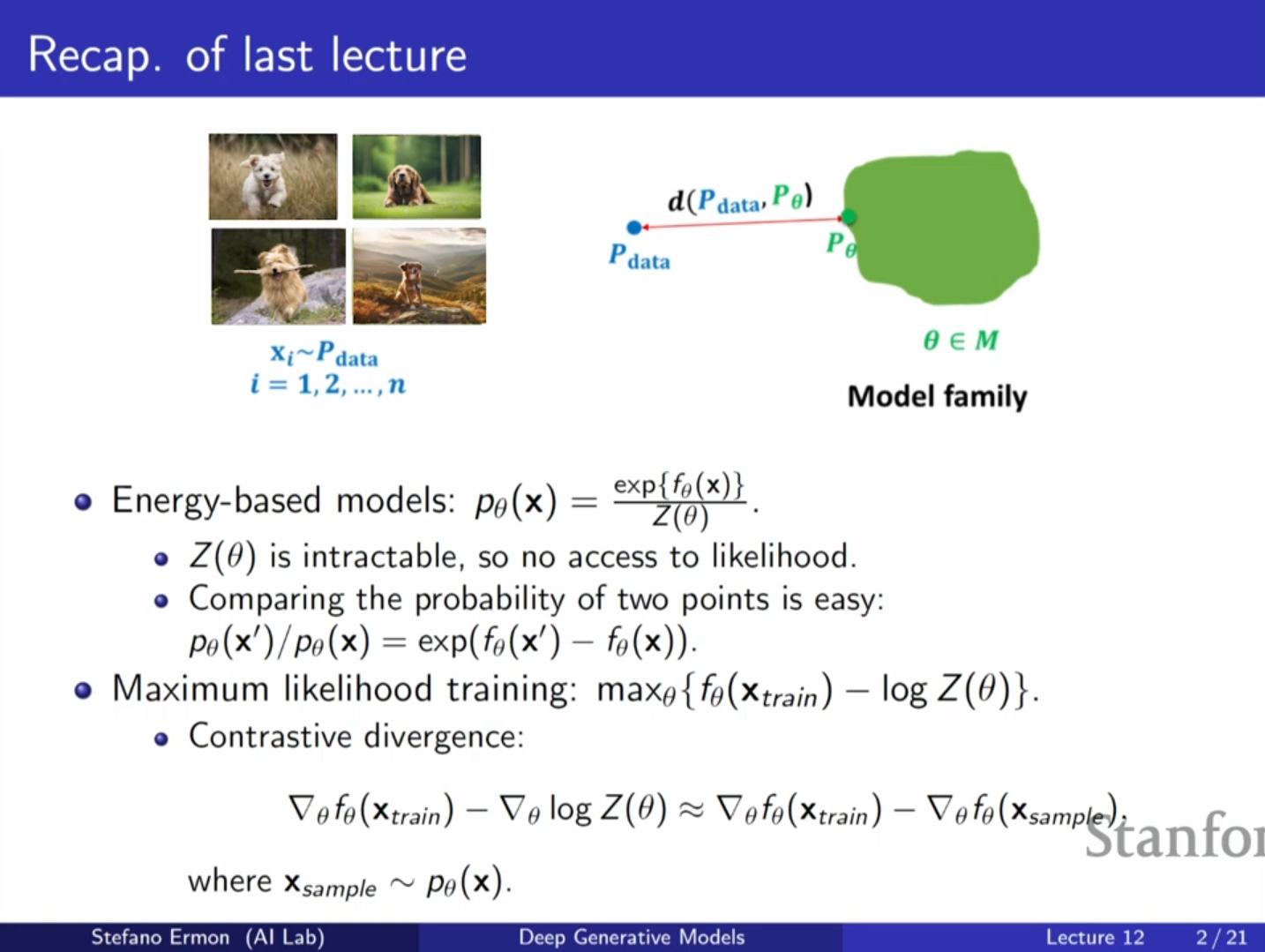

[CV] CS236 12강 정리 [Energy Based Models]

에너지 기반 모델은 정규화되지 않은 확률 분포(unnormalized probability distribution)를 정의하는 매우 유연한 방법입니다.

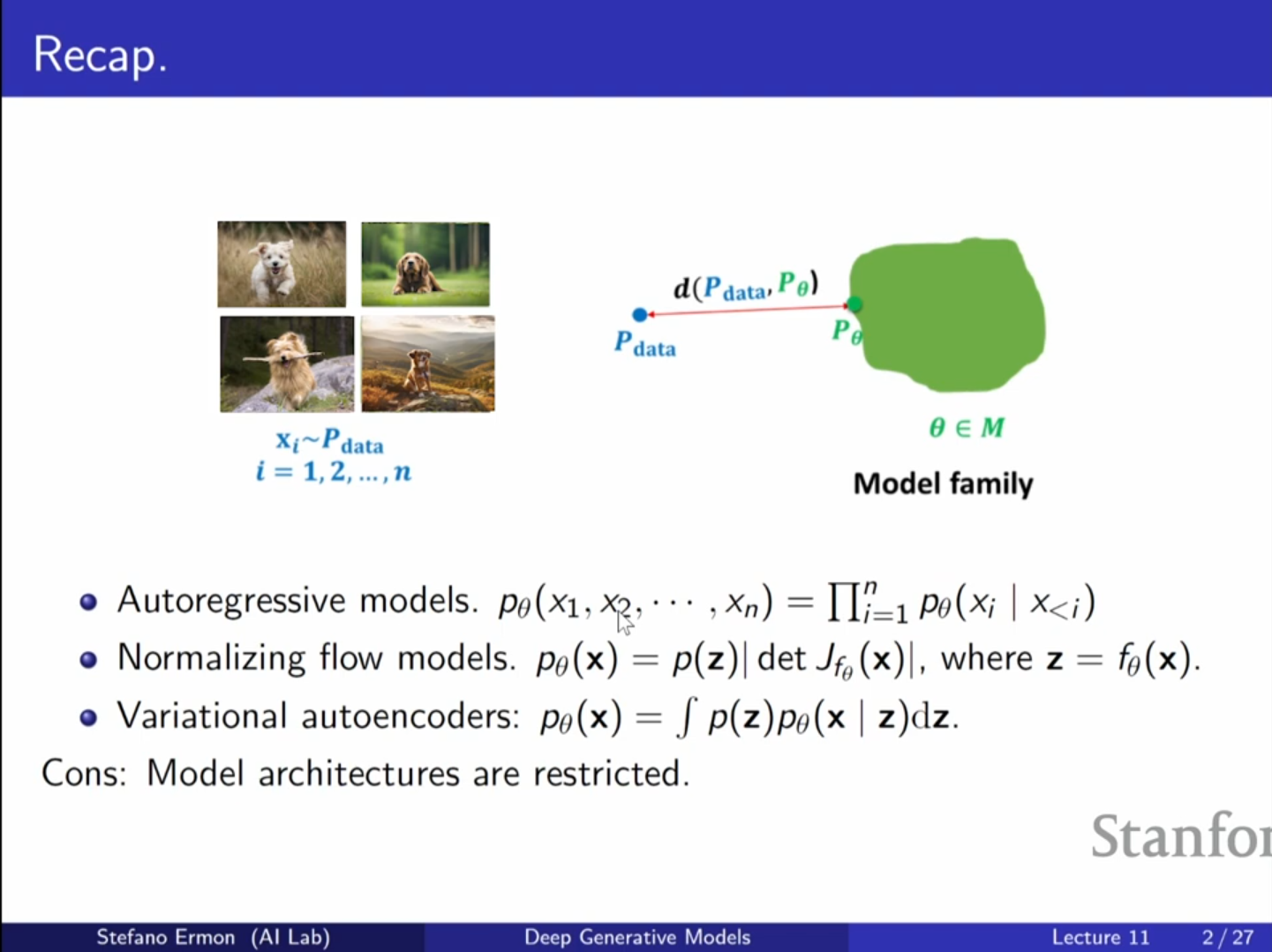

[CV] CS236 11강 정리 [Energy Based Models]

오늘 강의에서는 에너지 기반 모델(Energy Based Models, EBM)에 대해 다룹니다. 이는 확산 모델(Diffusion Models)과 밀접하게 관련된 생성 모델의 한 종류입니다.생성 모델을 구축할 때 우리는 알려지지 않은 데이터 분포에서 온 데이터를 가지

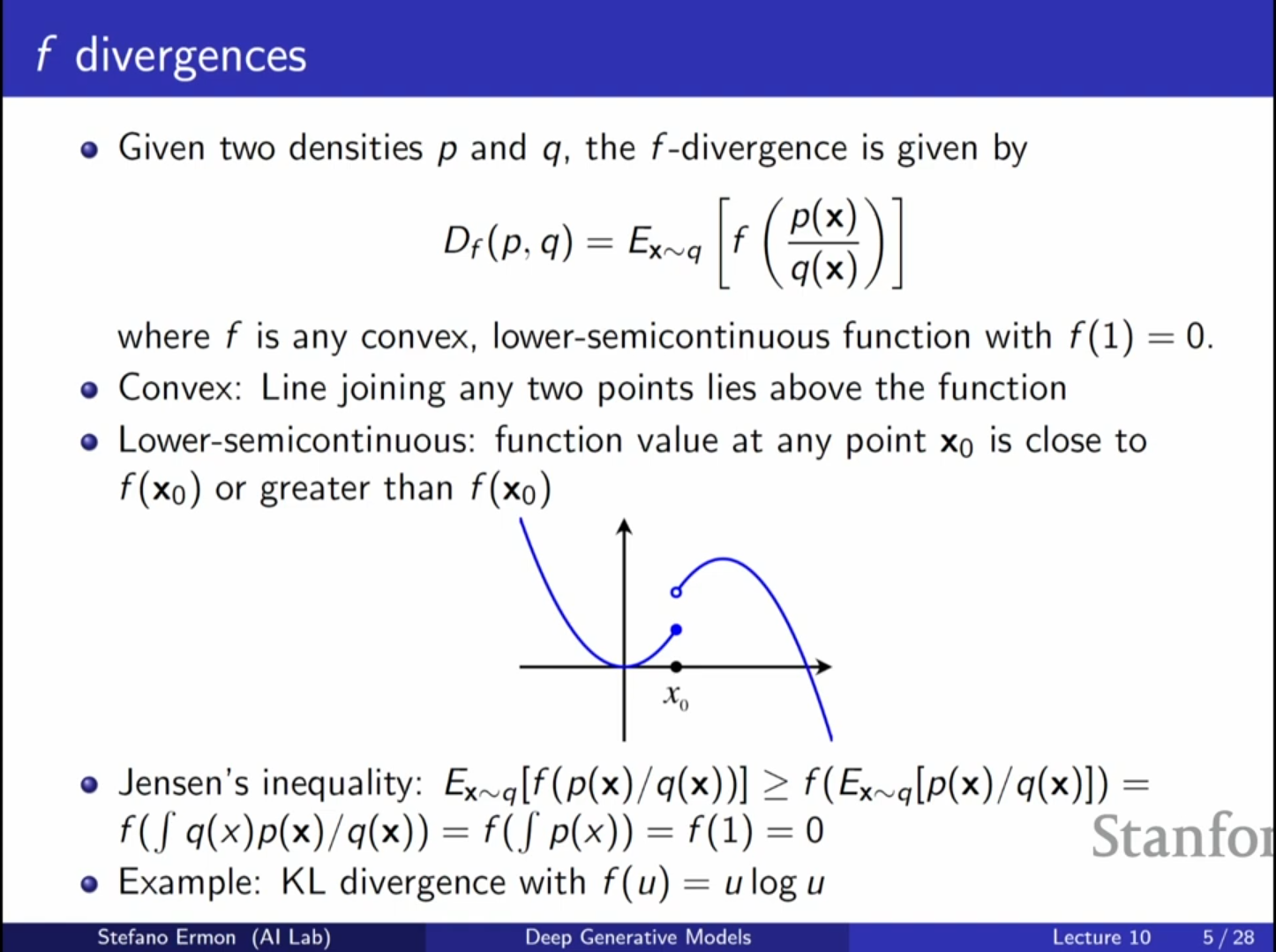

[CV] CS236 10강 정리 [GANs]

Likelihood-free 학습: 생성적 적대 신경망(GAN)의 가장 큰 장점은 모델의 확률 밀도 함수를 명시적으로 정의하거나 연쇄 법칙(chain rule)에 따라 분해할 필요 없이, 우도(Likelihood)를 계산하지 않고도 모델을 학습시킬 수 있다는 점입니다.

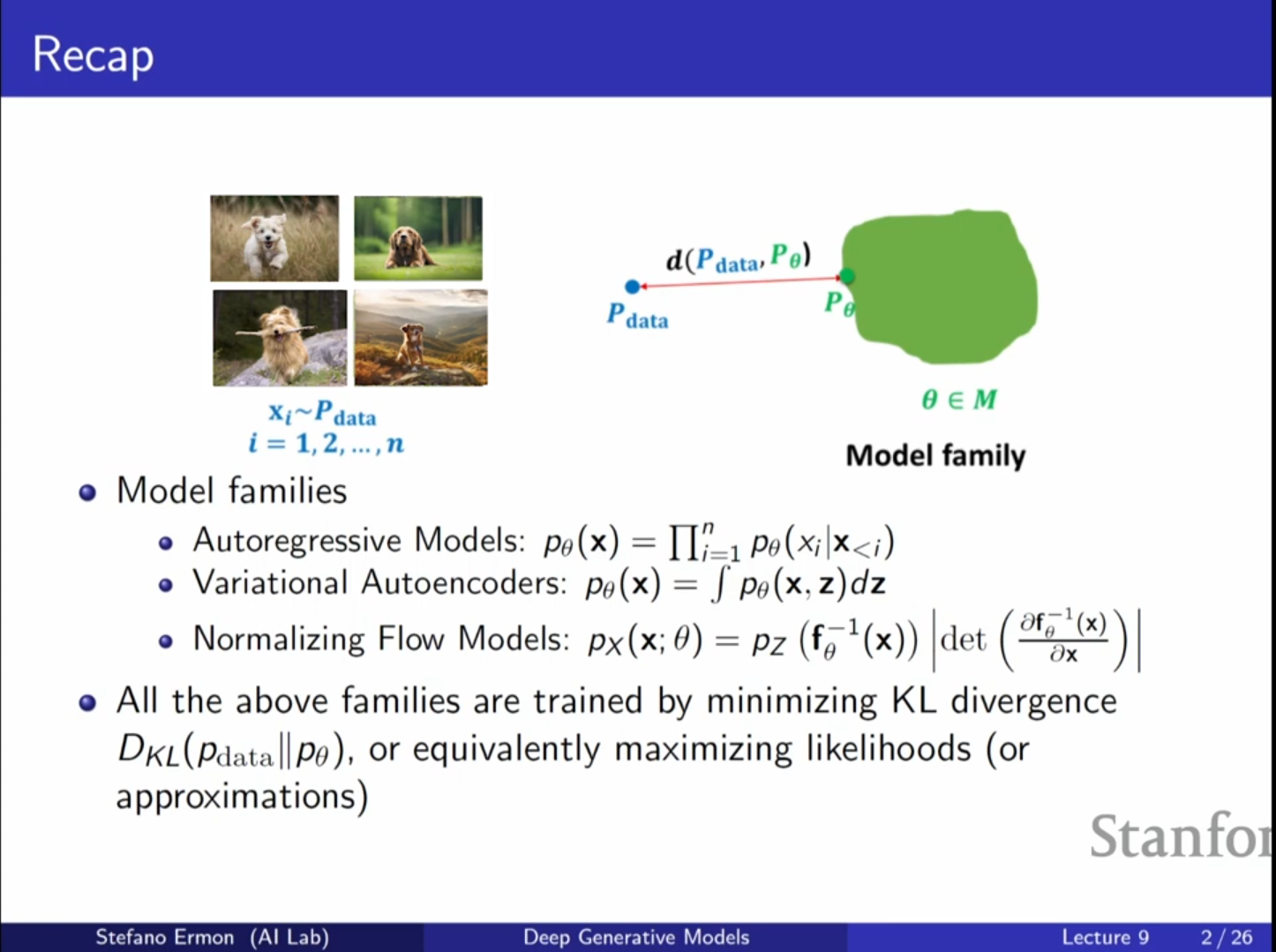

[CV] CS236 9강 정리 [GANs]

지금까지 다룬 모델들(Autoregressive Model, VAE, Normalizing Flow)은 모두 최대 우도(Maximum Likelihood) 학습을 기반으로 했습니다.이들은 데이터 분포($P{data}$)와 모델 분포($P{\\theta}$) 사이의 KL

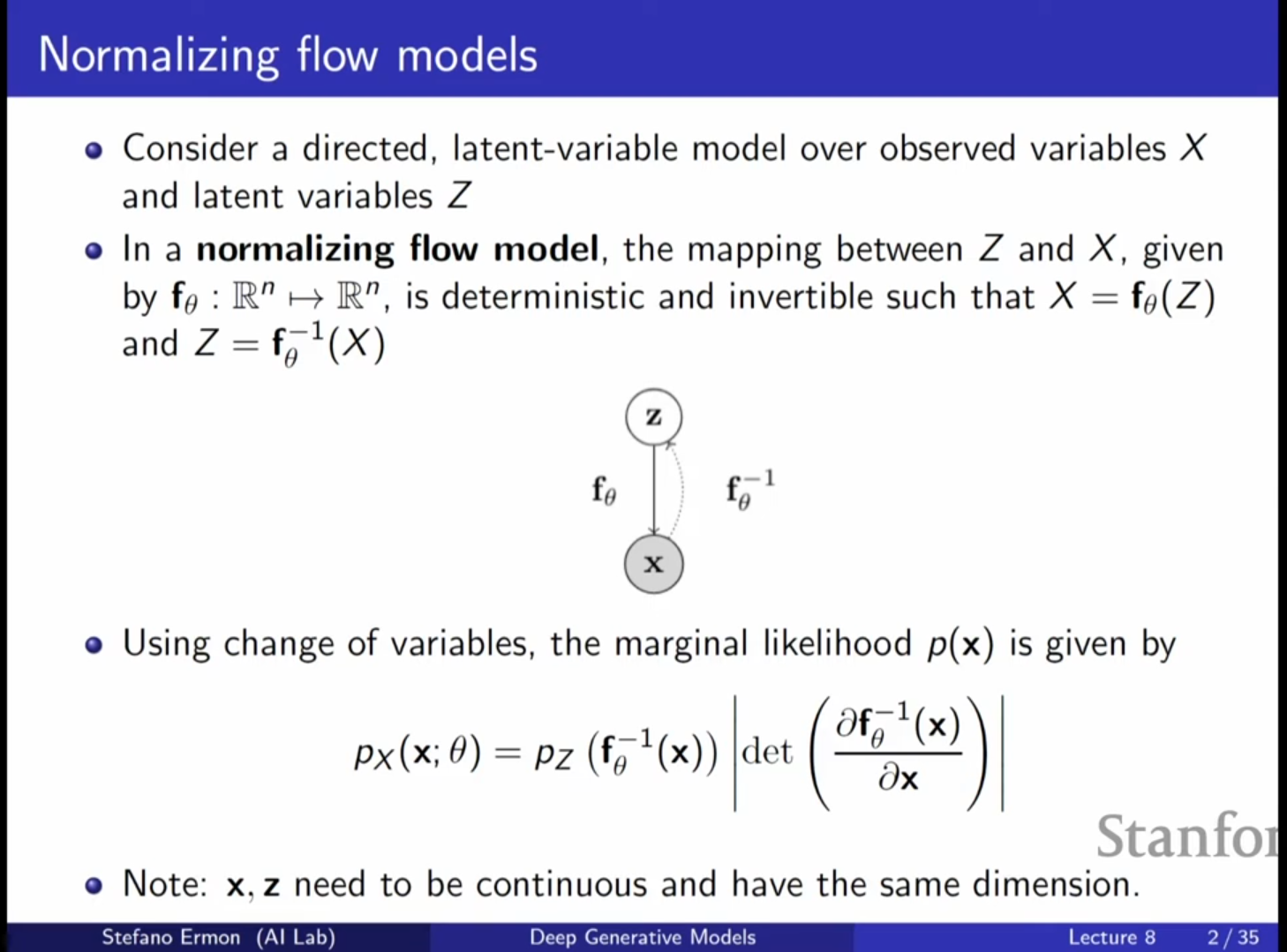

[CV] CS236 8강 정리 [Normalizing Flows]

Normalizing Flow 모델은 잠재 변수(Latent Variable) 모델의 일종으로, 가변 추론(Variational Inference)에 의존하지 않고 정확한 우도(Exact Likelihood)를 계산할 수 있다는 장점이 있습니다.VAE(Variation

[CV] CS236 7강 정리 [Normalizing Flows]

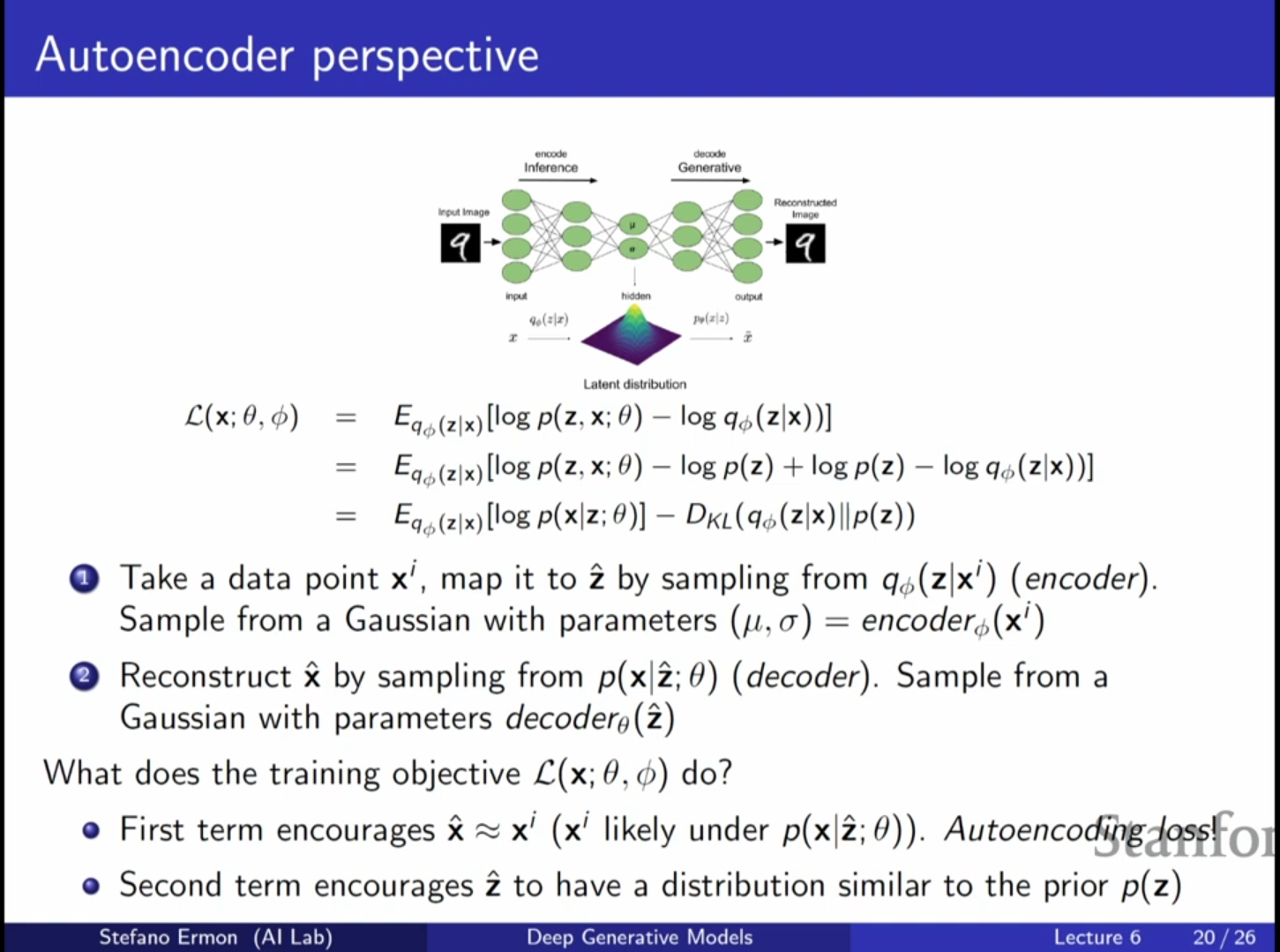

VAE의 훈련 목표와 오토인코더의 관계: 지난 강의에 이어 변분 오토인코더(VAE)를 오토인코더(Autoencoder)의 관점에서 해석하는 것으로 강의를 시작합니다. VAE의 목적 함수인 ELBO(Evidence Lower Bound)는 두 부분으로 나눌 수 있으며,

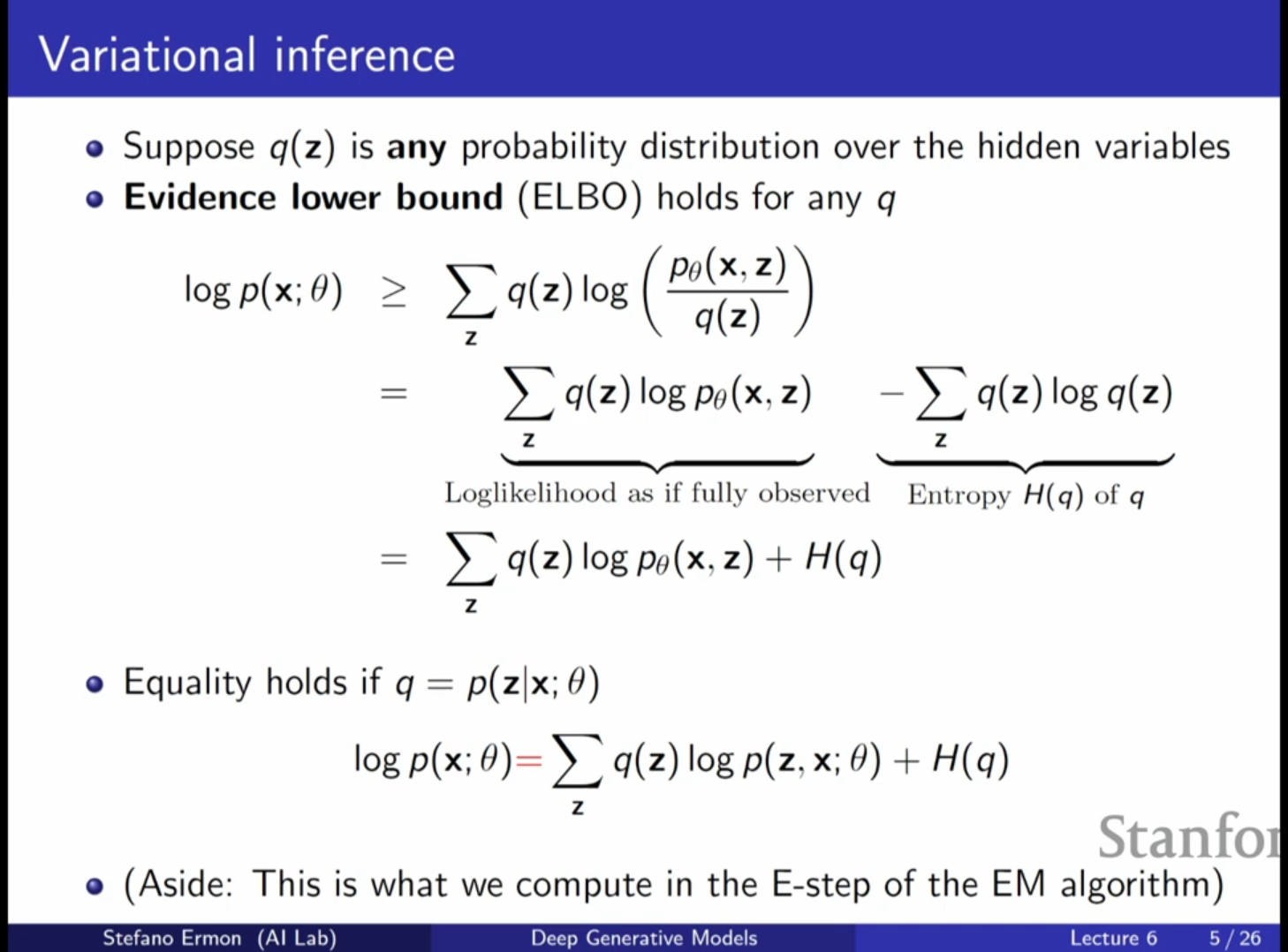

[CV] CS236 6강 정리 [VAEs]

VAE의 정의: 단순한 잠재 변수(Latent Variable) 모델을 신경망을 통해 매우 유연한 생성 모델로 확장한 형태예요.데이터 생성 프로세스:잠재 변수 $Z$ 샘플링: 단순한 분포(예: 평균이 0이고 공분산이 단위 행렬인 다변량 가우시안 분포, $P(Z)$)에서

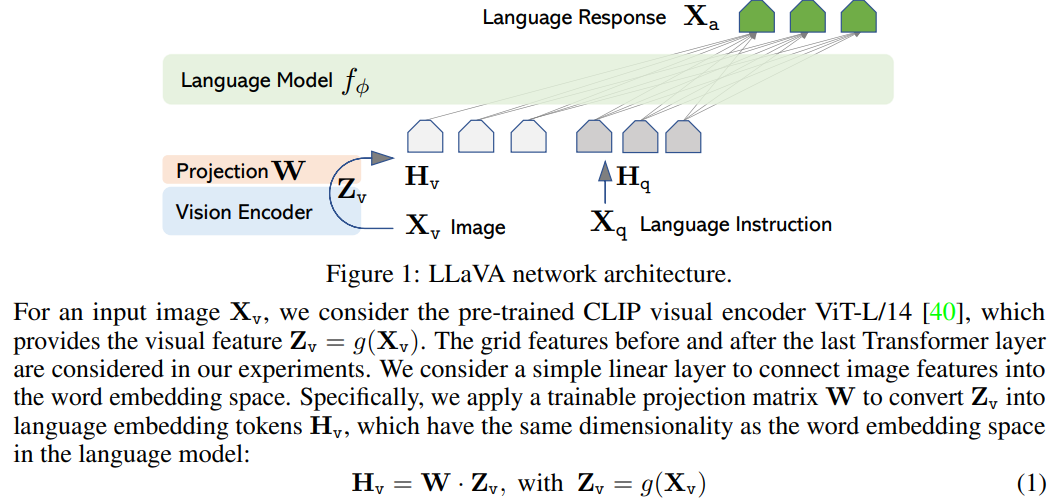

[논문 리뷰] Visual Instruction Tuning

제목: Visual Instruction Tuning저자: Haotian Liu et al. (UW–Madison, Microsoft Research)형식: 학술 논문 (NeurIPS 2023)발행: 2023 (arXiv)LLaVA는 이미지 인코더가 생성한 시각적 표현

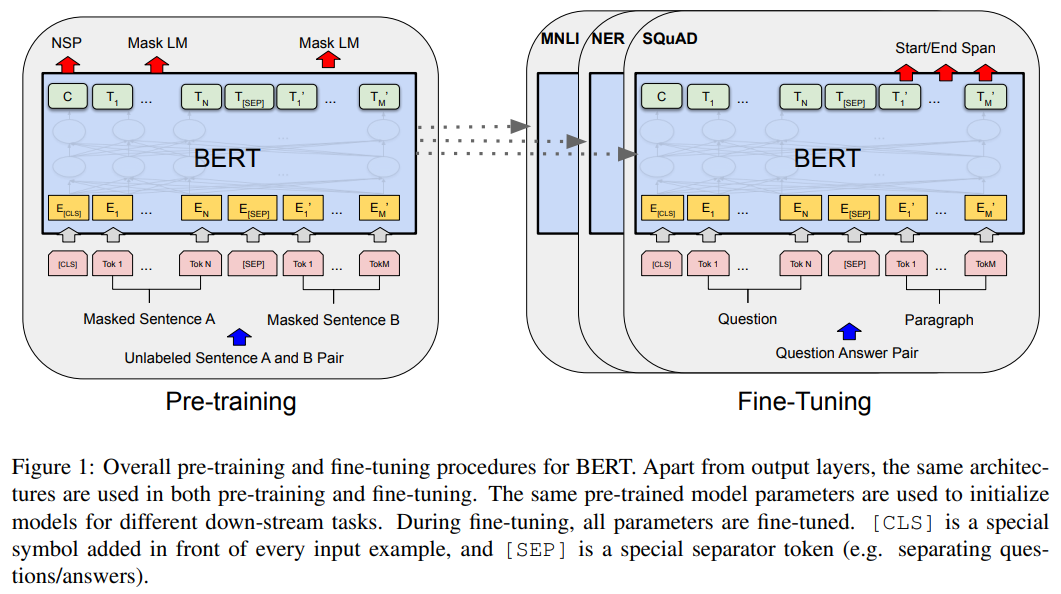

[논문 리뷰] BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

제목: BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding저자: Jacob Devlin et al. (Google AI Language)형식: 학술 논문 (NAACL 2019)

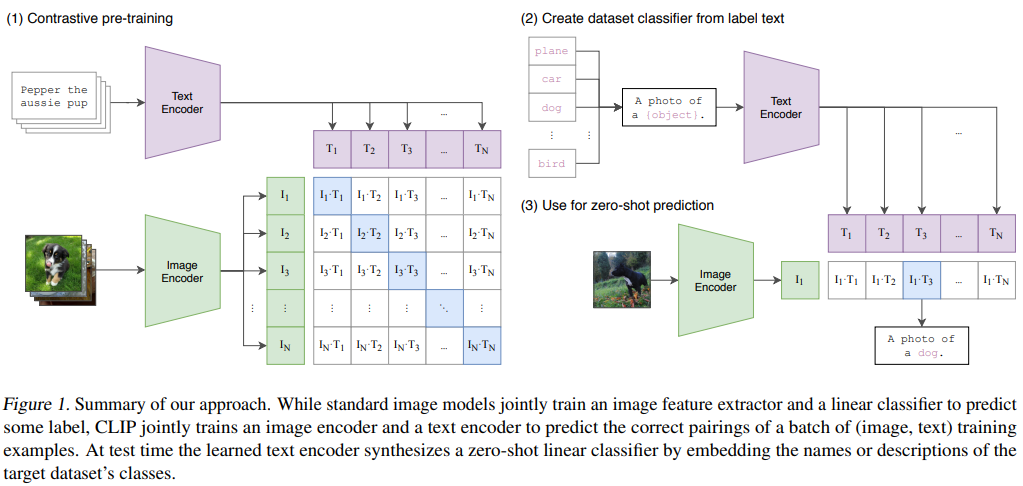

[논문 리뷰] Learning Transferable Visual Models From Natural Language Supervision

제목: Learning Transferable Visual Models From Natural Language Supervision저자: Alec Radford et al. (OpenAI)형식: 학술 논문발행: 2021 (ICML)CLIP은 이미지와 자연어를 동일한 임

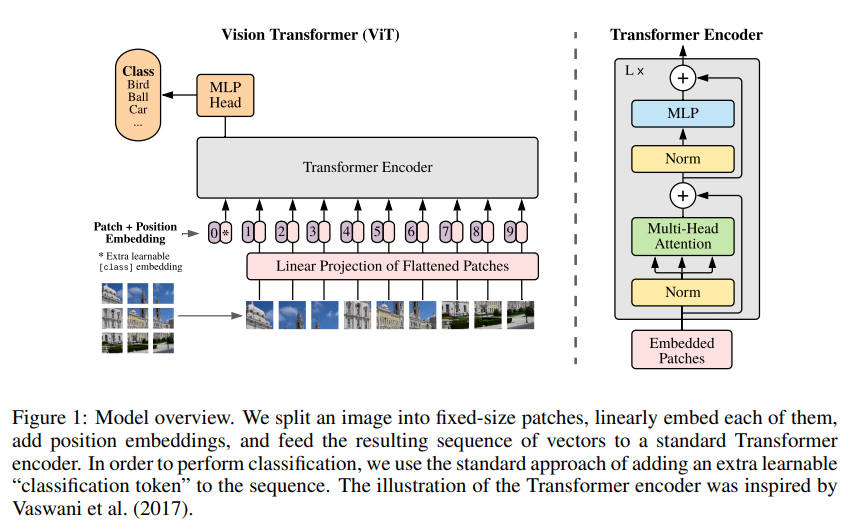

[논문 리뷰] An Image Is Worth 16×16 Words: Transformers for Image Recognition at Scale

제목: An Image is Worth 16×16 Words: Transformers for Image Recognition at Scale저자: Alexey Dosovitskiy et al. (Google Research)형식: 학술 논문 (ICLR 2021)발행:

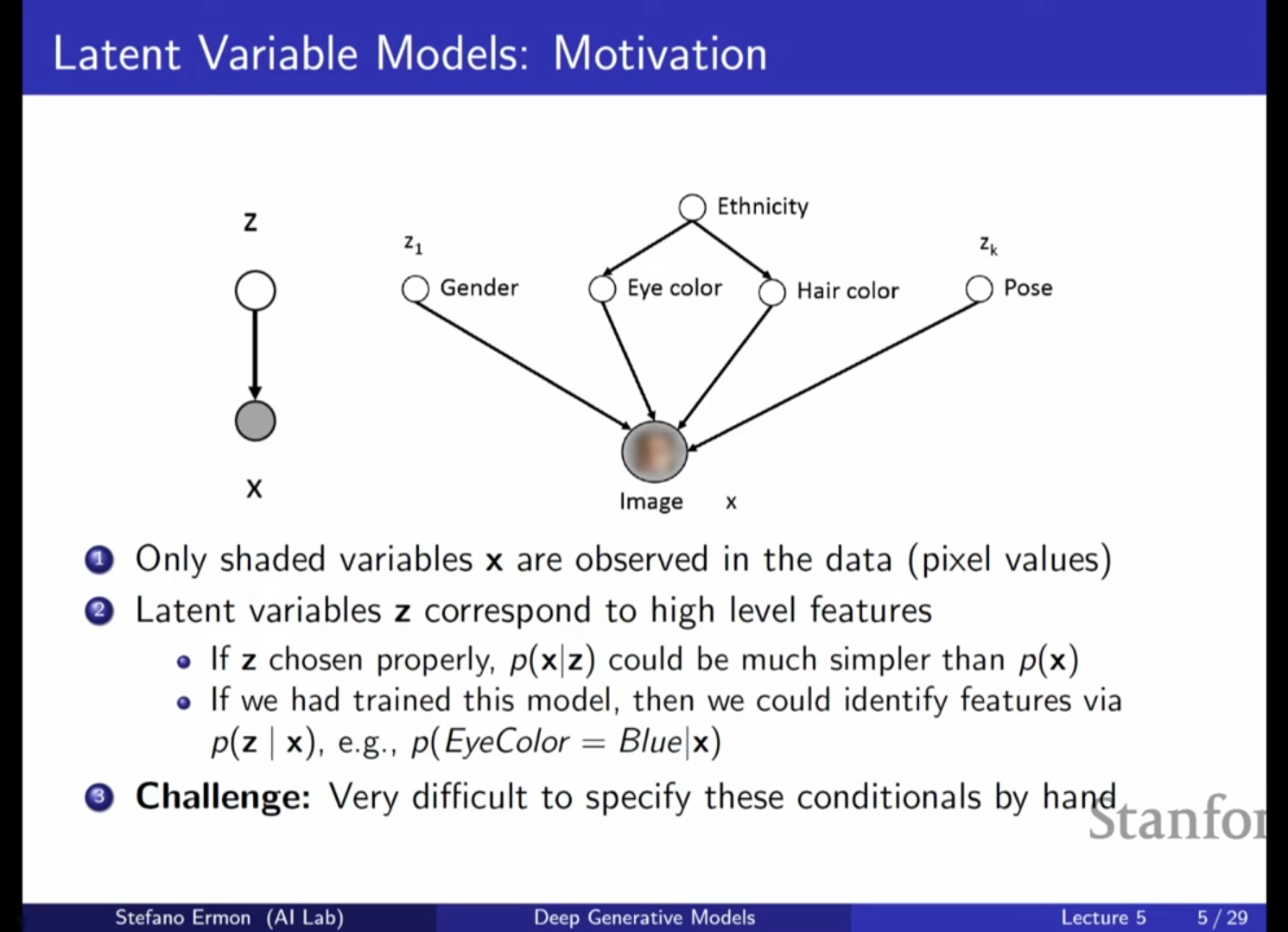

[CV] CS236 5강 정리 [VAEs]

지난 시간에는 자기회귀 모델(Auto-regressive models)에 대해 배웠습니다. 이 모델들은 연쇄 법칙(Chain rule)을 사용해 결합 확률 분포를 조건부 확률의 곱으로 근사하며, RNN, CNN, 트랜스포머 등을 활용해 우도(Likelihood)에 직접

[CV] CS236 4강 정리 [Maximum Likelihood Learning]

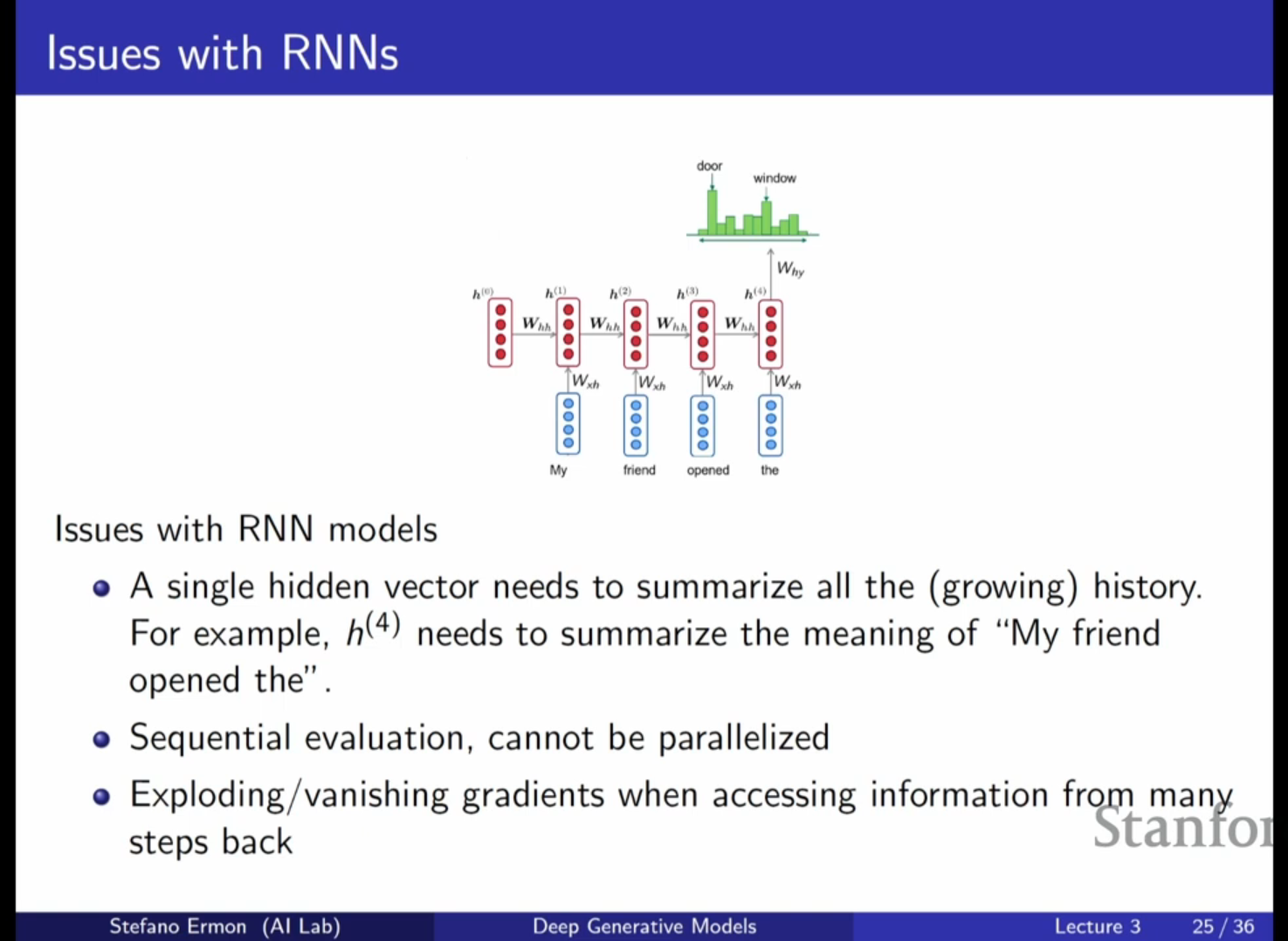

RNN 기반 자기회귀 모델의 특징: 지난 시간에 다룬 RNN은 시퀀스의 길이에 상관없이 고정된 수의 파라미터를 사용하여 이전의 문맥(Context)을 추적합니다. RNN은 이전까지 본 정보를 하나의 은닉 벡터(Hidden Vector, $h$)에 요약하여 다음 토큰이나

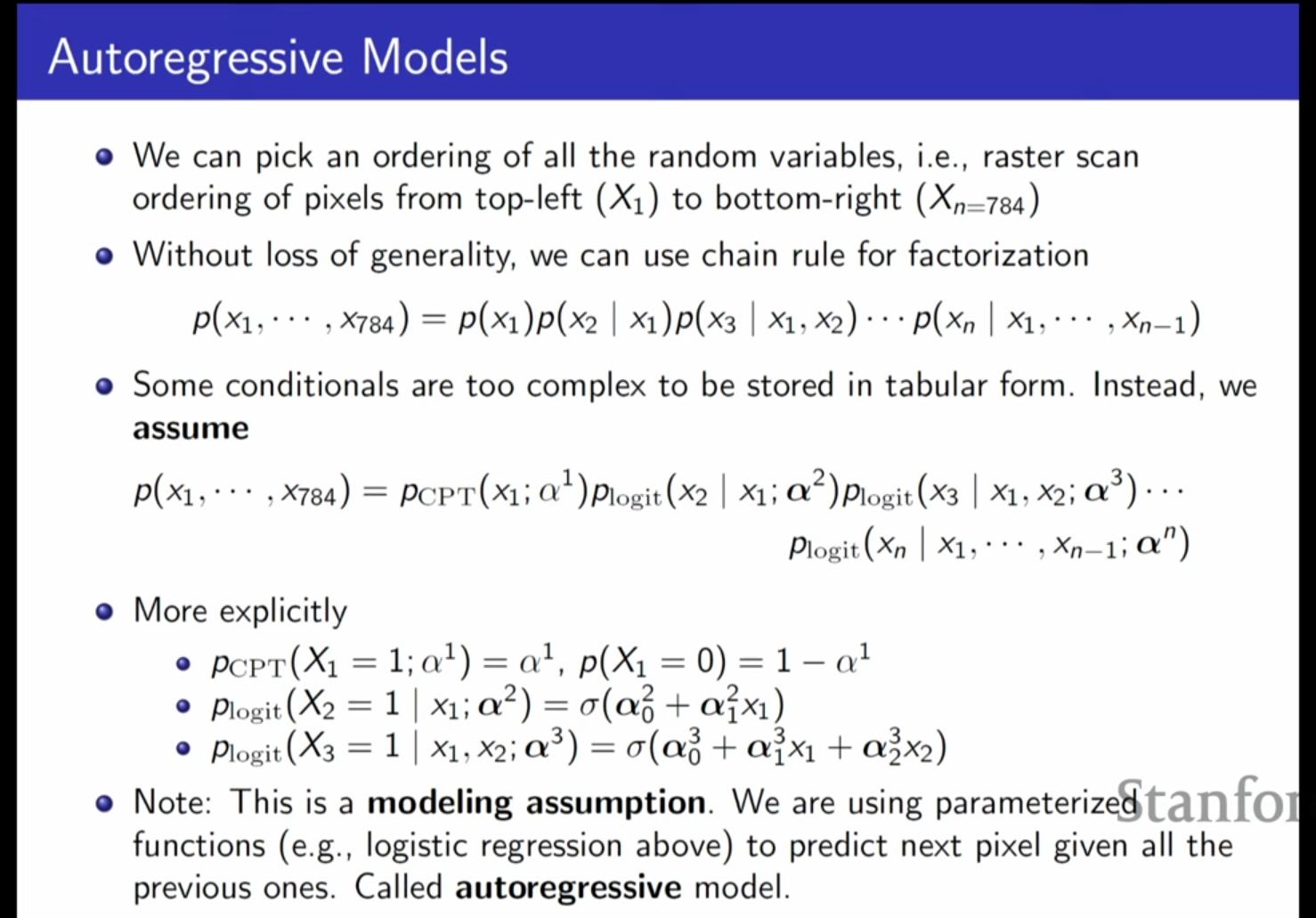

[CV] CS236 3강 정리 [Autoregressive Models]

생성 모델을 학습시키기 위해서는 데이터(IID 샘플)와 모델 패밀리, 그리고 데이터 분포와 모델 분포 사이의 유사성 또는 발산(Divergence)을 정의하는 과정이 필요합니다. 자기회귀 모델(Autoregressive Models)은 이러한 생성 모델의 한 종류로,

[CV] CS236 2강 정리 [Background]

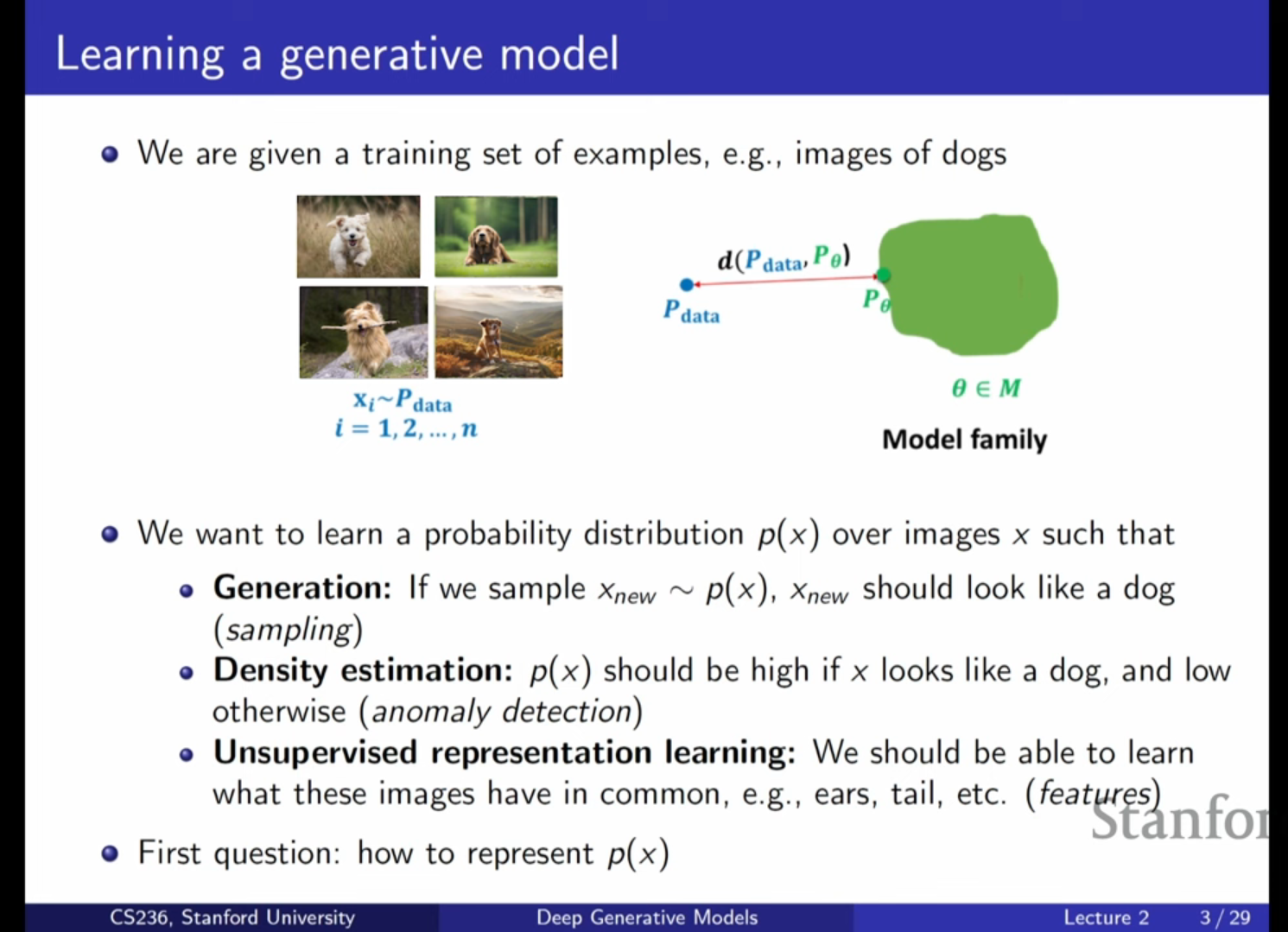

생성 모델(Generative Model)이란 복잡한 데이터셋(이미지, 텍스트 등)의 기본이 되는 확률 분포를 학습하는 모델을 의미합니다.우리가 다루는 데이터 포인트들은 알 수 없는 실제 확률 분포($P\_{data}$)로부터 샘플링되었다고 가정합니다.생성 모델링의 핵

[CV] CS236 1강 정리 [Introduction]

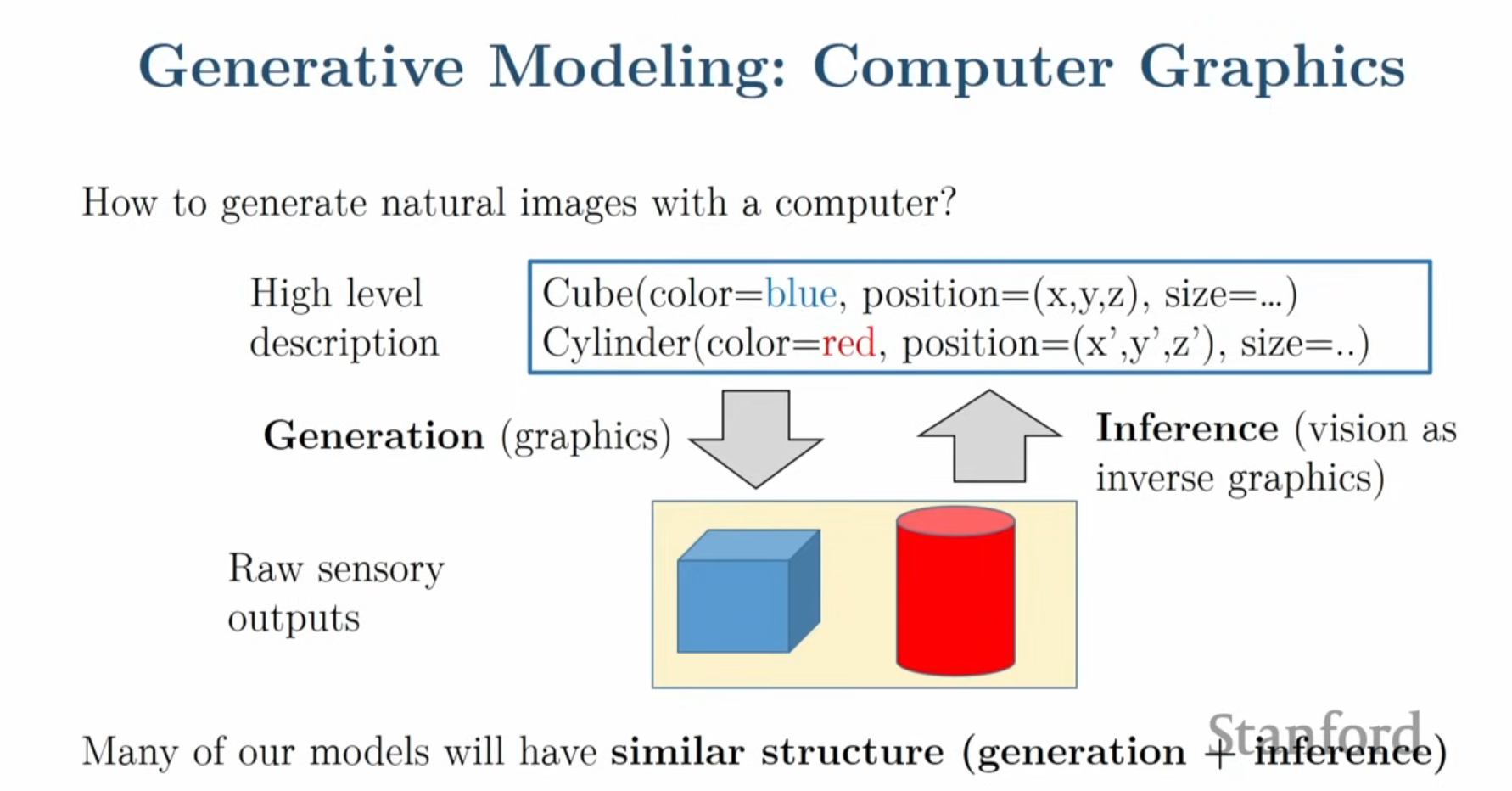

고차원 신호의 이해: 컴퓨터 비전, NLP, 음성 인식 등 AI의 다양한 분야에서 직면하는 근본적인 과제는 이미지, 오디오, 텍스트와 같은 복잡한 고차원 신호(High-dimensional signal)를 처리하는 것입니다.데이터의 표현: 컴퓨터 입장에서 이미지는 단순