NaverBoostCamp

1.MRC(1) : Embedding

기계독해 프로젝트 강의 학습정리

2.MRC(2) : MRC의 이해

MRC의 개념과 MRC 데이터셋 및 Task들에 대해 정리하였습니다.

3.MRC(3) : 유니코드 & Tokenization

유니코드, Tokenization(BPE), KorQuAD 상세사항

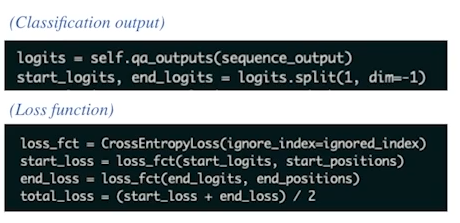

4.MRC(4) : Extraction based MRC 개요

Extractation-based 기계독해 학습 개요

5.MRC(5) : Generation-based MRC, BART, T5

Extraction이 아닌 Generation-based MRC에 대하여...

6.MRC(6) : Retrieval

Retrieval,,, MRC 이전에 문서를 파싱해보자 !

7.MRC(7) : Retrieval - Dense Embedding

Dense Embedding을 활용한 문서 검색,,, Retrieval?? 리트리버 ! ㅎㅎ ;;

8.MRC(8) : FAISS

FAISS를 활용한 문서검색

9.MRC(9) : ODQA

Open-Domain Question Answering 관련 이슈 및 성능 향상 방안

10.MRC(10) : ODQA와 bias

ODQA에서의 Bias 다루기

11.MRC(11) : Closed-book QA

Closed-book QA

12.MRC(12) : Dense-Sparse Phrase

더 효율적인 문서검색 및 MRC

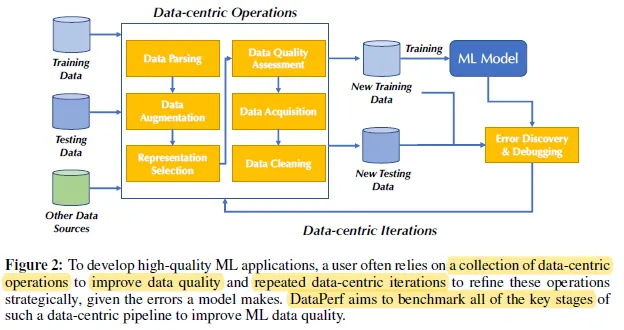

13.Data-Centric(1): 개요

Data-Centric 강의 개요

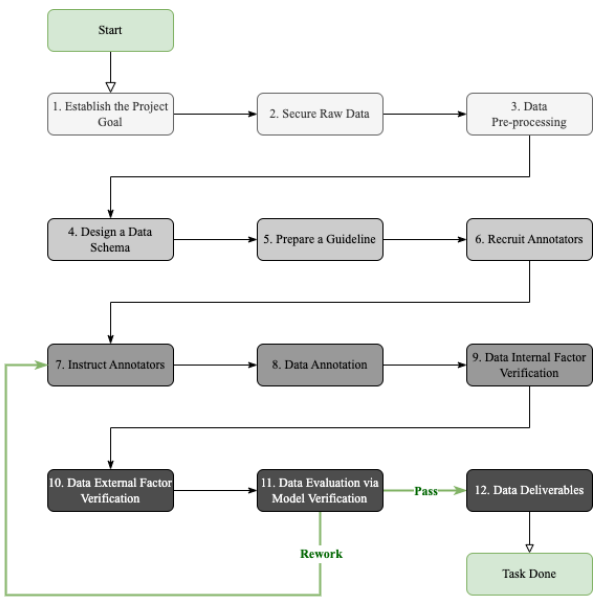

14.Data-Centric(2): 개요

DMOps

15.Data-Centric(3): Data Management

DMOps

16.Data-Centric(4): NLP 데이터 소개

NLP 데이터에 관하여...

17.Data-Centric(5): NLP 분야의 특이한 Data

NLP 분야 특이 Task 와 Data

18.Data-Centric(6): NLP History

NLP History를 Data-centric한 관점에서 본다.

19.Data-Centric(7): 데이터 증강, 필터링

주어진 말뭉치를 토큰으로 나뉘는 것을 말한다어떻게 하느냐에 따라 의미가 달라질 때가 많다.서브워드 토큰화주어진 말뭉치를 서브워드로 단위로 나눈다.인지적으로 알고 있는 워드 단위로 토큰화를 하게 되면 vocab이 너무나 커지기 때문에이러한 문제를 해결하기 위해 제시된 것

20.데이터 증강 : 마스터 클래스

데이터 증강 !

21.Data-Centric(8): 데이터 증강, 필터링

1. 데이터 증강에 관한 최근 연구 Iterative Back-Translation for Neural Machine Translation Back Translation이나 EDA(Easy Data Augmentation)과 같은 기법들은 RNN, LSTN 같은 모델들

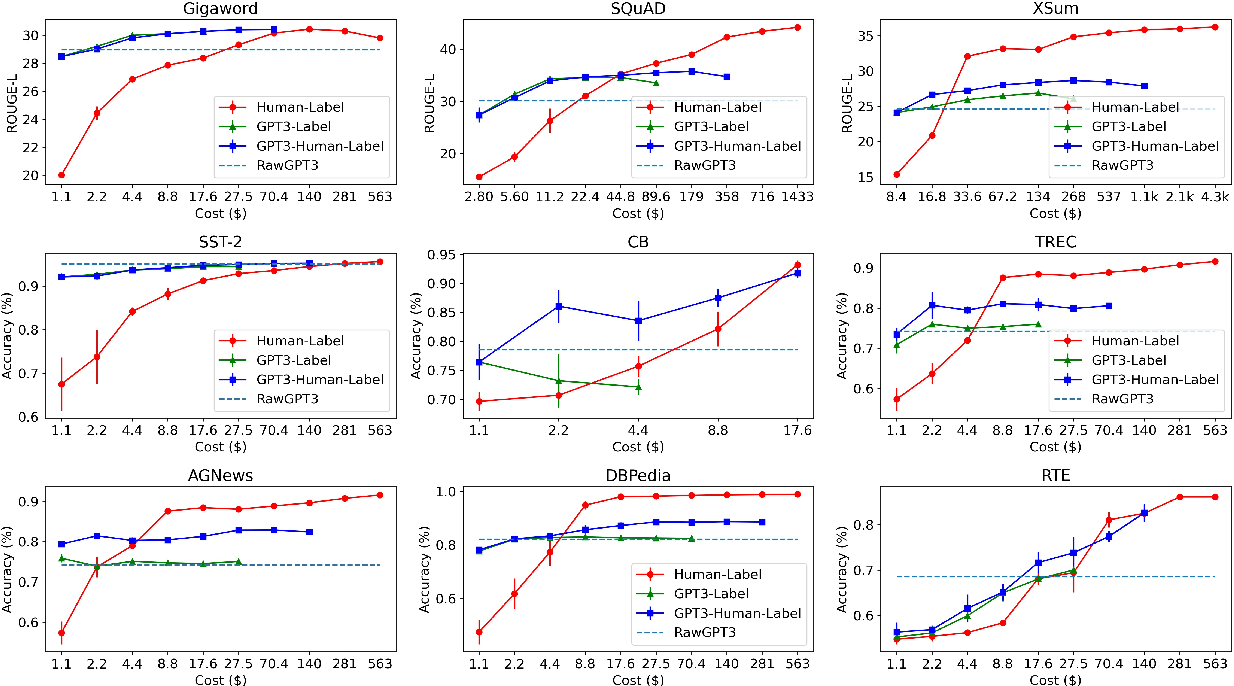

22.Data-Centric(9): Data-Centric NLP 최근 연구 동향

멀티모달 AI와 Neuro-Symbolic AI 1. 멀티모달 AI 정의: 텍스트, 이미지, 오디오 등 서로 다른 데이터 타입을 동시에 처리할 수 있는 AI 시스템 필요성: 현실 세계의 복잡한 문제 해결을 위해 단일 모달 데이터로는 불충분 다양한 감각 정보를 통합하여 더 풍부한 이해와 추론 가능 주요 연구 분야: Mathematical/Arithme...

23.Data-Centric(10): 미래 Data-centric AI

Future Data-centric AI

24.Generation for NLP: 인코더와 디코더

인코더와 디코더 각각에 대한 탐구

25.Generation for NLP: LLaMA 해체쇼

LLaMA 파헤치기

26.Generation for NLP: 언어모델 학습 프로세스

1. NLP 패러다임의 변화 N-gram language models → Neural language models: BERT, GPT Traditional models: Naive Bayes → Neural models: Transformers Static embeddings: word2vec → Contextual embeddings: BERT, GPT...

27.Generation for NLP: Pre-Training Dataset

고품질 Pre-Training Dataset과 전처리 도구들을 활용해 효율적인 언어모델 학습이 가능하며, Fine Web은 15T 규모의 정제된 데이터로 최적화된 학습을 지원한다.

28.Generation for NLP: Fine-Tuning Data

Self-Instruction, 소량의 Seed Dataset으로 LLM을 활용해 대규모 Instruction 데이터를 생성하고 필터링하여 Fine-tuning 데이터셋을 구축하는 효율적인 방법

29.Generation for NLP: LLM 평가

LLM 평가는 자동화된 메트릭, LLM 기반 판단, 사람 평가를 통해 다양한 능력과 편향성을 종합적으로 검증한다.

30.Generation for NLP: Long Context

LLM의 Long Context 처리를 위해 위치 정보 임베딩이 중요하며, RoPE와 ALiBi 같은 기술이 발전했고, Ring Attention을 통해 메모리 효율적으로 긴 컨텍스트를 처리할 수 있게 됨.

31.Generation for NLP: Embedding

EMbedding

32.Generation for NLP: AI Agent

AI Agent에 대하여

33.Generation for NLP: 실제 서비스 단계

1. Text Generation LLM은 다음 토큰을 예측하도록 학습되었다. 다음 토큰으로 가장 적합한 것을 선택하는 Decoding 방식은 다를 수 있다. Greedy Decoding (무조건 가장 확률이 높은 것) 반복어휘 가능성이 높음 Top-K Sampling > Autoregressive Generation의 특성상 원하는 답이 ...

34.Generative AI(1)

Generative AI 1강

35.Generative AI(2)

Generative AI(2)

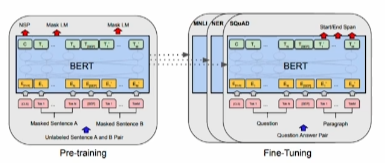

36.Generative AI(3): PEFT

PEFT 방법론

37.Generative AI(4): sLLM

라이센스, 학습데이터 구축, 평가

38.Generative AI(4): image

image AI에 대하여

39.Generative AI(4): image(stable Diffusion, 평가)

Stable Diffusion

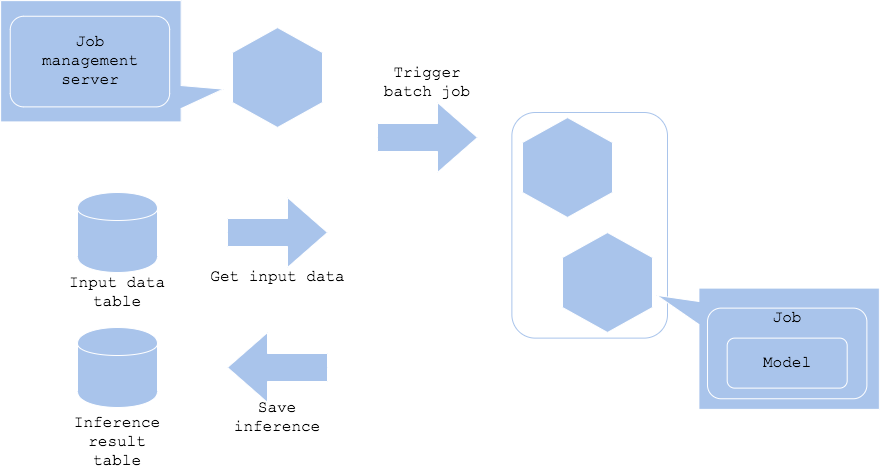

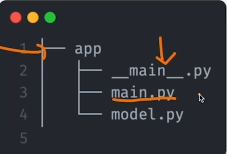

40.Product Serving(1): Serving

서빙의 유형

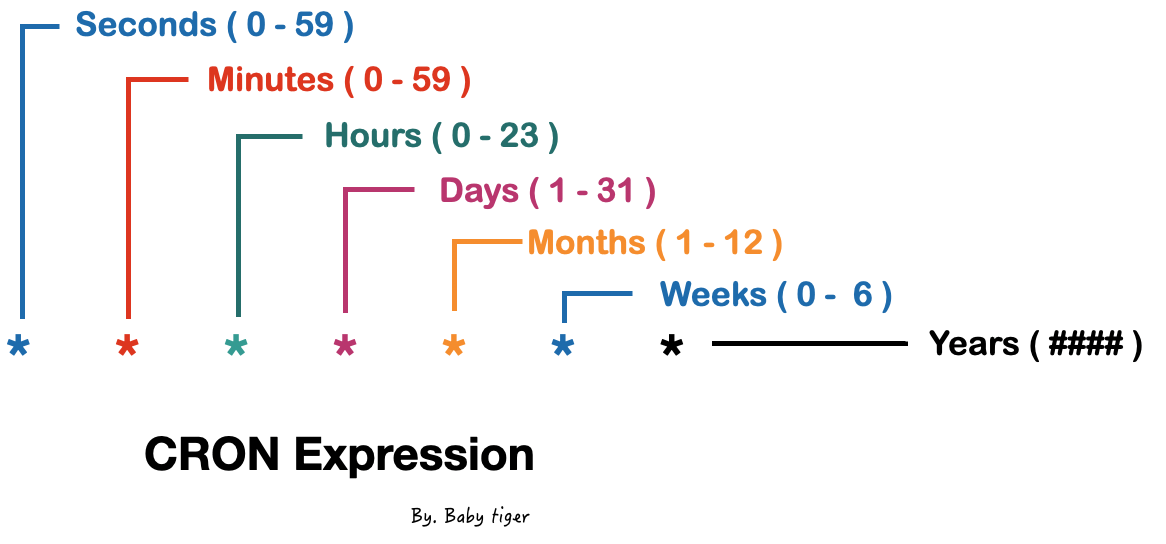

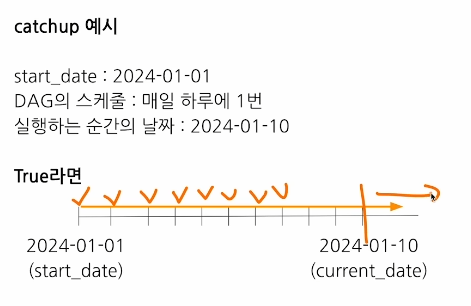

41.Product Serving(2): Airflow

Airflow

42.Product Serving(3): Airflow practice 1

Airflow 실습 강의

43.Product Serving(4): Online Serving을 위한 웹 프로그래밍

Online Serving

44.Product Serving(5): FastAPI

FastAPI 기초

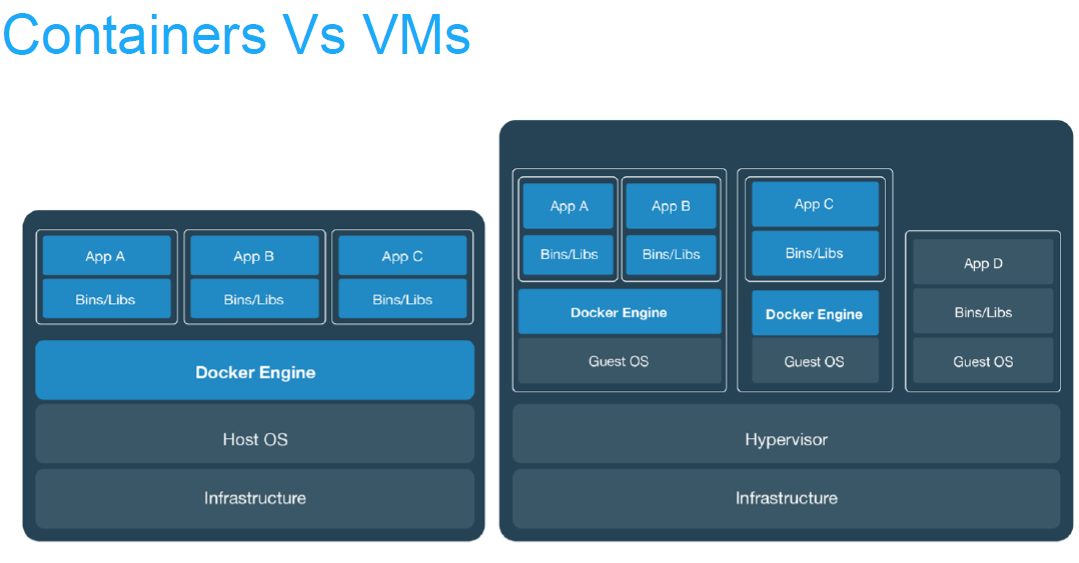

45.Product Serving(6): Docker

Docker를 알아보자

46.Product Serving(7): 클라우드 서비스

클라우드 서비스 배우기

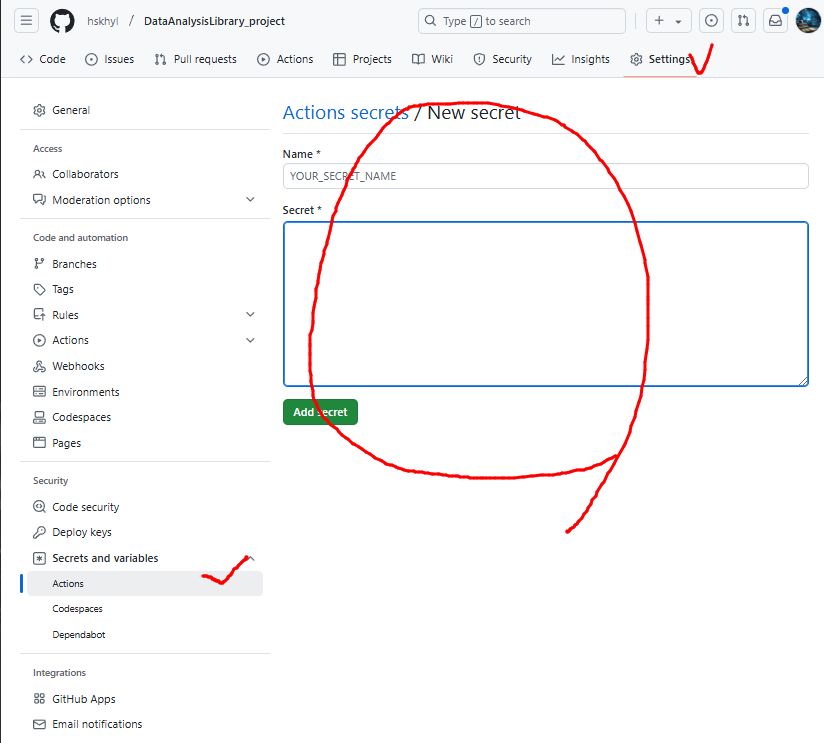

47.Product Serving(8): 모델, 코드배포

Github Actions의 활용

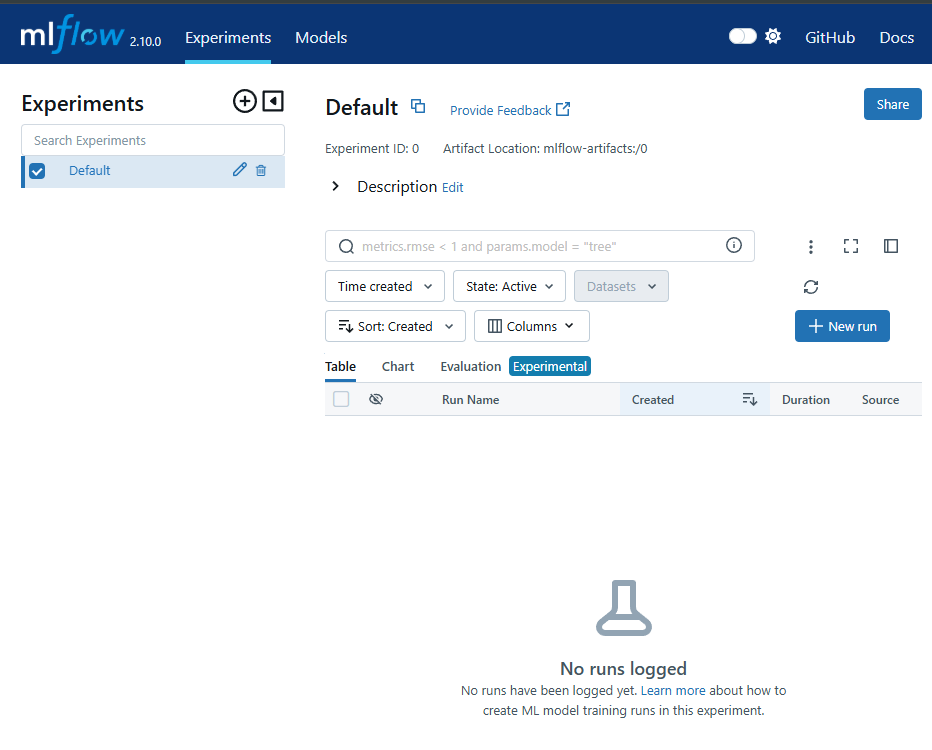

48.Product Serving(9): 모델관리와 평가(MLflow)

MLflow의 활용

49.Product Serving(10): Further more

지속적으로 성장하는 사람이 된다는 것

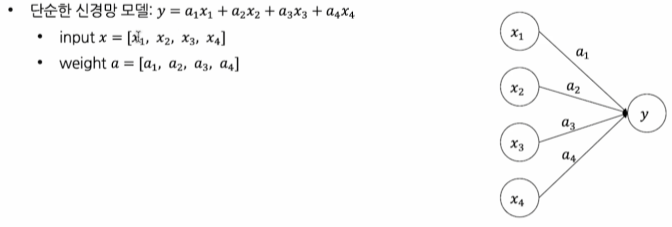

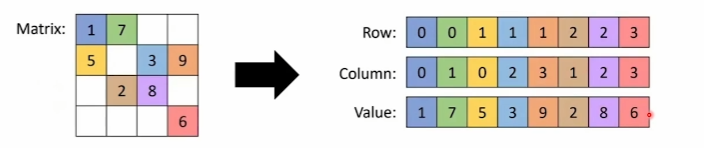

50.모델 최적화와 경량화: 개요

모델 최적화, 경량화 개요

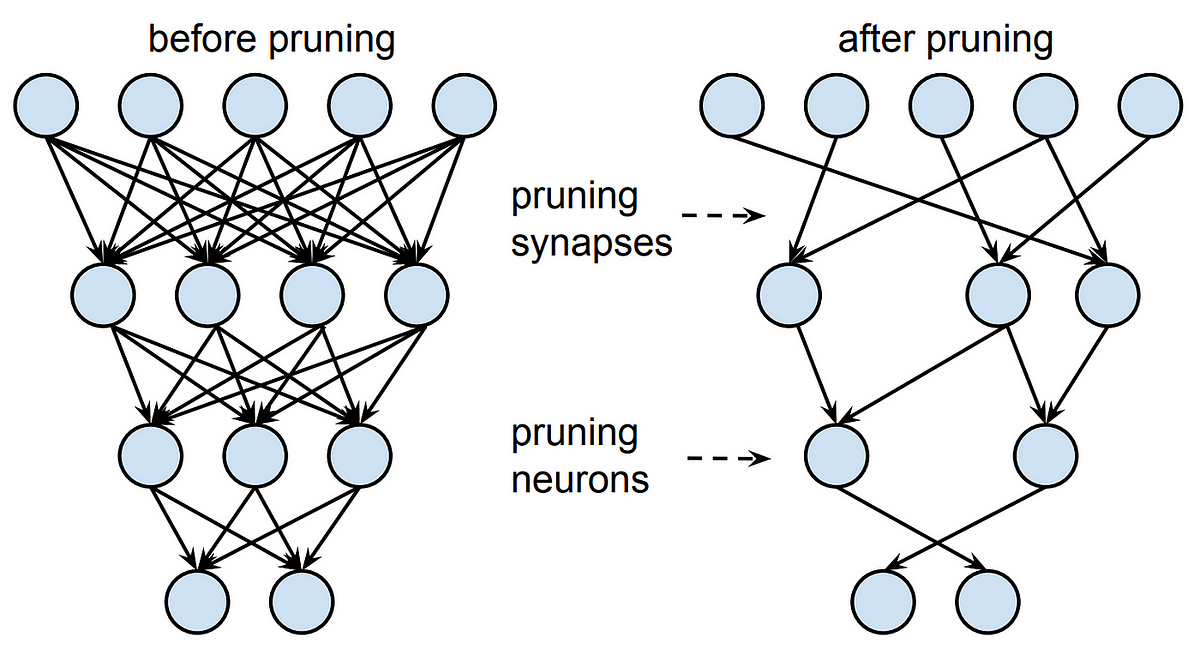

51.모델 최적화와 경량화: Pruning

Pruning에 대해 알아보자!

52.모델 최적화와 경량화: Pruning (2)

Pruning 심화 및 실습

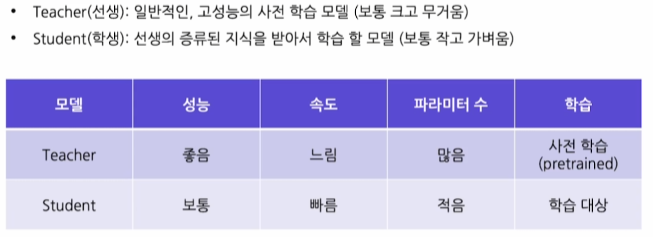

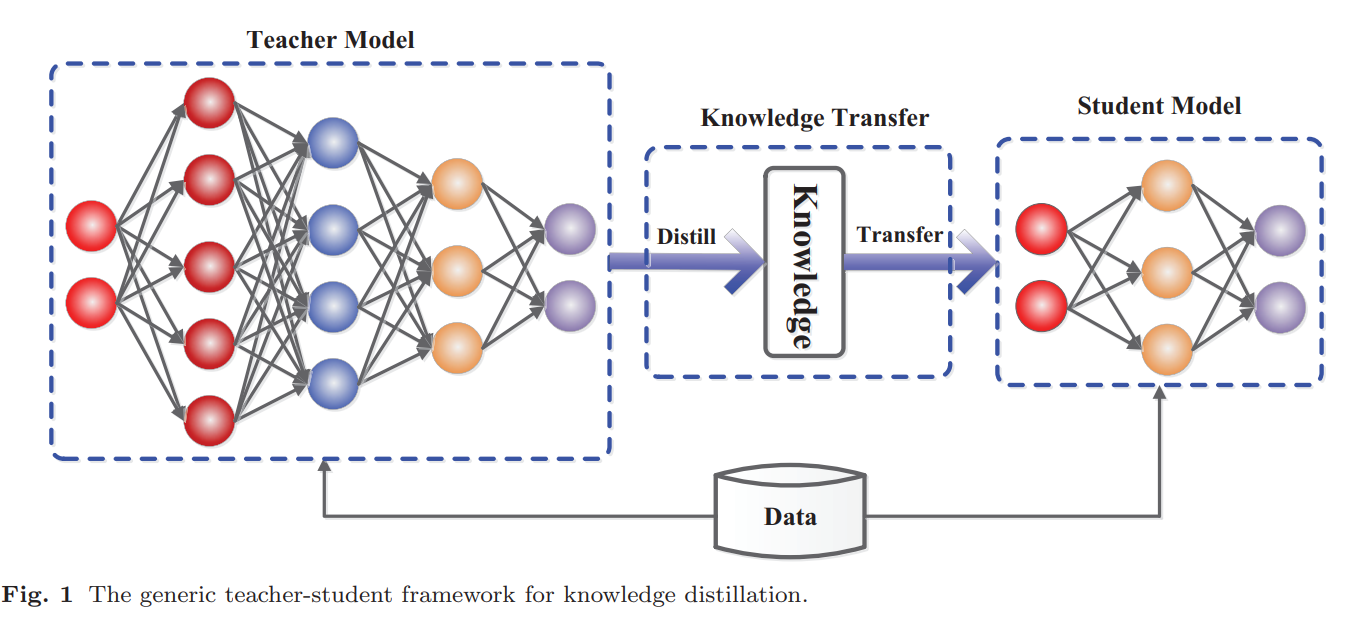

53.모델 최적화와 경량화: 지식증류(Knowledge Distillation: Logit-based)

Knowledge Distillation(logit-based)

54.모델 최적화와 경량화: 지식증류(Knowledge Distillation: Feature-based)

Featrue-based KD

55.모델 최적화와 경량화: Quantization

Absmax, Zero-point Quantization

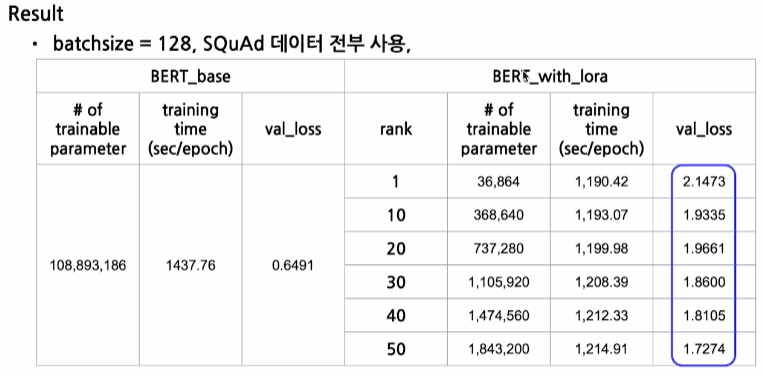

56.모델 최적화와 경량화: PEFT

LoRA, Adapter, Transfer Learning

57.모델 최적화와 경량화: PEFT (2)

Adpater Fusion, Q-LoRA

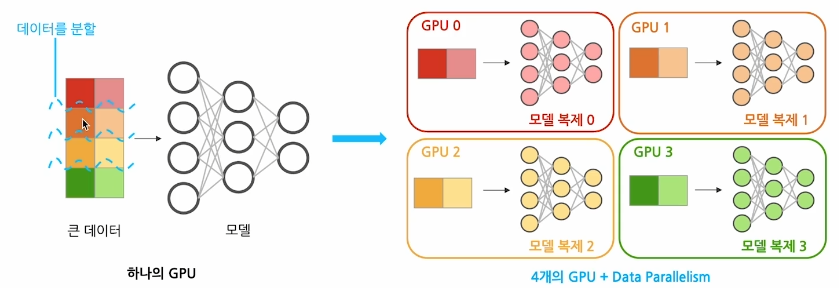

58.모델 최적화와 경량화: Distributed Training

DP, DDP

59.모델 최적화와 경량화: Distributed Training(2)

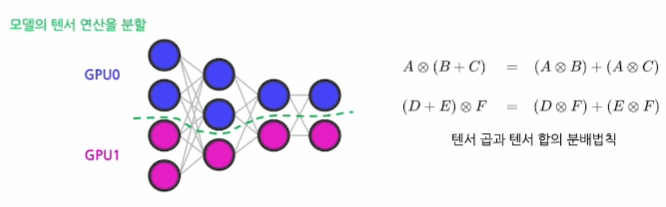

Model Parallelism, Tensor Parallelism, Pipeline Parallelism

60.NLP Trends: 프롬프트 기법

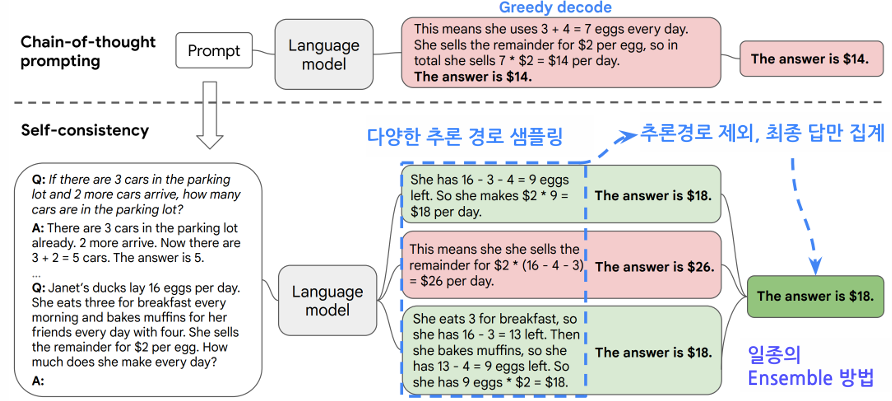

CoT, Self-Consistency, Least-to-Most, Decomposed, ReAct

61.NLP Trends: LLM의 응용과 한계

LLM Agent, Visual ChatGPT, JARVIS, LLM-Planner, LLM의 한계

62.NLP Trends: 윤리

Hallucination, Toxicity, Bias, Privacy Invasion

63.NLP Trends: 지식 업데이트

Continual-Learning, RAG

64.NLP Trends: 시장, Provider, Applications

시장현황, Provider, Applications